Spark(16)——SparkContext的作用

Posted Java学习基地Java毕设定制

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Spark(16)——SparkContext的作用相关的知识,希望对你有一定的参考价值。

官方解释:SparkContext是spark功能的主要入口。其代表与spark集群的连接,能够用来在集群上创建RDD、累加器、广播变量。每个JVM里只能存在一个处于激活状态的SparkContext,在创建新的SparkContext之前必须调用stop()来关闭之前的SparkContext。

下面我们看下SparkContext究竟有什么作用:

首先,每一个Spark应用都是一个SparkContext实例,可以理解为一个SparkContext就是一个spark application的生命周期,一旦SparkContext创建之后,就可以用这个SparkContext来创建RDD、累加器、广播变量,并且可以通过SparkContext访问Spark的服务,运行任务。spark context设置内部服务,并建立与spark执行环境的连接。

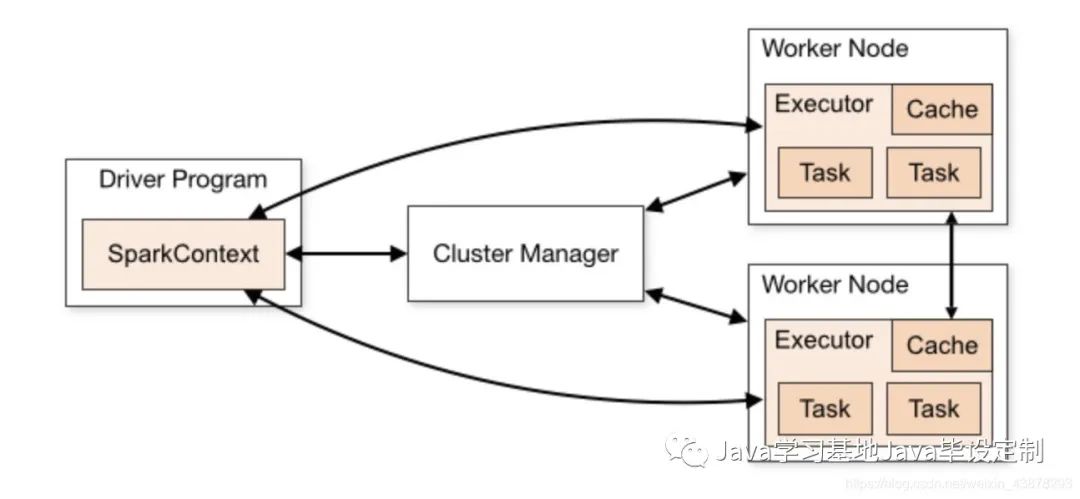

先来看一个spark架构组成图 再结合下一张图,SparkContext组成

再结合下一张图,SparkContext组成

通过这两张图我们不难发现,SparkContext在spark应用中起到了master的作用,掌控了所有Spark的生命活动,统筹全局,除了具体的任务在executor中执行,其他的任务调度、提交、监控、RDD管理等关键活动均由SparkContext主体来完成。

以上是关于Spark(16)——SparkContext的作用的主要内容,如果未能解决你的问题,请参考以下文章