简单好用!推荐中的自监督图神经网络

Posted 图与推荐

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了简单好用!推荐中的自监督图神经网络相关的知识,希望对你有一定的参考价值。

数据的偏态分布、噪声等问题在机器学习中广泛存在,极大的限制了模型的性能。自监督学习可能是缓解上述问题的有效途径!微软亚洲研究院、中国科学技术大学、新加坡国立大学的一众大佬联合提出了SGL模型,通过辅助的自监督任务来提高监督任务(推荐)的性能。通过简单的自监督任务就可以极大的提升现有GNN推荐模型的效果。

Part 1

摘要

推荐系统上的user-item图的表示学习从单个ID发展到了通过高阶邻居来学习(例如经典的NGCF)。虽然这样的模型很高效,但是却有两个限制:

(1)度数高的节点对表示学习的影响更大,从而减弱了度数低的节点对表示学习的影响。

(2)因为聚合邻居机制会扩大边的影响,所以模型对噪声敏感

这项工作是为了增强原来推荐系统GCN的精确性和鲁棒性的,中心思想是通过辅助的自监督任务来提高经典监督任务的性能。我们的模型叫做自监督图学习(SGL),这个模型超过了之前先进的模型lightGCN,提高了精确度和鲁棒性。

Part 2

简介

在user-item互动数据上进行表示学习,早期的模型比如MF将每个用户或项的ID映射到embedding向量上。后续的研究将单个ID同互动历史结合起来进行更好的表示。而现如今,表示学习已经发展为从高阶连接中进行学习。这项技术是从GCN中得到灵感的。但是基于GCN的表示模型受到了一些限制:

(1)稀疏的监督信号 相比整个互动空间而言,观察到的互动及其稀疏。这对于训练模型是不充足的。

(2)偏态分布的数据 观察到的互动通常遵循幂律分布,而度数小的节点则缺少监督信号,度数高的节点出现次数更多。所以模型受度数高的节点影响更大。

(3)噪声的影响 大多数用户提供的反馈是隐式而非显式的,所以观察到的互动通常含有噪声。而GCN的邻居聚集机制会扩大这种影响。

这里提出了SSL模型来解决上述问题。有两个关键的组成部分:

(1)数据增强 为每个节点生成多种视角

(2)对比学习 相对其他节点而言,最大化相同节点的不同视角的认同。

SGL模型可以用用于任何含有用户embedding和项目embedding的模型。我们将它应用于lightGCN上,在精确度和鲁棒性上获得了提升。

Part 3

模型

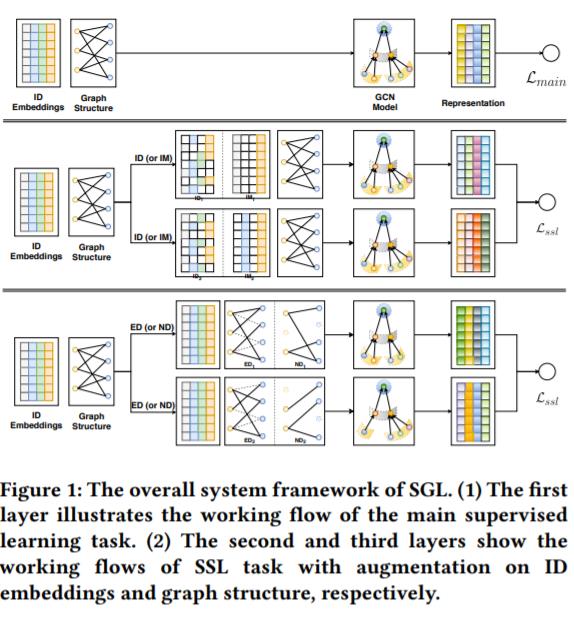

图1

SGL的总体框架。(1)第一层阐述了主要监督学习任务的工作流。(2)第二层和第三层展示了有增强ID embedding和图结构的SSL模型的工作流

在聚集邻居信息之前,要先进行ID embedding和图结构的增强。即

建立了节点的增强视角之后,我们将相同节点的视角看做正例对,不同节点的视角看做负例对,有

我们还提出了多任务训练策略来优化经典的推荐任务

Part 4

实验

我们在三个基准数据集上进行了实验,对不同的模型进行了对比,得到了如下结果

表3

可以看到,在大多数情况下,SGL表现优于lightGCN;其中SGL-ED的表现是最好的,我们将其归因为SGL-ED可以捕获图结构的继承模式;SGL-ND的稳定性比SGL-ED差很多,这是因为对边进行了dropout;将模型从1层变为3层可以增强SGL模型的性能。

除此之外,SGL在long-tail推荐中表现很好,且训练效率和鲁棒性测试上均表现优异。

Part 5

总结

这项工作中,我们介绍了之前GCN模型的限制,并且提出了SSL来解决这些问题。我们提出了SGL来增强推荐任务的性能。通过embedding矩阵和基于GCN模型的图结构,我们设计了四种数据增强来进行辅助对比任务。最后我们做了实验,证明了模型的优越性。

以上是关于简单好用!推荐中的自监督图神经网络的主要内容,如果未能解决你的问题,请参考以下文章