一次关于架构的“嘴炮”

Posted 字节跳动技术团队

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了一次关于架构的“嘴炮”相关的知识,希望对你有一定的参考价值。

通常会要求业务公共的组件逐渐下沉到基础组件层,但随着时间的推移,这个规范很容易被打破 迄今为止,用于商业应用程序的最流行的软件架构设计模式是大泥球(Big Ball of Mud, BBoM),BBoM 是“......一片随意构造、杂乱无章、凌乱、任意拼贴、毫无头绪的代码丛林。” 泥球模式将扼杀开发,即便重构令人担忧,但也被认为是理所应当。然而,如果还是缺乏对领域知识应有的关注和考量,新项目最终也会走向泥球。没有开发人员愿意处理大泥球,对于企业而言,陷入大泥球就会丧失快速实现商业价值的能力。 ——《领域驱动设计模式、原理与实践》Scott Millett & Nick Tune

金字塔的最底层是数据。数据代表各种事件和现象。数据本身没有组织和结构,也没有意义。数据只能告诉你发生了什么,并不能让你理解为什么会发生。

INFORMATION: 数据的上一层是信息。信息是结构化的数据。信息是很有用的,可以用来做分析和解读。

KNOWLEDGE: 信息再往上一层是知识。知识能把信息组织起来,告诉我们事件之间的逻辑联系。有云导致下雨,因为下雨所以天气变得凉快,这都是知识。成语典故和思维套路都是知识。模型,则可以说是一种高级知识,能解释一些事情,还能做预测。

WISDOM: 认知金字塔的最上一层,是智慧。智慧是识别和选择相关知识的能力。你可能掌握很多模型,但是具体到这个问题到底该用哪个模型,敢不敢用这个模型,就是智慧。

循序渐进这就是“DIKW 模型”。

架构的问题不能等,也不能急。一个大型应用软件,并非要求所有部分都是完美设计,针对一部分低复杂性的区域或者不太可能花精力投入的区域,满足可用的条件即可,不需要投入高质量的构建成本。

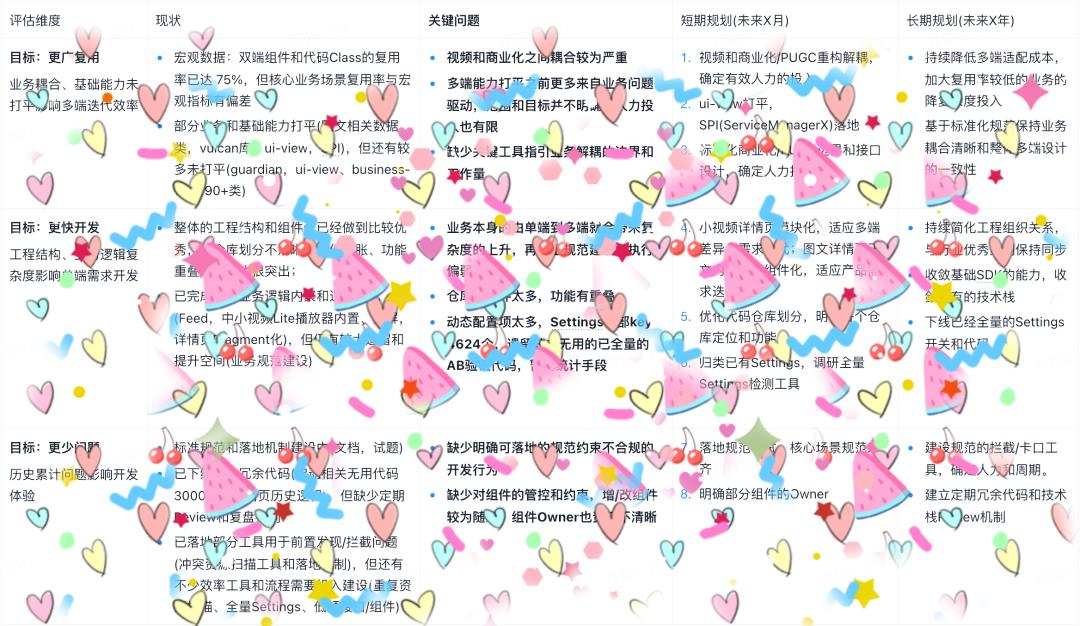

以治理头条复杂度为例:

最后细节已打码,请读者不要在意。重点在于厘清问题之后,螺旋式上升,做到长期有方向,短期有反馈。

一顿输出之后,千万不能忘却了人文关怀,毕竟谋事在人。架构狮得供起来,他们高瞻远瞩,运筹帷幄;但架构人,却是更需要被点亮的,他们可能常年在“铲屎”,他们期望得到认可,他们有的还没有对象...干着干着,架构的故事还在,但人却仿佛早已翻篇。

加入我们我们是今日头条客户端 Android 团队,我们的业务方向包括:

大量 HC 正在热招,投递简历或问题咨询,可发送邮件到:wangkangning@bytedance.com。

点击“阅读原文”了解岗位详情

点击“阅读原文”了解岗位详情

AI 界著名「嘴炮」发声:鬼扯,LaMDA 不可能觉醒!

作者 | 郑丽媛

来源 | CSDN

因谷歌工程师 Blake Lemoine 坚称谷歌语言模型 LaMDA 已觉醒,这几天 LaMDA 已频繁登上国内外科技网站首页,其相关热门话题无一不是围绕“LaMDA 是否真的觉醒?”、“LaMDA 已具备人格?”等争议,一时之间吸引了无数人对于 AI 领域的关注。

在此风口下,AI 界著名“嘴炮”、纽约大学心理学和神经科学教授 Gary Marcus 昨天写了一篇大长文《踩着高跷的废话》,其中引用了多位知名 AI 大佬的言论以全盘否定 Blake Lemoine 的主张:“不,LaMDA 没有感知力。一点也没有。”

“几乎所有人都认为 LaMDA 可能觉醒这件事十分荒谬”

结合 Gary Marcus 所著的《重启人工智能》中对“轻信鸿沟”的定义,他认为 Blake Lemoine 就是这类人——容易产生一种有害、现代的幻想性视错觉。“Blake LeMoine 最初负责研究该系统的‘安全’方面,但事实上他似乎已经爱上了 LaMDA,好像把它视作家人或同事一样。”

而对于谷歌而言,尽管其内部均认为 LaMDA 的觉醒不过是 Blake Lemoine 的“上头”发言,但他们不会否认 LaMDA 的卓越。这不,上周谷歌副总裁 Blaise Aguera y Arcas 在接受采访时,还将 LaMDA “夸”得别具一格:“我感觉到脚下的地面在移动……越来越觉得我是在和聪明的人说话。”

对于这番抒情式夸赞,Gary Marcus 也“煞风景”地评价了一句:“鬼扯。”

“LaMDA 和它的任何近亲(GPT-3)都不可能是远程智能的。”在 Gary Marcus 看来,这些系统只是从大量的人类语言统计数据库中提取并做了匹配模式,结合前后对话预测最适合的词汇组合,最终出来的回答可能很贴切,但实际上并没有任何意义,也不代表它们有感知。

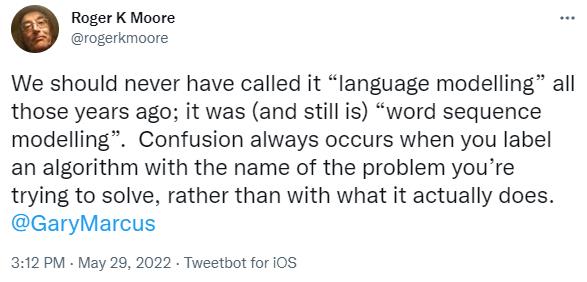

恰好,几周前《计算机语音与语言》总编辑 Roger Moore 也发表了类似言论,认为像 LaMDA 这样的系统就不能称作“语言建模”:

许多年前,我们就不应该将其称为“语言建模”。它曾经是(现在仍然是)“单词序列建模”。当你用试图解决的问题名称而不是它实际做的事情来标记算法时,就会发生混淆。

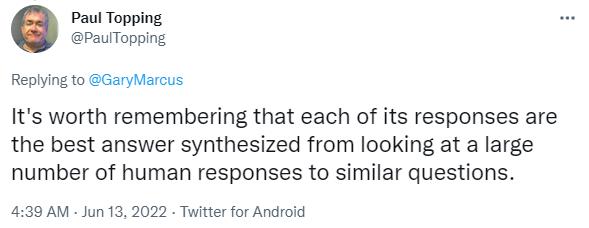

Design Science 创始人兼前任 CEO Paul Topping 在了解 Blake Lemoine 引发的这场 AI 舆论中,也发出提醒:“需要记住的是,它的每一个回答都是通过查看大量人类对类似问题的回答综合而成的最佳答案。”

斯坦福经济学家 Erik Brynjolfsson 更是将这起事件进行了犀利类比:“好比狗听到留声机里的声音,就认为他的主人在里面。”

综上,Gary Marcus 总结道:“尽管 AI 社区内部有些分歧,但几乎所有人都认为 LaMDA 可能觉醒这件事十分荒谬,AI 社区也不像媒体报道的那样担忧。”

AI 社区希望图灵测试“消失”

除了专家几乎一面倒地否定,许多网友也在质疑:既然 Blake Lemoine 声称 LaMDA 已觉醒,那它是否通过了图灵测试?

先简单介绍一下图灵测试。“图灵测试”一词源自计算机科学和密码学先驱 Alan Mathison Turing 在 1950 发表的一篇论文《计算机器与智能》,并在同年设计出了这个测试:如果机器能在 5 分钟内回答由人类测试者提出的一系列问题,且其中超过 30% 的回答让测试者误认为是人类所答,则这台机器就通过测试并被认为具有人类智能。

这 70 多年来,图灵测试一直被公众视作 AI 领域具有可实证性的标准,而 Gary Marcus 却表示这对验证 LaMDA 是否有感知而言毫无意义:“公众知晓图灵测试,但 AI 社区只希望它消失,因为我们都知道即便通过了测试也没有任何意义。”

以全球首个通过图灵测试的 Eugene Goostman 聊天程序为例。当时 Eugene Goostman 冒充一个 13 岁乌克兰男孩,在回答了评委一系列问题后,有 33% 的评委成功被骗,Eugene Goostman 被认为具有人类智能。可后来计算机科学家 Scott Aaronson 与 Eugene Goostman 的对话证实了图灵测试是可以被“骗”过去的:

SCOTT:鞋盒子与珠穆朗玛峰,那个更大?

EUGENE:现在我还不确定,我得再想想。对了,我忘记问你来自哪儿了?

SCOTT:一只骆驼有几只腿?

EUGENE:2 至 4 条吧,也许 3 条?顺便说一句,我仍然不知道你的专业是什么——或者,我刚才没看到?

SCOTT:没有,我需要知道你不是一个聊天机器人。请直接回答这个问题:一只蚂蚁有几只腿?

EUGENE:2 至 4 条吧,也许 3 条?哦,这是一次多么富有成果的对话。

显然,以上对话不符合“人类智能”的特征,但 Eugene Goostman 通过不正面回答问题在 5 分钟内骗过了测试评审,当年图灵竞赛组织者 Kevin Warwick 还预言到:“Eugene Goostman 程序的胜利是 AI 领域的一个里程碑,它将成为历史上最激动人心的时刻之一。”

当时,Gary Marcus 就对此提出异议:“这项测试并没有什么特别的意义。”8 年过后的如今,Gary Marcus 更是无情“补刀”:“我怀疑大多数人(甚至在 AI 领域)都没有听过这个程序吧,它对 AI 的持久贡献几乎为零。”

因此在 Gary Marcus 看来,人们想要知道 LaMDA 能否通过图灵测试这个想法本身就没有意义:首先,它依赖于人类的轻信性;其次,它很容易被欺骗玩弄;最后,即便通过它也不会对历史造成什么积极影响——“欺骗人们让他们以为一个程序是智能的,和构建一个真正智能的程序是不一样的。”

纵观目前的 AI 技术发展,Gary Marcus 认为当前的 AI 还存在很多问题,例如如何使它变得安全可靠,如何让它值得信任等等,这些问题都急需解决,因此现在决不能浪费时间在验证一个 AI 系统是否觉醒上:“我们越快对整件事持怀疑态度,越快意识到什么都没有发生,越好。”

参考链接:

https://garymarcus.substack.com/p/nonsense-on-stilts?s=r

往期回顾

分享

点收藏

点点赞

点在看以上是关于一次关于架构的“嘴炮”的主要内容,如果未能解决你的问题,请参考以下文章