这一篇 K8S(Kubernetes)集群部署 我觉得还可以!!!

Posted 牧小农

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了这一篇 K8S(Kubernetes)集群部署 我觉得还可以!!!相关的知识,希望对你有一定的参考价值。

点赞再看,养成习惯,微信搜索【牧小农】关注我获取更多资讯,风里雨里,小农等你,很高兴能够成为你的朋友。

国内安装K8S的四种途径

Kubernetes 的安装其实并不复杂,因为Kubernetes 属于Google 的产品,都是从Google的官方上进行下载,但是因为网络问题,在国内是没办法连接它的中央仓库进行下载安装包的,只能通过其他的途径进行安装,在国内有四种安装方式

- 使用 Kubeadmin 通过离线镜像安装: Kubeadmin 是K8S提供的管理控制台,通过这里的命令可以非常方便的对我们集群进行快速发布和部署

- 使用阿里云公有云平台安装K8S: 这是也是非常好用的,不用做任何设置,拿来就用,但是有一个缺点——要钱

- 通过yum官方仓库安装: 这个是最简单的,但是这个安装K8S的包是非常古老的版本,听说是和谷歌最新的差了十个版本

- 通过二进制包的形式进行安装: 采用第三方的提供的二进制包的形式来安装K8S,比如 Kubeasz,它是github的一个开源项目,因为它是由三方来提供的,如果在没有仔细验证的情况下,是非常容易出错的,后台存在什么样的缺陷,你是不知道的。

今天我们这里采用的是第一种 使用 Kubeadmin 通过离线镜像安装K8S,本文也会使用 Kubeadmin 来为大家展示K8S的集群部署和安装,环境和安装包我都为大家准备好了,大家感兴趣的可以进行下载安装。

关注公众号:牧小农,回复 k8s ,就可以获取下载地址了

环境准备

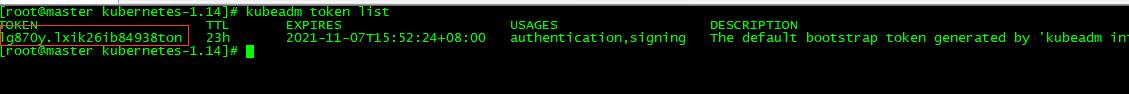

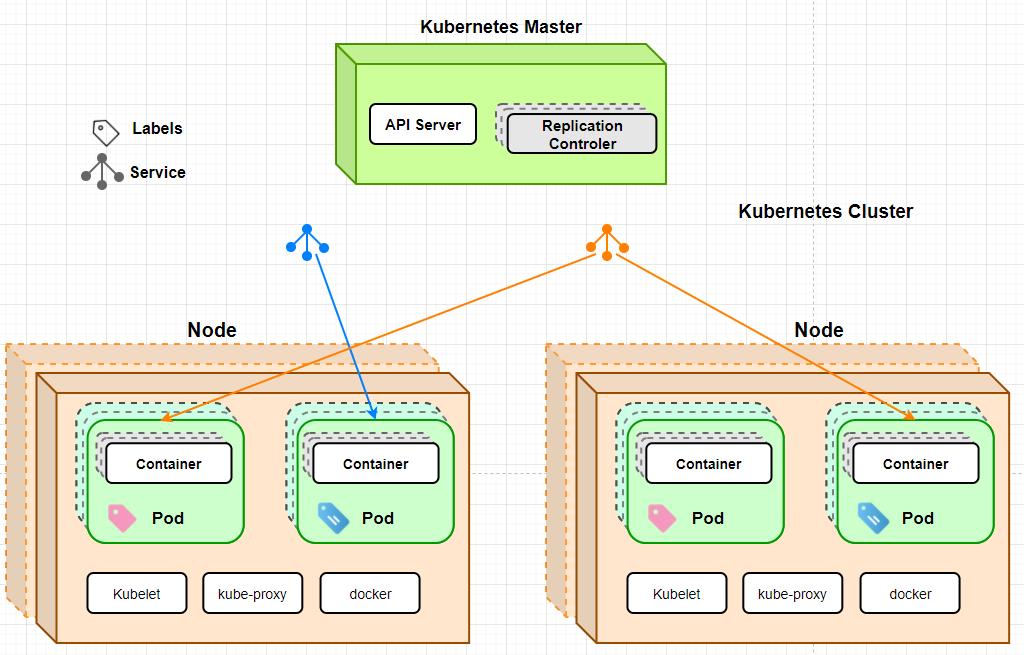

结构图:

1.1 物理机系统

在这里需要说明一下,小农是本地虚拟机安装测试的,如果不知道怎么安装,看下面的我安装虚拟机的教程:

虚拟机安装教程:安装linux虚拟机(CentOS) 详细教程

安装K9S需要处理器的数量为2,否则后面初始化的时候会失败

1,1 物理机操作系统采用Centos7.8 64位

[root@localhost ~]# uname -a

Linux localhost.localdomain 3.10.0-1127.el7.x86_64 #1 SMP Tue Mar 31 23:36:51 UTC 2020 x86_64 x86_64 x86_64 GNU/Linux

[root@localhost ~]# cat /etc/redhat-release

CentOS Linux release 7.8.2003 (Core)

1.2 集群信息

| 节点及功能 | 主机名 | IP |

|---|---|---|

| Master、etcd、registry | Master | 192.168.137.129 |

| Node1 | Node1 | 192.168.137.130 |

| Node2 | Node2 | 192.168.137.131 |

环境准备命令

2.1 设置时区

三台机器都需要执行:timedatectl set-timezone Asia/Shanghai

2.2 设置主机名

129执行: hostnamectl set-hostname master

130执行: hostnamectl set-hostname node1

131执行: hostnamectl set-hostname node2

2.3 添加hosts网络主机配置

三台主机都需要添加这个配置

vi /etc/hosts

192.168.137.129 master

192.168.137.130 node1

192.168.137.131 node2

添加完成之后我们在master上验证一下 ping node1

[root@localhost ~]# ping node1

PING node1 (192.168.137.130) 56(84) bytes of data.

64 bytes from node1 (192.168.137.130): icmp_seq=1 ttl=64 time=0.605 ms

64 bytes from node1 (192.168.137.130): icmp_seq=2 ttl=64 time=0.382 ms

64 bytes from node1 (192.168.137.130): icmp_seq=3 ttl=64 time=0.321 ms

2.4 关闭防火墙

生产环境可以跳过这一步,在生产环境不要执行这个,这里只是为了方便我们学习的时候使用

SELINUX是安全增强型的LINUX,是LINUX内置安全增强模块,可以增强LINUX的安全性,但是这个设置起来太麻烦了,所以我们在学习过程中一般都会关闭掉这个

关闭命令:sed -i \'s/SELINUX=enforcing/SELINUX=disabled/g\' /etc/selinux/config

设置为临时生效:setenforce 0

禁用防火墙:systemctl disable firewalld

停止防火墙:systemctl stop firewalld

安装Kubeadm部署工具

首先我们要弄清楚一个概念,Kubeadm 并不是 K8S 本身,Kubeadm只是一个快速部署工具,通过安装这个工具可以帮助我们简化K8S部署的过程。

创建文件目录: mkdir /usr/local/k8s

切换目录地址: cd /usr/local/k8s

然后我们将安装包(kubernetes-1.14 安装包在开头有下载连接)放到 k8s 这个目录下

[root@master k8s]# ll

drwxr-xr-x 2 root root 335 Nov 6 11:17 kubernetes-1.14

切换到kubernetes的目录

[root@master k8s]# cd kubernetes-1.14/

[root@master kubernetes-1.14]# ll

total 986908

-rw-r--r-- 1 root root 357 Jul 3 14:15 admin-role.yaml

-rw-r--r-- 1 root root 67 Jul 3 14:15 daemon.json

-rw-r--r-- 1 root root 67850818 Jul 3 14:15 docker-ce-18.09.tar.gz

-rw-r--r-- 1 root root 177698304 Jul 3 14:15 flannel-dashboard.tar.gz

-rw-r--r-- 1 root root 927 Jul 3 14:15 init.sh

-rw-r--r-- 1 root root 706070528 Jul 3 14:15 k8s-114-images.tar.gz

-rw-r--r-- 1 root root 79 Jul 3 14:15 k8s.conf

-rw-r--r-- 1 root root 58913350 Jul 3 14:15 kube114-rpm.tar.gz

-rw-r--r-- 1 root root 12306 Jul 3 14:15 kube-flannel.yml

-rw-r--r-- 1 root root 281 Jul 3 14:15 kubernetes-dashboard-admin.rbac.yaml

-rw-r--r-- 1 root root 4809 Jul 3 14:15 kubernetes-dashboard.yaml

-rw-r--r-- 1 root root 953 Jul 3 14:15 worker-node.sh

[root@master kubernetes-1.14]#

这里面就包含了我们安装K8S的所有内容,其中

kube114-rpm.tar.gz: 是我们Kubeadm 集群管理工具的安装压缩包

docker-ce-18.09.tar.gz: 是我们docker的安装压缩包,可以进行本地化安装

k8s-114-images.tar.gz: 是K8S镜像本身,我们K8S的安装是 通过 Kubeadm 集群管理工具对K8S的镜像进行自动化部署

flannel-dashboard.tar.gz: 用来监控集群状态

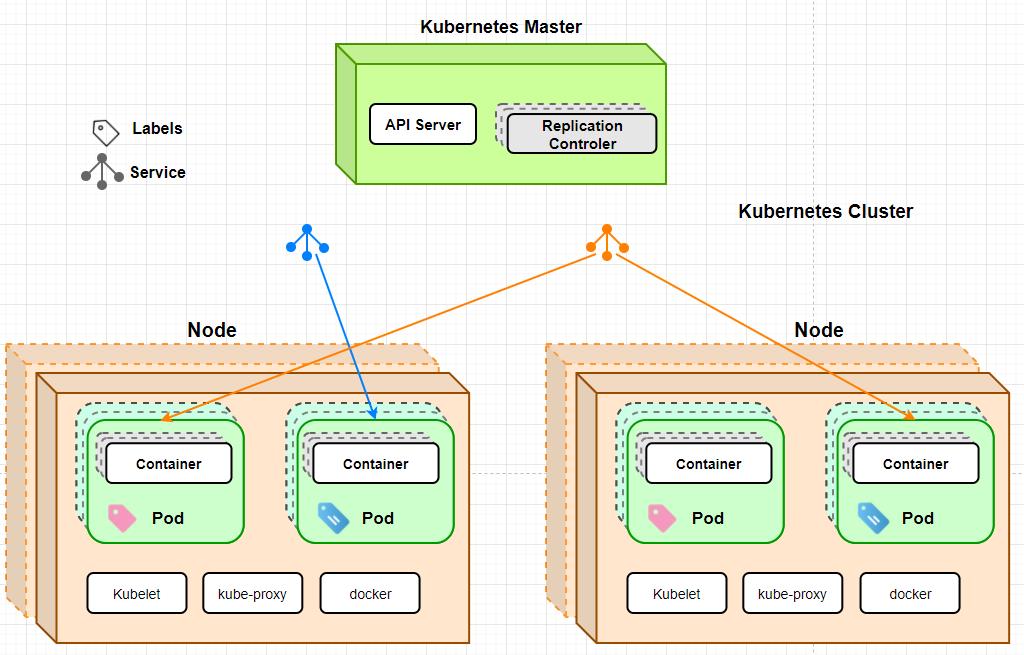

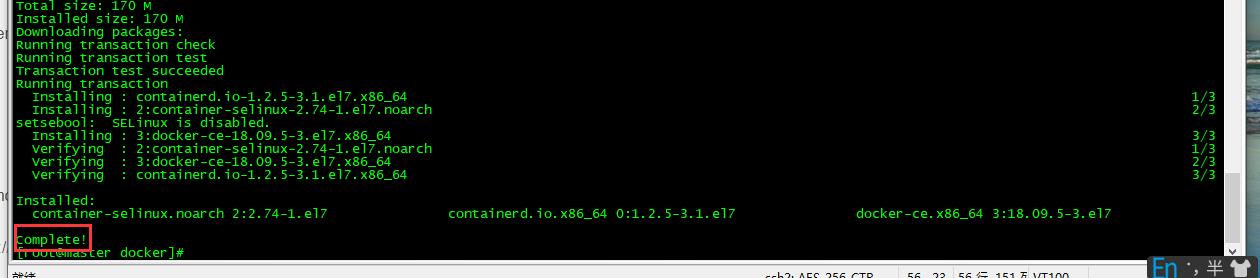

安装docker

我们需要在三台机器上都安装docker,文中用 master 节点来做演示

首先对 docker-ce-18.09.tar.gz进行解压缩

[root@master kubernetes-1.14]# tar -zxvf docker-ce-18.09.tar.gz

[root@master kubernetes-1.14]# cd docker

在安装之前我们首先需要保证本来的yum源和docker依赖是最新的,所以我们需要先执行以下命令,这一步命令执行都是在 docker这个目录下执行的

1、安装GCC

yum -y install gcc

yum -y install gcc-c++

2、卸载老版本的docker和依赖

yum remove docker docker-client docker-client-latest docker-common docker-latest docker-latest-logrotate docker-logrotate docker-selinux docker-engine-selinux docker-engine

3、安装 yum-utils组件:yum install -y yum-utils device-mapper-persistent-data lvm2

4、添加yum 源 PS

docker官网地址:

sudo yum-config-manager --add-repo https://download.docker.com/linux/centos/docker-ce.repo

阿里云地址:sudo yum-config-manager --add-repo http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

5、更新yum索引:sudo yum makecache fast

6、安装docker-ce:sudo yum install docker-ce

7、卸载老版本的docker和依赖

这一步不是重复,是为了卸载上一步的 docker-ce来安装我们k8s包里面的 docker-ce

yum remove docker docker-client docker-client-latest docker-common docker-latest docker-latest-logrotate docker-logrotate docker-selinux docker-engine-selinux docker-engine

8、执行我们安装包里面的文件:yum localinstall -y *.rpm

到这里就代表我们的docker安装完成了

启动docker: systemctl start docker

设置docker为自动启动: systemctl enable docker

保证 cgroups 在同一个 groupfs

执行命令:

[root@master docker]# docker info | grep cgroup

Cgroup Driver: cgroupfs

cgroups是control groups的简称,它为Linux内核提供了一种任务聚集和划分的机制,通过一组参数集合将一些任务组织成一个或多个子系统。cgroups是实现IaaS虚拟化(kvm、lxc等),PaaS容器沙箱(Docker等)的资源管理控制部分的底层基础。- 子系统是根据

cgroup对任务的划分功能将任务按照一种指定的属性划分成的一个组,主要用来实现资源的控制。 - 在

cgroup中,划分成的任务组以层次结构的形式组织,多个子系统形成一个数据结构中类似多根树的结构。cgroup包含了多个孤立的子系统,每一个子系统代表单一的资源

我们只需要确认输入上面的命令后出现的是: Cgroup Driver: cgroupfs就可以了

当我们输入命令发现不是 Cgroup Driver: cgroupfs这个结果,那我们需要执行下面的命令:

对 daemon.json 进行修改:

cat << EOF > /etc/docker/daemon.json

{

"exec-opts": ["native.cgroupdriver=cgroupfs"]

}

EOF

systemctl daemon-reload && systemctl restart docker

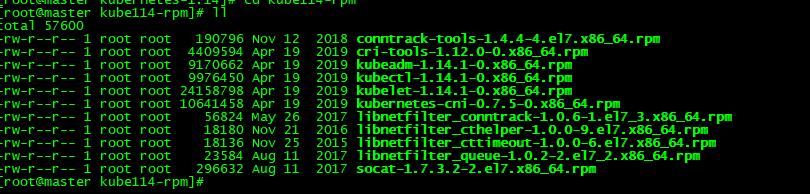

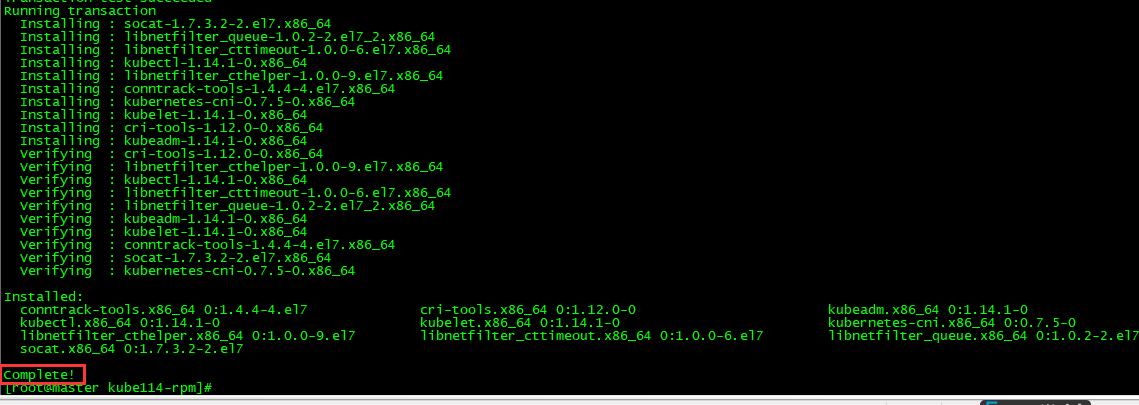

安装kubeadm

kubeadm是K8S官方提供的集群部署工具,通过这个工具可以快速帮助我们简化的完成K8S的管理,以及各集群节点下的容器创建

切换目录: cd /usr/local/k8s/kubernetes-1.14

解压 kube114安装包: tar -zxvf kube114-rpm.tar.gz

切换目录: cd kube114-rpm

安装: yum localinstall -y *.rpm

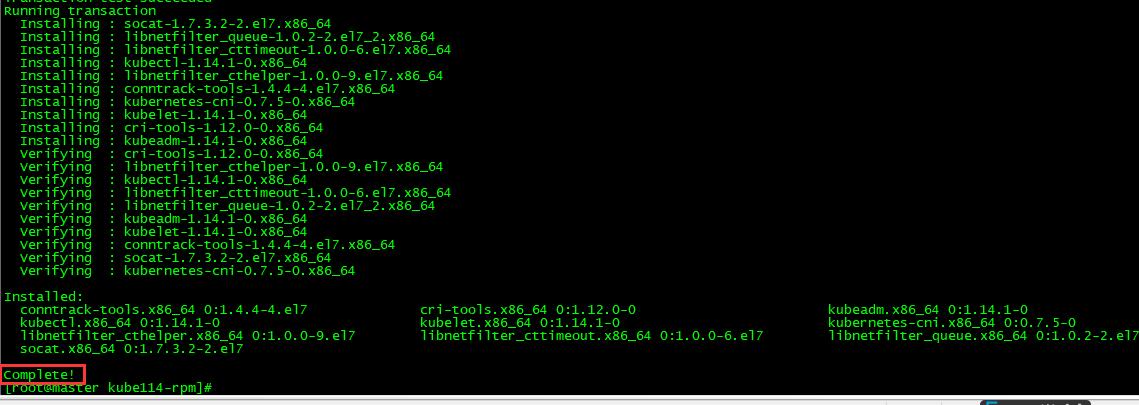

关闭交换区

- 在linux系统中,交换区类似于我们的

windows的虚拟内存,作为windows的虚拟内存,其实就是用物理磁盘模拟内存. - 比如说我们系统内存比较小,那么在进行数据处理的时候,内存不够了,我们就会先把这些数据寄存在硬盘上,用硬盘空间模拟内存来使用,虽然硬盘提取数据的速度比较慢,但是总是比内存不够要好,在linux系统中,交换区就是我们所说的虚拟内存了.

- 在这里,虚拟内存可能会对系统部署产生不必要的影响,在K8S的环境下,使用的服务器一般都是内存比较充足的,所以我们一般不推荐使用系统交换区,这样会让我们系统的性能降低,在这里选择关闭交换区

关闭交换区:swapoff -a

修改配置文件,永久关闭交换区:vi /etc/fstab

swap一行注释

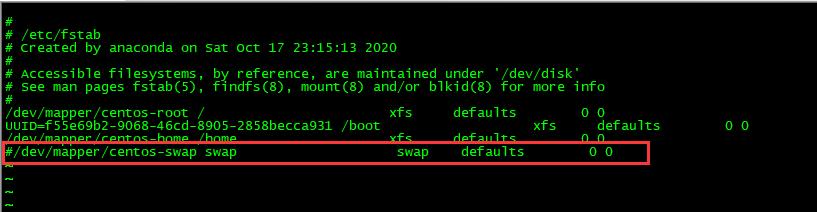

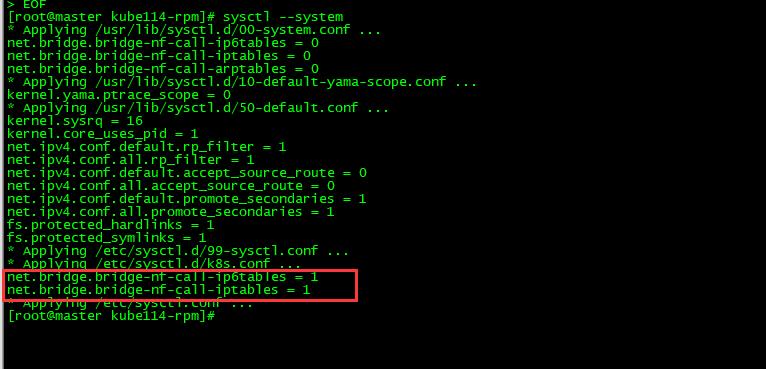

配置网桥

所谓配置网桥其实就是我们对k8s.conf这个文件进行修改

iptables 是在linux中的一个网络工具,用来对我们包按照规则进行过滤,在k8s.conf中增加下面两行配置当在K8S容器间进行网络通信的时候,当网桥进行数据传输的时候,也要遵循iptables的规则,进行相应的处理,这样可以提高我们系统在网络传输间的安全性

开启方式:

cat <<EOF > /etc/sysctl.d/k8s.conf

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

EOF

sysctl --system

当我们执行完成以后,要确保红框中的值为1

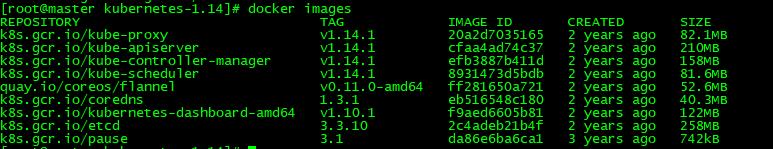

通过镜像安装K8S

切换目录: cd /usr/local/k8s/kubernetes-1.14

加载本地镜像—k8s: docker load -i k8s-114-images.tar.gz

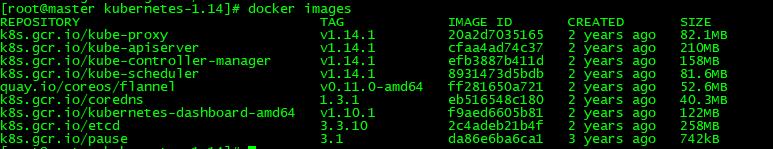

加载完成后查看:docker images

[root@master kubernetes-1.14]# docker images

REPOSITORY TAG IMAGE ID CREATED SIZE

k8s.gcr.io/kube-proxy v1.14.1 20a2d7035165 2 years ago 82.1MB

k8s.gcr.io/kube-apiserver v1.14.1 cfaa4ad74c37 2 years ago 210MB

k8s.gcr.io/kube-controller-manager v1.14.1 efb3887b411d 2 years ago 158MB

k8s.gcr.io/kube-scheduler v1.14.1 8931473d5bdb 2 years ago 81.6MB

k8s.gcr.io/coredns 1.3.1 eb516548c180 2 years ago 40.3MB

k8s.gcr.io/etcd 3.3.10 2c4adeb21b4f 2 years ago 258MB

k8s.gcr.io/pause 3.1 da86e6ba6ca1 3 years ago 742kB

如果看过我上一篇K8S入门的同学,应该很熟悉这些东西,这里就不做详细介绍了,感兴趣的可以去看一看

这一篇 K8S(Kubernetes)我觉得可以了解一下!!!

加载本地镜像—对集群可视化: docker load -i flannel-dashboard.tar.gz

同样我们也可以使用docker images进行查看

到这里我们K8S的前置工作已经完成了,但是我们今天安装的集群环境,所以上面的步骤,在其他两台机器中也要进行安装,当我们安装好了之后,其他的两台机器使用docker images,也能 出现上面的信息表示我们安装完成,这里我们就不做重复的工作了,大家可以自行安装好

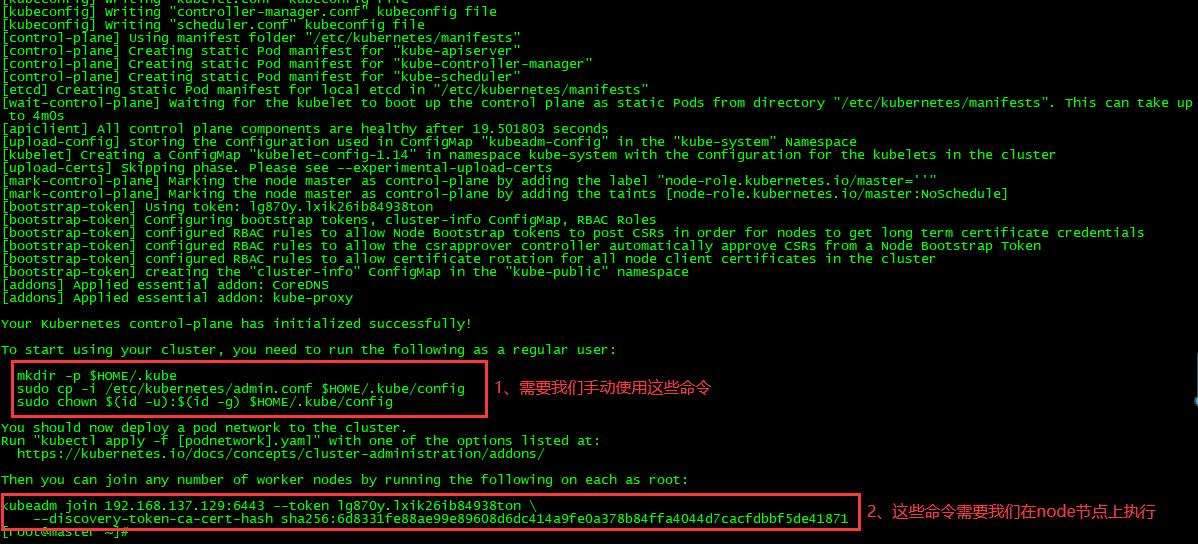

使用Kubeadm部署K8S集群

master 主服务配置

下面的步骤我们都是在 129(master) 这台服务器上执行的,请大家注意!!!

- master主服务器配置:

kubeadm init --kubernetes-version=v1.14.1 --pod-network-cidr=10.244.0.0/16

versioin:版本

cidr:Ip范围必须在10.244之内

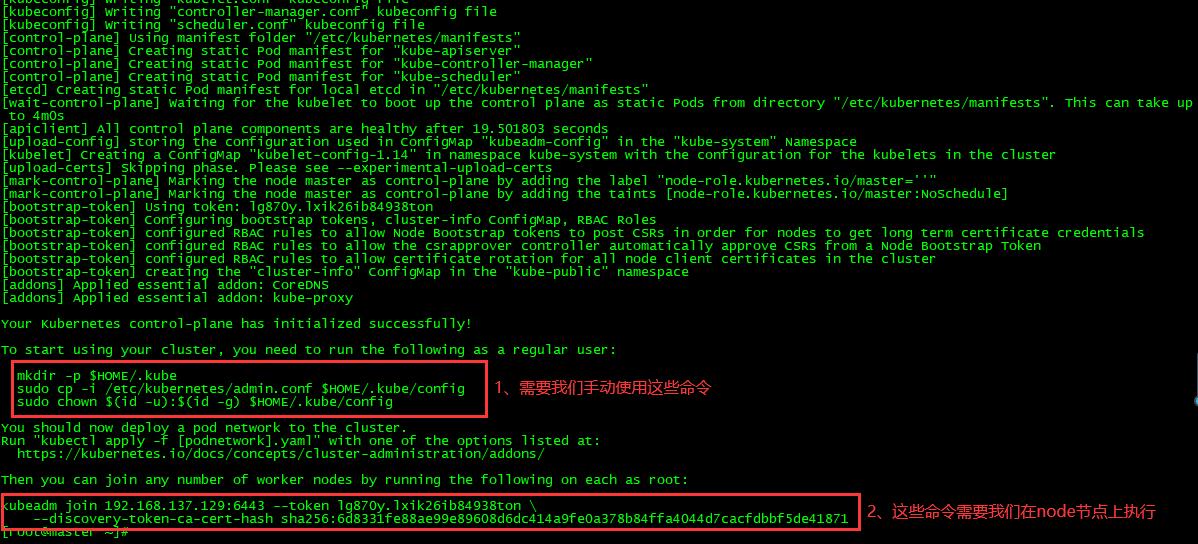

安装成功之后我们可以看到下面的信息:

第一步:

这三行命令需要我们复制以后手动去运行

mkdir -p $HOME/.kube ## 表示需要我们创建一个.kube目录

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config ##将admin.conf 复制到config中

sudo chown $(id -u):$(id -g) $HOME/.kube/config ## 进行授权操作

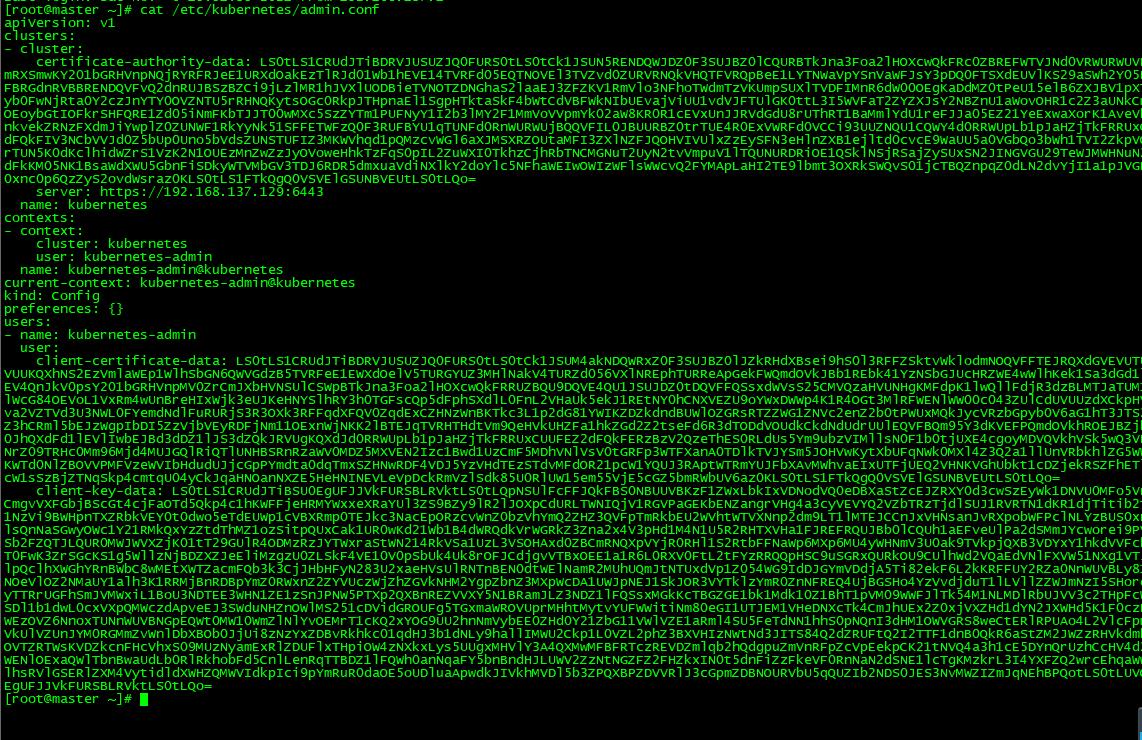

admin.conf 是kubeadm有关于当前集群的核心配置文件,包含了kubeadm集群信息,也包含节点的信息,大家可以看一下

第二步:

这条命令需要我们在节点中(130、131)去运行,让我们的节点信息加入到master(129)中,我们可以先复制保存一下

kubeadm join 192.168.137.129:6443 --token lg870y.lxik26ib84938ton \\

--discovery-token-ca-cert-hash sha256:6d8331fe88ae99e89608d6dc414a9fe0a378b84ffa4044d7cacfdbbf5de41871

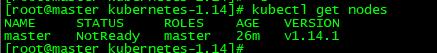

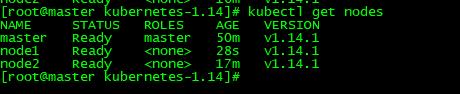

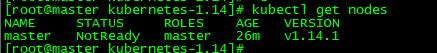

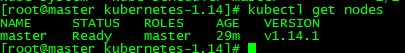

通过kubectl获取节点信息(包含master):kubectl get nodes

name:主机名

STATUS:状态

ROLES:角色

AGE:创建时间26分钟

VERSION:版本

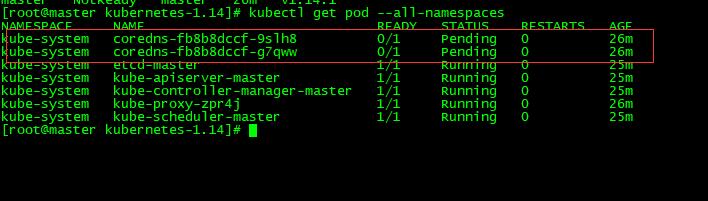

从上图中我们可以看到,节点只有master,没有Node,是因为当前没有执行第二步的操作,所以当前没有节点加入到我们的master中,当时我们看到 status 是 NotReady,是没有准备好,这是为什么呢,在底层肯定是有什么组件没有正常的执行,我们可以通过下面这个命令来查看

查看存在问题的pod:kubectl get pod --all-namespaces

如果我们在状态(STATUS)中看到

CrashLoopBackOff一般重新执行几次kubectl get pod --all-namespaces命令就会没有,但是如果一直存在,表示我们硬件不够,需要增加CPU和内存资源就可以了。

我们可以前两行的是状态一直是 Pending,其他的都是Running,这是不正常的,那为什么只有前两个是这样的,后面的是好的呢,这个问题是必然会出现的。

我们可以看到 name下 有一个 coredns,它代表的是我们基础中的网络应用,这个基础的网络应用因为缺少一个额外的组件,所以无法进行安装,在这里是因为缺少 flannel网络组件,它是pod的网络组件,我们只需要通过 kubectl 进行安装就可以了

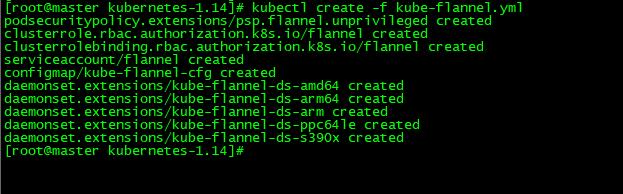

安装flannel网络组件:kubectl create -f kube-flannel.yml

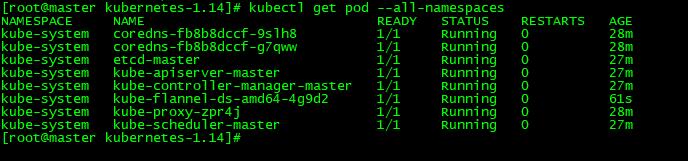

安装成功以后我们再使用命令:kubectl get pod --all-namespaces,就不会出现Pending的状态了

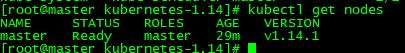

并且master也是准备就绪了

node 从服务配置

还记得我们在主服务(master)初始化的时候,复制下来的第二步的命令吗,我们在node(130、131)节点中只需要执行那条命令就可以了,

PS:这条命令是由我自己的master生成的,大家需要替换成你们自己的那条命令才可以。

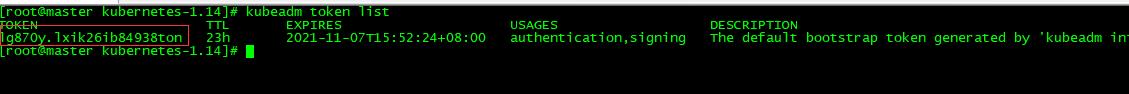

如果我们忘记了这条命令,我们可以通过

kubeadm token list命令去查看,然后将下方的IP地址和token替换一下就可以了,其他不用替换

kubeadm join 192.168.137.129:6443 --token lg870y.lxik26ib84938ton \\

--discovery-token-ca-cert-hash sha256:6d8331fe88ae99e89608d6dc414a9fe0a378b84ffa4044d7cacfdbbf5de41871

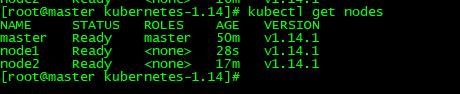

通过kubectl获取节点信息(包含master):kubectl get nodes

然后我们就可以看到,两个节点已经加入进来了

重新启动服务

重启docker:systemctl restart docker

重启kubelet:systemctl restart kubelet

设置开机启动:systemctl enablekubelet

kubeadm/kubelet/kubectl区别

- kubeadm:是kubernetes集群快速构建工具

- kubelet 运行在所有节点上,负责启动Pod和容器,以系统服务形式出现

- kubectl:kubectl是kubernetes命令行工具,提供指令

小结

到这里K8S的集群服务就讲完了,其实本身安装K8S并不复杂,但是你架不住里面有许多许多的坑,大家可能看到我安装的比较顺利,但是小农也是躺了很多坑,这篇文章才呈现给大家的,如果觉得文章对你有帮助的,记得点赞关注,你的支持我创作的最大动力。

如果有疑问或者不懂的地方,欢迎在下面留言,小农看到了,会第一时间回复大家。

怕什么真理无穷,进一步 有进一步的欢喜,大家加油~

这一篇 K8S(Kubernetes)集群部署 我觉得还可以

点赞再看,养成习惯,微信搜索【牧小农】关注我获取更多资讯,风里雨里,小农等你,很高兴能够成为你的朋友。

国内安装K8S的四种途径

Kubernetes 的安装其实并不复杂,因为Kubernetes 属于Google 的产品,都是从Google的官方上进行下载,但是因为网络问题,在国内是没办法连接它的中央仓库进行下载安装包的,只能通过其他的途径进行安装,在国内有四种安装方式

- 使用 Kubeadmin 通过离线镜像安装: Kubeadmin 是K8S提供的管理控制台,通过这里的命令可以非常方便的对我们集群进行快速发布和部署

- 使用阿里云公有云平台安装K8S: 这是也是非常好用的,不用做任何设置,拿来就用,但是有一个缺点——要钱

- 通过yum官方仓库安装: 这个是最简单的,但是这个安装K8S的包是非常古老的版本,听说是和谷歌最新的差了十个版本

- 通过二进制包的形式进行安装: 采用第三方的提供的二进制包的形式来安装K8S,比如 Kubeasz,它是github的一个开源项目,因为它是由三方来提供的,如果在没有仔细验证的情况下,是非常容易出错的,后台存在什么样的缺陷,你是不知道的。

今天我们这里采用的是第一种 使用 Kubeadmin 通过离线镜像安装K8S,本文也会使用 Kubeadmin 来为大家展示K8S的集群部署和安装,环境和安装包我都为大家准备好了,大家感兴趣的可以进行下载安装。

关注公众号:牧小农,回复 k8s ,就可以获取下载地址了

环境准备

结构图:

1.1 物理机系统

在这里需要说明一下,小农是本地虚拟机安装测试的,如果不知道怎么安装,看下面的我安装虚拟机的教程:

虚拟机安装教程:安装linux虚拟机(CentOS) 详细教程

安装K9S需要处理器的数量为2,否则后面初始化的时候会失败

1,1 物理机操作系统采用Centos7.8 64位

[root@localhost ~]# uname -a

Linux localhost.localdomain 3.10.0-1127.el7.x86_64 #1 SMP Tue Mar 31 23:36:51 UTC 2020 x86_64 x86_64 x86_64 GNU/Linux

[root@localhost ~]# cat /etc/redhat-release

CentOS Linux release 7.8.2003 (Core)

1.2 集群信息

| 节点及功能 | 主机名 | IP |

|---|---|---|

| Master、etcd、registry | Master | 192.168.137.129 |

| Node1 | Node1 | 192.168.137.130 |

| Node2 | Node2 | 192.168.137.131 |

环境准备命令

2.1 设置时区

三台机器都需要执行:timedatectl set-timezone Asia/Shanghai

2.2 设置主机名

129执行: hostnamectl set-hostname master

130执行: hostnamectl set-hostname node1

131执行: hostnamectl set-hostname node2

2.3 添加hosts网络主机配置

三台主机都需要添加这个配置

vi /etc/hosts

192.168.137.129 master

192.168.137.130 node1

192.168.137.131 node2

添加完成之后我们在master上验证一下 ping node1

[root@localhost ~]# ping node1

PING node1 (192.168.137.130) 56(84) bytes of data.

64 bytes from node1 (192.168.137.130): icmp_seq=1 ttl=64 time=0.605 ms

64 bytes from node1 (192.168.137.130): icmp_seq=2 ttl=64 time=0.382 ms

64 bytes from node1 (192.168.137.130): icmp_seq=3 ttl=64 time=0.321 ms

2.4 关闭防火墙

生产环境可以跳过这一步,在生产环境不要执行这个,这里只是为了方便我们学习的时候使用

SELINUX是安全增强型的LINUX,是LINUX内置安全增强模块,可以增强LINUX的安全性,但是这个设置起来太麻烦了,所以我们在学习过程中一般都会关闭掉这个

关闭命令:sed -i 's/SELINUX=enforcing/SELINUX=disabled/g' /etc/selinux/config

设置为临时生效:setenforce 0

禁用防火墙:systemctl disable firewalld

停止防火墙:systemctl stop firewalld

安装Kubeadm部署工具

首先我们要弄清楚一个概念,Kubeadm 并不是 K8S 本身,Kubeadm只是一个快速部署工具,通过安装这个工具可以帮助我们简化K8S部署的过程。

创建文件目录: mkdir /usr/local/k8s

切换目录地址: cd /usr/local/k8s

然后我们将安装包(kubernetes-1.14 安装包在开头有下载连接)放到 k8s 这个目录下

[root@master k8s]# ll

drwxr-xr-x 2 root root 335 Nov 6 11:17 kubernetes-1.14

切换到kubernetes的目录

[root@master k8s]# cd kubernetes-1.14/

[root@master kubernetes-1.14]# ll

total 986908

-rw-r--r-- 1 root root 357 Jul 3 14:15 admin-role.yaml

-rw-r--r-- 1 root root 67 Jul 3 14:15 daemon.json

-rw-r--r-- 1 root root 67850818 Jul 3 14:15 docker-ce-18.09.tar.gz

-rw-r--r-- 1 root root 177698304 Jul 3 14:15 flannel-dashboard.tar.gz

-rw-r--r-- 1 root root 927 Jul 3 14:15 init.sh

-rw-r--r-- 1 root root 706070528 Jul 3 14:15 k8s-114-images.tar.gz

-rw-r--r-- 1 root root 79 Jul 3 14:15 k8s.conf

-rw-r--r-- 1 root root 58913350 Jul 3 14:15 kube114-rpm.tar.gz

-rw-r--r-- 1 root root 12306 Jul 3 14:15 kube-flannel.yml

-rw-r--r-- 1 root root 281 Jul 3 14:15 kubernetes-dashboard-admin.rbac.yaml

-rw-r--r-- 1 root root 4809 Jul 3 14:15 kubernetes-dashboard.yaml

-rw-r--r-- 1 root root 953 Jul 3 14:15 worker-node.sh

[root@master kubernetes-1.14]#

这里面就包含了我们安装K8S的所有内容,其中

kube114-rpm.tar.gz: 是我们Kubeadm 集群管理工具的安装压缩包

docker-ce-18.09.tar.gz: 是我们docker的安装压缩包,可以进行本地化安装

k8s-114-images.tar.gz: 是K8S镜像本身,我们K8S的安装是 通过 Kubeadm 集群管理工具对K8S的镜像进行自动化部署

flannel-dashboard.tar.gz: 用来监控集群状态

安装docker

我们需要在三台机器上都安装docker,文中用 master 节点来做演示

首先对 docker-ce-18.09.tar.gz进行解压缩

[root@master kubernetes-1.14]# tar -zxvf docker-ce-18.09.tar.gz

[root@master kubernetes-1.14]# cd docker

在安装之前我们首先需要保证本来的yum源和docker依赖是最新的,所以我们需要先执行以下命令,这一步命令执行都是在 docker这个目录下执行的

1、安装GCC

yum -y install gcc

yum -y install gcc-c++

2、卸载老版本的docker和依赖

yum remove docker docker-client docker-client-latest docker-common docker-latest docker-latest-logrotate docker-logrotate docker-selinux docker-engine-selinux docker-engine

3、安装 yum-utils组件:yum install -y yum-utils device-mapper-persistent-data lvm2

4、添加yum 源 PS

docker官网地址:

sudo yum-config-manager --add-repo https://download.docker.com/linux/centos/docker-ce.repo

阿里云地址:sudo yum-config-manager --add-repo http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

5、更新yum索引:sudo yum makecache fast

6、安装docker-ce:sudo yum install docker-ce

7、卸载老版本的docker和依赖

这一步不是重复,是为了卸载上一步的 docker-ce来安装我们k8s包里面的 docker-ce

yum remove docker docker-client docker-client-latest docker-common docker-latest docker-latest-logrotate docker-logrotate docker-selinux docker-engine-selinux docker-engine

8、执行我们安装包里面的文件:yum localinstall -y *.rpm

到这里就代表我们的docker安装完成了

启动docker: systemctl start docker

设置docker为自动启动: systemctl enable docker

保证 cgroups 在同一个 groupfs

执行命令:

[root@master docker]# docker info | grep cgroup

Cgroup Driver: cgroupfs

cgroups是control groups的简称,它为Linux内核提供了一种任务聚集和划分的机制,通过一组参数集合将一些任务组织成一个或多个子系统。cgroups是实现IaaS虚拟化(kvm、lxc等),PaaS容器沙箱(Docker等)的资源管理控制部分的底层基础。- 子系统是根据

cgroup对任务的划分功能将任务按照一种指定的属性划分成的一个组,主要用来实现资源的控制。 - 在

cgroup中,划分成的任务组以层次结构的形式组织,多个子系统形成一个数据结构中类似多根树的结构。cgroup包含了多个孤立的子系统,每一个子系统代表单一的资源

我们只需要确认输入上面的命令后出现的是: Cgroup Driver: cgroupfs就可以了

当我们输入命令发现不是 Cgroup Driver: cgroupfs这个结果,那我们需要执行下面的命令:

对 daemon.json 进行修改:

cat << EOF > /etc/docker/daemon.json

"exec-opts": ["native.cgroupdriver=cgroupfs"]

EOF

systemctl daemon-reload && systemctl restart docker

安装kubeadm

kubeadm是K8S官方提供的集群部署工具,通过这个工具可以快速帮助我们简化的完成K8S的管理,以及各集群节点下的容器创建

切换目录: cd /usr/local/k8s/kubernetes-1.14

解压 kube114安装包: tar -zxvf kube114-rpm.tar.gz

切换目录: cd kube114-rpm

安装: yum localinstall -y *.rpm

关闭交换区

- 在linux系统中,交换区类似于我们的

windows的虚拟内存,作为windows的虚拟内存,其实就是用物理磁盘模拟内存. - 比如说我们系统内存比较小,那么在进行数据处理的时候,内存不够了,我们就会先把这些数据寄存在硬盘上,用硬盘空间模拟内存来使用,虽然硬盘提取数据的速度比较慢,但是总是比内存不够要好,在linux系统中,交换区就是我们所说的虚拟内存了.

- 在这里,虚拟内存可能会对系统部署产生不必要的影响,在K8S的环境下,使用的服务器一般都是内存比较充足的,所以我们一般不推荐使用系统交换区,这样会让我们系统的性能降低,在这里选择关闭交换区

关闭交换区:swapoff -a

修改配置文件,永久关闭交换区:vi /etc/fstab

swap一行注释

配置网桥

所谓配置网桥其实就是我们对k8s.conf这个文件进行修改

iptables 是在linux中的一个网络工具,用来对我们包按照规则进行过滤,在k8s.conf中增加下面两行配置当在K8S容器间进行网络通信的时候,当网桥进行数据传输的时候,也要遵循iptables的规则,进行相应的处理,这样可以提高我们系统在网络传输间的安全性

开启方式:

cat <<EOF > /etc/sysctl.d/k8s.conf

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

EOF

sysctl --system

当我们执行完成以后,要确保红框中的值为1

通过镜像安装K8S

切换目录: cd /usr/local/k8s/kubernetes-1.14

加载本地镜像—k8s: docker load -i k8s-114-images.tar.gz

加载完成后查看:docker images

[root@master kubernetes-1.14]# docker images

REPOSITORY TAG IMAGE ID CREATED SIZE

k8s.gcr.io/kube-proxy v1.14.1 20a2d7035165 2 years ago 82.1MB

k8s.gcr.io/kube-apiserver v1.14.1 cfaa4ad74c37 2 years ago 210MB

k8s.gcr.io/kube-controller-manager v1.14.1 efb3887b411d 2 years ago 158MB

k8s.gcr.io/kube-scheduler v1.14.1 8931473d5bdb 2 years ago 81.6MB

k8s.gcr.io/coredns 1.3.1 eb516548c180 2 years ago 40.3MB

k8s.gcr.io/etcd 3.3.10 2c4adeb21b4f 2 years ago 258MB

k8s.gcr.io/pause 3.1 da86e6ba6ca1 3 years ago 742kB

如果看过我上一篇K8S入门的同学,应该很熟悉这些东西,这里就不做详细介绍了,感兴趣的可以去看一看

这一篇 K8S(Kubernetes)我觉得可以了解一下!!!

加载本地镜像—对集群可视化: docker load -i flannel-dashboard.tar.gz

同样我们也可以使用docker images进行查看

到这里我们K8S的前置工作已经完成了,但是我们今天安装的集群环境,所以上面的步骤,在其他两台机器中也要进行安装,当我们安装好了之后,其他的两台机器使用docker images,也能 出现上面的信息表示我们安装完成,这里我们就不做重复的工作了,大家可以自行安装好

使用Kubeadm部署K8S集群

master 主服务配置

下面的步骤我们都是在 129(master) 这台服务器上执行的,请大家注意!!!

- master主服务器配置:

kubeadm init --kubernetes-version=v1.14.1 --pod-network-cidr=10.244.0.0/16

versioin:版本

cidr:Ip范围必须在10.244之内

安装成功之后我们可以看到下面的信息:

第一步:

这三行命令需要我们复制以后手动去运行

mkdir -p $HOME/.kube ## 表示需要我们创建一个.kube目录

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config ##将admin.conf 复制到config中

sudo chown $(id -u):$(id -g) $HOME/.kube/config ## 进行授权操作

admin.conf 是kubeadm有关于当前集群的核心配置文件,包含了kubeadm集群信息,也包含节点的信息,大家可以看一下

第二步:

这条命令需要我们在节点中(130、131)去运行,让我们的节点信息加入到master(129)中,我们可以先复制保存一下

kubeadm join 192.168.137.129:6443 --token lg870y.lxik26ib84938ton \\

--discovery-token-ca-cert-hash sha256:6d8331fe88ae99e89608d6dc414a9fe0a378b84ffa4044d7cacfdbbf5de41871

通过kubectl获取节点信息(包含master):kubectl get nodes

name:主机名

STATUS:状态

ROLES:角色

AGE:创建时间26分钟

VERSION:版本

从上图中我们可以看到,节点只有master,没有Node,是因为当前没有执行第二步的操作,所以当前没有节点加入到我们的master中,当时我们看到 status 是 NotReady,是没有准备好,这是为什么呢,在底层肯定是有什么组件没有正常的执行,我们可以通过下面这个命令来查看

查看存在问题的pod:kubectl get pod --all-namespaces

如果我们在状态(STATUS)中看到

CrashLoopBackOff一般重新执行几次kubectl get pod --all-namespaces命令就会没有,但是如果一直存在,表示我们硬件不够,需要增加CPU和内存资源就可以了。

我们可以前两行的是状态一直是 Pending,其他的都是Running,这是不正常的,那为什么只有前两个是这样的,后面的是好的呢,这个问题是必然会出现的。

我们可以看到 name下 有一个 coredns,它代表的是我们基础中的网络应用,这个基础的网络应用因为缺少一个额外的组件,所以无法进行安装,在这里是因为缺少 flannel网络组件,它是pod的网络组件,我们只需要通过 kubectl 进行安装就可以了

安装flannel网络组件:kubectl create -f kube-flannel.yml

安装成功以后我们再使用命令:kubectl get pod --all-namespaces,就不会出现Pending的状态了

并且master也是准备就绪了

node 从服务配置

还记得我们在主服务(master)初始化的时候,复制下来的第二步的命令吗,我们在node(130、131)节点中只需要执行那条命令就可以了,

PS:这条命令是由我自己的master生成的,大家需要替换成你们自己的那条命令才可以。

如果我们忘记了这条命令,我们可以通过

kubeadm token list命令去查看,然后将下方的IP地址和token替换一下就可以了,其他不用替换

kubeadm join 192.168.137.129:6443 --token lg870y.lxik26ib84938ton \\

--discovery-token-ca-cert-hash sha256:6d8331fe88ae99e89608d6dc414a9fe0a378b84ffa4044d7cacfdbbf5de41871

通过kubectl获取节点信息(包含master):kubectl get nodes

然后我们就可以看到,两个节点已经加入进来了

重新启动服务

重启docker:systemctl restart docker

重启kubelet:systemctl restart kubelet

设置开机启动:systemctl enablekubelet

kubeadm/kubelet/kubectl区别

- kubeadm:是kubernetes集群快速构建工具

- kubelet 运行在所有节点上,负责启动Pod和容器,以系统服务形式出现

- kubectl:kubectl是kubernetes命令行工具,提供指令

小结

到这里K8S的集群服务就讲完了,其实本身安装K8S并不复杂,但是你架不住里面有许多许多的坑,大家可能看到我安装的比较顺利,但是小农也是躺了很多坑,这篇文章才呈现给大家的,如果觉得文章对你有帮助的,记得点赞关注,你的支持我创作的最大动力。

如果有疑问或者不懂的地方,欢迎在下面留言,小农看到了,会第一时间回复大家。

怕什么真理无穷,进一步 有进一步的欢喜,大家加油~

以上是关于这一篇 K8S(Kubernetes)集群部署 我觉得还可以!!!的主要内容,如果未能解决你的问题,请参考以下文章

这一篇 K8S(Kubernetes)集群部署 我觉得还可以

这一篇 K8S(Kubernetes)集群部署 我觉得还可以

这一篇 K8S(Kubernetes)集群部署 我觉得还可以