自然语言预训练模型知识增强方法综述

Posted 专知

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了自然语言预训练模型知识增强方法综述相关的知识,希望对你有一定的参考价值。

将知识引入到依靠数据驱动的人工智能模型中是实现人机混合智能的一种重要途径。当前以BERT为代表的预训练模型在自然语言处理领域取得了显著的成功,但是由于预训练模型大多是在大规模非结构化的语料数据上训练出来的,因此可以通过引入外部知识在一定程度上弥补其在确定性和可解释性上的缺陷。该文针对预训练词嵌入和预训练上下文编码器两个预训练模型的发展阶段,分析了它们的特点和缺陷,阐述了知识增强的相关概念,提出了预训练词嵌入知识增强的分类方法,将其分为四类:词嵌入改造、层次化编解码过程、优化注意力和引入知识记忆。将预训练上下文编码器的知识增强方法分为任务特定和任务通用两大类,并根据引入知识的显隐性对其中任务通用的知识增强方法进行了进一步的细分。该文通过分析预训练模型知识增强方法的类型和特点,为实现人机混合的人工智能提供了模式和算法上的参考依据。

数据驱动和知识驱动是当前实现人工智能的两 条重要途径。近年来以深度学习为代表的数据驱动 方法在各类任务上取得了极大的成功,在自然语言 处理领域,在大规模语料上训练的预训练语言模型 在各项任务上均显示出良好的性能。尽管如此,当前以数据驱动的方法仍然存在较大的局限性,张钹 院士认为其适用场景仅限于:具有充分知识或数 据、稳定性、完全信息、静态、特定领域与单任务。知 识驱动的人工智能具有良好的逻辑性和可解释性, 但却严重依赖人工定义的知识与规则,缺少对特征 抽象和学习的能力,难以完整地表示人类的经验和 知识。通过将知识融入深度学习模型中,可以在一定 程度上提高模型的泛化能力,同时增强模型的可控 性。当前,从大规模数据中进行知识抽取和知识图 谱建设的相关工作已逐渐成熟,但由于知识与训练 语料或数据的异构性,对于知识赋能深度学习模型、 指导应用实践的方法研究仍不够充分。因此,本文 通过总结分析自然语言预训练模型知识增强的方 法,来展示知识增强深度学习模型的途径和发展趋 势,为实现通用的人机混合智能提供可借鉴的思路。

本文主要包括以下四个部分:

1) 介绍了预训练模型与知识增强两个基本概 念,分析了预训练词嵌入和预训练上下文编码器的 特点与不足,阐述了知识的分类、知识库的类型和知 识增强的基本模式。

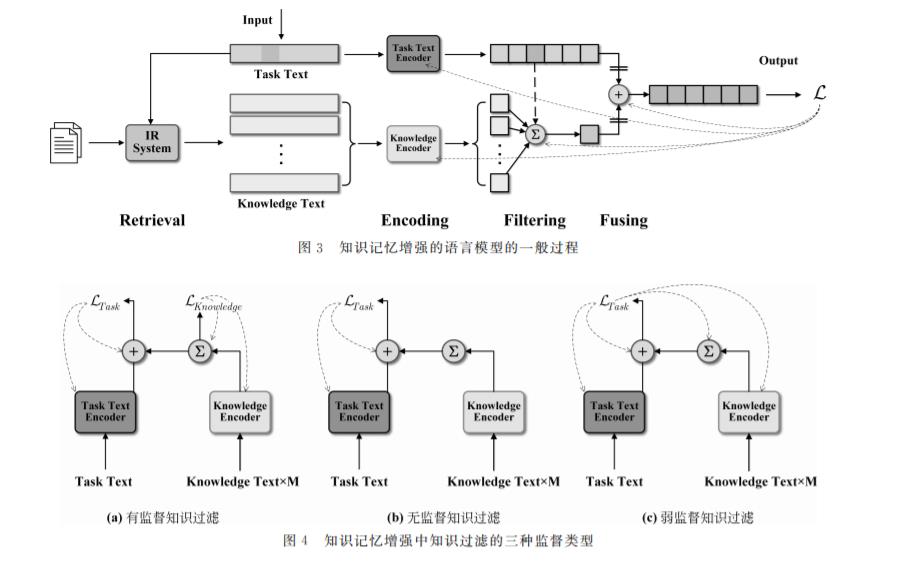

2) 总结分析了以预训练词嵌入为基础的语言 模型知识增强的方法,提出将预训练词嵌入知识增 强分为四类:词嵌入改造、层次化编解码过程、优化 注意力和引入知识记忆,并分析了他们的特点与适 用场景。

3) 从任务特定和任务通用、引入知识的显隐性 两个视角对预训练上下文编码器的知识增强进行了 总结分类,针对通用预训练上下文编码器,着重从显 性知识和隐性知识的角度对其知识增强方法进行了 阐述。

4) 对当前语言模型知识增强方法进行了进一 步的总结分析,并为其模式和方法的发展方向进行 了展望。

本文的文献主要来源于近年来自然语言处理与 人工智能领域的顶级会议和刊物,如 ACL、AAAI、 ICLR、IJCAI、EMNLP、NAACL、TACL等。

专知便捷查看

后台回复“NLPK” 就可以获取《自然语言预训练模型知识增强方法综述》专知下载链接

以上是关于自然语言预训练模型知识增强方法综述的主要内容,如果未能解决你的问题,请参考以下文章