python爬虫实战 | 爬取洛杉矶上千房源(建议收藏)

Posted _less is more

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了python爬虫实战 | 爬取洛杉矶上千房源(建议收藏)相关的知识,希望对你有一定的参考价值。

前言

最近打算签证流程结束后,开始看看加州的房子了,毕竟研究生是不太容易住校内的,具体来说还是看看洛杉矶的房源。因为网站在国外,访问比较慢,不同页的也不好比较,于是想着把它全部爬取下来整理成docx文档,便于搜索和直接筛选,比如价格太高的直接删掉,剩下的就是满足需求的房源了。

本文简单分析下代码后将所有源码和文件公开,大家各取所需~

python库

| Package | Version |

|---|---|

| python-docx | 0.8.11 |

| requests | 2.21.0 |

| lxml | 4.6.2 |

| bs4 | 0.0.1 |

其中:

- python-docx库用于操作docx文件,将爬取的信息保存下来

- requests发送网络请求

- lxml中的etree用于通过Xpath查找想要的页面元素

- bs4用于定位网页源码中的元素并统一筛选

房源平台

本代码中爬取的对象是 www.apartments.com 和 https://tripalink.com/,想必留学生们都对这两个网站非常熟悉。经测试,两个网站均无任何反爬机制,毕竟是公开的第三方平台,房源入驻打广告,也没有什么私有资料,既然给爬那随便爬。。。

开始

1.导入库

首先我们导入python库

#coding=utf-8

import os

import re

import docx

import urllib

import requests

from datetime import *

from lxml import etree

from bs4 import BeautifulSoup

from docx import Document

from docx.shared import Inches, Cm

from docx.enum.text import WD_PARAGRAPH_ALIGNMENT

from docx.enum.table import WD_TABLE_ALIGNMENT

from docx.enum.dml import MSO_THEME_COLOR_INDEX

结尾版式

先引入一个docx文件里的末尾版式添加函数,不理解的可以先不看,后面会用到:

def endnote(document):

p = document.add_paragraph('欢迎点赞收藏关注~')

p.paragraph_format.alignment = WD_PARAGRAPH_ALIGNMENT.CENTER

p = document.add_paragraph('https://blog.csdn.net/weixin_42815846')

p.paragraph_format.alignment = WD_PARAGRAPH_ALIGNMENT.CENTER

document.add_picture('比心.png', width=Inches(1))

document.paragraphs[-1].alignment = WD_PARAGRAPH_ALIGNMENT.CENTER

2.请求函数

再进入一个页面获取函数,此函数的输入为页面的url链接,返回页面内容,其中headers可以根据自己浏览器的具体信息来修改,当然也可以不改,作用就是伪装自己,让网站以为你是浏览器访问,而不是python源码在请求数据。

def gethtml(url):

# 借助user-agent

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/80.0.3987.100 Safari/537.36'

}

# 借助requests获取响应对象

response = requests.get(url=url, headers=headers)

# 从响应对象中获取响应内容

# 设置编码格式

response.encoding = "utf-8"

return response.text

3.Xpath提取信息

既然已经把页面请求到手,那可以通过Xpath进行搜索我们想要的信息了,代码如下。不懂Xpath可以先搜一搜Xpath的用法,再返回来看此代码。此代码爬取了 www.apartments.com 上加州洛杉矶的房源信息,第一个循环中的page范围为1-28,因为在作者爬取时该地方的房源有28页,因此循环进行爬取。

for page in range(1, 29):

print(f"第{page}页")

html = getHtml(f'https://www.apartments.com/los-angeles-ca/{page}/')

bs4 = BeautifulSoup(html, 'html.parser')

# 根据属性结构获取内容

content = bs4.find_all(name="li", attrs={"class": "mortar-wrapper"})

selecter=etree.HTML(html)

for index in range(1, len(content)+1):

title = selecter.xpath(f'//*[@id="placardContainer"]/ul/li[{index}]/article/header/div[1]/a/div[1]/span')[0].xpath('string(.)')

addr = selecter.xpath(f'//*[@id="placardContainer"]/ul/li[{index}]/article/header/div[1]/a/div[2]')[0].xpath('string(.)')

# 房屋链接

roomlink = selecter.xpath(f'//*[@id="placardContainer"]/ul/li[{index}]/article')[0].xpath('@data-url')[0]

rooms.append([title, addr, roomlink])

prefix = selecter.xpath(f'//*[@id="placardContainer"]/ul/li[{index}]/article/section/div')[0]

# 图片链接

picsrc = prefix.xpath('./div[1]/div[2]/div[2]/ul/li[1]/a')

picsrc = picsrc[0].xpath('@href')[0] if len(picsrc)>0 else "无"

# Virtual Tour

VRtour = prefix.xpath('./div[1]/div[2]/div[2]/ul/li[2]/a')

VRtour = VRtour[0].xpath('@href')[0] if len(VRtour)>0 else "无"

# 免租

freeRent = prefix.xpath('./div[2]/div/div[1]/div')

freeRent = freeRent[0].xpath('@data-specials-label')[0] if len(freeRent)>0 else "否"

# 价格

price = prefix.xpath('./div[2]/div/div[2]/div')[0].xpath('string(.)')

# 类型

roomtype = prefix.xpath('./div[2]/div/div[3]/div[1]')[0].xpath('string(.)')

# 是否可用

available = prefix.xpath('./div[2]/div/div[3]/div[2]')[0].xpath('string(.)')

# 便利设施

amenities = []

for i, per1 in enumerate(prefix.xpath('./div[2]/div/div[4]/span')):

amenities.append(per1.xpath('string(.)'))

# 电话

telephone = prefix.xpath('./div[2]/div/div[5]/a/span')

telephone = telephone[0].xpath('string(.)') if len(telephone)>0 else "无"

rooms[-1].extend([picsrc, VRtour, freeRent, price, roomtype, available, amenities, telephone])

可见,在代码中爬取了房源的很多信息:房屋名、房屋链接、内部图片链接、VR看房、免租信息、价格、住房类型、可用性、便利设施以及联系电话等。其中图片链接还可以进一步将图片爬取下来,但是为了docx文档的组织便利性,仅将链接保存下来 (毕竟它给你看的多半不是实际的样子。。懂的都懂

4.存入docx

最后利用如下函数将所有信息存入docx,用到了Document类。其中add_heading表示加标题,第二个参数中的0表示0号标题,1表示1号标题;add_paragraph表示加一个段落;用到了add_table添加表格,以及居中、合并、设置列宽等操作。

def apartments2docx(data):

document = Document()

header = 'LA lease from www.apartments.com {}'.format(datetime.now().strftime('%a, %b %d %H:%M'))

document.add_heading(header, 0)

names = ['房屋类型', 'Availability', '价格', '是否免租', '便利设施', '室内概览', 'VR看房', '房屋链接', '联系方式']

orders = [7, 8, 6, 5, 9, 3, 4, 2, 10]

for i, room in enumerate(data):

document.add_heading(f"{i+1}. "+room[0], 1)

document.add_paragraph(room[1])

table = document.add_table(rows=10, cols=2, style='Table Grid')

for index, column in enumerate(table.columns):

for cell in column.cells:

cell.width = Inches(1) if index == 0 else Inches(5)

table.cell(0,0).merge(table.cell(0,1))

for row, obj_row in enumerate(table.rows):

if row == 0:

obj_row.cells[0].text = "租赁信息"

else:

x = orders[row-1]

obj_row.cells[1].text = room[x] if x != 9 else '、'.join(room[x])

obj_row.cells[0].text = names[row-1]

table.cell(0,0).paragraphs[0].paragraph_format.alignment = WD_TABLE_ALIGNMENT.CENTER

document.add_paragraph('')

endnote(document)

document.save('ApartmentsRooms.docx')

如有报错Failed to establish a new connection: [WinError 10060] 由于连接方在一段时间后没有正确答复或连接的主机没有反应,连接尝试失败。')),换一个headers可以解决,可能网站还是有对一个客户端请求的回应上限

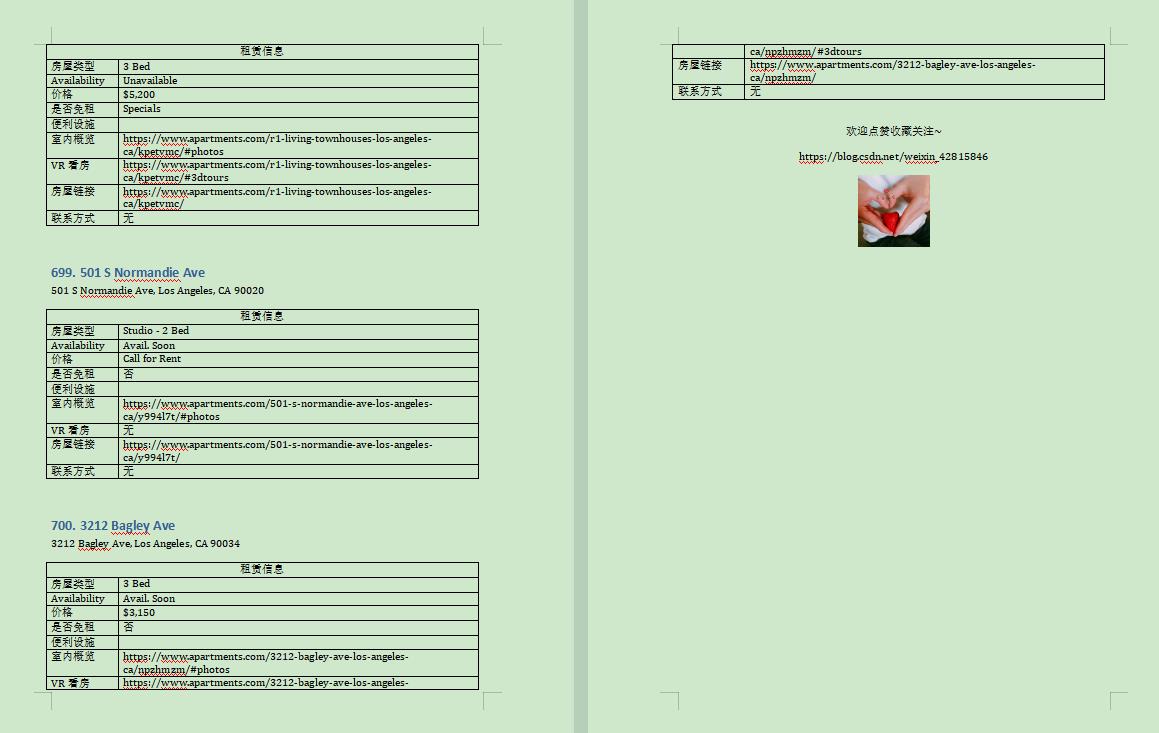

效果展示

小结(附源码)

本代码中对tripalink的爬取不再赘述,唯一不同的是没用Xpath,而是直接对BeautifulSoup对象进行操作。源码和爬取的文档链接附在GitHub 点击此处

以上是关于python爬虫实战 | 爬取洛杉矶上千房源(建议收藏)的主要内容,如果未能解决你的问题,请参考以下文章