FedPNS论文阅读笔记

Posted LeoJarvis

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了FedPNS论文阅读笔记相关的知识,希望对你有一定的参考价值。

联邦学习——FedPNS

填上一篇的坑。

《Node Selection Toward Faster Convergence for Federated Learning on Non-IID Data》这篇论文建立在数据异构的基础上,设计了一个选择性地让节点参与模型聚合的概率模型。通过排除不利于全局收敛的节点,提高模型收敛速度和预测精度。

摘要

联邦学习(FL)是一种分布式学习范式,它允许大量资源有限的节点在没有数据共享的情况下协作训练模型。非独立的和同分布的(Non-IID)数据样本造成了全局目标和局部目标之间的差异,使得FL模型收敛缓慢。本文提出了更好的最优聚合算法,该算法通过检查局部梯度与全局梯度的关系,识别和排除不利于全局收敛地局部更新,找到每个全局回合中参与节点局部更新的最优子集。最终提出了一个概率节点选择框架(FedPNS),根据最优聚合的输出动态地改变每个节点的选择概率。FedPNS可以优先选择能够促进更快的模型收敛速度的节点参与模型聚合。从理论上分析了FedPNS比常用的FedAvg算法的具有更快的收敛速度。并通过实验证明了其有效性。

节点选择的相关策略

《Client selection for federated learning with heterogeneous resources in mobile edge》

《Convergence of update aware device scheduling for federated learning at the wireless edge》

《Scheduling for cellular federated edge learning with importance and channel awareness》

《Client selection in federated learning: Convergence analysis and power-of-choice selection strategies》

这些策略就不加以讨论了,有兴趣的话可以自己下载康康。总的来讲,这些节点选择策略都没有分析数据异质性对节点选择带来的影响。

与上述研究相比,FedPNS这一基于概率的节点选择模型建立在数据异质性观点的基础上。因为FL模型很难在Non-IID数据收敛,所以要描述节点间数据样本的分布并不容易。与随机选择相比,通过识别不同节点对模型收敛的贡献程度,有目的地选择节点更有利于加速模型收敛。

FedPNS原理

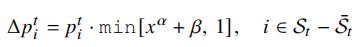

FedAvg通过随机挑选节点参与模型聚合的方式实现平均聚合,但这种方式过于简单,有些节点的梯度信息可能对全局模型的收敛起到反作用,本文提出的FedPNS通过节点的梯度信息是否有利于全局模型收敛来对节点进行筛选,该概率模型基于optimal aggregation算法,来选择具体哪些节点有利于模型收敛,该算法基于节点梯度和全局梯度的内积,若内积小于零,则不利于模型收敛,FedPNS通过check expectation方法对这些节点进行标记并调整其在下一轮训练中被选中的概率,概率分配过程如下:

其中,

p

i

t

p_i^t

pit和

Δ

p

i

t

Δp_i^t

Δpit分别表示节点 i 在第 t 轮中被选择的概率,以及在下一轮被选中的概率减少量。x∈(0,1]定义为节点被check expectation标记的次数与节点被选中参与训练的次数之间的比率。a controls how big the probability decrement is achieved by

x

a

+

β

x^a+β

xa+β given a ratio x. β ∈ [0, 1] are coefficients as explained in the following.

通过具体实验,a和β的值建议分别为2和0.7。

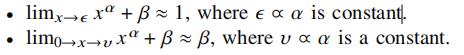

p

i

t

+

1

p_i^{t+1}

pit+1是第t+1轮中节点i被选中的概率,K是被标记的节点子集,根据FedPNS的设计要求,被标记的子集在下一轮被选中的概率会减小,而未被标记的,即有利于全局收敛的节点在下一轮被选中的概率则会增大。

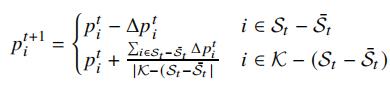

optimal aggregation及相关算法的伪代码如Algorithm 1所示

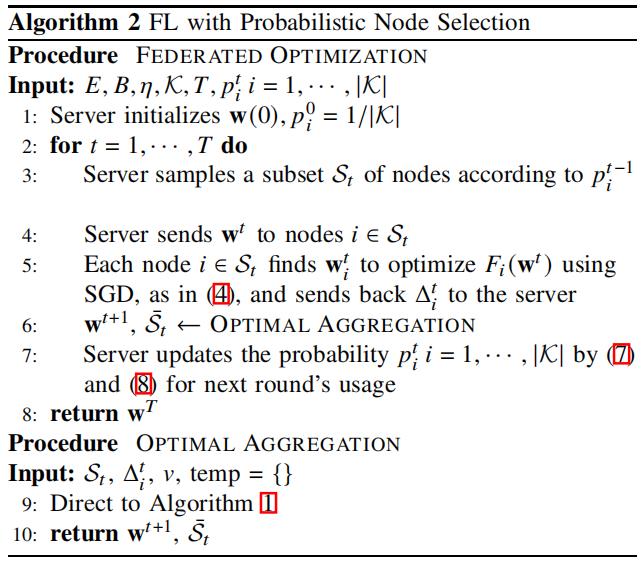

FedPNS的伪代码如Algorithm 2所示

以上是关于FedPNS论文阅读笔记的主要内容,如果未能解决你的问题,请参考以下文章