CVPR2021最佳论文:当GAN遇到3D场景,无需监督就学会“动态抠图”360度展示对象...

Posted QbitAl

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了CVPR2021最佳论文:当GAN遇到3D场景,无需监督就学会“动态抠图”360度展示对象...相关的知识,希望对你有一定的参考价值。

月石一 发自 凹非寺

量子位 报道 | 公众号 QbitAI

GAN又又又有新玩法了!

人脸?NO,NO,NO~

这回,开发者利用「3D+GAN」生成了汽车大片,还是能360度展示、随手换背景那种。

只需无监督训练,模型就可以产出几百万张新车硬照!

不只是车,还有人脸、猫咪、建筑、家具等等……(好家伙,利好设计师~)

无论是换背景、改外观,还是在场景中添加、平移、旋转对象,或者改变视角,都能搞定。

这项研究摘得CVPR2021最佳论文奖,现已开源,研究团队来自马普所和图宾根大学。

在此前的研究中,深度生成模型虽然可以合成高分辨率的图像,但生成过程的可控性不足。

而对变化因素的研究大多局限于2D空间,很少考虑场景的组成。

研究人员在GAN中加入了3D场景,新模型能够生成更可控、质量更高的图像,并且模型参数量更少。

那么3D与GAN是如何结合起来的?

GAN+3D:合成可控

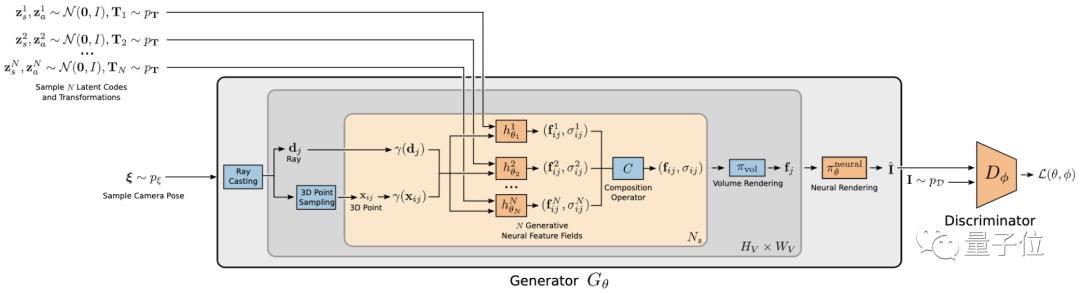

研究人员将神经渲染管道与场景表示结合,把场景表示为合成的生成性神经特征场,就得到了一个真实、高效的图像合成模型——GIRAFFE。

具体而言,首先要为场景和对象采样单独的潜在编码,为正则空间提供特征字段。

将3D点和观察方向映射到密度值和特征向量的函数,即为特征场。

接下来,为每个对象采样一个视角,生成器将对象和背景合成到一个场景中。

将生成器生成的图像与真实图像输入判别器,再利用对抗性损失进行无监督训练。

虽然训练集使用了原始、未定位的图像,但在测试时,包括相机和物体的视角,以及物体的形状、外观,都能够得到控制。

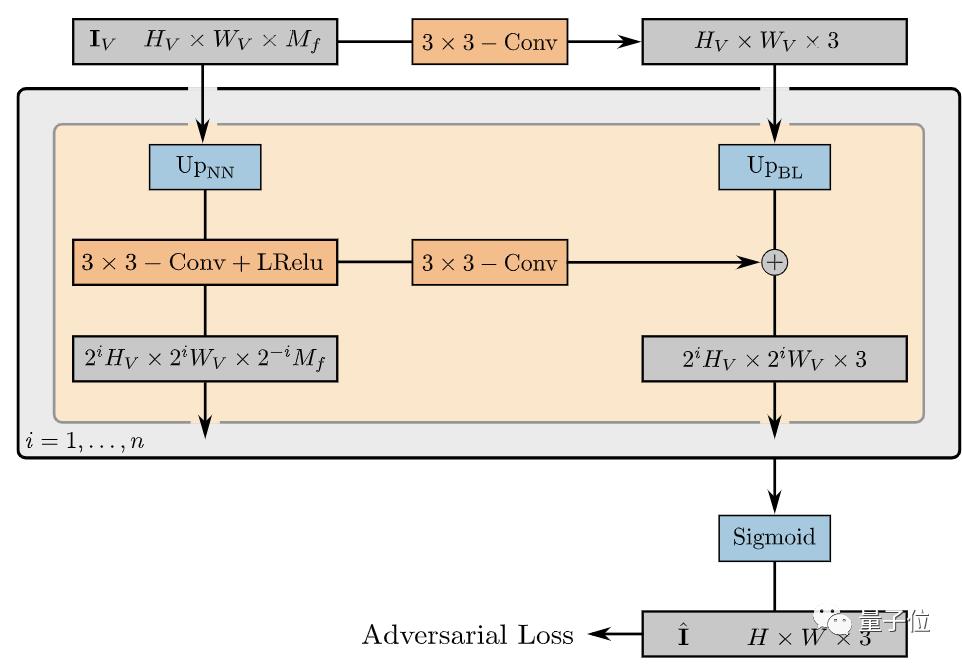

最后,利用2D神经渲染网络,对相机视角、体积渲染场景的特征图像进行采样,将其转换为最终的具有3×3卷积的RGB渲染图像。

△神经渲染网络

与其他模型对比

研究人员将GIRAFFE与基于2D的GAN进行了比较。

平移单个对象时,二者的效果对比情况:(右图为新模型)

相比之下,新模型还能够实现更复杂的操作,比如循环移动、改变背景、添加对象等。

此外,研究人员还分别使用64×64和256×256像素的图像,对不同模型进行了对比。

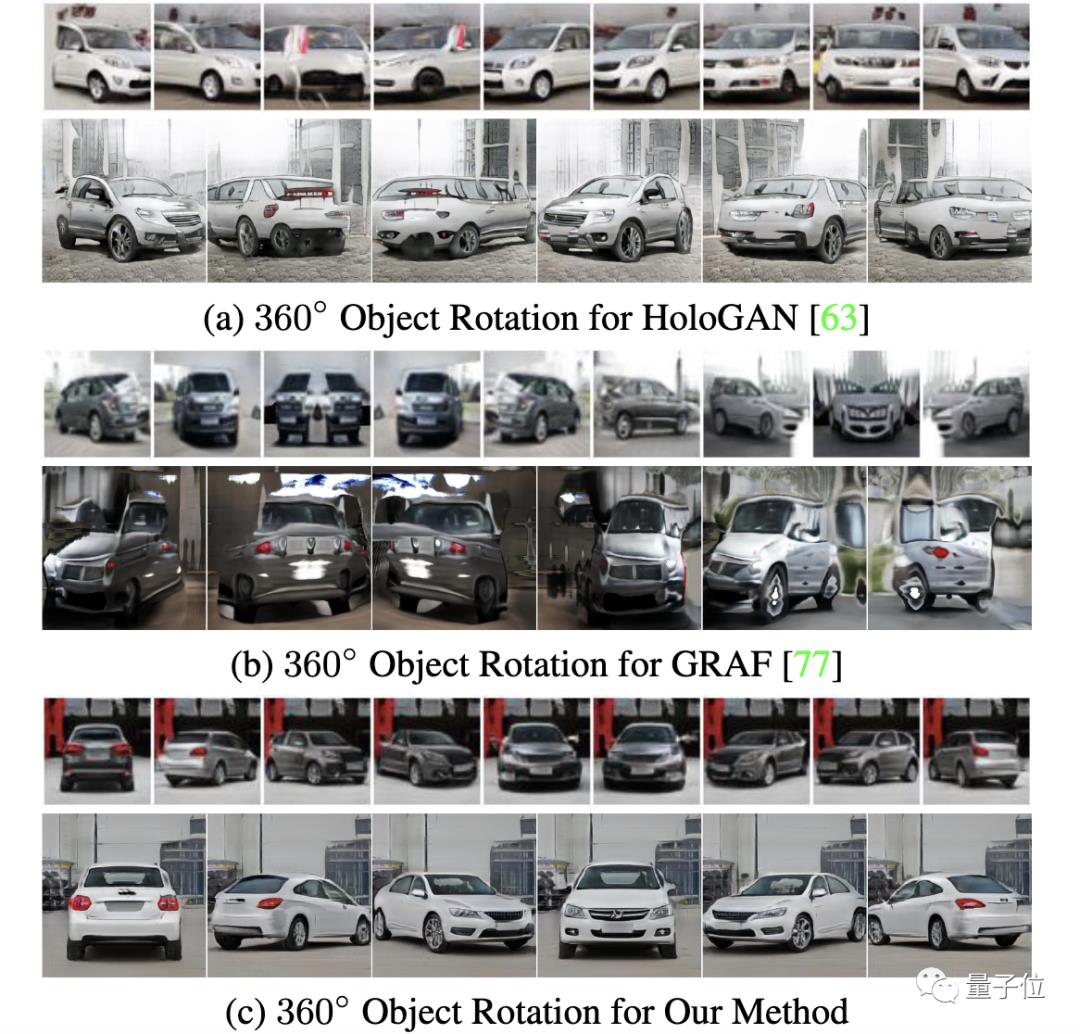

在固定背景的情况下旋转对象,新模型的效果比其他模型更优:

在定量分析中,新模型在不同像素下的FID分数都更低,说明生成效果更好:

(FID分数是通过生成图像与真实图像的“距离值”,得到的评估分数,数值越小越好。)

并且,新模型的参数量也更少:(单位:百万)

泛化能力如何?

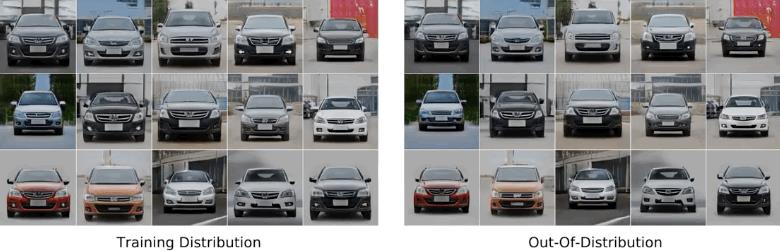

此外,模型还能在训练数据之外进行泛化。

比如增加水平和深度平移范围:

合成比训练时更多对象的场景:(训练集图像中仅一辆汽车)

开发者表示,这项技术可以应用在动画和游戏制作中。3D动画师们离解放又近了一步~

GIRAFFE已经在GitHub上开源,感兴趣的小伙伴可戳文末链接了解~

相关链接:

[1]https://arxiv.org/abs/2011.12100

[2]https://autonomousvision.github.io/giraffe/

[3]https://m-niemeyer.github.io/project-pages/giraffe/index.html

[4]https://m-niemeyer.github.io/slides/#/

[5]https://github.com/autonomousvision/giraffe

以上是关于CVPR2021最佳论文:当GAN遇到3D场景,无需监督就学会“动态抠图”360度展示对象...的主要内容,如果未能解决你的问题,请参考以下文章