YARN UI界面日志详解二——某个任务详细日志

Posted NC_NE

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了YARN UI界面日志详解二——某个任务详细日志相关的知识,希望对你有一定的参考价值。

一、任务日志在哪

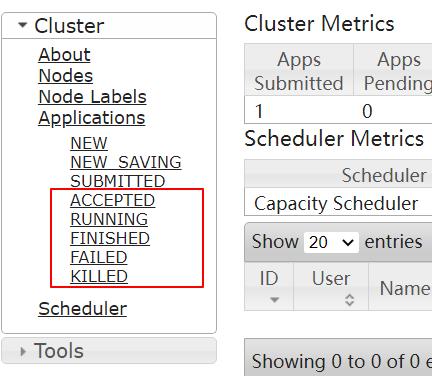

前面我们已经了解了ResourceManager UI界面参考上一篇文章YARN UI界面日志详解一,我们也看到了下图:

就在Applications下的几个状态中,只要你是提交到yarn来管理的任务那一定在这几个状态中的某一个,所以弄清楚这几个状态的日志信息那我们就能知道某个任务的运行状况了。

在实际工作中NEW、NEW_SAVING、SUBMITTED这三个用到的概率还是非常低的,而ACCEPTED、RUNNING、FINISHED、FAILE、KILLED这五个那是经常使用的,所以我们重点关注:

ACCEPTED:接受状态,已经被队列(queue)接受,但是还没有开始执行。如果生产中有任务一直停留在这个状态,那就可能是队列资源是不充足。

RUNNING:运行状态,获得我集群资源正在计算,我们也看一下点进去查看运行的日志

FINISHED:完成状态,表示任务运行完成

FAILE:失败状态,表示任务运行失败,这个时候我们就应该点进去查看日志寻找失败的原因

KILLED:被杀死状态,这个一般都是人为强制kill的

二、某个任务Finished状态详解

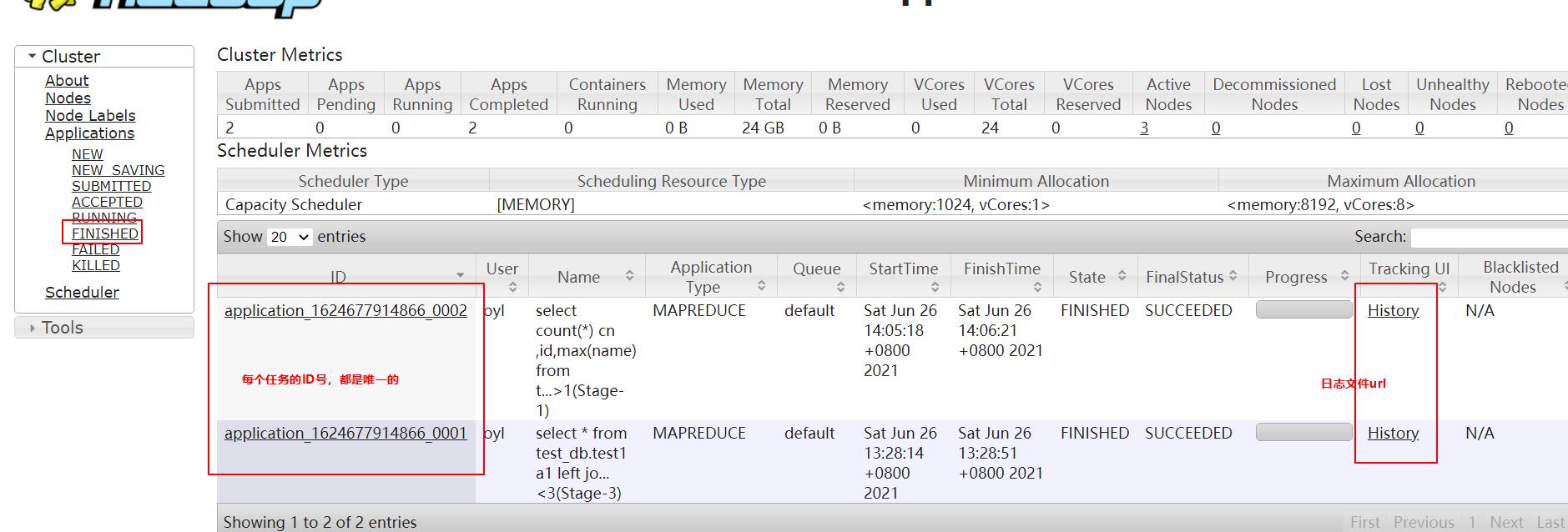

我们点击FINISHED如图:

我们点击History就可以跳转到当前任务详细信息界面

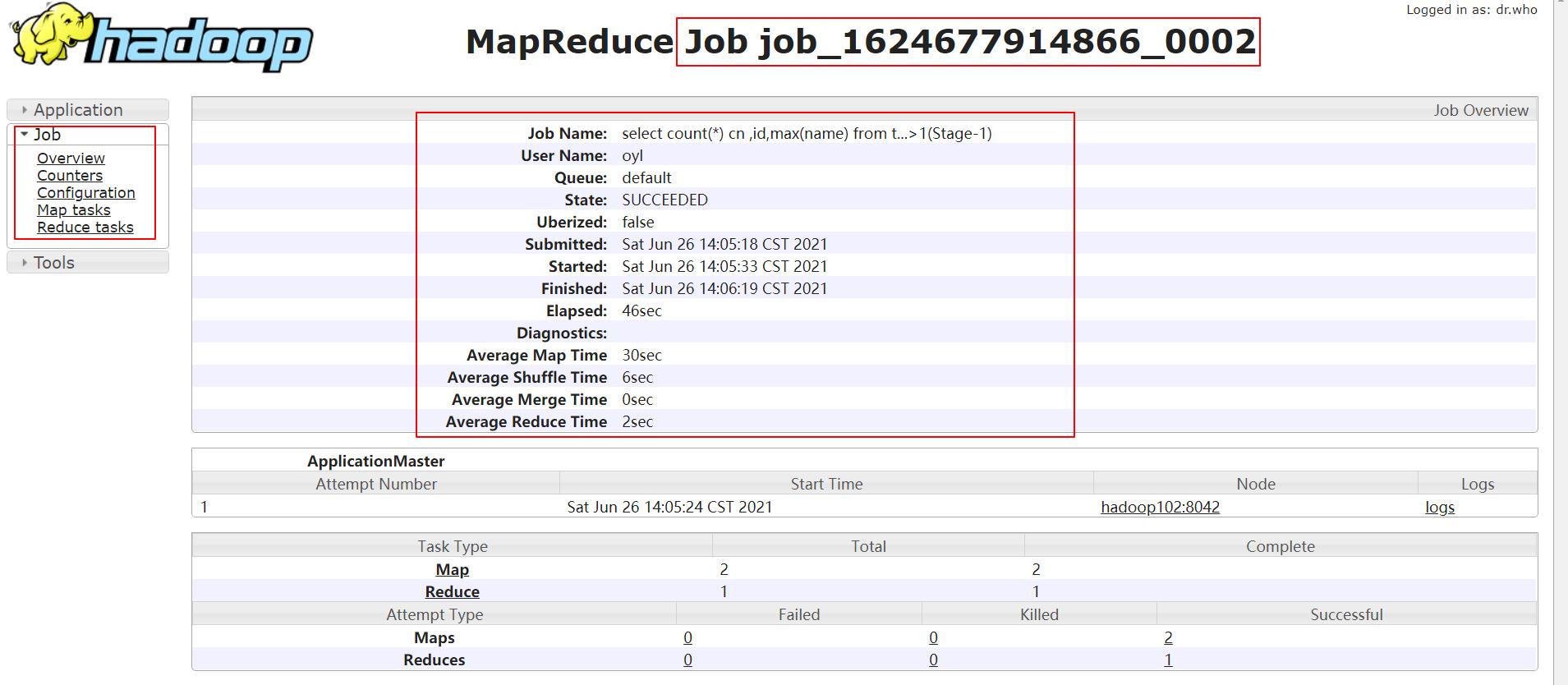

我们看到三个重要的框,左边框Job是当前任务信息的菜单,每一个都是非常重要的对于了解当前任务的运行情况,我们详细讲解。

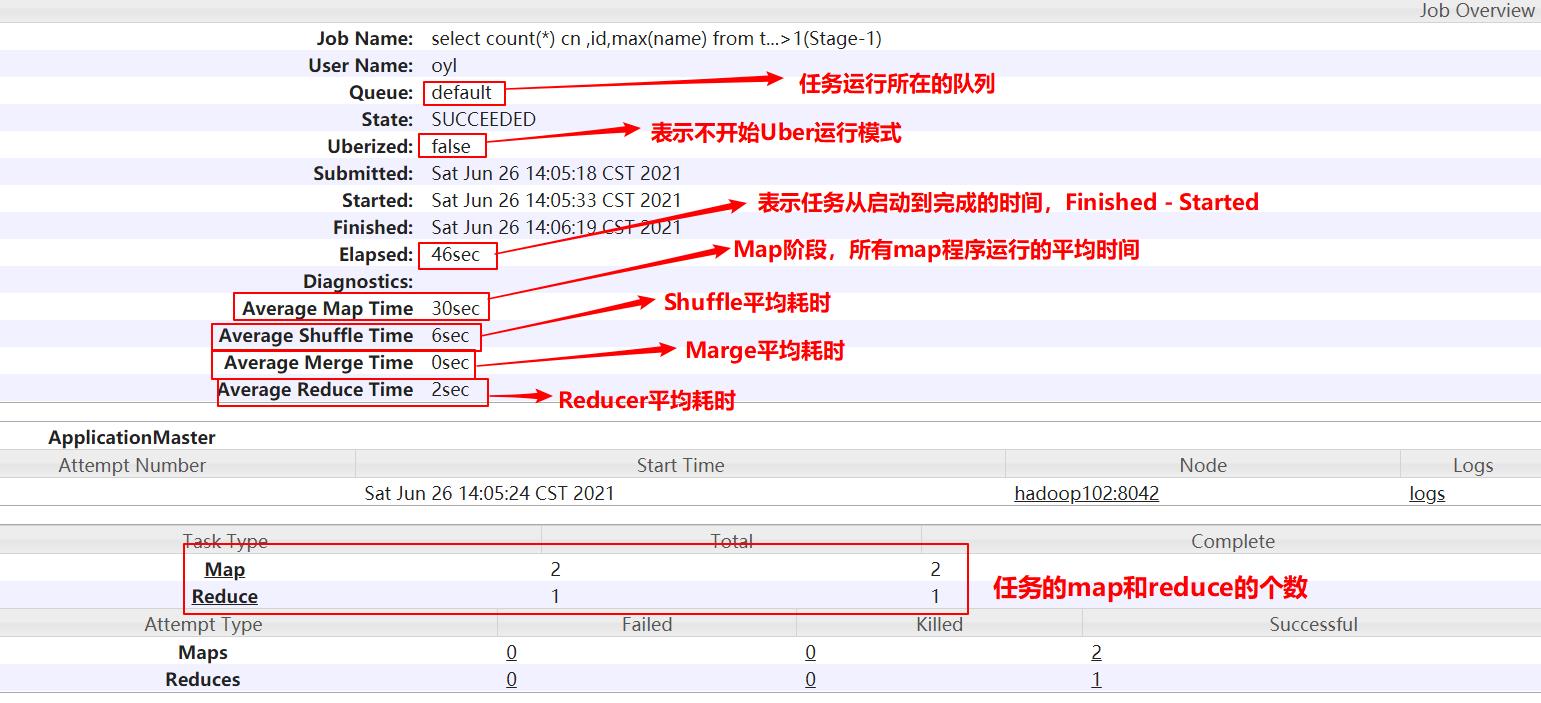

Overview:也就是我们上面看到的这张图,当前任务的概况

Counters:作业计数器,表示hive作业在Input,Map,Shuffle,Reduce,Output等各个阶段的定量数据,我们能够非常直观的看到任务处理的数据量,处理耗时和使用资源,这个非常有利于开发定位问题和后期性能优化

我们点击Counters链接,可以看到任务计数器的页面,分为如下7个部分(因为图太长我们分段讲解):

1、File System Counters:文件系统计数器

注意:

HDFS: Number of read operations:表示一个作业内读取HDFS的次数,读取HDFS操作都是在map阶段,所以读取次数等于所操作表在Hdfs中的文件个数

HDFS: Number of write operations:表示一个作业写入HDFS的次数,写HDFS操作一般只发生在reduce阶段,所以写入次数就等于HDFS 的文件个数

FILE: Number of read operations:表示一个作业内读取本地文件的次数,读取本地文件一般只发生在reduce阶段读取数据操作(如果数据源来自本地那么map阶段会被统计到)

FILE: Number of write operations:表示一个作业写入本地文件次数,写入本地文件发生在shuffle阶段,还有reduce拉取数据阶段。

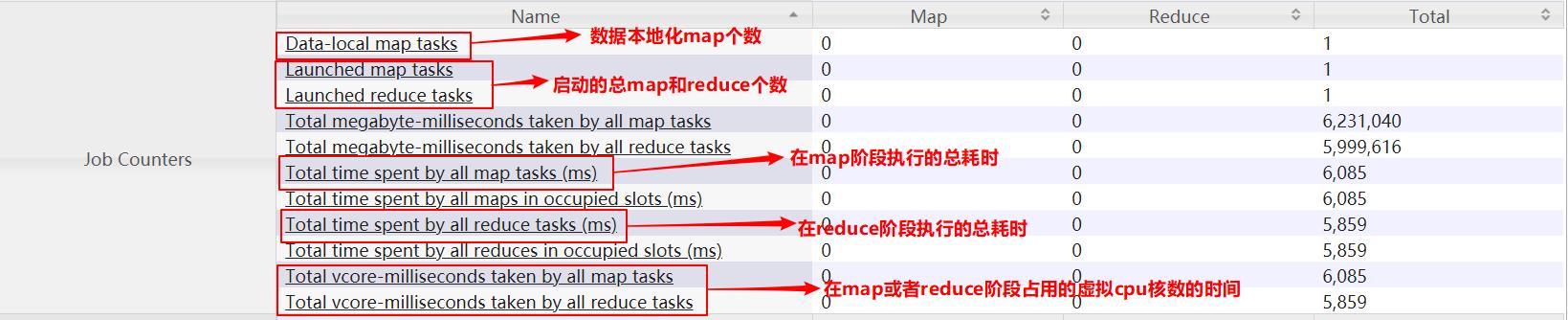

2、Job Counters:作业计数器

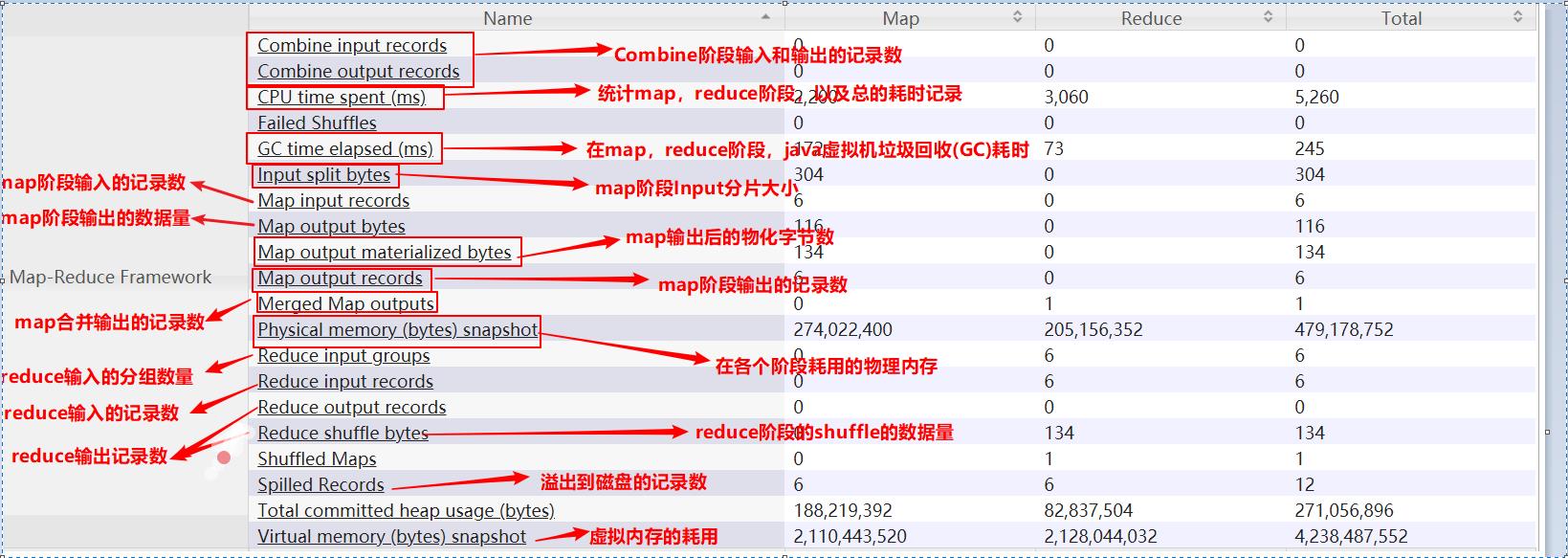

3、Map-Reduce Framework:MapReduce框架计数器

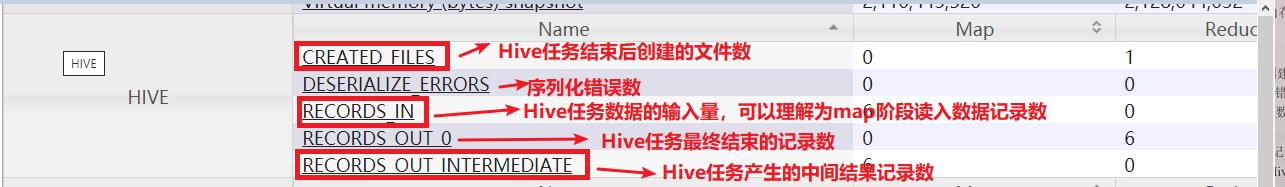

4、HIVE:hive计数器

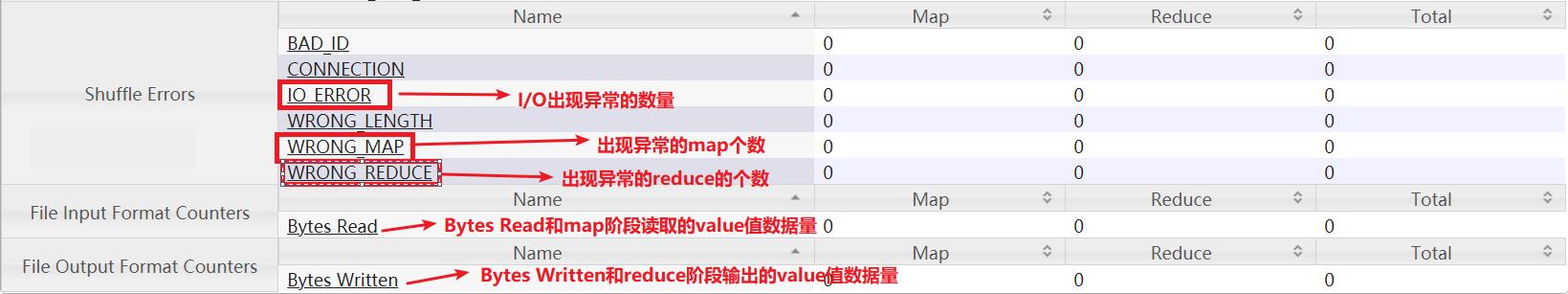

5、Shuffle Errors:shuffle错误计数器

6、File Input Format Counters:文件输入格式的计数器

7、File Output Format Counters:文件输出格式计数器

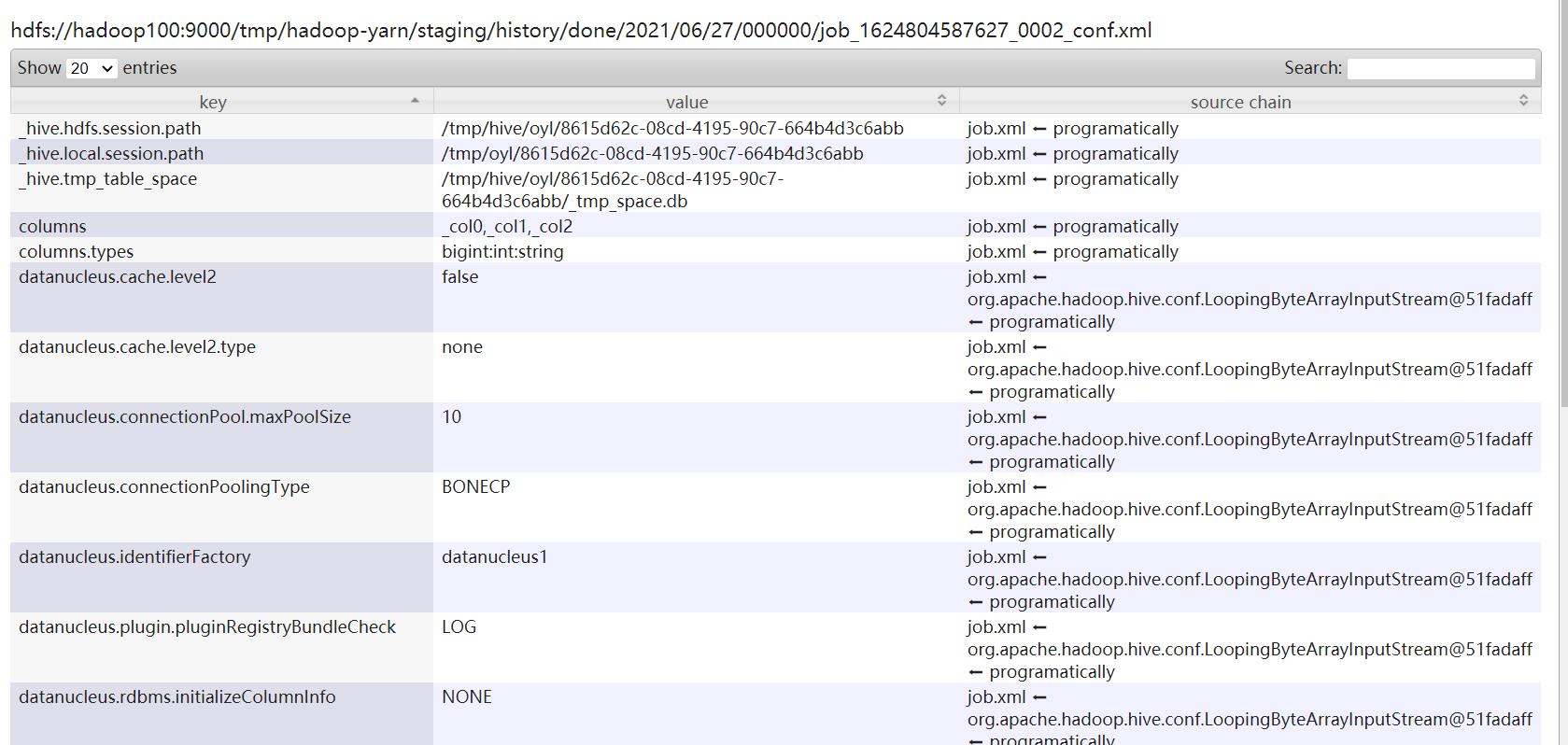

Configuration:就是任务提交的时候的xml配置文件,里面都是一些相关的参数配置

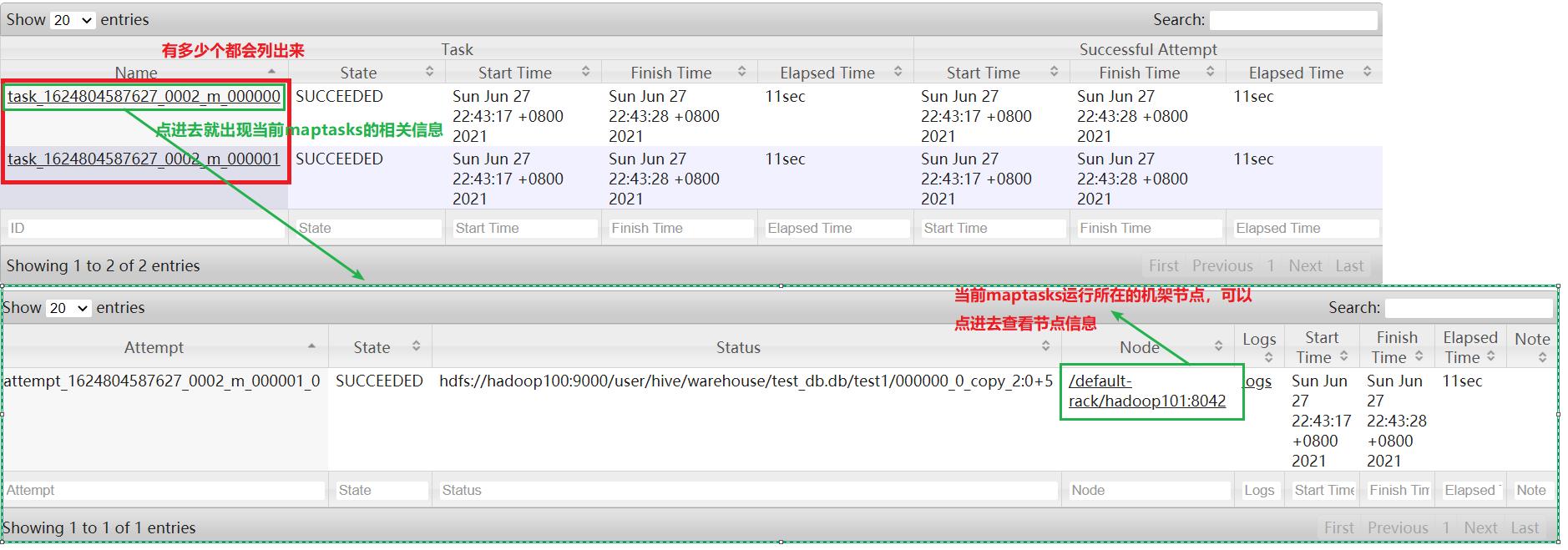

Map tasks:当前任务的map tasks的详细信息

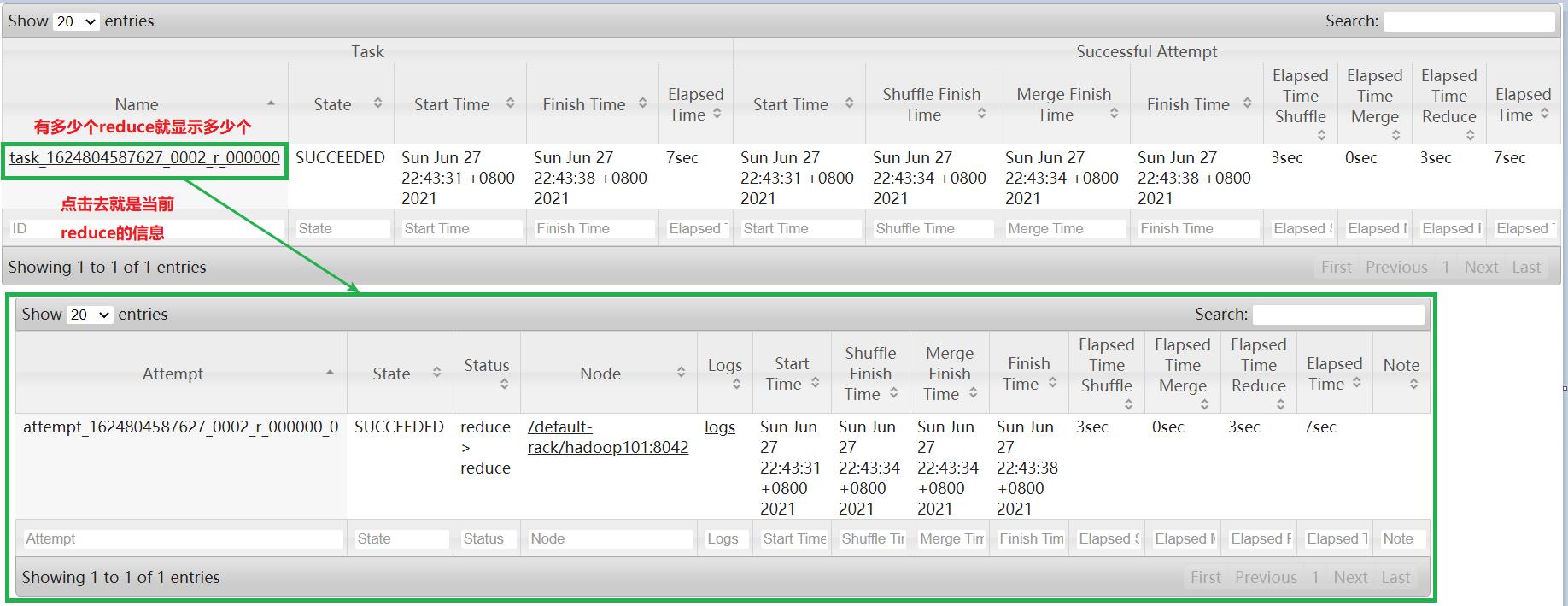

Reduce tasks:当前任务的reduce的详细信息

以上是关于YARN UI界面日志详解二——某个任务详细日志的主要内容,如果未能解决你的问题,请参考以下文章