爬虫-简介

Posted 程序员唐丁

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了爬虫-简介相关的知识,希望对你有一定的参考价值。

一、什么是爬虫

网络爬虫(又称为网页蜘蛛,网络机器人),是一种按照一定的规则,自动地抓取万维网信息的程序或者脚本。简单来说,爬虫就是用来获取万维网上各类数据(图片、视频、文字等等)资源的程序。

二、爬虫可以用来做什么

很多人可能没有听说过爬虫技术,但一定都在生活中使用过爬虫技术的产品,比如大家经常使用的百度搜索、微信小程序搜索等。

三、Python如何实现爬虫

一般的爬虫主要分为三个步骤:获取数据,解析数据,保存或展示数据。其中获取数据一般使用requests库,解析数据使用re(正则)、BeautifulSoup、lxml(Xpath)这三个库中其一,又或组合使用。保存和展示数据就是将爬取的数据整理后保存在csv或者txt等文件中,又或利用matplotlib等绘图库对数据进行可视化展示。

具体的一些爬虫库的使用和实例项目我会在后面的专题给大家介绍。

老规矩,下面我就利用requests加上lxml做一个爬取豆瓣排名前250的电影名的小实例给大家感受一下Python的魅力。

源代码:

#导入第三方库

import requests

from lxml import etree

#构造请求头

headers = {

'user-agent':'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36 (Khtml, like Gecko) Chrome/88.0.4324.150 Safari/537.36'

}

#通过观察发现豆瓣TOP250共10个页面,每个页面展示25个电影数据,据此构造请求的URL

for page in range(0,226,25):

url = 'https://movie.douban.com/top250?start='+str(page)+'&filter='

#发送请求

r = requests.get(url,headers=headers)

#解析数据

tree = etree.HTML(r.text)

#利用XPath匹配找出所有电影的名称,返回list类型

film_name = tree.xpath("//div[@class='info']//span[@class='title'][1]/text()")

#存到txt文件中

with open("豆瓣Top250.txt",'a+') as f:

f.write(f'--------这是第{page}页--------\\n')

for item in film_name:

f.write(item+'\\n')

print("保存成功!")

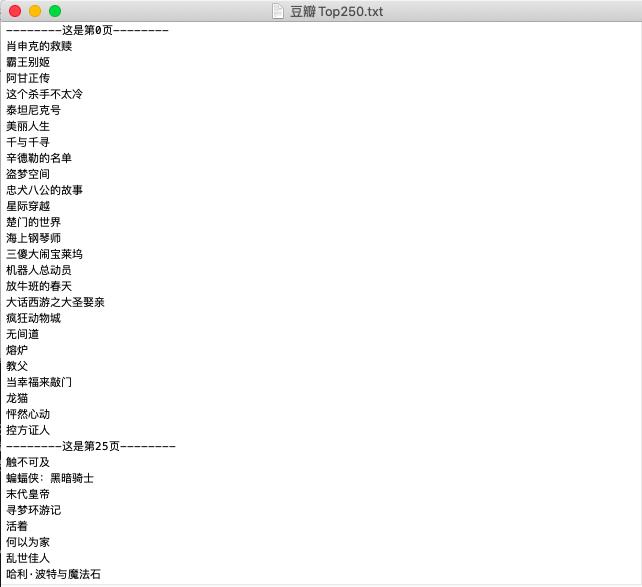

效果图:

以上是关于爬虫-简介的主要内容,如果未能解决你的问题,请参考以下文章