机器学习 --- 线性回归

Posted Alex Hub

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了机器学习 --- 线性回归相关的知识,希望对你有一定的参考价值。

线性回归是属于机器学习里面的监督学习,与分类问题不同的是,在回归问题中,其目标是通过对训练样本的学习,得到从样本特征到样本标签直接的映射,其中,在回归问题中,样本的标签是连续值。线性回归是一类重要的回归问题。在线性回归中,目标值与特征直接存在线性关系。

本实训项目介绍线性回归模型的类别和性能度量等知识,并基于sklearn线性回归面向解决房价预测问题。

第1关:简单线性回归与多元线性回归

任务描述

本关任务:根据本节课所学知识完成本关所设置的选择题。

相关知识

为了完成本关任务,你需要掌握:1.简单线性回归,2.多元线性回归。

您的浏览器不支持 video 标签。

课程视频《简单线性回归》

您的浏览器不支持 video 标签。

课程视频《多元线性回归》

简单线性回归

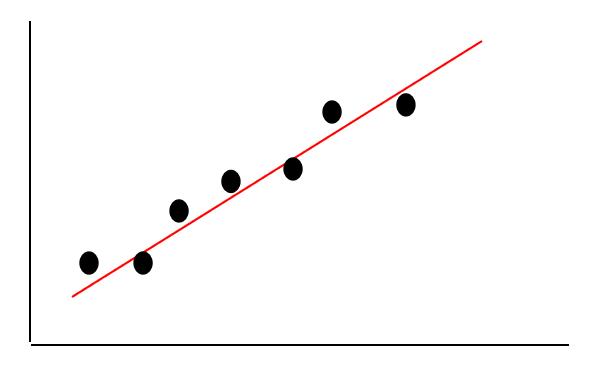

在生活中,我们常常能碰到这么一种情况,一个变量会跟着另一个变量的变化而变化,如圆的周长与半径的关系,当圆的半径确定了,那么周长也就确定了。还有一种情况就是,两个变量之间看似存在某种关系,但又没那么确定,如青少年的身高与体重,他们存在一种近似的线性关系: 身高/cm = 体重/kg +105 但是,并不是每个青少年都符合这个公式,只能说每个青少年的身高体重都存在这么一种近似的线性关系。这就是其实就是简单的线性回归,那么,到底什么是线性回归呢?假如我们将青少年的身高和体重值作为坐标,不同人的身高体重就会在平面上构成不同的坐标点,然后用一条直线,尽可能的去拟合这些点,这就是简单的线性回归。

简单的线性回归模型如下:

y=wx+b

其中x表示特征值(如:体重值),w表示权重,b表示偏置,y表示标签(如:身高值)。

多元线性回归

简单线性回归中,一个变量跟另一个变量的变化而变化,但是生活中,还有很多变量,可能由多个变量的变化决定着它的变化,比如房价,影响它的因素可能有:房屋面积、地理位置等等。如果我们要给它们建立出近似的线性关系,这就是多元线性回归,多元线性回归模型如下:

y=b+w1x1+w2x2+...+wnxn

其中xi表示第i个特征值,wi表示第i个特征对应的权重,b表示偏置,y表示标签。

编程要求

根据相关知识,按照要求完成右侧选择题任务,包含单选题和多选题。

测试说明

平台会对你选择的答案进行判断,全对则通过测试。

开始你的任务吧,祝你成功!

-

1、下面属于多元线性回归的是?(BC)

-

2、若线性回归方程得到多个解,下面哪些方法能够解决此问题?(ABC)

-

3、下列关于线性回归分析中的残差(预测值减去真实值)说法正确的是?(A)

第2关:线性回归的正规方程解

任务描述

本关任务:根据本关卡所学知识,构建线性回归算法,并利用波斯顿房价数据对模型进行训练,然后对未知的房价数据进行预测。

相关知识

为了完成本关任务,你需要掌握:1.线性回归训练流程,2.线性回归的正规方程解。

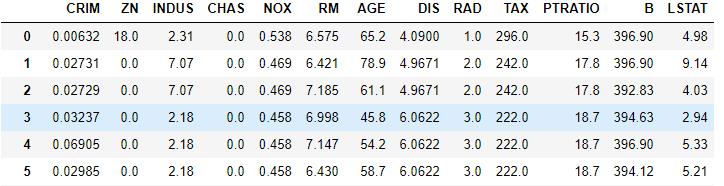

数据集介绍

波斯顿房价数据集共有506条波斯顿房价的数据,每条数据包括对指定房屋的13项数值型特征和目标房价组成。用数据集的80%作为训练集,数据集的20%作为测试集,训练集和测试集中都包括特征和目标房价。

sklearn中已经提供了波斯顿房价数据集的相关接口,想要使用该数据集可以使用如下代码:

from sklearn import datasets#加载波斯顿房价数据集boston = datasets.load_boston()#X表示特征,y表示目标房价X = boston.datay = boston.target

数据集中部分数据与标签如下图所示:

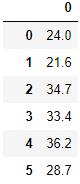

线性回归训练流程

由数据集可以知道,每一个样本有13个特征与目标房价,而我们要做的事就是通过这13个特征来预测房价,我们可以构建一个多元线性回归模型,来对房价进行预测。模型如下:

y=b+w1x1+w2x2+...+wnxn

其中xi表示第i个特征值,wi表示第i个特征对应的权重,b表示偏置,y表示目标房价。

为了方便,我们稍微将模型进行变换:

y=w0x0+w1x1+w2x2+...+wnxn

其中x0等于1。

Y=heta.X

heta=(w0,w1,...,wn)

X=(1,x1,...,xn)

而我们的目的就是找出能够正确预测的多元线性回归模型,即找出正确的参数heta。那么如何寻找呢?通常在监督学习里面都会使用这么一个套路,构造一个损失函数,用来衡量真实值与预测值之间的差异,然后将问题转化为最优化损失函数。既然损失函数是用来衡量真实值与预测值之间的差异那么很多人自然而然的想到了用所有真实值与预测值的差的绝对值来表示损失函数。不过带绝对值的函数不容易求导,所以采用MSE(均方误差)作为损失函数,公式如下:

loss=m1sumi=1m(yi−pi)2

其中p表示预测值,y表示真实值,m为样本总个数,i表示第i个样本。最后,我们再使用正规方程解来求得我们所需要的参数。

线性回归模型训练流程如下:

线性回归的正规方程解

对线性回归模型,假设训练集中m个训练样本,每个训练样本中有n个特征,可以使用矩阵的表示方法,预测函数可以写为:

Y=hetaX

其损失函数可以表示为

(Y−hetaX)T(Y−hetaX)

其中,标签Y为mx1的矩阵,训练特征X为mx(n+1)的矩阵,回归系数heta为(n+1)x1的矩阵,对heta求导,并令其导数等于0,可以得到XT(Y−hetaX)=0。所以,最优解为:

heta=(XTX)−1XTY

这个就是正规方程解,我们可以通过最优方程解直接求得我们所需要的参数。

编程要求

根据提示,在右侧编辑器补充 Python 代码,实现线性回归算法与MSE损失函数计算方法,并利用房价数据对模型进行训练,然后对未知的房价数据进行预测。

测试说明

只需返回预测结果即可,程序内部会检测您的代码,MSE低于30则视为过关。

开始你的任务吧,祝你成功!

#encoding=utf8

import numpy as np

def mse_score(y_predict,y_test):

'''

input:y_predict(ndarray):预测值

y_test(ndarray):真实值

ouput:mse(float):mse损失函数值

'''

#********* Begin *********#

mse = np.mean((y_predict-y_test)/2)

#********* End *********#

return mse

class LinearRegression :

def __init__(self):

'''初始化线性回归模型'''

self.theta = None

def fit_normal(self,train_data,train_label):

'''

input:train_data(ndarray):训练样本

train_label(ndarray):训练标签

'''

#********* Begin *********#

x = np.hstack([np.ones((len(train_data),1)),train_data])

self.theta =np.linalg.inv(x.T.dot(x)).dot(x.T).dot(train_label)

#********* End *********#

return self.theta

def predict(self,test_data):

'''

input:test_data(ndarray):测试样本

'''

#********* Begin *********#

x = np.hstack([np.ones((len(test_data),1)),test_data])

return x.dot(self.theta)

#********* End *********#

第3关:衡量线性回归的性能指标

任务描述

本关任务:根据本关卡所学知识,用Python实现线性回归常用评估指标,并对构造的线性回归模型进行评估。

相关知识

为了完成本关任务,你需要掌握:1.均方误差(MSE),2.均方根误差(RMSE),3.平均绝对误差(MAE),4.R-Squared。

前言

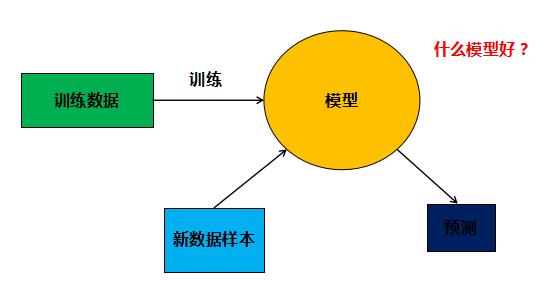

大家知道已经,机器学习通常都是将训练集上的数据对模型进行训练,然后再将测试集上的数据给训练好的模型进行预测,最后根据模型性能的好坏选择模型,对于分类问题,大家很容易想到,可以使用正确率来评估模型的性能,那么回归问题可以使用哪些指标用来评估呢?

MSE

MSE (Mean Squared Error)叫做均方误差,公式如下:

m1sumi=1m(yi−pi)2

其中yi表示第i个样本的真实标签,pi表示模型对第i个样本的预测标签。线性回归的目的就是让损失函数最小。那么模型训练出来了,我们在测试集上用损失函数来评估模型就行了。

RMSE

RMSE(Root Mean Squard Error)均方根误差,公式如下:

sqrtm1sumi=1m(yi−pi)2

RMSE其实就是MSE开个根号。有什么意义呢?其实实质是一样的。只不过用于数据更好的描述。

例如:要做房价预测,每平方是万元,我们预测结果也是万元。那么差值的平方单位应该是千万级别的。那我们不太好描述自己做的模型效果。怎么说呢?我们的模型误差是多少千万?于是干脆就开个根号就好了。我们误差的结果就跟我们数据是一个级别的了,在描述模型的时候就说,我们模型的误差是多少万元。

MAE

MAE(平均绝对误差),公式如下:

m1sumi=1m∣yi−pi∣

MAE虽然不作为损失函数,确是一个非常直观的评估指标,它表示每个样本的预测标签值与真实标签值的L1距离。

R-Squared

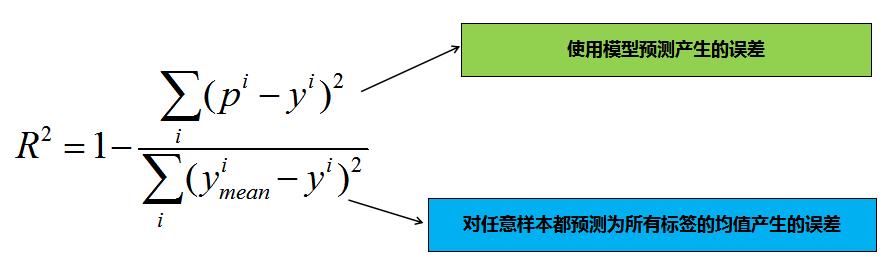

上面的几种衡量标准针对不同的模型会有不同的值。比如说预测房价 那么误差单位就是万元。数子可能是3,4,5之类的。那么预测身高就可能是0.1,0.6之类的。没有什么可读性,到底多少才算好呢?不知道,那要根据模型的应用场景来。 看看分类算法的衡量标准就是正确率,而正确率又在0~1之间,最高百分之百。最低0。如果是负数,则考虑非线性相关。很直观,而且不同模型一样的。那么线性回归有没有这样的衡量标准呢? R-Squared就是这么一个指标,公式如下:

R2=1−sumi(ymeani−yi)2sumi(pi−yi)2

其中ymean表示所有测试样本标签值的均值。为什么这个指标会有刚刚我们提到的性能呢?我们分析下公式:

其实分子表示的是模型预测时产生的误差,分母表示的是对任意样本都预测为所有标签均值时产生的误差,由此可知:

R2leq1,当我们的模型不犯任何错误时,取最大值

1;当我们的模型性能跟基模型性能相同时,取

0;如果为负数,则说明我们训练出来的模型还不如基准模型,此时,很有可能我们的数据不存在任何线性关系。

编程要求

根据提示,在右侧编辑器Begin-End处补充代码,用Python实现R-Squared指标,并用实现的R-Squared指标来评估上一关的线性回归模型。

测试说明

只需返回预测结果即可,程序内部会检测您的代码,R-Squared指标高于0.6视为过关。以上是关于机器学习 --- 线性回归的主要内容,如果未能解决你的问题,请参考以下文章