记录一下Kafka报错:timeout expired while fetching topic metadata

Posted ChinaManor

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了记录一下Kafka报错:timeout expired while fetching topic metadata相关的知识,希望对你有一定的参考价值。

文章目录

引言

大家好,我是ChinaManor,直译过来就是中国码农的意思,我希望自己能成为国家复兴道路的铺路人,大数据领域的耕耘者,平凡但不甘于平庸的人。

步骤如下:

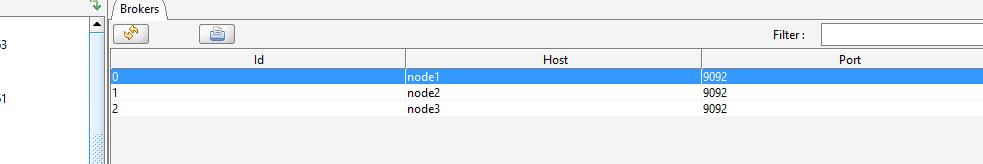

Kafka tool 连接node1:9092集群

- 使用 node1 node2 node3

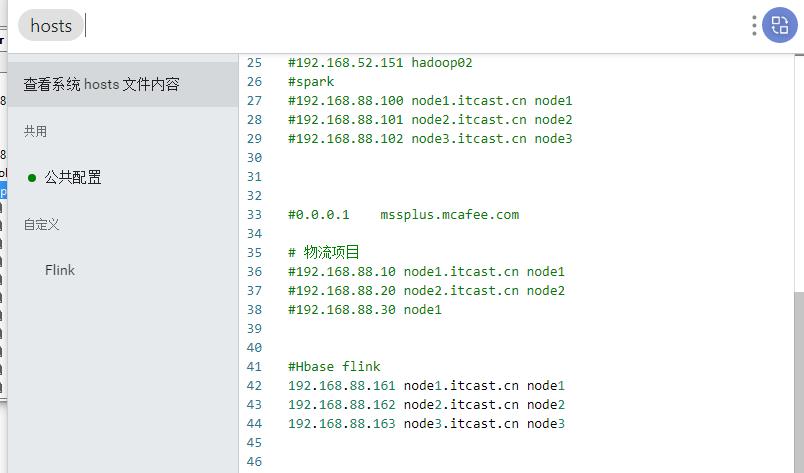

# 在 windows HOSTS文件

192.168.88.161 node1 node1.itcast.cn

192.168.88.162 node2 node2.itcast.cn

192.168.88.163 node3 node3.itcast.cn

- 防火墙 windows 和 Linux ,杀毒软件是否关闭

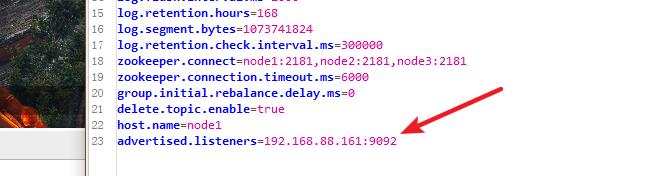

- 在配置文件中

advertised.listeners=192.168.88.161:9092

- 重启 zookeeper 和 kafka

心路历程:

按照讲师的做法配置了一下,

一开始报的不是这个错,是unable to find any brokers,

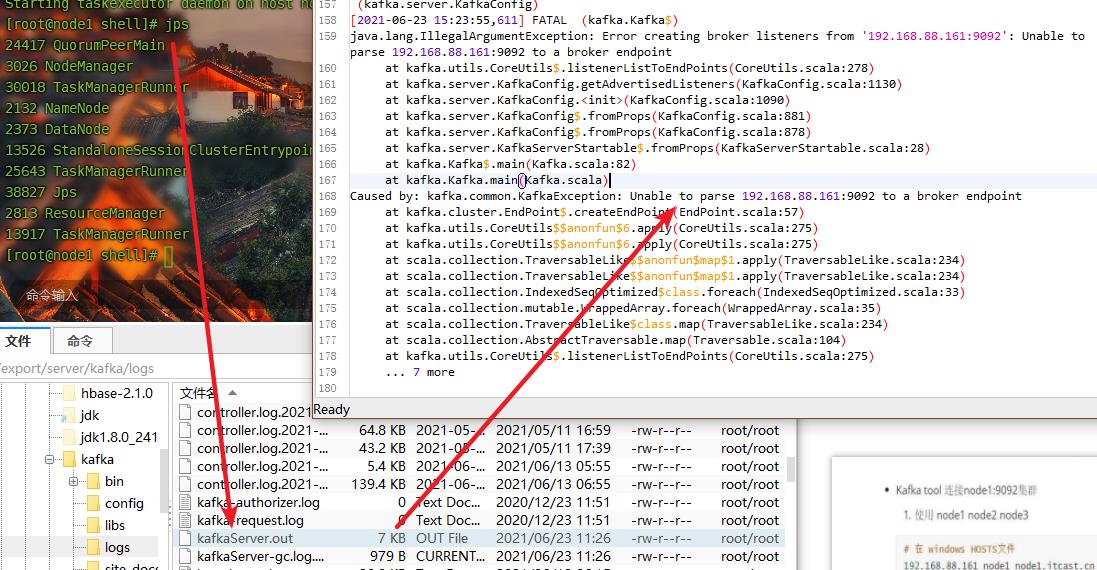

查看Kaka日志,发现根本没起来

把配置里的advertised.listeners=192.168.88.161:9092删除

不报错了

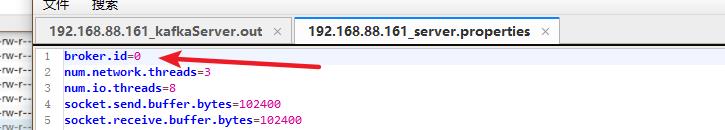

节点只有一个,盲猜是id号没改

然后成功了,雀跃了一把

但还是报timeout expired while fetching topic metadata

由于我用的是utools的工具插件,打开 cmd ping node1 ping不通

重新改变一下顺序,终于成功了

结论是windows hosts的文件没改,连接不上.

以上是关于记录一下Kafka报错:timeout expired while fetching topic metadata的主要内容,如果未能解决你的问题,请参考以下文章

FlinkFlink exactly-once 报错 Timeout expired after 60000 milliseconds while awaiting InitProducerId(代码

FlinkFlink 写入 kafka 报错 Failed to send data to Kafka: Expiring 4 record(s) for 20001 ms has passed(代码

kafkaTimeout of 60000ms expired before the position for partition could be determined

Batch containing 1 record(s) expired due to timeout while requesting metadata from brokers