查看GPU信息,设置指定的GPU,pytorch移动到指定GPU操作

Posted 呆呆象呆呆

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了查看GPU信息,设置指定的GPU,pytorch移动到指定GPU操作相关的知识,希望对你有一定的参考价值。

1、查看设备的使用情况

1.1 gpu

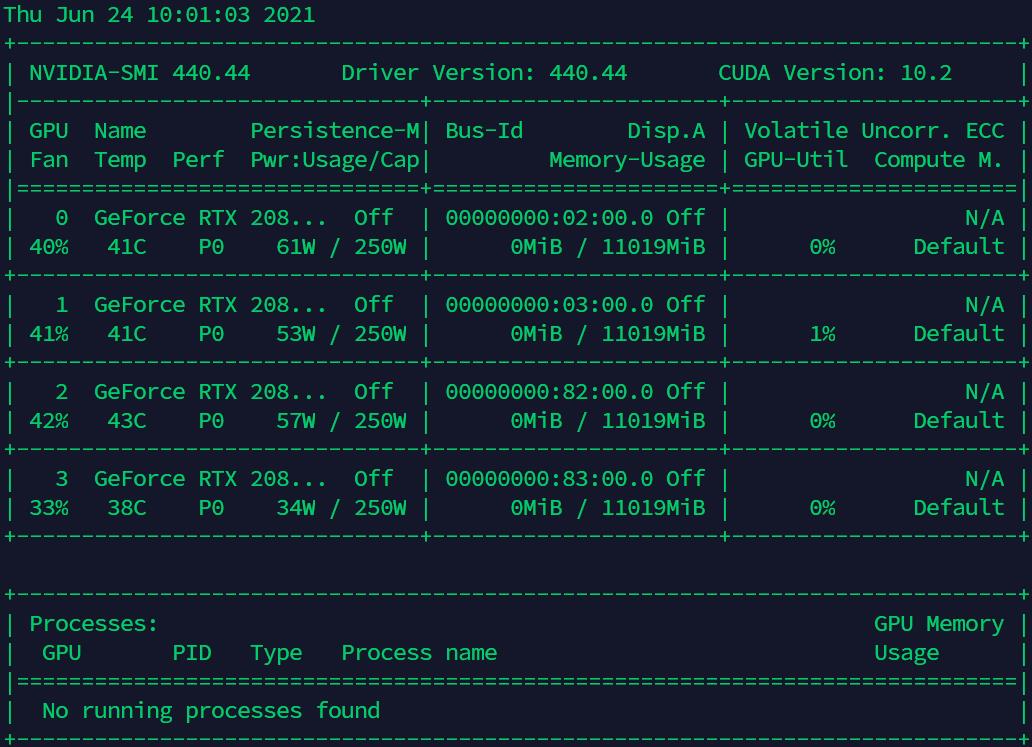

方法一:nvidia-smi

查询当前gpu情况

nvidia-smi

定时更新gpu情况(会在终端不断地刷新)

nvidia-smi -l

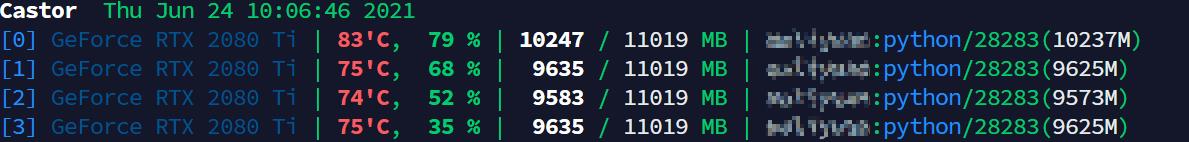

方法二:gpustat

安装

pip install gpustat

查询当前gpu情况(cpu代表的分别是color、process、user)

gpustat -cpu

注意:定时刷新监控

watch -n 1 gpustat -cpu

或者

watch -n 1 nvidia-smi

1.2 npu

查询当前npu情况

npu-smi -info

2、选定设备执行代码

2.1 终端执行程序时指定

CUDA_VISIBLE_DEVICES=1 python XXX.py

这样在跑你的网络之前,告诉程序只能看到1号GPU,其他的GPU它不可见

可用的形式如下:

# Only device 1 will be seen

CUDA_VISIBLE_DEVICES=1 python XXX.py

# Devices 0 and 1 will be visible

CUDA_VISIBLE_DEVICES=0,1 python XXX.py

# Devices 0 and 1 will be visible, quotation marks are optional

CUDA_VISIBLE_DEVICES="0,1" python XXX.py

# Devices 0, 2, 3 will be visible; device 1 is masked

CUDA_VISIBLE_DEVICES=0,2,3 python XXX.py

# No GPU will be visible

CUDA_VISIBLE_DEVICES="" python XXX.py

2.2 在Python代码中指定GPU

import os

os.environ["CUDA_VISIBLE_DEVICES"] = "0"

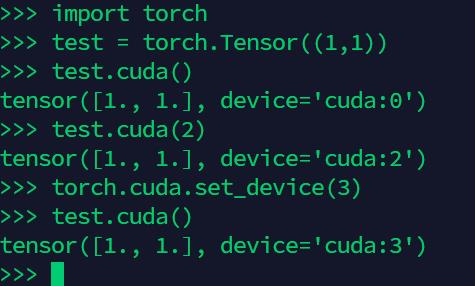

3、pytorch设置使用设备

3.1 使用函数set_device

在生成网络对象之前执行:

import torch

torch.cuda.set_device(id)

在做了这个设置之后,进行.cuda()操作的时候就会默认移动到之前设置的设备

3.2 生成网络的时候指定移动到所选设备

tensor.cuda(id)

LAST、参考文献

以上是关于查看GPU信息,设置指定的GPU,pytorch移动到指定GPU操作的主要内容,如果未能解决你的问题,请参考以下文章