Elasticseach之Linux集群部署

Posted 爱上口袋的天空

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Elasticseach之Linux集群部署相关的知识,希望对你有一定的参考价值。

1、环境准备

安装Elasticsearch 7.8.0

服务器:

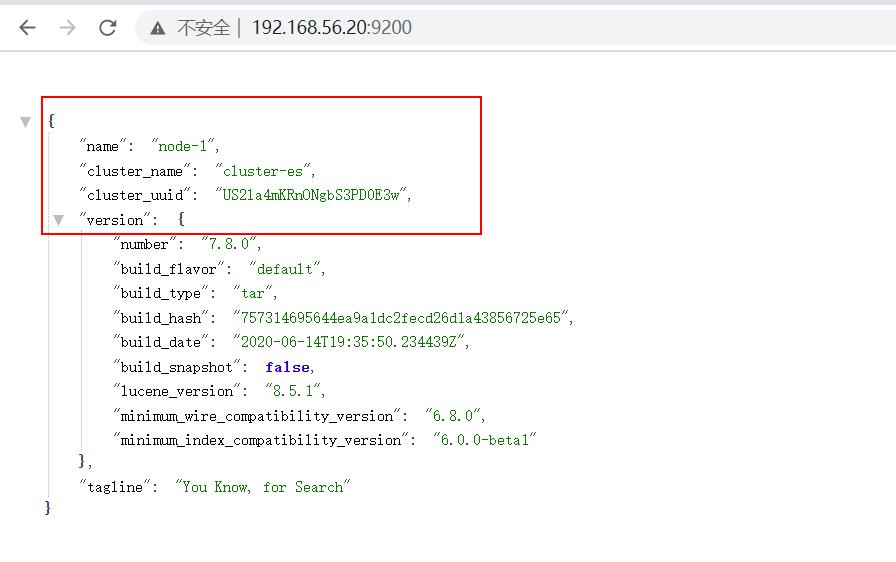

192.168.56.20 -es001(Master)

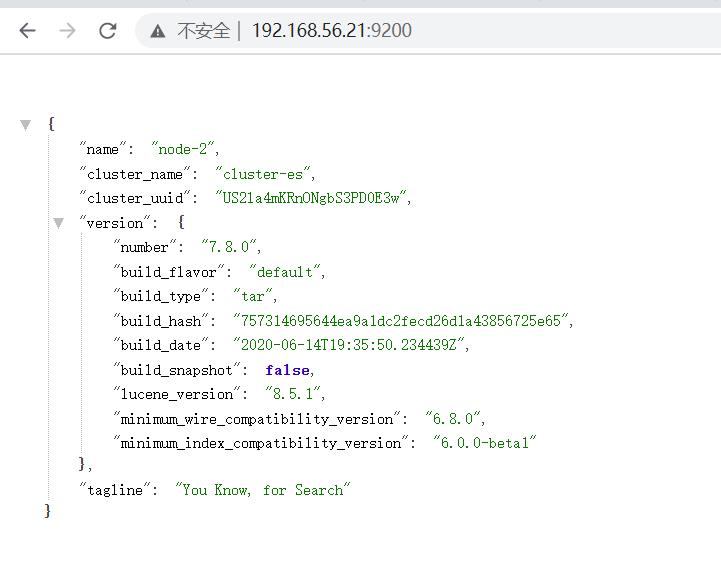

192.168.56.21 -es002

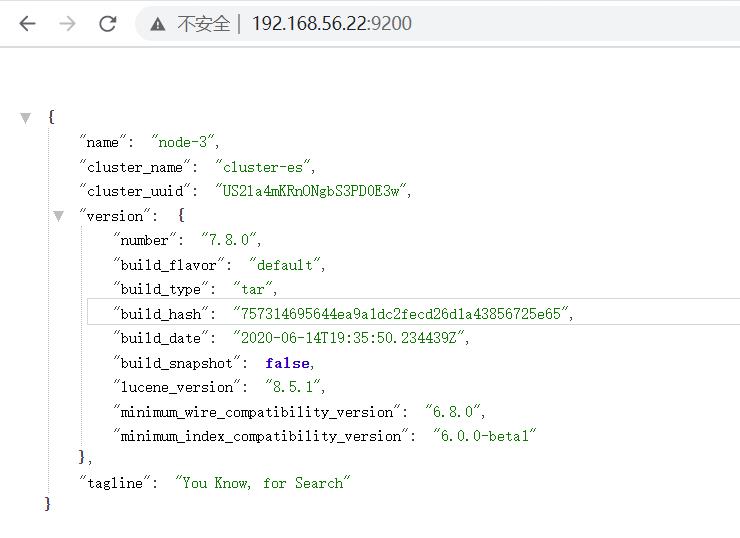

192.168.56.22 -es003

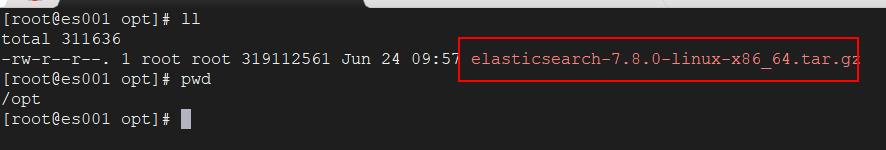

2、将es的安装包上传到Linux服务器

将软件分发到其他节点: es002, es003

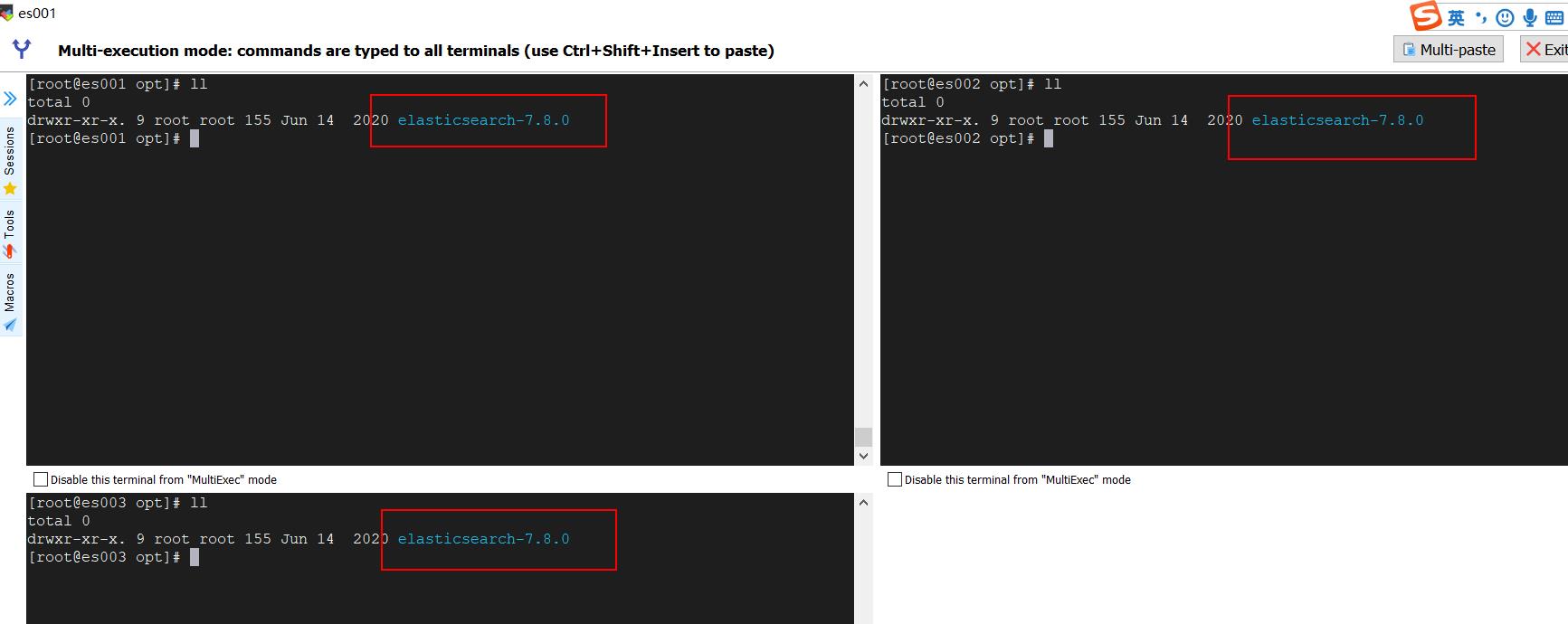

3、解压软件

解压命令: tar -zxvf elasticsearch-7.8.0-linux-x86_64.tar.gz

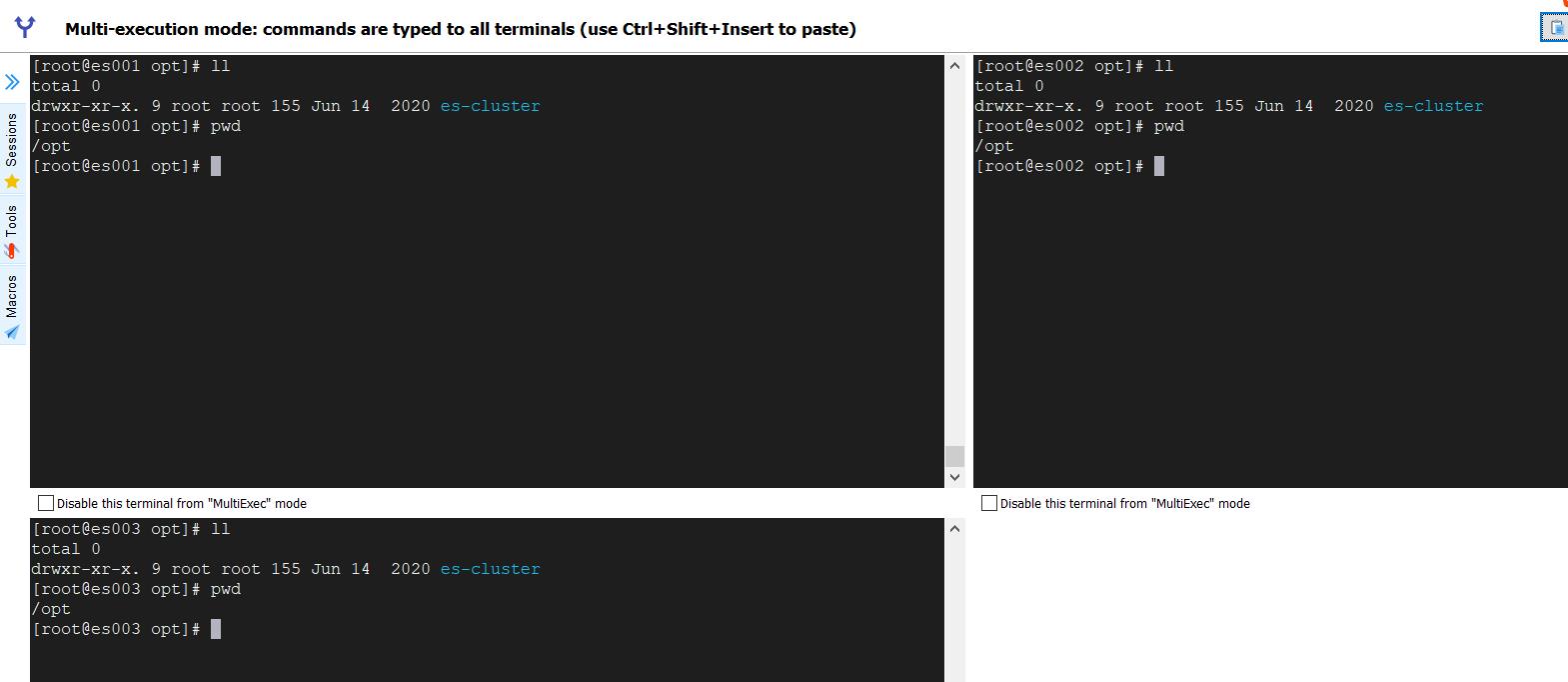

将软件改名:

mv elasticsearch-7.8.0 es-cluster

4、创建用户

因为安全问题, Elasticsearch 不允许 root 用户直接运行,所以要创建新用户,在 root 用户中创建新用户。

useradd es #新增 es 用户

passwd es #为 es 用户设置密码

userdel -r es #如果错了,可以删除再加

chown -R es:es /opt/es-cluster #文件夹所有者

5、修改配置文件

修改es001节点的/opt/es-cluster/config/elasticsearch.yml 文件

# 加入如下配置 #集群名称 cluster.name: cluster-es #节点名称, 每个节点的名称不能重复 node.name: node-1 #ip 地址, 每个节点的地址不能重复 network.host: 192.168.56.20 #是不是有资格主节点 node.master: true node.data: true http.port: 9200 # head 插件需要这打开这两个配置 http.cors.allow-origin: "*" http.cors.enabled: true http.max_content_length: 200mb #es7.x 之后新增的配置,初始化一个新的集群时需要此配置来选举 master cluster.initial_master_nodes: ["node-1"] #es7.x 之后新增的配置,节点发现 discovery.seed_hosts: ["192.168.56.20:9300", "192.168.56.21:9300", "192.168.56.22:300"] gateway.recover_after_nodes: 2 network.tcp.keep_alive: true network.tcp.no_delay: true transport.tcp.compress: true #集群内同时启动的数据任务个数,默认是 2 个 cluster.routing.allocation.cluster_concurrent_rebalance: 16 #添加或删除节点及负载均衡时并发恢复的线程个数,默认 4 个 cluster.routing.allocation.node_concurrent_recoveries: 16 #初始化数据恢复时,并发恢复线程的个数,默认 4 个 cluster.routing.allocation.node_initial_primaries_recoveries: 16修改es002节点的/opt/es-cluster/config/elasticsearch.yml 文件

# 加入如下配置 #集群名称 cluster.name: cluster-es #节点名称, 每个节点的名称不能重复 node.name: node-2 #ip 地址, 每个节点的地址不能重复 network.host: 192.168.56.21 #是不是有资格主节点 node.master: true node.data: true http.port: 9200 # head 插件需要这打开这两个配置 http.cors.allow-origin: "*" http.cors.enabled: true http.max_content_length: 200mb #es7.x 之后新增的配置,初始化一个新的集群时需要此配置来选举 master cluster.initial_master_nodes: ["node-1"] #es7.x 之后新增的配置,节点发现 discovery.seed_hosts: ["192.168.56.20:9300", "192.168.56.21:9300", "192.168.56.22:300"] gateway.recover_after_nodes: 2 network.tcp.keep_alive: true network.tcp.no_delay: true transport.tcp.compress: true #集群内同时启动的数据任务个数,默认是 2 个 cluster.routing.allocation.cluster_concurrent_rebalance: 16 #添加或删除节点及负载均衡时并发恢复的线程个数,默认 4 个 cluster.routing.allocation.node_concurrent_recoveries: 16 #初始化数据恢复时,并发恢复线程的个数,默认 4 个 cluster.routing.allocation.node_initial_primaries_recoveries: 16修改es003节点的/opt/es-cluster/config/elasticsearch.yml 文件

# 加入如下配置 #集群名称 cluster.name: cluster-es #节点名称, 每个节点的名称不能重复 node.name: node-3 #ip 地址, 每个节点的地址不能重复 network.host: 192.168.56.22 #是不是有资格主节点 node.master: true node.data: true http.port: 9200 # head 插件需要这打开这两个配置 http.cors.allow-origin: "*" http.cors.enabled: true http.max_content_length: 200mb #es7.x 之后新增的配置,初始化一个新的集群时需要此配置来选举 master cluster.initial_master_nodes: ["node-1"] #es7.x 之后新增的配置,节点发现 discovery.seed_hosts: ["192.168.56.20:9300", "192.168.56.21:9300", "192.168.56.22:300"] gateway.recover_after_nodes: 2 network.tcp.keep_alive: true network.tcp.no_delay: true transport.tcp.compress: true #集群内同时启动的数据任务个数,默认是 2 个 cluster.routing.allocation.cluster_concurrent_rebalance: 16 #添加或删除节点及负载均衡时并发恢复的线程个数,默认 4 个 cluster.routing.allocation.node_concurrent_recoveries: 16 #初始化数据恢复时,并发恢复线程的个数,默认 4 个 cluster.routing.allocation.node_initial_primaries_recoveries: 16

6、修改/etc/security/limits.conf ,分发文件

# 在文件末尾中增加下面内容 es soft nofile 65536 es hard nofile 65536

7、修改/etc/security/limits.d/20-nproc.conf,分发文件

# 在文件末尾中增加下面内容

es soft nofile 65536

es hard nofile 65536

* hard nproc 4096

\\# 注: * 带表 Linux 所有用户名称

8、修改/etc/sysctl.conf

# 在文件中增加下面内容

vm.max_map_count=655360

9、重新加载

sysctl -p

10、启动软件

分别在不同节点上启动 ES 软件

cd /opt/es-cluster

#启动

bin/elasticsearch

#后台启动

bin/elasticsearch -d

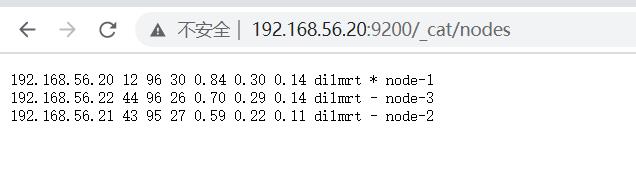

11、测试集群

以上是关于Elasticseach之Linux集群部署的主要内容,如果未能解决你的问题,请参考以下文章