论文泛读135脱离上下文:基于方面情感分析的上下文建模的新线索

Posted 及时行樂_

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了论文泛读135脱离上下文:基于方面情感分析的上下文建模的新线索相关的知识,希望对你有一定的参考价值。

贴一下汇总贴:论文阅读记录

论文链接:《Out of Context: A New Clue for Context Modeling of Aspect-based Sentiment Analysis》

一、摘要

基于方面的情感分析(ABSA)旨在预测评论中对给定方面的情感表达。ABSA的核心是对上下文和给定方面之间的交互进行建模,以提取与方面相关的信息。在以往的研究中,人们普遍采用注意机制和依赖图网络来获取上下文和给定方面之间的关系。并将上下文隐藏状态的加权和作为最终反馈给分类器的表示。然而,与给定方面相关的信息可能已经被丢弃,不良信息可能在现有模型的上下文建模过程中被保留。这是后续模块无法解决的问题,原因有二:一是对编码器生成的上下文隐藏状态进行操作,其值在编码器后无法改变;第二,现有的编码器只考虑上下文而不考虑给定的方面。为了解决这个问题,我们认为应该将给定的方面视为上下文建模过程中脱离上下文的新线索。至于解决方案,我们基于不同的骨干设计了几个方面感知的上下文编码器:一个方面感知的LSTM和三个方面感知的bert。他们致力于生成方面感知的隐藏状态,为ABSA任务量身定制。在这些感知方面的上下文编码器中,使用给定方面的语义来调节信息流。因此,可以保留与方面相关的信息,而在生成的隐藏状态中可以排除与方面无关的信息。我们在几个基准数据集上进行了大量的实验和实证分析,证明了我们提出的方面感知上下文编码器的有效性和优势。

二、结论

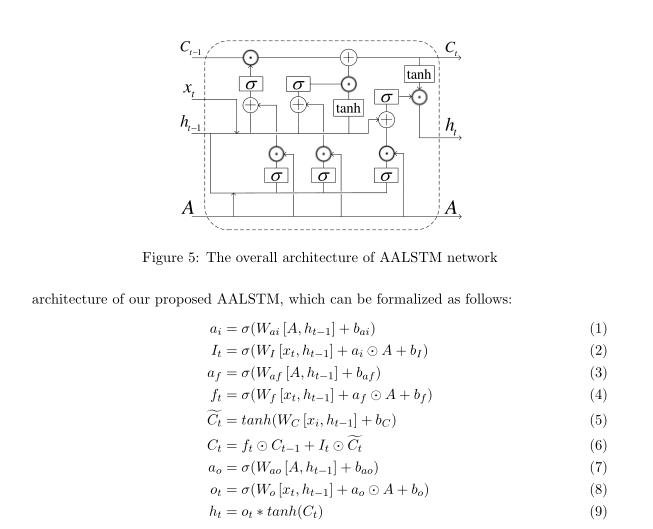

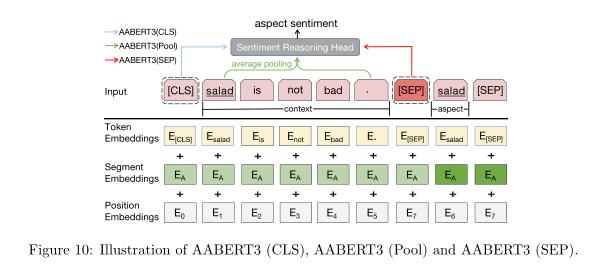

本文发现并定义了在ABSA模型的上下文建模过程中普遍存在的方面不可知问题。然后,我们认为在对上下文建模时,应将给定方面的语义视为脱离上下文的新线索。我们提出了两种方面感知的上下文编码流:一个方面感知的LSTM (AALSTM)和三个方面感知的BERTs (AABERTs)来生成面向ABSA任务的方面感知隐藏状态。具体来说,AALSTM采用了相位感知门机制,将相位的有益扰动动态地添加到三个LSTM门的原始内部值上。这样,给定的方面可以动态地帮助调节LSTM细胞中的信息流沿时间步长。因此,AALSTM可以将给定方面的情感指示信息保留在生成的隐藏状态中,并消除与给定方面有关的无用信息。在BERT的基础上,我们灵活地修改了片段嵌入和[SEP]标记的设置,避免了上下文和连接方面被彻底隔离为两个单独的句子。与BERT相比,我们的aabert可以在上下文建模过程中有效地建模方面感知的内部依赖关系。实验结果表明,AALSTM和aabert在ABSA任务中的表现显著优于香草对照,显示了它们在缓解方面不可知问题方面的能力。

据我们所知,这是第一次关注上下文编码器的缺点,并利用aspect作为ABSA任务中上下文建模的脱离上下文的新线索。在这项工作中,我们从一个新的角度解决ABSA任务,这第一个调查为基于其他架构的上下文编码器的几个方面感知扩展铺平了道路,如卷积神经网络,记忆网络等。在未来,我们很高兴看到在解决方面不可知论问题方面有更多的进展。

三、模型

前一版本中的贡献:

- 发现了ABSA任务中的方面不可知论问题。据我们所知,这是第一次发现这个问题。为了解决这个问题,我们提出了一种新的LSTM变体,称为面向方面的LSTM (AALSTM),将面向方面引入到上下文建模过程中。

- 考虑到aspect是本次任务的核心信息,我们通过将其引入LSTM单元来充分挖掘其潜力。在LSTM单元中,我们设计了三个相位门将相位引入输入门、遗忘门和输出门。AALSTM可以利用方面改进信息流,生成更有效的针对ABSA任务的方面特定上下文隐藏状态。

- 将我们提出的AALSTM应用于几个具有代表性的基于lstm的模型,在基准数据集上的实验结果证明了我们提出的AALSTM的有效性和泛化。

本篇文章的扩展研究:

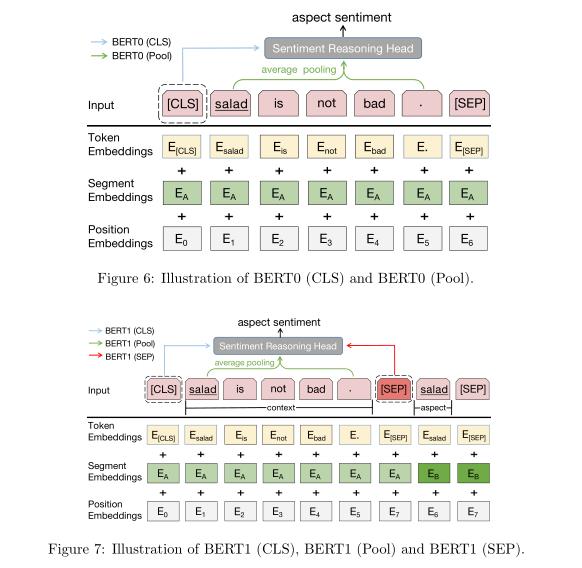

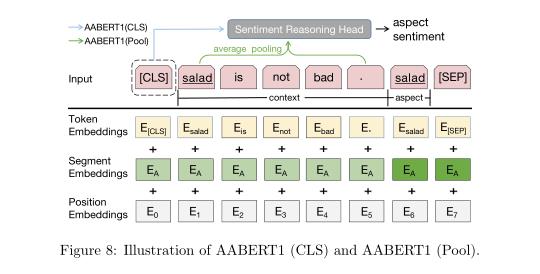

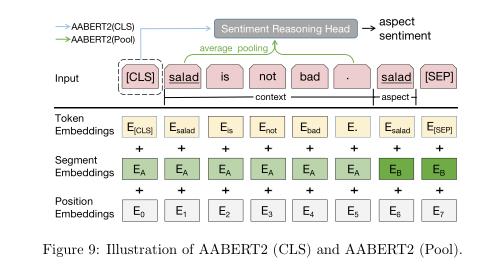

- 发现BERT虽然在ABSA任务中有很好的表现,但它也存在方面不可知论问题。为了解决BERT的问题,我们通过修改BERT的输入格式,提出了三种方面感知BERT (AABERT)变体。

- 进行了广泛的实验来评估ABSA任务中提议的aabert。结果表明,无论是作为单一模型还是作为上下文编码器,AABERTs都能显著地超越普通BERT。

- 进行了一些实验来研究AALSTM和AABERTs在某些特定场景下的特性,并进一步证明了它们的优势。

主要就是两个模型,一个是LSTM的变种AALSTM,一个是BERT的变种AABERT。

AALSTM:

AABERT:

首先看BERT的基本模型

AABERT(1):

AABERT(2):

AABERT(3):

如果是研究情感分析,我觉得本文提出的四个模型,都值得很好的研究。

以上是关于论文泛读135脱离上下文:基于方面情感分析的上下文建模的新线索的主要内容,如果未能解决你的问题,请参考以下文章