ffmpeg的介绍,编译与使用

Posted Chin_style

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了ffmpeg的介绍,编译与使用相关的知识,希望对你有一定的参考价值。

上一篇文章《音视频基础知识》介绍了一些音视频开发相关的概念。这一篇文章进入ffmpeg的分享。具体包括 ffmpeg 介绍 + 基础 + 架构 + 工具库 + 命令行 + 常用参数 + 编译等内容。

ffmpeg

官方项目地址:https://github.com/FFmpeg/FFmpeg

1.1 简介

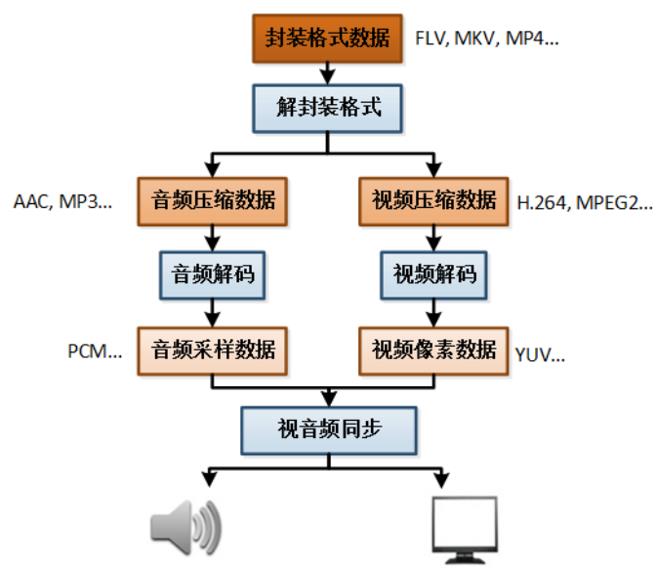

ffmpeg是广泛使用的多媒体解决方案,既是一款音视频编解码工具,同时也是一组音视频编解码开发套件,作为编解码开发套件,它为开发者提供了丰富的音视频处理的调用接口。

其包括了目前领先的音/视频编码库 libavcodec。

ffmpeg提供了多种媒体格式的封装和解封装,包括多种音视频编码,多种协议的流媒体,多种色彩格式转换,多种采样率转换,多种码率转换等。ffmpeg发展至今,已经被许多开源项目使用。

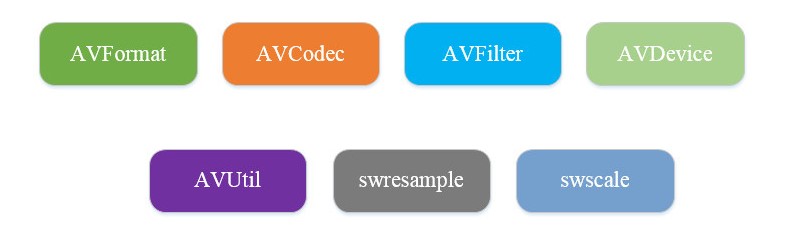

1.2 基本组成

ffmpeg框架的基本组成包含AVFormat,AVCodec,AVFilter,AVDevice,AVUtil等。

1)封装模块 - AVFormat

AVFormat:文件格式和协议库,该模块是最重要的模块之一,封 装了Protocol层和Demuxer、Muxer层,使得协议和格式对于开发者来说 是透明的。

AVFormat中实现了目前多媒体领域中绝大多数媒体封装格式,包括封装和解封装,如MP4,FLV等文件封装格式,RTMP,HLS等网络协议封装格式。ffmpeg是否支持某种封装格式,取决于编译时是否包含了该格式的封装库。

应用于各种音视频封装格式的生成和解析,包括获取解码所需信息以生成解码上下文结构和读取音

视频帧等功能;音视频的格式解析协议,为 libavcodec 分析码流提供独立的音频或视频码流源。

在上一篇文章内重点介绍了封装格式和编码格式的区别。

2)编解码模块 - AVCodec

编解码库,该模块也是最重要的模块之一,封装了 Codec层。

AVCodec中实现了目前多媒体领域绝大多数常用的编解码格式,既支持编码,也支持解码。AVCodec除了支持自带的媒体解码格式之外,还支持第三方的编解码器,如H.264编码,需要使用x264编码器;MP3编码,需要使用libmp3lame编码器。如果希望增加自己的编码格式,或者硬件编解码,则需要在AVCodec中增加相应的编解码模块。(有一些Codec是具备自己的License的,FFmpeg是不会默认添加像libx264、FDK-AAC、lame等库的,但是FFmpeg就像一个平台 一样,可以将其他的第三方的Codec以插件的方式添加进来,然后为开 发者提供统一的接口)

该库是音视频编解码的核心,avcodec 库被其他各大解码器 ffdshow,Mplayer 等所包含或应用。

3)滤镜模块 - AVFilter

AVFilter提供了一个通用的音频,视频,字幕等滤镜处理框架。该模块提供了包括音频特效和视频特效的处理,在使用FFmpeg的API进行编解码的过程中,直接使用该模块为音视频数据做特效处理是非常方便同时也非常高效的一种方式。

4)视频图像转换计算模块 - swscale

swscale模块提供了高级别的图像转换API,例如它允许进行图像缩放和像素格式转换,视频场景比例缩放、色彩映射转换;图像颜色空间或格式转换,如gb565 rgb888 与 yuv420 等之间转换。

5)音频转换计算模块 - swresample

swresample模块提供了高级别的音频重采样API。可以对数字音频进行 声道数、数据格式、采样率等多种基本信息的转换。例如,它允许操作音频采样,音频通道布局转换与布局调整。

6)AVUtil - 核心工具库,该模块是最基础的模块之一,许多其他模块都会依赖该库做一些基本的音视频处理操作。

7)AVDevice - 硬件采集,加速,显示。输入输出设备库,比如,需要编译出播放声音或者视 频的工具ffplay,就需要确保该模块是打开的,同时也需要libSDL的预 先编译,因为该设备模块播放声音与播放视频使用的都是libSDL库。

8)补充一个 AVResample - 音视频封装编解码格式预设等。比较老的FFmpeg版本,那么有可能还会编译出来avresample 模块,该模块其实也是用于对音频原始数据进行重采样,但是现在已经 被废弃掉了,不再推荐使用该库,而是使用swrresample库进行替代。

1.3 命令行工具

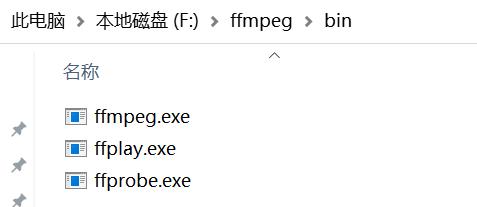

ffmpeg已经编译好了3个常用的工具集- ffmpeg.exe ffprobe.exe ffplay.exe. 通过这3个工具就可以使用命令去操作一个多媒体文件。

下载地址:http://ffmpeg.org/download.html#build-windows

将下载好的exe文件,取路径配置好环境变量,就可以在任意的文件夹内使用ffmpeg的命令行了。

逐一介绍一下三大将:

- ffmpeg.exe:ffmpeg主要用于对音视频进行处理,比如说剪切、抽取视频、抽取音频、增加贴纸水印等等。Hyper fast Audio and Video encoder,音视频编解码工具(类似爱剪辑 格式工厂)。

- ffplay.exe:ffplay主要用于播放视频,几乎支持所有的本地视频播放,还能支持流媒体等网络视频播放,甚至还能播放YUV视频,这点在开发过程中非常好用。Simple media player 简单媒体播放器。

- ffprobe.exe:ffprobe主要用于查看音视频文件格式,比如说你要将一个音视频文件的所有信息以JSON格式输出,ffprobe这个命令行就很便捷。Simple multimedia streams analyzer,简单多媒体流分析器。

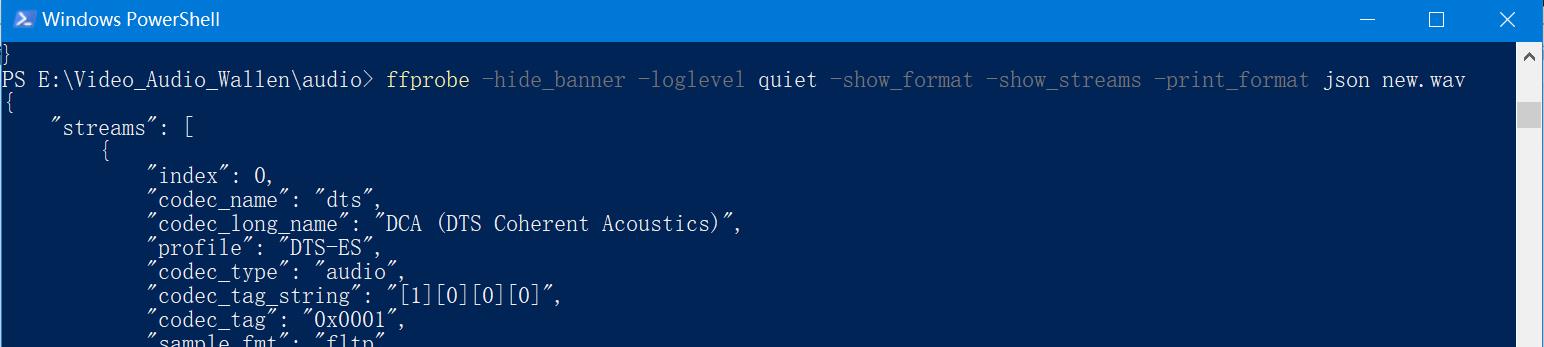

在上一篇文章中,就是使用ffprobe的命令行取获取的媒体文件的封装格式和编码格式,具体命令:

ffprobe -hide_banner -loglevel quiet -show_format -show_streams -print_format json new.wav

1.4 ffmpeg ffprobe ffplay命令行使用示例

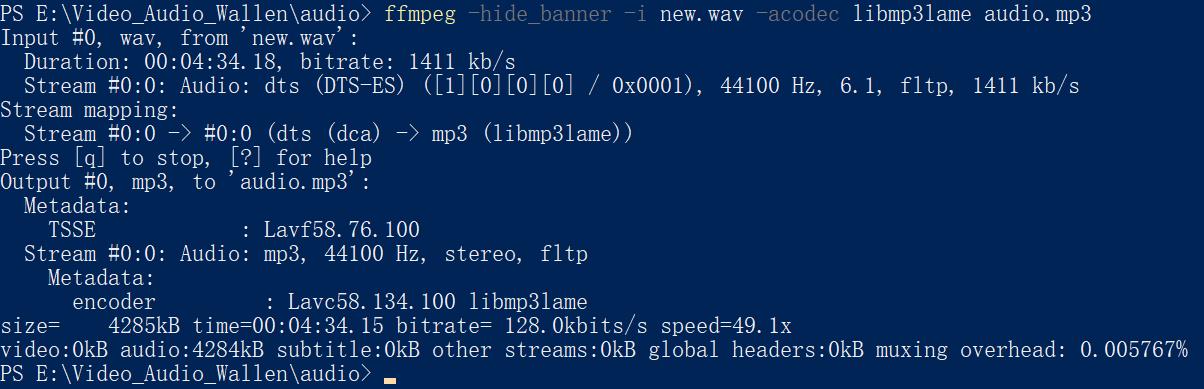

我们使用ffmpeg命令行测试,将一个wav文件转换为mp3文件,命令如下:

ffmpeg -hide_banner -i new.wav -acodec libmp3lame audio.mp3

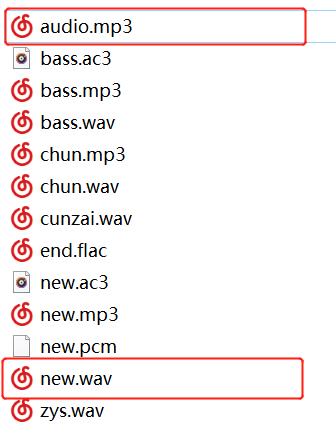

左边就是通过命令生成的audio.mp3。

左边就是通过命令生成的audio.mp3。

这个命令行的组成分为这几个部分:

① ffmpeg - 这是指定使用ffmpeg的命令行;

② -hide_banner - 这是取消了ffmpeg的版权信息显示,这样得到的信息更简洁。

③ -i 代表输入,后面接需要转换的媒体名

④ -acodec,代表使用codev编解码

⑤ libmp3lame,代表mp3的编码器,随后接输出的文件名

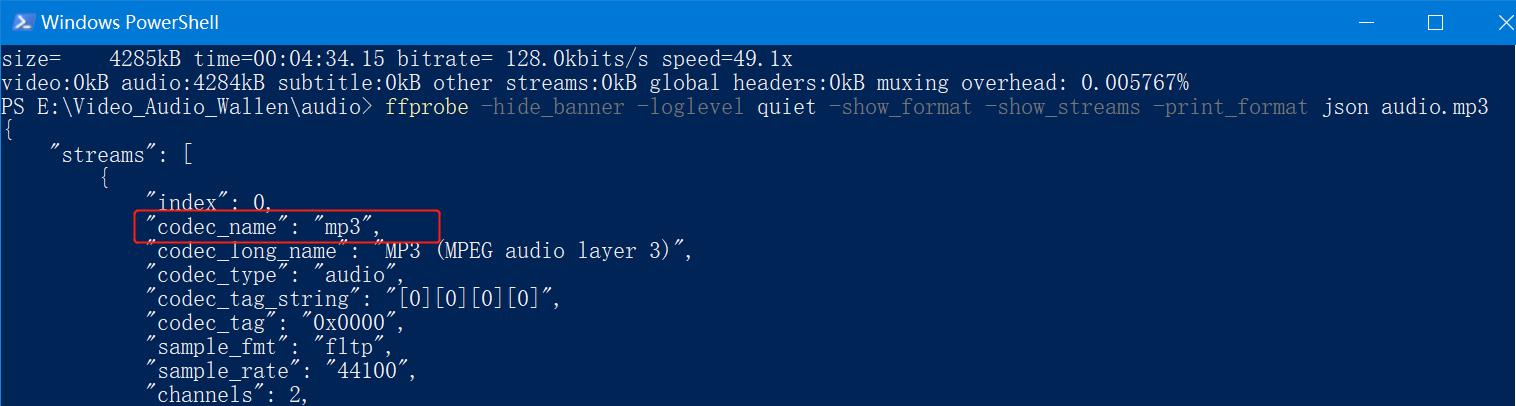

接着我们再使用ffprobe 命令去查看转换MP3媒体文件信息:

ffprobe -hide_banner -loglevel quiet -show_format -show_streams -print_format json audio.mp3

可以看到,编码格式已经由此前dts变为mp3了,说明上一条转换指令已经成功。

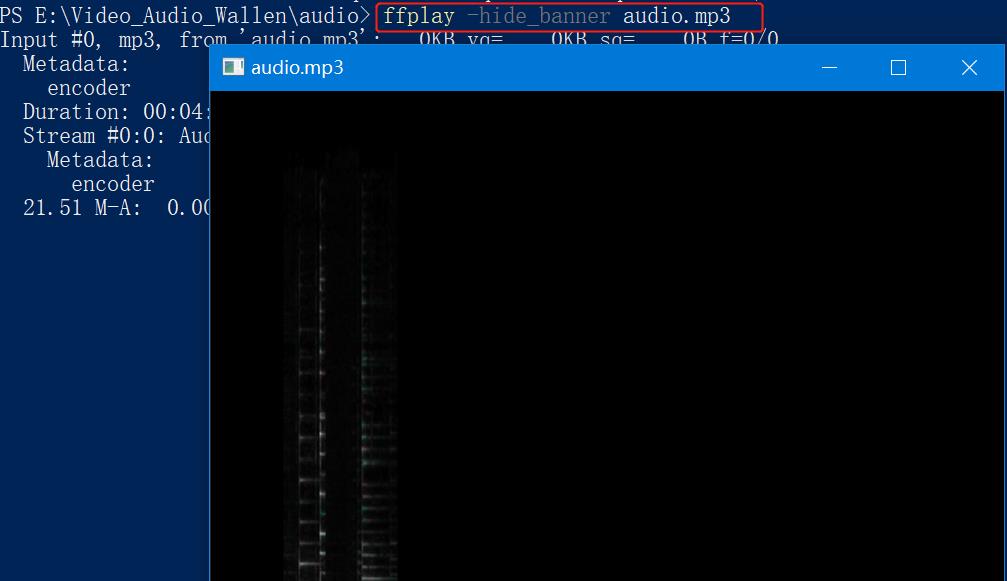

我们可以再使用ffplay命令去播放这首新转的mp3:

ffplay -hide_banner audio.mp3

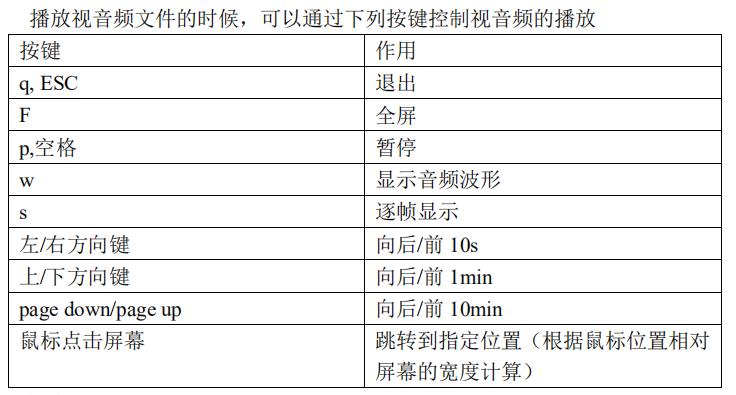

ffplay 是 ffmpeg 工程中提供的播放器,功能相当的强大,凡是 ffmpeg 支持的视音频格式它基本上都支持。甚至连VLC 不支持的一些流媒体都可以播放(比如说 RTMP),但是它的缺点是其不是图形化界面的,必须通过键盘来操作。因此介绍一下它的快捷键以及选项。

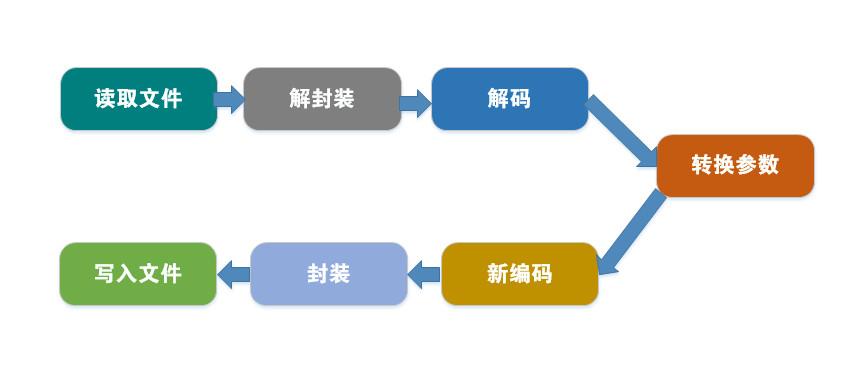

1.5 ffmpeg 格式转码工作流程

我们回到 ffmpeg的转码命令,ffmpeg -hide_banner -i new.wav -acodec libmp3lame audio.mp3

这条命令主要做了以下操作:

- 获得输入源 new.wav

- 转码

- 输出文件 audio.mp3

看似简单的步骤,其实远远不止是从后缀名的变换,因为在ffmpeg中,wav和MP3是2种文件封装格式,并不是后缀名可以决定的。

ffmpeg格式转码流程如下:

- 解封装(Demuxing)

- 解码(Decoding)

- 编码(Encoding)

- 封装(Muxing)

其中需要经过6个步骤,具体如下:

- 读取输入源

- 进行音视频的解封装

- 解码每一帧音视频数据

- 编码每一帧音视频数据

- 进行音视频的重新封装

- 输出到目标

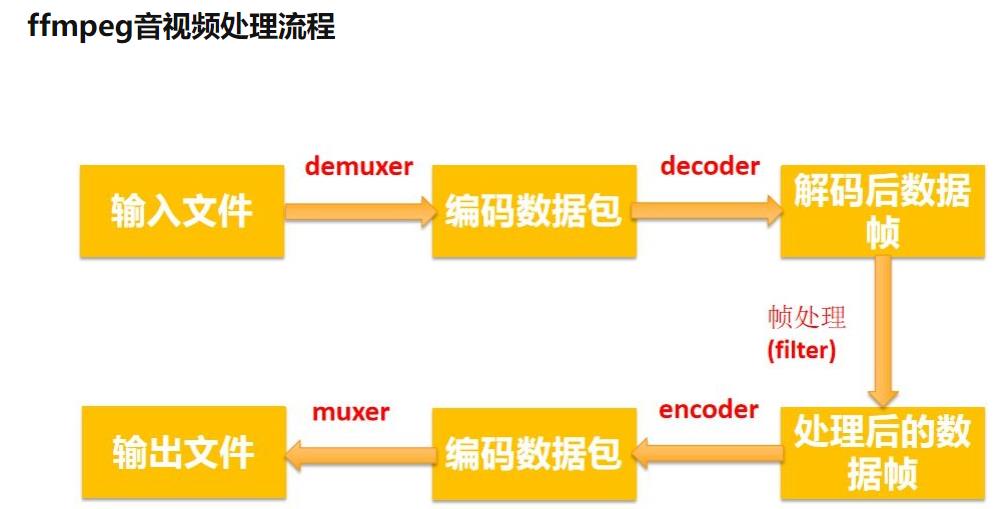

ffmpeg首先读取输入源;

然后通过Demuxer将音视频包进行解封装,这个动作通过调用libavformat中的接口来实现;

接下来通过Decoder进行解码,将音视频通过Decoder解包成为YVU或者PCM这样的数据,Decoder通过libavcodec中的接口来实现;

然后通过Encoder将对应的数据进行编码,编码可以通过libavcodec中的接口来实现;

接下来将编码后的音视频数据包通过Muxer进行封装,Muxer封装通过libavformat中的接口来实现,输出成为输出流。

这里引用雷神的一张著名的图:

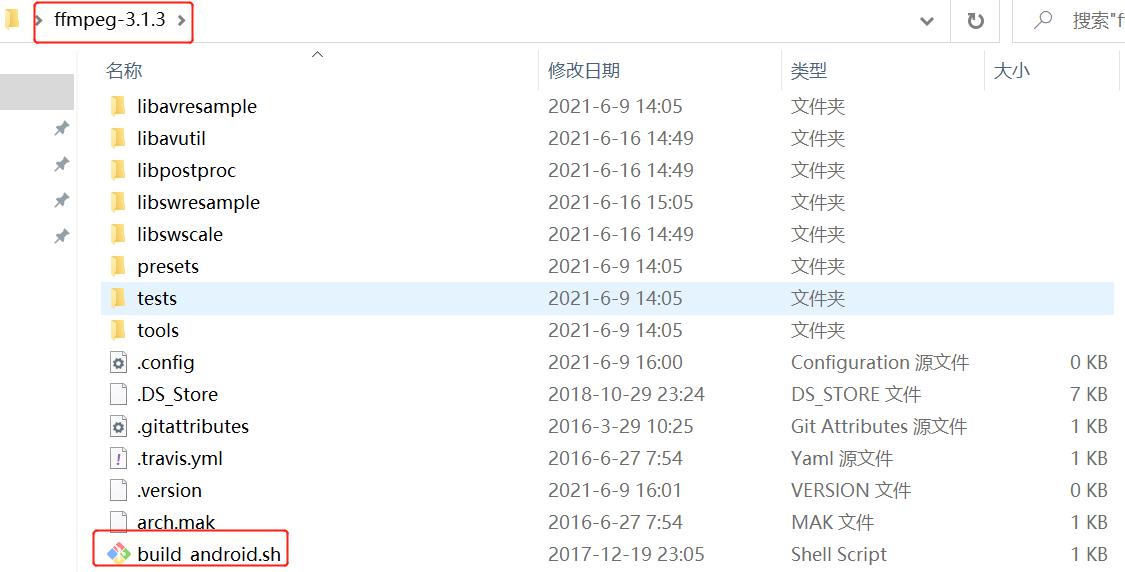

1.6 编译ffmpeg

Windows下编译ffmpeg,提供2个方法,博主都编译成功了。

1)准备工具MSYS2和Yasm

方法来源:《android音视频开发》第7章

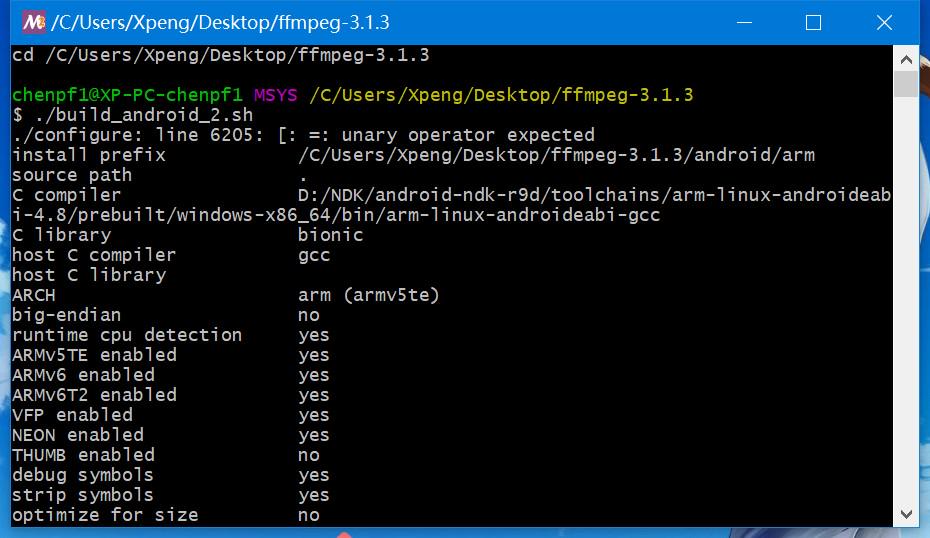

下载上面的软件,下载好ffmpeg源码,编写好shell编译脚本(这个网上很多,博主的附在文章最后)

编译时要使用NDK,所以要提前下载。另外记得修改一下configure文件。这些步骤都是相同的。

进入msys2命令行,执行脚本文件,就能进行编译了。注意Windows下编译时间较长。

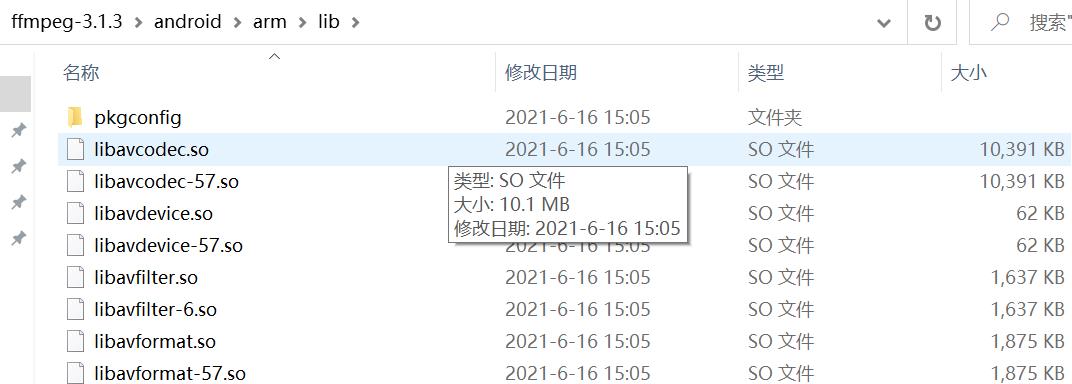

最终会在源码目录下生成一份android文件,里面有编译好的ffmpeg so库。

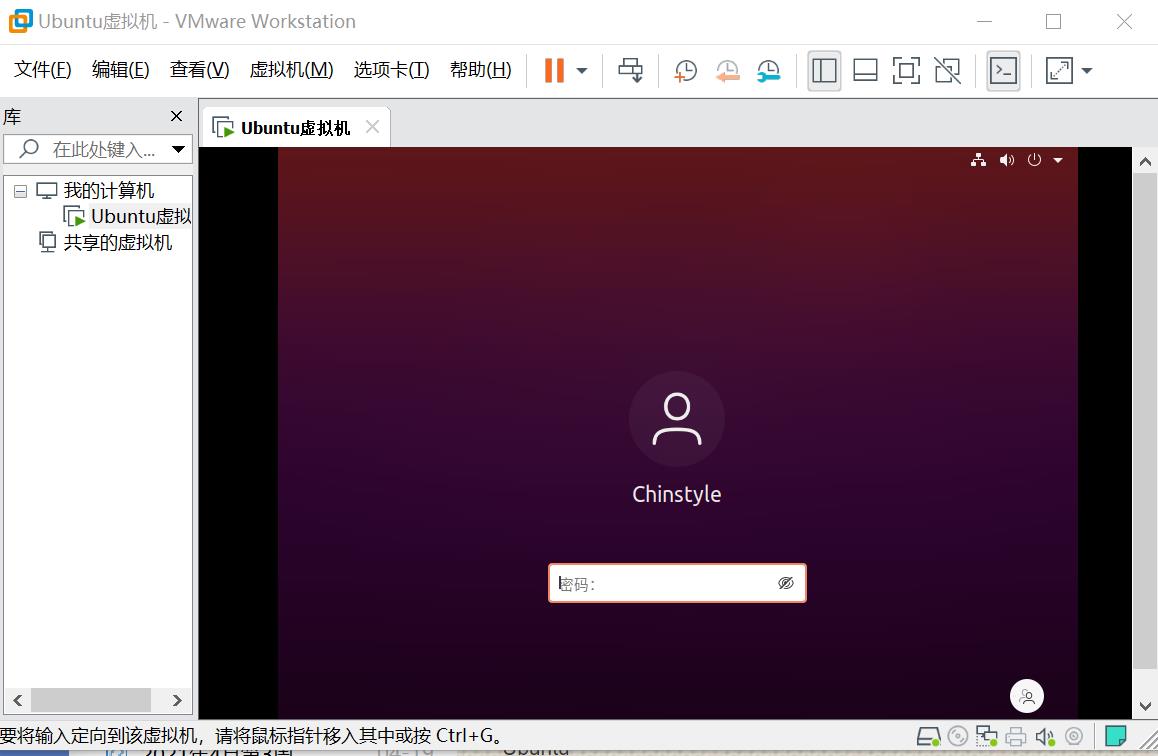

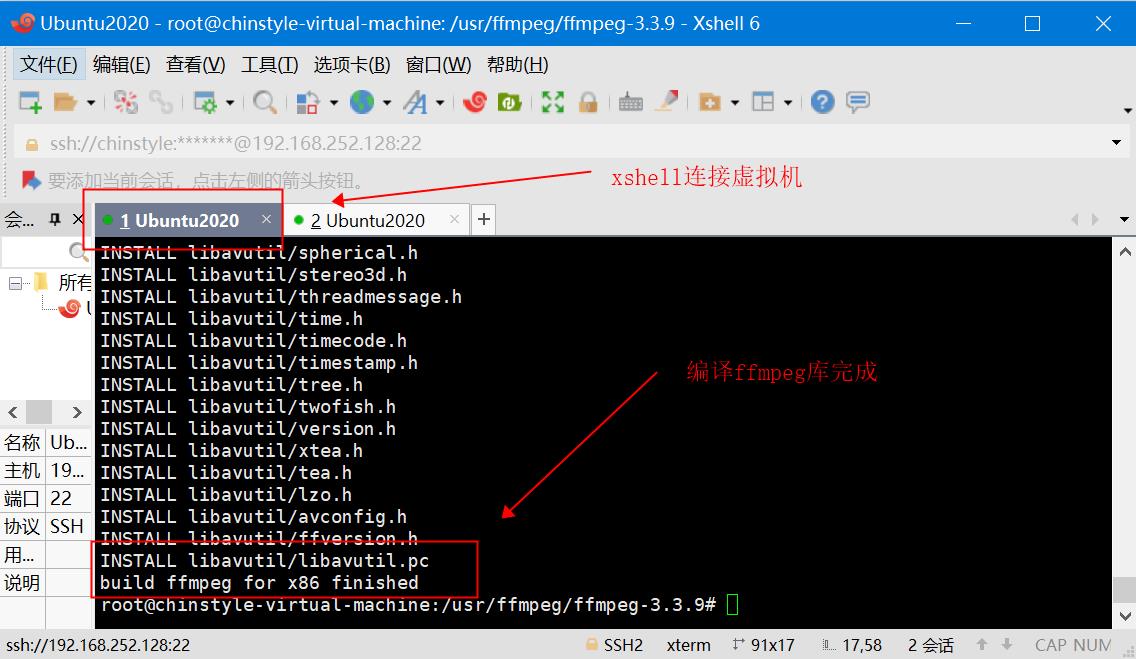

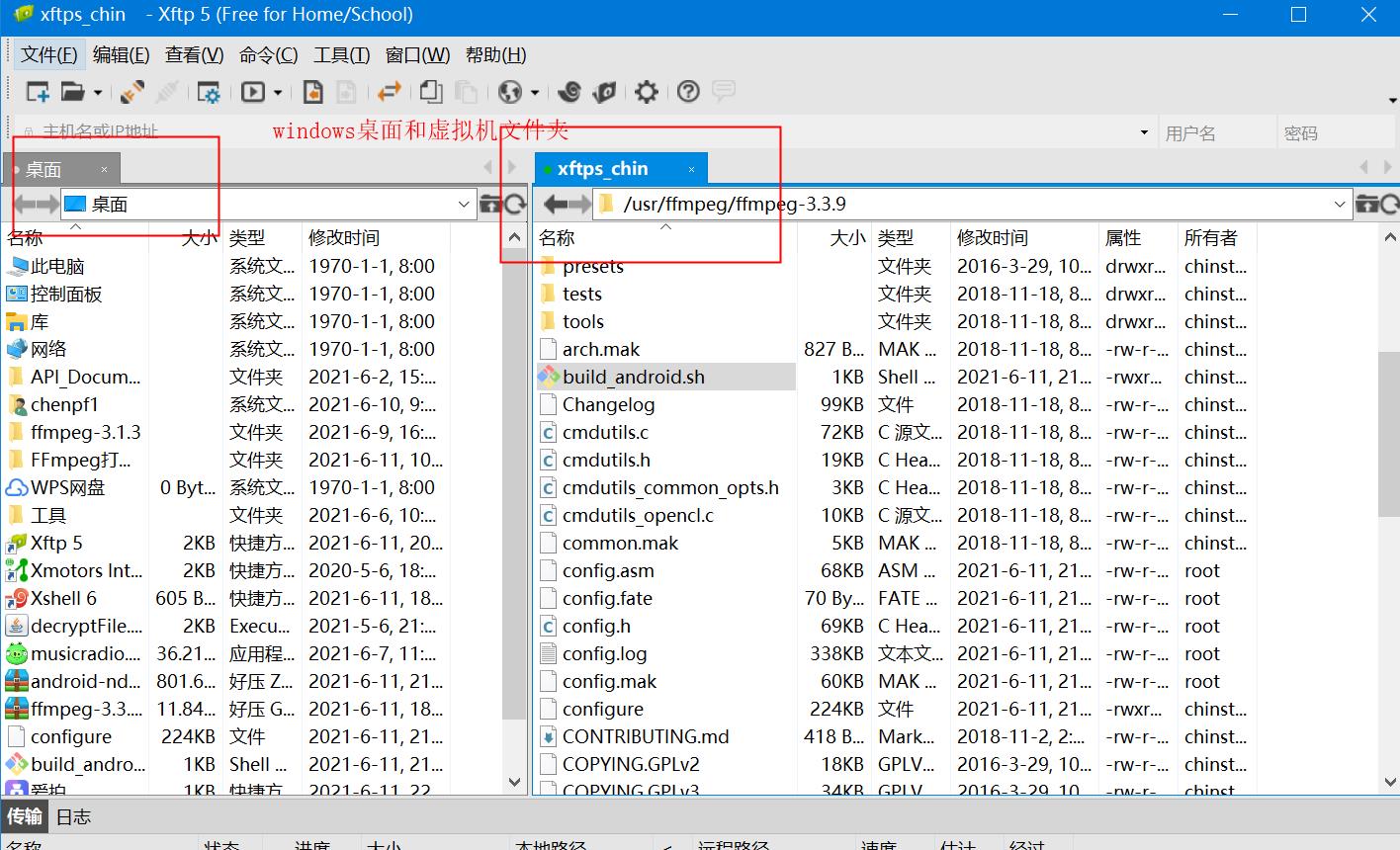

2)准备工具Ubtuntu,xshell,Vmware,xftps,通过虚拟机的方式进行编译

方法来源:《FFmpeg打造Android万能音频播放器》

① 安装Ubuntu,比较麻烦,可以参考这篇文章

小白菜Windows10系统安装Linux(ubuntu)虚拟机超详细教程

② xhell连接Ubuntu

③ xftps连接Ubuntu

然后也是下载NDK,编写shell脚本,再在xshell中执行脚本文件即可。生成的产物so库一样的。

这种构建方式会比在msys2中快一点。

附录 博主使用的shell编译脚本文件,注意换成自己的ndk,并且查验toolchain:

#!/bin/bash

make clean

export NDK=D:/NDK/android-ndk-r9d

export SYSROOT=$NDK/platforms/android-9/arch-arm/

export TOOLCHAIN=$NDK/toolchains/arm-linux-androideabi-4.8/prebuilt/windows-x86_64

export CPU=arm

export PREFIX=$(pwd)/android/$CPU

export ADDI_CFLAGS="-marm"

./configure --target-os=linux \\

--prefix=$PREFIX --arch=arm \\

--disable-doc \\

--enable-shared \\

--disable-static \\

--disable-yasm \\

--disable-symver \\

--enable-gpl \\

--disable-ffmpeg \\

--disable-ffplay \\

--disable-ffprobe \\

--disable-ffserver \\

--disable-doc \\

--disable-symver \\

--cross-prefix=$TOOLCHAIN/bin/arm-linux-androideabi- \\

--enable-cross-compile \\

--sysroot=$SYSROOT \\

--extra-cflags="-Os -fpic $ADDI_CFLAGS" \\

--extra-ldflags="$ADDI_LDFLAGS" \\

$ADDITIONAL_CONFIGURE_FLAG

make clean

make

make install对于Android平台来讲,Shell脚本需要添加如下内容:

ANDROID_NDK_ROOT=/Users/apple/soft/android/android-ndk-r9b

PREBUILT=$ANDROID_NDK_ROOT/toolchains/arm-linux-androideabi-4.8/prebuilt/darwin-x86_64

PLATFORM=$ANDROID_NDK_ROOT/platforms/android-8/arch-arm

./configure

\\ $CONFIGURE_FLAGS \\

--target-os=linux \\

--arch=arm \\

--cross-prefix=$PREBUILT/bin/arm-linux-androideabi- \\

--sysroot=$PLATFORM \\

--extra-cflags="-marm -march=armv7-a -Ifdk_aac/include -Ix264 /include" \\

--extra-ldflags="-marm -march=armv7-a -Lfdk_aac/lib -Lx264 /lib"可以看到,上述脚本中指定了运行的平台与架构,指定了编译器、 链接器的前缀,以用于执行真正的编译与链接操作,然后给出sysroot和 编译、链接参数。这里是以armv7a作为编译目标架构的,如果读者想自 行编译armv8或者x86的平台,可以查看代码仓库中的编译脚本,这里不 再列举。

也可以根据自己的项目需求,进行深度定制,如需开启X264编码,LAME编码,就可以通过修改编译脚本的方式实现,比如:

新增X264编码器需要新增以下脚本:

--enable-muxer=h264 \\

--enable-encoder=libx264 \\

--enable-libx264 \\

--extra-cflags=”-Iexternal-libs/x264/include” \\

--extra-ldflags=”-Lexternal-libs/x264/lib” \\

新增LAME编码器需要新增以下脚本:

--enable-muxer=mp3 \\

--enable-encoder=libmp3lame \\

--enable-libmp3lame \\

--extra-cflags=”-Iexternal-libs/lame/include” \\

--extra-ldflags=”-Lexternal-libs/lame/lib” \\读者可以按照自己的应用场景,把需要编译进来的第三方库以修改脚本文件的方式进行编译,然后以命令行模式或者以API调用的方式进行使用。

有读者对编译脚本这块有疑问的或者想深入了解的可以参考《音视频开发进阶指南》第3章,里面有详细的编译参数介绍。

1.7 ffmpeg 常用命令汇总

《ffmpeg 常用命令汇总》— 中文版

上面这篇汇总已经很全了。之后,博主会整理补充一些自己开发中常用的命令行。

1.8 ffmpeg命令行参数解析

附录 c:ffmpeg 参数中文详细解释

a) 通用选项

-L license

-h 帮助

-fromats 显示可用的格式,编解码的,协议的...

-f fmt 强迫采用格式 fmt

-I filename 输入文件

-y 覆盖输出文件

-t duration 设置纪录时间 hh:mm:ss[.xxx]格式的记录时间也支持

-ss position 搜索到指定的时间 [-]hh:mm:ss[.xxx]的格式也支持

-title string 设置标题

-author string 设置作者

-copyright string 设置版权

-comment string 设置评论

-target type 设置目标文件类型(vcd,svcd,dvd) 所有的格式选项(比特率,编解码以及缓冲区大小)自动设置,只需

要输入如下的就可以了:ffmpeg -i myfile.avi -target vcd /tmp/vcd.mpg

-hq 激活高质量设置

-itsoffset offset 设置以秒为基准的时间偏移,该选项影响所有后面的输入文件。该偏移被加到输入文件的时戳,定

义一个正偏移意味着相应的流被延迟了 offset 秒。 [-]hh:mm:ss[.xxx]的格式也支持

b) 视频选项

-b bitrate 设置比特率,缺省 200kb/s

-r fps 设置帧频 缺省 25

-s size 设置帧大小 格式为 WXH 缺省 160X128.下面的简写也可以直接使用:

Sqcif 128X96 qcif 176X144 cif 252X288 4cif 704X576

-aspect aspect 设置横纵比 4:3 16:9 或 1.3333 1.7777

-croptop size 设置顶部切除带大小 像素单位

-cropbottom size –cropleft size –cropright size

-padtop size 设置顶部补齐的大小 像素单位

-padbottom size –padleft size –padright size –padcolor color 设置补齐条颜色(hex,6 个 16 进制的数,红:绿:兰排列,

比如 000000 代表黑色) -vn 不做视频记录

-bt tolerance 设置视频码率容忍度 kbit/s

-maxrate bitrate 设置最大视频码率容忍度

-minrate bitreate 设置最小视频码率容忍度

-bufsize size 设置码率控制缓冲区大小

-vcodec codec 强制使用 codec 编解码方式。如果用 copy 表示原始编解码数据必须被拷贝。

-sameq 使用同样视频质量作为源(VBR) -pass n 选择处理遍数(1 或者 2)。两遍编码非常有用。第一遍生成统计信息,第二遍生成精确的请求的码率

-passlogfile file 选择两遍的纪录文件名为 file

c)高级视频选项

-g gop_size 设置图像组大小

-intra 仅适用帧内编码

-qscale q 使用固定的视频量化标度(VBR)

-qmin q 最小视频量化标度(VBR)

-qmax q 最大视频量化标度(VBR)

-qdiff q 量化标度间最大偏差 (VBR)

-qblur blur 视频量化标度柔化(VBR)

-qcomp compression 视频量化标度压缩(VBR)

-rc_init_cplx complexity 一遍编码的初始复杂度

-b_qfactor factor 在 p 和 b 帧间的 qp 因子

-i_qfactor factor 在 p 和 i 帧间的 qp 因子

-b_qoffset offset 在 p 和 b 帧间的 qp 偏差

-i_qoffset offset 在 p 和 i 帧间的 qp 偏差

-rc_eq equation 设置码率控制方程 默认 tex^qComp

-rc_override override 特定间隔下的速率控制重载

-me method 设置运动估计的方法 可用方法有 zero phods log x1 epzs(缺省) full

-dct_algo algo 设置 dct 的算法 可用的有 0 FF_DCT_AUTO 缺省的 DCT 1 FF_DCT_FASTINT 2 FF_DCT_INT 3

FF_DCT_MMX 4 FF_DCT_MLIB 5 FF_DCT_ALTIVEC

-idct_algo algo 设置 idct 算法。可用的有 0 FF_IDCT_AUTO 缺省的 IDCT 1 FF_IDCT_INT 2 FF_IDCT_SIMPLE 3

FF_IDCT_SIMPLEMMX 4 FF_IDCT_LIBMPEG2MMX 5 FF_IDCT_PS2 6 FF_IDCT_MLIB 7 FF_IDCT_ARM 8

FF_IDCT_ALTIVEC 9 FF_IDCT_SH4 10 FF_IDCT_SIMPLEARM

-er n 设 置 错 误 残 留 为 n 1 FF_ER_CAREFULL 缺 省 2 FF_ER_COMPLIANT 3 FF_ER_AGGRESSIVE 4

FF_ER_VERY_AGGRESSIVE

-ec bit_mask 设置错误掩蔽为 bit_mask,该值为如下值的位掩码 1 FF_EC_GUESS_MVS (default=enabled) 2

FF_EC_DEBLOCK (default=enabled)

-bf frames 使用 frames B 帧,支持 mpeg1,mpeg2,mpeg4

-mbd mode 宏 块 决 策 0 FF_MB_DECISION_SIMPLE 使 用 mb_cmp 1 FF_MB_DECISION_BITS 2

FF_MB_DECISION_RD

-4mv 使用 4 个运动矢量 仅用于 mpeg4

-part 使用数据划分 仅用于 mpeg4

-bug param 绕过没有被自动监测到编码器的问题

-strict strictness 跟标准的严格性

-aic 使能高级帧内编码 h263+

-umv 使能无限运动矢量 h263+

-deinterlace 不采用交织方法

-interlace 强迫交织法编码仅对 mpeg2 和 mpeg4 有效。当你的输入是交织的并且你想要保持交织以最小图像损失的

时候采用该选项。可选的方法是不交织,但是损失更大

-psnr 计算压缩帧的 psnr

-vstats 输出视频编码统计到 vstats_hhmmss.log

-vhook module 插入视频处理模块 module 包括了模块名和参数,用空格分开

D)音频选项

-ab bitrate 设置音频码率

-ar freq 设置音频采样率

-ac channels 设置通道 缺省为 1 -an 不使能音频纪录

-acodec codec 使用 codec 编解码

E)音频/视频捕获选项

-vd device 设置视频捕获设备。比如/dev/video0

-vc channel 设置视频捕获通道 DV1394 专用

-tvstd standard 设置电视标准 NTSC PAL(SECAM)

-dv1394 设置 DV1394 捕获

-av device 设置音频设备 比如/dev/dsp

F)高级选项

-map file:stream 设置输入流映射

-debug 打印特定调试信息

-benchmark 为基准测试加入时间

-hex 倾倒每一个输入包

-bitexact 仅使用位精确算法 用于编解码测试

-ps size 设置包大小,以 bits 为单位

-re 以本地帧频读数据,主要用于模拟捕获设备

-loop 循环输入流(只工作于图像流,用于 ffserver 测试)

以上是关于ffmpeg的介绍,编译与使用的主要内容,如果未能解决你的问题,请参考以下文章