LVS+Keepalived 搭建高可用群集(DR模式)

Posted 奋斗的蜗牛灬

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了LVS+Keepalived 搭建高可用群集(DR模式)相关的知识,希望对你有一定的参考价值。

前言

https://blog.csdn.net/weixin_51326240/article/details/113148776?spm=1001.2014.3001.5501

- 企业应用中,单台服务器承担应用存在单点故障的危险;

- 负载均衡器 单点故障一旦发生,企业服务将发生中断,造成极大的危害与损失。

通常 LVS 集群 与 keepalived 配合使用 解决这个问题。

一、LVS+Keepalived 高可用群集

1、LVS

- Linux虚拟服务器(Linux Virtual Server)

- LVS 实际上相当于 基于IP地址 的虚拟化应用, 为基于IP地址和内容请求分发的负载均衡提出了一种高效的解决方法。

2、Keepalived

Keepalived 是专为LVS和HA设计的一款健康检查工具

- 支持故障自动切换(Failover)

- 支持节点健康状态检查(Health Checking)

- 判断LVS负载调度器、节点服务器的可用性,当 master 主机出现故障及时切换到 backup 节点保证业务正常,当 master 故障主机恢复后将其重新加入群集并且业务重新切换回 master 节点。

工作原理:

-

Keepalived 是一个基于VRRP协议来实现的LVS服务高可用方案,可以解决静态路由出现的单点故障问题。

-

在一个LVS服务集群中通常有主服务器(MASTER)和备份服务器(BACKUP)两种角色的服务器,但是对外表现为一个虚拟IP,主服务器会发送VRRP通告(心跳通告)信息给备份服务器,当备份服务器收不到VRRP消息的时候,即主服务器异常的时候,备份服务器就会接管虚拟IP,继续提供服务,从而保证了高可用性。

Keepalived的作用是检测服务器的状态,如果有一台web服务器宕机,或工作出现故障,Keepalived将检测到,并将有故障的服务器从系统中剔除,同时使用其他服务器代替该服务器的工作,当服务器工作正常后Keepalived自动将服务器加入到服务器群中,这些工作全部自动完成,不需要人工干涉,需要人工做的只是修复故障的服务器。

3、Keepalived实现原理剖析

- keepalived 采用 VRRP 热备份协议 实现 Linux 服务器的多机热备功能;

- VRRP(虚拟路由冗余协议)是针对路由器的一种备份解决方案。

- 由多台路由器组成一个热备份组,通过共用的虚拟IP地址对外提供服务;

- 每个热备组内同时只有一台主路由器提供服务,其他路由器处于冗余状态;

- 若当前在线的路由器失效,则其他路由器会根据设置的优先级自动接替虚拟IP地址,继续提供服务。

问:

Keepalived 通过什么判断哪台主机为主服务器,通过什么方式配置浮动IP?

答案:

- Keepalived 首先做初始化先检查 state 状态,master 为主服务器,backup 为备服务器。

- 然后再对比所有服务器的 priority,谁的优先级高谁是最终的主服务器。

- 优先级高的服务器会通过ip命令为自己的电脑配置一个提前定义好的浮动IP地址。

二、keepalived 配置实例

双机热备的故障切换是由虚拟IP地址的漂移来实现,适用于各种应用服务器。

环境准备:

本次配置是在 上篇博客 DR 实现负载均衡的基础上做的。所以重点是如何配置 keepalived

| 主机 | 操作系统 | IP地址 | 所需软件服务 |

|---|---|---|---|

| 主DR 负载调度器 | CentOS7 | ens33:192.168.10.30 ens33:0 (VIP):192.168.10.100 | ipvsadm |

| 备DR 负载调度器 | CentOS7 | ens33:192.168.10.31 ens33:0 (VIP):192.168.10.100 | ipvsadm |

| NFS 服务器 | CentOS7 | 192.168.10.101 | rpcbind、nfs-utils |

| Web节点服务器1 | CentOS7 | ens33:192.168.10.10 lo:0 (VIP):192.168.10.100 | rpcbind、nfs-utils、httpd |

| Web节点服务器2 | CentOS7 | ens33:192.168.10.20 lo:0 (VIP):192.168.10.100 | rpcbind、nfs-utils、httpd |

| 客户端 | Windows10 | 192.168.10.200 |

2.1 配置负载调度器(主、备相同)

下面是两个调度器一样的配置

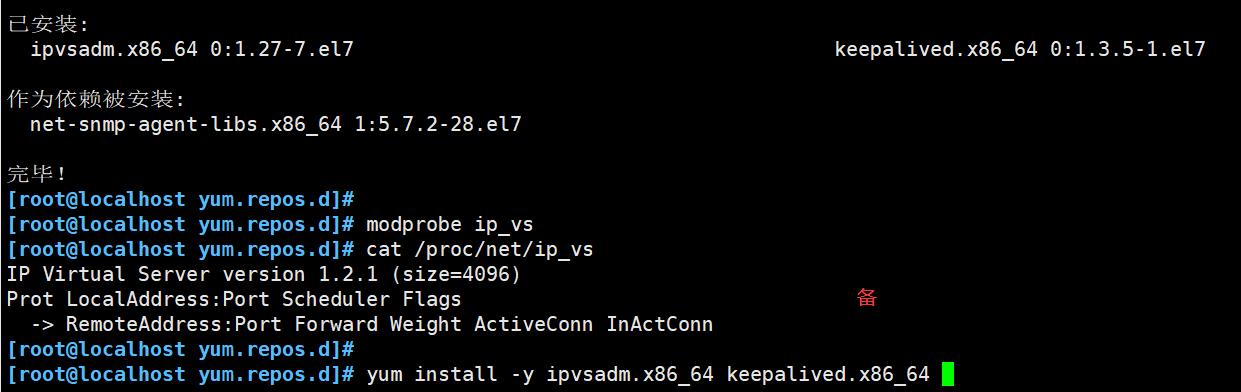

(1)关防火墙,加载ip_vs模块

systemctl stop firewalld.service

systemctl disable firewalld.service

setenforce 0

modprobe ip_vs

cat /proc/net/ip_vs

yum -y install ipvsadm

(2)调整 proc 响应参数

vim /etc/sysctl.conf

net.ipv4.conf.all.send_redirects = 0

net.ipv4.conf.default.send_redirects = 0

net.ipv4.conf.ens33.send_redirects = 0

sysctl -p

(3)配置负载分配策略

这里有点轻微的区别,源IP 是本机的 ip

主负载调度器:192.168.10.30

ipvsadm-save > /etc/sysconfig/ipvsadm

systemctl start ipvsadm.service

ipvsadm -C

#这里-t指定的虚拟地址为本机ens33网卡ip

ipvsadm -A -t 192.168.10.30:80 -s rr

ipvsadm -a -t 192.168.10.30:80 -r 192.168.10.10:80 -g

ipvsadm -a -t 192.168.10.30:80 -r 192.168.10.20:80 -g

ipvsadm

ipvsadm -ln

备负载调度器:192.168.10.31

ipvsadm-save > /etc/sysconfig/ipvsadm

systemctl start ipvsadm.service

ipvsadm -C

ipvsadm -A -t 192.168.10.31:80 -s rr

ipvsadm -a -t 192.168.10.31:80 -r 192.168.10.10:80 -g

ipvsadm -a -t 192.168.10.31:80 -r 192.168.10.20:80 -g

ipvsadm -ln

2.2 配置keeplived

主负载调度器1:192.168.10.30

备负载调度器2:192.168.10.31

yum -y install keepalived

cd /etc/keepalived/

#备份配置文件

cp keepalived.conf keepalived.conf.bak

vim /etc/keepalived/keepalived.conf

vim keepalived.conf

......

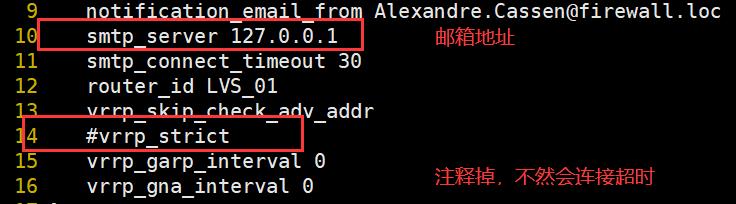

#定义全局参数

global_defs {

#10行修改,邮件服务指向本地

smtp_server 127.0.0.1

#12行修改,指定服务器(路由器)的名称,主备服务器名称须不同,主为LVS_01,备为LVS_02

router_id LVS_01

#14行修改;加注释;vrrp_strict:严格遵守VRRP协议。下列情况将会阻止启动Keepalived:1. 没有VIP地址。2. 单播邻居。3. 在VRRP版本2中有IPv6地址。

#vrrp_strict

}

#定义VRRP热备实例参数

vrrp_instance VI_1 {

#20行修改;指定热备状态,主为MASTER,备为BACKUP

state MASTER

#21行修改;指定承载vip地址的物理接口

interface ens33

#22行修改;指定虚拟路由器的ID号,每个热备组保持一致

virtual_router_id 10

#取消抢占配置,默认是随时进行抢占,配置后可防止 keepalived脑裂情况

#nopreempt

#23行修改;指定优先级,数值越大优先级越高,主为100,备为90

priority 100

#通告间隔秒数(心跳频率)

advert_int 1

#定义认证信息,每个热备组保持一致

authentication {

#认证类型

auth_type PASS

#27行修改,指定验证密码,主备服务器保持一致

auth_pass 123456

}

#指定群集 vip 虚拟地址

virtual_ipaddress {

192.168.10.100

}

}

#34行修改,指定虚拟服务器地址(VIP)、端口,定义虚拟服务器和Web服务器池参数

virtual_server 192.168.10.100 80 {

#健康检查的间隔时间(秒)

delay_loop 6

#指定调度算法,轮询(rr)

lb_algo rr

#37行修改,指定群集工作模式,直接路由(DR)

lb_kind DR

#连接保持时间(秒)

persistence_timeout 50

#应用服务采用的是TCP协议

protocol TCP

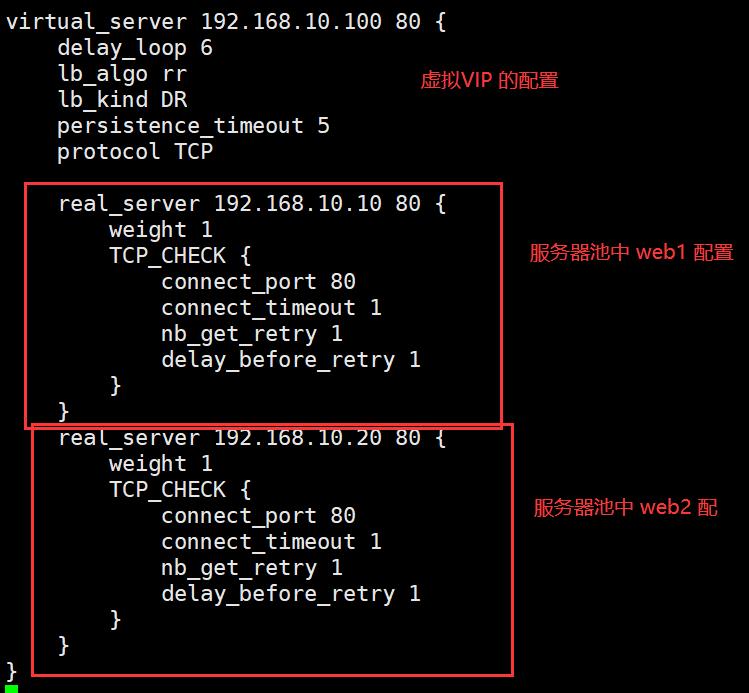

#41行修改,指定第一个Web节点的地址、端口

real_server 192.168.10.10 80 {

#节点的权重

weight 1

#43行删除,添加以下健康检查方式

TCP_CHECK {

#添加检查的目标端口

connect_port 80

#添加连接超时(秒)

connect_timeout 3

#添加重试次数

nb_get_retry 3

#添加重试间隔

delay_before_retry 4

}

}

#添加第二个 Web节点的地址、端口

real_server 192.168.10.20 80 {

weight 1

TCP_CHECK {

connect_port 80

connect_timeout 3

nb_get_retry 3

delay_before_retry 4

}

}

}

#删除后面多余的配置

systemctl start keepalived

#查看虚拟网卡vip

ip addr show dev ens33

或

ip a

192.168.10.30 主 MASTER 配置

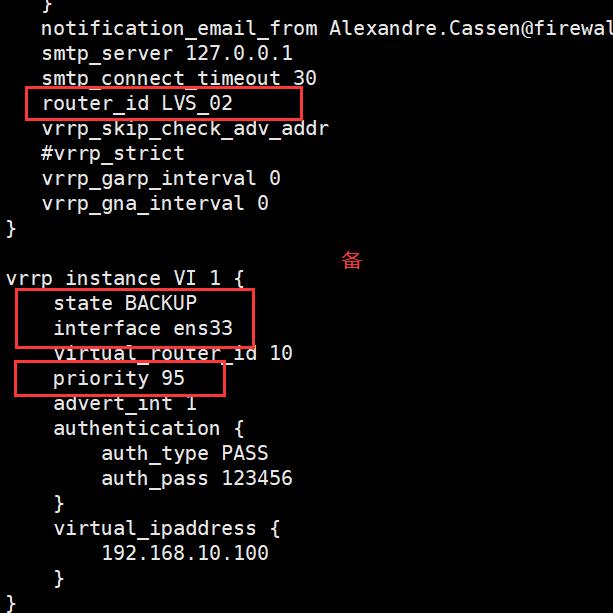

备 192.168.10.31 配置,优先级比主的低就行

分别执行 systemctl restart keepalived.service

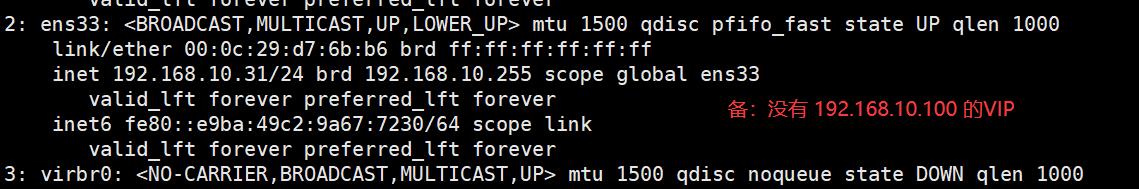

备 执行 ip -a

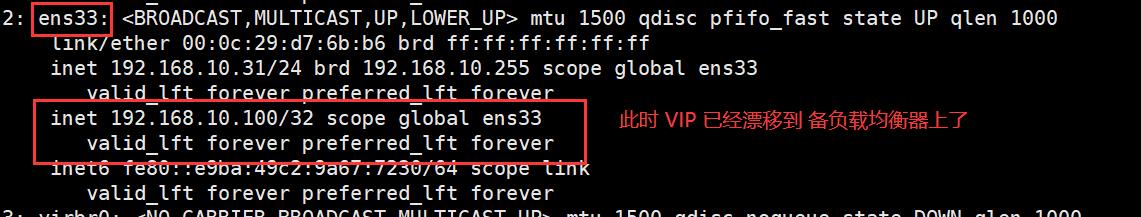

如果此时 主执行 分别执行 systemctl stop keepalived.service

备 再执行 ip -a

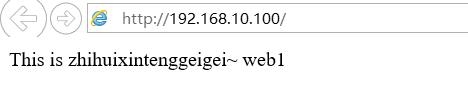

客户端一直都能够访问,负载均衡功能也能实现

以上是关于LVS+Keepalived 搭建高可用群集(DR模式)的主要内容,如果未能解决你的问题,请参考以下文章