2021年大数据Hive:Hive自定义函数

Posted Lansonli

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了2021年大数据Hive:Hive自定义函数相关的知识,希望对你有一定的参考价值。

全网最详细的Hive文章系列,强烈建议收藏加关注!

后面更新文章都会列出历史文章目录,帮助大家回顾知识重点。

目录

系列历史文章

2021年大数据Hive(五):Hive的内置函数(数学、字符串、日期、条件、转换、行转列)

2021年大数据Hive(三):手把手教你如何吃透Hive数据库和表操作(学会秒变数仓大佬)

2021年大数据Hive(二):Hive的三种安装模式和MySQL搭配使用

前言

2021年全网最详细的大数据笔记,轻松带你从入门到精通,该栏目每天更新,汇总知识分享

Hive自定义函数

一、概述

Hive 自带了一些函数,比如:max/min等,但是数量有限,自己可以通过自定义UDF来方便的扩展。

当Hive提供的内置函数无法满足你的业务处理需要时,此时就可以考虑使用用户自定义函数(UDF:user-defined function)。

根据用户自定义函数类别分为以下三种:

1、UDF(User-Defined-Function)

一进一出

类似于:lower/lower/reverse

2、UDAF(User-Defined Aggregation Function)

聚集函数,多进一出

类似于:count/max/min

3、UDTF(User-Defined Table-Generating Functions)

一进多出

如lateral view explode()

二、自定义UDF

编程步骤:

(1)继承org.apache.hadoop.hive.ql.exec.UDF

(2)需要实现evaluate函数;evaluate函数支持重载;

注意事项:

(1)UDF必须要有返回类型,可以返回null,但是返回类型不能为void;

(2)UDF中常用Text/LongWritable等类型,不推荐使用java类型;

1、代码编写

第一步:创建maven java 工程,导入jar包

<dependencies>

<dependency>

<groupId>org.apache.hive</groupId>

<artifactId>hive-exec</artifactId>

<version>2.1.0</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-common</artifactId>

<version>2.7.5</version>

</dependency>

</dependencies>

第二步:开发java类继承UDF,并重载evaluate 方法

public class MyUDF extends UDF{

public Text evaluate(final Text s) {

if (null == s) {

return null;

}

//返回大写字母

return new Text(s.toString().toLowerCase());

}

}

2、函数使用方式1-临时函数

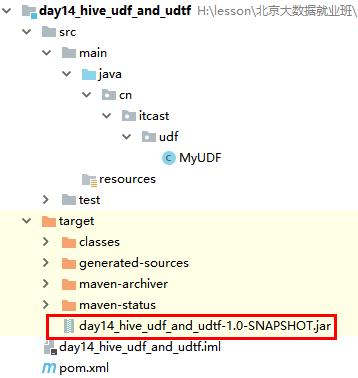

1、将我们的项目打包,并上传到hive的lib目录下

2、添加我们的jar包

将jar包上传到 /export/server/hive-2.1.0/lib目录,并重命名我们的jar包名称

cd /export/server/hive-2.1.0/lib

mv original-day_10_hive_udf-1.0-SNAPSHOT.jar my_lower.jar

3、hive的客户端添加我们的jar包

hive>add jar /export/server/hive-2.1.0/lib/my_lower.jar

4、设置函数与我们的自定义函数关联-临时函数

hive>create temporary function my_lower as 'cn.itcast.udf.MyUDF';

5、使用自定义函数

hive>select my_lower('abc');

3、函数使用方式2-永久函数

1. 把自定义函数的jar上传到hdfs中.

hadoop fs -mkdir /hive_func

hadoop fs -put my_lower.jar /hive_func

2. 创建永久函数

hive> create function my_lower2 as 'cn.itcast.udf.MyUDF' using jar 'hdfs://node1:8020/hive_func/my_lower.jar';

3. 验证

hive> select my_lower2("Hello World");

三、自定义UDTF

1、需求

自定义一个UDTF,实现将一个任意分隔符的字符串切割成独立的单词,例如:

源数据:

"zookeeper,hadoop,hdfs,hive,MapReduce"

目标数据:

zookeeper

hadoop

hdfs

hive

MapReduce

2、代码实现

import org.apache.hadoop.hive.ql.exec.UDFArgumentException;

import org.apache.hadoop.hive.ql.metadata.HiveException;

import org.apache.hadoop.hive.ql.udf.generic.GenericUDTF;

import org.apache.hadoop.hive.serde2.objectinspector.ObjectInspector;

import org.apache.hadoop.hive.serde2.objectinspector.ObjectInspectorFactory;

import org.apache.hadoop.hive.serde2.objectinspector.StructObjectInspector;

import org.apache.hadoop.hive.serde2.objectinspector.primitive.PrimitiveObjectInspectorFactory;

import java.util.ArrayList;

import java.util.List;

import java.util.function.ObjDoubleConsumer;

public class MyUDTF extends GenericUDTF {

private final transient Object[] forwardListObj = new Object[1];

@Override

public StructObjectInspector initialize(StructObjectInspector argOIs) throws UDFArgumentException {

//设置列名的类型

List<String> fieldNames = new ArrayList<>();

//设置列名

fieldNames.add("column_01");

List<ObjectInspector> fieldOIs = new ArrayList<ObjectInspector>() ;//检查器列表

//设置输出的列的值类型

fieldOIs.add(PrimitiveObjectInspectorFactory.javaStringObjectInspector);

return ObjectInspectorFactory.getStandardStructObjectInspector(fieldNames, fieldOIs);

}

@Override

public void process(Object[] objects) throws HiveException {

//1:获取原始数据

String args = objects[0].toString();

//2:获取数据传入的第二个参数,此处为分隔符

String splitKey = objects[1].toString();

//3.将原始数据按照传入的分隔符进行切分

String[] fields = args.split(splitKey);

//4:遍历切分后的结果,并写出

for (String field : fields) {

//将每一个单词添加值对象数组

forwardListObj[0] = field;

//将对象数组内容写出

forward(forwardListObj);

}

}

@Override

public void close() throws HiveException {

}

}

3、添加我们的jar包

将打包的jar包上传到node3主机/export/data/hive-2.1.0/lib目录,并重命名我们的jar包名称

cd /export/data/hive-2.1.0/lib

mv original-day_10_hive_udtf-1.0-SNAPSHOT.jar my_udtf.jar

hive的客户端添加我们的jar包,将jar包添加到hive的classpath下

hive> add jar /export/server/hive-2.1.0/lib/my_udtf.jar;

4、创建临时函数与开发后的udtf代码关联

hive>create temporary function my_udtf as 'cn.itcast.udtf.MyUDTF';

5、使用自定义udtf函数

hive>select my_udtf("zookeeper,hadoop,hdfs,hive,MapReduce",",") word;本博客大数据系列文章会一直每天更新,记得收藏加关注喔~

以上是关于2021年大数据Hive:Hive自定义函数的主要内容,如果未能解决你的问题,请参考以下文章