sparkRDD编程实验

Posted fadeless_3

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了sparkRDD编程实验相关的知识,希望对你有一定的参考价值。

实验平台

操作系统:Ubuntu16.04

Spark版本:2.4.0

Python版本:3.4.3

实验一:pyspark交互式编程

本作业提供分析数据data.txt(该数据集0积分下载),该数据集包含了某大学计算机系的成绩,数据格式如下所示:

Tom,DataBase,80

Tom,Algorithm,50

Tom,DataStructure,60

Jim,DataBase,90

Jim,Algorithm,60

Jim,DataStructure,80

……

请根据给定的实验数据,在pyspark中通过编程来计算以下内容:

(1) 该系总共有多少学生;

(2) 该系共开设了多少门课程;

(3) Tom同学的总成绩平均分是多少;

(4) 求每名同学的选修的课程门数;

(5) 该系DataBase课程共有多少人选修;

(6) 各门课程的平均分是多少;

(7) 使用累加器计算共有多少人选了DataBase这门课。

以下代码仅供参考:

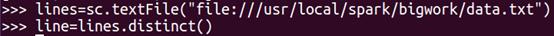

在进行下列操作前,先进行读取数据,然后去重,目的是为了减少数据的运算量,提高数据的运算速度

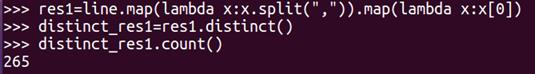

(1) 该系总共有多少学生;

代码解读:

将读取到的数据根据“,”进行拆分后,再根据列表的第一个(学生姓名)进行拆分

然后进行去重,计数输出

(2) 该系共开设了多少门课程;

代码解读:

将读取到的数据根据“,”进行拆分后,再根据列表的第二个(科目)进行拆分

然后进行去重,计数输出

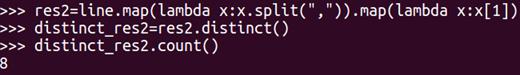

(3) Tom同学的总成绩平均分是多少;

代码解读:

将读取到的数据根据“,”进行拆分后,再根据列表的第一个(学生姓名)为Tom的学生进行拆分

循环输出拆分过滤后的列表

然后根据根据列表的第三个(成绩)进行转换类型(字符串转整型)、拆分

计数输出(有多少学科)

统计所有成绩的综合

成绩综合/学科数=平均值

打印输出结果

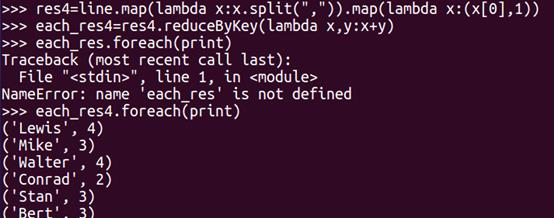

(4) 求每名同学的选修的课程门数;

代码解读:

将读取到的数据根据“,”进行拆分后,再根据列表的第一个(学生姓名)进行计数(以1累加)以(学生姓名,%i)

统计结果以元组(键值对)的形式保存起来

循环打印输出结果

(5) 该系DataBase课程共有多少人选修;

代码解读:

将读取到的数据根据“,”进行拆分后,再根据列表的第二个(科目)为DataBase的学科进行过滤

计数输出

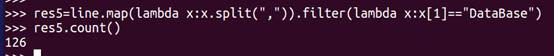

(6) 各门课程的平均分是多少;

代码解读:

将读取到的数据根据“,”进行拆分后,再根据列表的第二个(科目),列表的第三个(成绩)(这里以二维数组的形式保存),然后进行拆分(产生新的列表,以(科目,(成绩,1))保存)

统计结果以元组(键值对)的形式保存起来

计算学科平均分,并利用round(成绩总和/人数,2)保留两位小数

循环输出

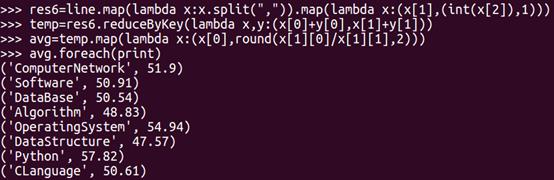

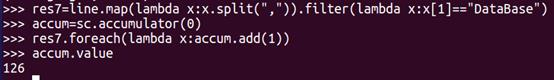

(7) 使用累加器计算共有多少人选了DataBase这门课。

代码解读:

将读取到的数据根据“,”进行拆分后,再根据列表的第二个(科目)为DataBase的学科进行过滤

定义一个从0开始的累加器accum

遍历res7,每扫描一条数据,累加器加1

输出数值

其结果和上面的(5)是一样的

实验二:编写独立应用程序实现数据去重

对于两个输入文件A和B,编写Spark独立应用程序,对两个文件进行合并,并剔除其中重复的内容,得到一个新文件C。本文给出门课的成绩(A.txt、B.txt)下面是输入文件和输出文件的一个样例,供参考。

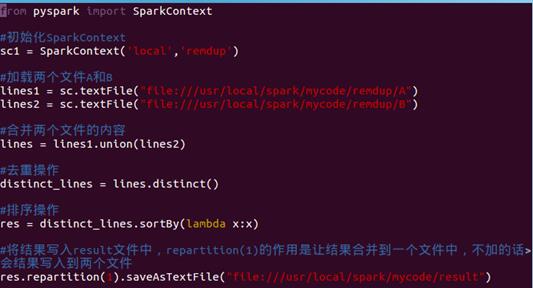

输入文件A的样例如下:

20200101 x

20200102 y

20200103 x

20200104 y

20200105 z

20200106 z

输入文件B的样例如下:

20200101 y

20200102 y

20200103 x

20200104 z

20200105 y

根据输入的文件A和B合并得到的输出文件C的样例如下:

20200101 x

20200101 y

20200102 y

20200103 x

20200104 y

20200104 z

20200105 y

20200105 z

20200106 z

以下操作仅供参考

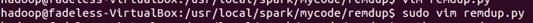

(1)假设当前目录为/usr/local/spark/mycode/remdup,在当前目录下新建一个remdup.py文件

(2)最后在目录/usr/local/spark/mycode/remdup下执行下面命令执行程序(注意执行程序时请先退出pyspark shell,否则会出现“地址已在使用”的警告);

$ python3 remdup.py

(3)在目录/usr/local/spark/mycode/remdup/result下即可得到结果文件part-00000。

实验三:编写独立应用程序实现求平均值问题

每个输入文件表示班级学生某个学科的成绩,每行内容由两个字段组成,第一个是学生名字,第二个是学生的成绩;编写Spark独立应用程序求出所有学生的平均成绩,并输出到一个新文件中。本文给出门课的成绩(Algorithm.txt、Database.txt、Python.txt),下面是输入文件和输出文件的一个样例,供参考。

Algorithm成绩:

小明 92

小红 87

小新 82

小丽 90

Database成绩:

小明 95

小红 81

小新 89

小丽 85

Python成绩:

小明 82

小红 83

小新 94

小丽 91

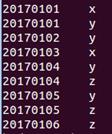

平均成绩如下:

(小红,83.67)

(小新,88.33)

(小明,89.67)

(小丽,88.67)

以下操作仅供参考:

(1)假设当前目录为/usr/local/spark/mycode/avgscore,在当前目录下新建一个avgscore.py;

$ vim avgscore.py

以下代码截图时漏了

from pyspark import SparkContext

#初始化SparkContext

sc = SparkContext('local',' avgscore')

#加载三个文件Algorithm.txt、Database.txt和Python.txt

lines1 = sc.textFile("file:///usr/local/spark/mycode/avgscore/Algorithm.txt")

lines2 = sc.textFile("file:///usr/local/spark/mycode/avgscore/Database.txt")

lines3 = sc.textFile("file:///usr/local/spark/mycode/avgscore/Python.txt")

(2)最后在目录/usr/local/spark/mycode/avgscore下执行下面命令执行程序(注意执行程序时请先退出pyspark shell,否则会出现“地址已在使用”的警告)。

$ python3 avgscore.py

(3)在目录/usr/local/spark/mycode/avgscore/result下即可得到结果文件part-00000。

$ cat part-00000

以上是关于sparkRDD编程实验的主要内容,如果未能解决你的问题,请参考以下文章