你的 AI 算法模型安全吗?来 AI 安全测试基准平台测试下

Posted AI科技大本营

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了你的 AI 算法模型安全吗?来 AI 安全测试基准平台测试下相关的知识,希望对你有一定的参考价值。

整理 | 伍杏玲

出品 | AI 科技大本营(ID:rgznai100)

回顾人工智能 60 多年的发展历程,我们经历了第一代以知识驱动的人工智能,第二代以数据驱动的人工智能,如今来到第三代以安全、可控为主的阶段。

为何 AI 安全如此重要?譬如去年引发全民“吃瓜”的“AI 换脸杨幂”等换脸技术,在娱乐之余,还有可能被不法分子应用到黑产以及金融欺诈事件中。

另外,由于算法存在的“对抗样本”特征,黑客可基于对抗样本技术,通过简单伪装,便能引发 AI 算法新漏洞,随之攻击系统。去年美国东北大学和麻省理工学院共同研制出“基于对抗样本”的 T 恤。用技术生成有较强干扰性的图案替换掉衣服上的原有图案,从而改变 T 恤的视觉效果。因此干扰 AI 检测,无法检测出行人,达到“隐身”的效果。

面向恶性 AI 安全事件不断涌现,如何提前评估 AI 算法安全,检测算法漏洞?

6月3日,清华大学联合阿里安全、Real AI发布了 AI 攻防对抗基准平台(Adversarial Robustness Benchmark),可对 AI 防御和攻击算法进行自动化和科学地评估。

AI 模型攻防“标尺”

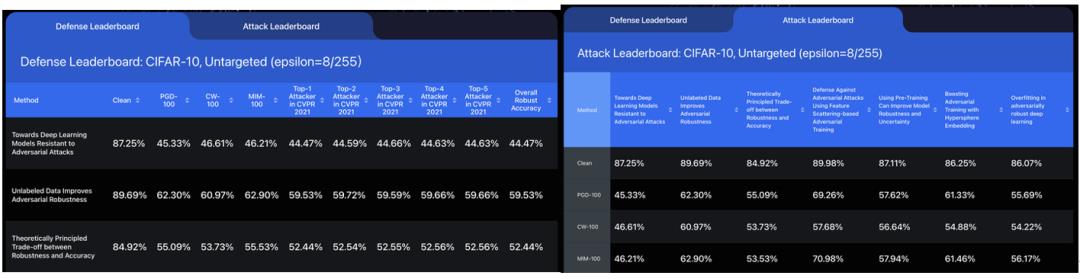

AI 安全基准平台基于清华大学在 2020 年GitHub 开源的 ARES 算法库,提供模型攻击与防御的排行榜。

安全性对抗稳健性评估 ARES 库,是一个用于对抗性机器学习研究的 Python 库,专注于对图像分类的对抗性稳健性进行基准测试。曾在完整的威胁模型下使用 15 次攻击和 16 次防御对对抗性稳健性进行了基准测试。

谈及 AI 安全基准平台的研发初衷,据官方表示,由于攻击算法是经常变化的,需要考虑模型在多种攻击算法下和更强的攻击下的防御能力,如果只在一种攻击算法下进行测试的话,不够全面。另外,以往一些攻击排行榜只有一些零散和仅针对一个防御算法的排行版,有些也没有统计攻击算法的耗时。

对此,不同于以往只包含零散攻防模型的对抗攻防基准,AI 对抗安全基准平台涵盖目前主流的人工智能对抗攻防模型,并覆盖数十种典型的攻防算法。并且在不同算法比测的过程中尽量采用了相同的实验设定和一致的度量标准,最大限度上保证比较的公平性,做 AI 模型攻防“标尺”。

官网:http://ml.cs.tsinghua.edu.cn/adv-bench/

未来发展

在本次发布的 AI 安全排行榜里,涵盖刚结束的 CVPR2021 人工智能攻防竞赛中诞生的排名前五代表队的攻击算法。此次竞赛吸引到了全球 2000多支代表队提交的最新算法,进一步提升了该安全基准的科学性和可信性。

据介绍,工业界可用该平台来评估自己的 AI 算法安全性,帮助尽早发现模型的安全漏洞。对有学术界而言,平台提供全面、客观、公平、科学地比较模型防御能力和对抗攻击算法攻击能力,具有行业标准性。由于该基准评测平台不是专属于某一家机构或者公司搭建的平台,需要大家共同参与,一起将它打造为更全面、权威的 AI 安全评估平台。

扫描下方二维码,添加小助手

即刻加入 AI 科技大本营「读者群」

群内将不定期放送福利

快快加入吧!

以上是关于你的 AI 算法模型安全吗?来 AI 安全测试基准平台测试下的主要内容,如果未能解决你的问题,请参考以下文章