文献阅读08期:SBM-DEA混合蒙特卡洛的能用效用评估

Posted RaZLeon

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了文献阅读08期:SBM-DEA混合蒙特卡洛的能用效用评估相关的知识,希望对你有一定的参考价值。

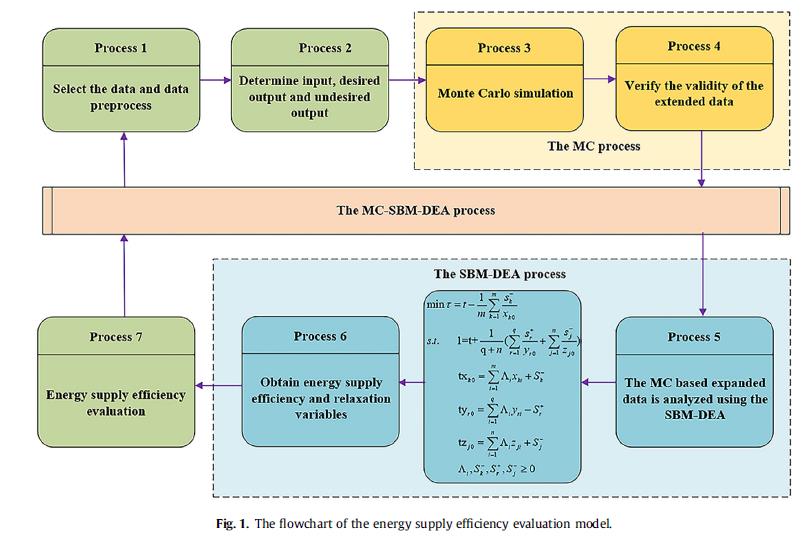

[ 文献阅读·能源 ] Energy supply efficiency evaluation of integrated energy systems using novel SBM-DEA integrating Monte Carlo [1]

推荐理由: 以往的DEA模型分为两种,径向模型和角度量模型,这两种模型要么没有考虑松弛问题,要么仅考虑单一的输入输出。本文提出的MC-SBM-DEA可以说是兼顾了两个方面,值得借鉴

1.摘要&简介

- 主流的DEA模型分为两种,径向模型和角度量模型。径向模型经常忽视松弛问题,而角度量模型进考虑单一的输入输出。

- SBM-DEA模型同时兼顾了两个方面且有以下重要特性:

- 效率的度量不受决策单元的影响(decision-making units)

- 效率值和输入输出之差是单调递减的。

2.问题模型

2.1. SBM-DEA模型

- 若有m个输入n个出,所有可能集合可定义为:

P = { ( x , y ) ∣ x ≥ X λ , y ≤ Y λ , λ ≥ 0 } (1) P=\\{(x, y) \\mid x \\geq X \\lambda, y \\leq Y \\lambda, \\lambda \\geq 0\\}\\tag{1} P={(x,y)∣x≥Xλ,y≤Yλ,λ≥0}(1) - 其中 x x x是输入, y y y是输出, λ \\lambda λ为调整矩阵。

- 通过测量

DMU

(

x

0

,

y

0

)

\\operatorname{DMU}\\left(x_{0}, y_{0}\\right)

DMU(x0,y0)的效率,SBM-DEA模型的基础形式可以写为以下形式:

ρ ∗ = min 1 − 1 m ∑ k = 1 m s k − x k 0 1 − 1 n ∑ r = 1 n s r + y r 0 S.t. x 0 = X λ + s − y 0 = Y λ − s + λ ≥ 0 , s − ≥ 0 , s + ≥ 0 (2) \\begin{array}{l} \\rho^{*}=\\min \\frac{1-\\frac{1}{m} \\sum_{k=1}^{m} \\frac{s_{k}^{-}}{x_{k 0}}}{1-\\frac{1}{n} \\sum_{r=1}^{n} \\frac{s_{r}^{+}}{y_{r 0}}} \\\\ \\text { S.t. } \\mathrm{x}_{0}=X \\lambda+s^{-} \\\\ \\mathrm{y}_{0}=Y \\lambda-s^{+} \\\\ \\lambda \\geq 0, s^{-} \\geq 0, s^{+} \\geq 0 \\end{array}\\tag{2} ρ∗=min1−n1∑r=1nyr0sr+1−m1∑k=1mxk0sk− S.t. x0=Xλ+s−y0=Yλ−s+λ≥0,s−≥0,s+≥0(2)

其中, ρ ∗ \\rho^{*} ρ∗代表 DMU ( x 0 , y 0 ) \\operatorname{DMU}\\left(x_{0}, y_{0}\\right) DMU(x0,y0)的效率值, X r 0 X_{r 0} Xr0和 Y r 0 Y_{r 0} Yr0为第j个DMU的输入输出向量。 s + \\mathrm{s}^{+} s+和 s − \\mathrm{s}^{-} s−为输入输出相对应的松弛变量。 s k − s_{k}^{-} sk−代表第k个输入的冗余, s r + s_{r}^{+} sr+代表第r个输出的不足。 - 目标函数上下分别代表输入输出的效率水平,任何一方变化都会造成效率值的变化。

- 将标量t引入式2有:

min τ = t − 1 m ∑ k = 1 m t s k − x k 0 s.t. 1 = t + 1 n ∑ r = 1 n t s r + y r 0 x 0 = X λ + s − y 0 = Y λ − s + λ ≥ 0 , s − ≥ 0 , s + ≥ 0 , t > 0 (5) \\begin{array}{l} \\min \\tau=t-\\frac{1}{m} \\sum_{k=1}^{m} \\frac{t s_{k}^{-}}{x_{k 0}} \\\\ \\text { s.t. } 1=\\mathrm{t}+\\frac{1}{\\mathrm{n}} \\sum_{r=1}^{n} \\frac{t s_{r}^{+}}{y_{r 0}} \\\\ \\mathrm{x}_{0}=X \\lambda+s^{-} \\\\ \\mathrm{y}_{0}=Y \\lambda-s^{+} \\\\ \\lambda \\geq 0, s^{-} \\geq 0, s^{+} \\geq 0, \\mathrm{t}>0 \\end{array}\\tag{5} minτ=t−m1∑k=1mxk0tsk− s.t. 1=t+n1∑r=1nyr0tsr+x0=Xλ+s−y0=Yλ−s+λ≥0,s−≥0,s+≥0,t>0