HashMap1.8底层数据结构分析源代码解析1.7头插法如何形成环形链表

Posted Java.xu

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了HashMap1.8底层数据结构分析源代码解析1.7头插法如何形成环形链表相关的知识,希望对你有一定的参考价值。

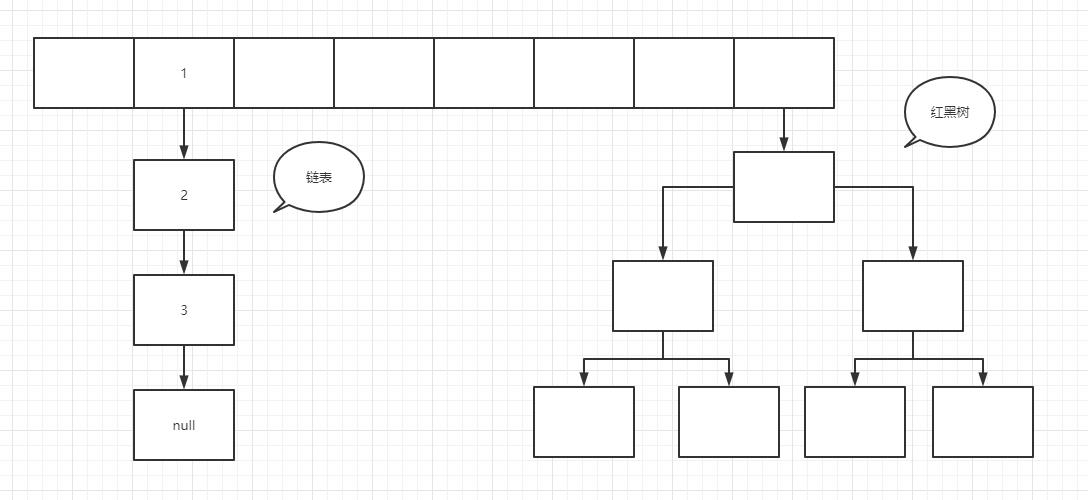

HashMap工作中常用的数据结构之一,底层数据结构是由数组+链表+红黑树组成如下图

了解了HashMap的数据结构之后你肯定会有一些疑虑为什么有的是链表有的是红黑树有的却只有一个节点,链表和红黑树之间是如何转换的?下面从0到1来拨开云雾吧!

首先看下HashMap的一些属性

/**

* 缺省table大小,也就是默认初始化数组长度

*/

static final int DEFAULT_INITIAL_CAPACITY = 1 << 4; // aka 16

/**

* table最大长度

*/

static final int MAXIMUM_CAPACITY = 1 << 30;

/**

* 缺省负载因子大小

*/

static final float DEFAULT_LOAD_FACTOR = 0.75f;

/**

* 树化阈值

*/

static final int TREEIFY_THRESHOLD = 8;

/**

* 树降级称为链表的阈值

*/

static final int UNTREEIFY_THRESHOLD = 6;

/**

* 树化的另一个参数,当哈希表中的所有元素个数超过64时,才会允许树化

*/

static final int MIN_TREEIFY_CAPACITY = 64;

/**

* HashMap中的数组

*/

transient Node<K,V>[] table;

/**

* 当前哈希表中元素个数

*/

transient int size;

//HashMap中的内部类,注意看他的4个属性

static class Node<K,V> implements Map.Entry<K,V> {

//hash值

final int hash;

//传入的键

final K key;

//传入的值

V value;

//因为是链表,所以指向下一个节点的信息,这个next本身也是一个Node节点

Node<K,V> next;

Node(int hash, K key, V value, Node<K,V> next) {

this.hash = hash;

this.key = key;

this.value = value;

this.next = next;

}

public final K getKey() { return key; }

public final V getValue() { return value; }

//还有些方法不做展示

}

然后看HashMap的初始化方法

/**

* 传入一个初始长度和加载因子

*/

public HashMap(int initialCapacity, float loadFactor) {

//其实就是做了一些校验

//capacity必须是大于0 ,最大值也就是 MAX_CAP

if (initialCapacity < 0)

throw new IllegalArgumentException("Illegal initial capacity: " +

initialCapacity);

if (initialCapacity > MAXIMUM_CAPACITY)

initialCapacity = MAXIMUM_CAPACITY;

//loadFactor必须大于0

if (loadFactor <= 0 || Float.isNaN(loadFactor))

throw new IllegalArgumentException("Illegal load factor: " +

loadFactor);

this.loadFactor = loadFactor;

this.threshold = tableSizeFor(initialCapacity);

}

/**

* initialCapacity :传入一个初始长度,默认loadFactor为0.75

*/

public HashMap(int initialCapacity) {

this(initialCapacity, DEFAULT_LOAD_FACTOR);

}

/**

* 什么都不传,默认长度为16,加载因子loadFactor为0.75

*/

public HashMap() {

this.loadFactor = DEFAULT_LOAD_FACTOR;

}

/**

* 传入一个Map把这个Map重新赋值给新的Map

*/

public HashMap(Map<? extends K, ? extends V> m) {

this.loadFactor = DEFAULT_LOAD_FACTOR;

putMapEntries(m, false);

}

不难看出HashMap有4个构造函数,其中最主要的就是第1个构造函数,其中大部分是参数的校验,但是注意看tableSizeFor(initialCapacity)这个方法

//作用:返回一个大于等于当前值cap的一个数字,并且这个数字一定是2的次方数

static final int tableSizeFor(int cap) {

int n = cap;

n |= n >>> 1;

n |= n >>> 2;

n |= n >>> 4;

n |= n >>> 8;

n |= n >>> 16;

return (n < 0) ? 1 : (n >= MAXIMUM_CAPACITY) ? MAXIMUM_CAPACITY : n + 1;

}

这个方法很重要,得到的是当前传入的初始大小的向上取2的幂次方,比如说我传入一个14,那么通过该方法就会返回16,传入31就会返回32,这里为什么一定要取2的幂次方,作用很大,后面寻址找到数据存放到哪个下标的数组时再详细说明。

现在构造工作已经完成了,但是当前HashMap还是一个空壳,里面的table并没有初始化,第一次初始化的时候是在第一次put的时候,下面看代码

final V putVal(int hash, K key, V value, boolean onlyIfAbsent,

boolean evict) {

//tab:引用当前hashMap的散列表

//p:表示当前散列表的元素

//n:表示散列表数组的长度

//i:表示路由寻址 结果

Node<K,V>[] tab; Node<K,V> p; int n, i;

//延迟初始化逻辑,第一次调用putVal时会初始化hashMap对象中的最耗费内存的散列表

if ((tab = table) == null || (n = tab.length) == 0)

n = (tab = resize()).length;

//最简单的一种情况:寻址找到的桶位 刚好是 null,这个时候,直接将当前k-v=>node 扔进去就可以了

if ((p = tab[i = (n - 1) & hash]) == null)

tab[i] = newNode(hash, key, value, null);

else {

//e:不为null的话,找到了一个与当前要插入的key-value一致的key的元素

//k:表示临时的一个key

Node<K,V> e; K k;

//表示桶位中的该元素,与你当前插入的元素的key完全一致,表示后续需要进行替换操作

if (p.hash == hash &&

((k = p.key) == key || (key != null && key.equals(k))))

e = p;

else if (p instanceof TreeNode)//红黑树,这里不做过多说明,红黑树插入节点本质上和链表差不多,只不过他的翻转很复杂

e = ((TreeNode<K,V>)p).putTreeVal(this, tab, hash, key, value);

else {

//链表的情况,而且链表的头元素与我们要插入的key不一致。

for (int binCount = 0; ; ++binCount) {

//条件成立的话,说明迭代到最后一个元素了,也没找到一个与你要插入的key一致的node

//说明需要加入到当前链表的末尾

if ((e = p.next) == null) {

p.next = newNode(hash, key, value, null);

//条件成立的话,说明当前链表的长度,达到树化标准了,需要进行树化

if (binCount >= TREEIFY_THRESHOLD - 1) // -1 for 1st

//树化操作

treeifyBin(tab, hash);

break;

}

//条件成立的话,说明找到了相同key的node元素,需要进行替换操作

if (e.hash == hash &&

((k = e.key) == key || (key != null && key.equals(k))))

break;

p = e;

}

}

//e不等于null,条件成立说明,找到了一个与你插入元素key完全一致的数据,需要进行替换

if (e != null) { // existing mapping for key

V oldValue = e.value;

if (!onlyIfAbsent || oldValue == null)

e.value = value;

afterNodeAccess(e);

return oldValue;

}

}

//modCount:表示散列表结构被修改的次数,替换Node元素的value不计数

++modCount;

//插入新元素,size自增,如果自增后的值大于扩容阈值,则触发扩容。

if (++size > threshold)

resize();

afterNodeInsertion(evict);

return null;

}

第一次put的时候table肯定为null,那就会进去resize()方法这个方法大家应该都知道,这个是扩容的方法,但其实HashMap1.8扩容resize方法还有一个功能就是初始化table,看下面代码

final Node<K,V>[] resize() {

//oldTab:引用扩容前的哈希表

Node<K,V>[] oldTab = table;

//oldCap:表示扩容之前table数组的长度

int oldCap = (oldTab == null) ? 0 : oldTab.length;

//oldThr:表示扩容之前的扩容阈值,触发本次扩容的阈值

int oldThr = threshold;

//newCap:扩容之后table数组的大小

//newThr:扩容之后,下次再次触发扩容的条件

int newCap, newThr = 0;

//条件如果成立说明 hashMap中的散列表已经初始化过了,这是一次正常扩容

if (oldCap > 0) {

//扩容之前的table数组大小已经达到 最大阈值后,则不扩容,且设置扩容条件为 int 最大值。

if (oldCap >= MAXIMUM_CAPACITY) {

threshold = Integer.MAX_VALUE;

return oldTab;

}

//oldCap左移一位实现数值翻倍,并且赋值给newCap, newCap 小于数组最大值限制 且 扩容之前的阈值 >= 16

//这种情况下,则 下一次扩容的阈值 等于当前阈值翻倍

else if ((newCap = oldCap << 1) < MAXIMUM_CAPACITY &&

oldCap >= DEFAULT_INITIAL_CAPACITY)

newThr = oldThr << 1; // double threshold

}

//oldCap == 0,说明hashMap中的散列表是null,也就是说是Map map=new HashMap();构造出来的map,那就给默认长度16,扩容阈值12

//1.new HashMap(initCap, loadFactor);

//2.new HashMap(initCap);

//3.new HashMap(map); 并且这个map有数据

else if (oldThr > 0) // initial capacity was placed in threshold

newCap = oldThr;

//oldCap == 0,oldThr == 0

//new HashMap();

else { // zero initial threshold signifies using defaults

newCap = DEFAULT_INITIAL_CAPACITY;//16

newThr = (int)(DEFAULT_LOAD_FACTOR * DEFAULT_INITIAL_CAPACITY);//12

}

//newThr为零时,通过newCap和loadFactor计算出一个newThr

if (newThr == 0) {

float ft = (float)newCap * loadFactor;

newThr = (newCap < MAXIMUM_CAPACITY && ft < (float)MAXIMUM_CAPACITY ?

(int)ft : Integer.MAX_VALUE);

}

threshold = newThr;

//创建出一个更长 更大的数组

@SuppressWarnings({"rawtypes","unchecked"})

Node<K,V>[] newTab = (Node<K,V>[])new Node[newCap];

table = newTab;

//说明,hashMap本次扩容之前,table不为null,初始化时不会进入,因为旧数组为null,进入改方法必定是扩容

if (oldTab != null) {

for (int j = 0; j < oldCap; ++j) {

//当前node节点

Node<K,V> e;

//说明当前桶位中有数据,但是数据具体是 单个数据,还是链表 还是 红黑树 并不知道

if ((e = oldTab[j]) != null) {

//方便JVM GC时回收内存

oldTab[j] = null;

//第一种情况:当前桶位只有一个元素,从未发生过碰撞,这情况 直接计算出当前元素应存放在 新数组中的位置,然后

//扔进去就可以了

if (e.next == null)

newTab[e.hash & (newCap - 1)] = e;

//第二种情况:当前节点已经树化,本期先不讲,下一期讲,红黑树

else if (e instanceof TreeNode)

((TreeNode<K,V>)e).split(this, newTab, j, oldCap);

else { // preserve order

//第三种情况:桶位已经形成链表

//低位链表:存放在扩容之后的数组的下标位置,与当前数组的下标位置一致。

Node<K,V> loHead = null, loTail = null;

//高位链表:存放在扩容之后的数组的下表位置为 当前数组下标位置 + 扩容之前数组的长度

Node<K,V> hiHead = null, hiTail = null;

Node<K,V> next;

do {

next = e.next;

//hash-> .... 1 1111

//hash-> .... 0 1111

// 0b 10000

/** 这里用hash & 旧数组长度并没有-1,是为了区分高位和低位,比如16的二进制 10000用这个数&上hash

* 无论hahs是什么值结果都只有1和0,如果减1那16的二进制就是1111,无法区分高位和低位 */

if ((e.hash & oldCap) == 0) {

if (loTail == null)

loHead = e;

else

/** 这里主要是形成链表结构 ,值得注意的是,hashmap的1.7和1.8版本在扩容的时候经常使用临时变量

* 来承载node节点,所以 loTail.next = e 应该是loTail这个临时变量指针所指的节点对象的next

* */

loTail.next = e;

loTail = e;

}

else {

if (hiTail == null)

hiHead = e;

else

hiTail.next = e;

hiTail = e;

}

} while ((e = next) != null);

if (loTail != null) {

/** 也是属于拆分链表的一部分 */

loTail.next = null;

newTab[j] = loHead;

}

if (hiTail != null) {

hiTail.next = null;

newTab[j + oldCap] = hiHead;

}

}

}

}

}

return newTab;

}

这里就可以看出如果在构造HashMap map=new HashMap()的时候什么也不传那oldThr肯定是没赋值的,默认给HashMap初始容量16,扩容阈值12。

如果有传入初始容量HashMap map=new HashMap(16)那么就会根据loadFactor加载因子去计算出threshold扩容阈值,最终都会创建一个新的Node数组赋值给旧数组并且返回Node<K,V>[] newTab = (Node<K,V>[])new Node[newCap],因为第一次旧数组为空所以不会进入扩容的数据转移方法,好了,现在初始化完成后返回了table,那继续进行put方法,注意看我上面的put代码片段。在put前if ((p = tab[i = (n - 1) & hash]) == null)注意n上面赋值为数组的length了n = (tab = resize()).length前面有说到为什么为什么HashMap的长度一定是2的幂次方,假设长度n为16,转换为二进制那就是0001 0000那么(n-1)的二进制位0000 11111,在假设我们的key的hash为 0101 0101

(n - 1) & hash==0000 1111&0101 0101 不管hash怎么变&出来这个值一定<=0000 1111(也就是n-1)

n-1又刚好是数组长度的最大值,所以put进去的下标永远不会超过数组长度,并且计算机底层计算都是通过二进制计算的所以 &操作效率更快tab[i = (n - 1) & hash])这个操作称为寻址也就是找到对应的数组下标,下面才开始存放数据到table,put分为4种情况:

1.获取到当前下标节点还未存放数据也就是说table[i]==null,这种情况直接放入数据即可

2.获取到当前下标节点有数据(只有当前一个),如果当前hash、key(值和地址)都相等那么久覆盖旧值

3.获取到当前下标节点有数据(形成链表),那么则需要遍历链表插入到最后,插入完后需要判断当前链表是否达到树化阈值(树化阈值为8)当链表节点达到树化阈值后,链表会转为红黑树(转为红黑树可以参考其他博客主要是红黑树的翻转比较复杂,但是插入数据的思想还是不变)

4.获取到当前下标节点有数据(已经是红黑树),那么需要遍历红黑树,然后插入(红黑树参考其他博客,如果有需要的话我会考虑出一篇红黑树的博客)

最后会判断一下当前HashMap的size有没有超过threshold扩容阈值,如果超过了那就会触发resize()方法,如果没有超过那么久会返回元素,put成功。

好了下面看到resize()代码块,我们来看下扩容方法如何转移元素:

进入扩容方法前面说过不是初始化就是要扩大HashMap的容量,这里我们假设是需要扩容

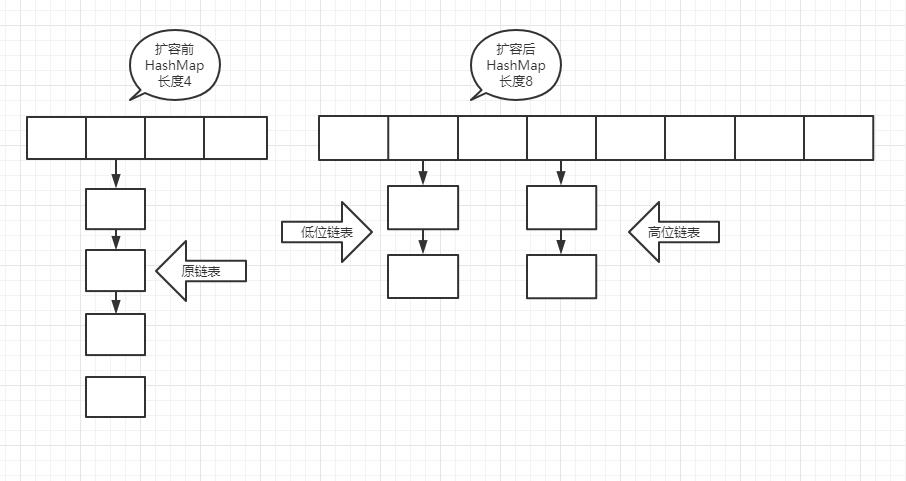

首先旧数组oldTab肯定不为空所以oldCap也就是数组长度肯定>0那就会进入if (oldCap > 0) {}这个代码块首先判断旧数组长度是否超过MAXIMUM_CAPACITY最大长度,超过了直接赋予Integer.MAX_VALUE的最大值2147483647,否则就将数组长度扩大1倍,然后重新计算出扩容阈值并且赋值给新的threshold最后就是数据的转移,HashMap1.8数据转移分为高位和低位会拆分链表及红黑树以达到数据分散的效果充分利用HashMap的空间,降低链表及红黑树的长度加快查询效率,下面是扩容前以及扩容后的效果图

数据转移的思路其实不难结合我上面的resize()方法代码块非常简单的可以看出就是遍历旧数组这里也分为4种情况,和put类似,需要注意的是不管是哪种情况都会重新计算元素存放在新数组中的下标位置

1.遍历到当前节点为null说明当前节点没有元素则跳过

2.遍历到当前节点只有一个元素即未发生hash碰撞,则重新计算当前元素在新数组中的下标 newTab[e.hash & (newCap - 1)] = e

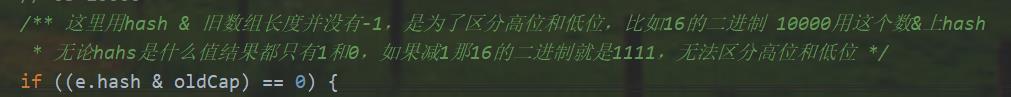

3.遍历到当前节点为链表则会遍历该链表,上面说到HashMap分为高位和低位,仔细看我上面的代码块,这里我截图下来,高位和低位是通过(e.hash & oldCap) == 0来判断的,诶这里怎么和之前put所说的计算元素存放数组的下标如此相似tab[i = (n - 1) & hash],是的没错具体解释看下图

4.遍历到到当前节点是红黑树,那么也是遍历红黑树进行拆分,并且拆分后红黑树达到退化阈值6之后会从红黑树转为链表(这里不讲红黑树是因为红黑树的翻转不好表述,,实际面试中我们也不可能去和面试官说怎么翻转的,我们只需要知道他这个执行思路即可,如果非要说的话可以去看红黑树博客)

至此数据的转移就完成了,HashMap1.8使用的是尾插法,不会出现扩容之后元素顺序颠倒的情况,也不会产生环形链表所以不会导致get的时候产生dead lock情况,但是这并不代表jdk1.8的HashMap线程是安全的,他同样存在并发修改异常ConcurrentModificationException

其实讲到这里HashMap就差不多了,他的get、remove方法都非常简单我这里就不过多赘述了,简单说下get的思路吧!老规矩先看下面代码

final Node<K,V> getNode(int hash, Object key) {

//tab:引用当前hashMap的散列表

//first:桶位中的头元素

//e:临时node元素

//n:table数组长度

Node<K,V>[] tab; Node<K,V> first, e; int n; K k;

if ((tab = table) != null && (n = tab.length) > 0 &&

(first = tab[(n - <以上是关于HashMap1.8底层数据结构分析源代码解析1.7头插法如何形成环形链表的主要内容,如果未能解决你的问题,请参考以下文章