机器学习 Machine Learning- 吴恩达Andrew Ng 第6~10课总结

Posted 架构师易筋

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了机器学习 Machine Learning- 吴恩达Andrew Ng 第6~10课总结相关的知识,希望对你有一定的参考价值。

YouTube课程地址

https://www.youtube.com/playlist?list=PLOXON7BTL9IW7Ggbc09jLqGmzkwPI4-3V

截止2021-5-3, 有112 个视频

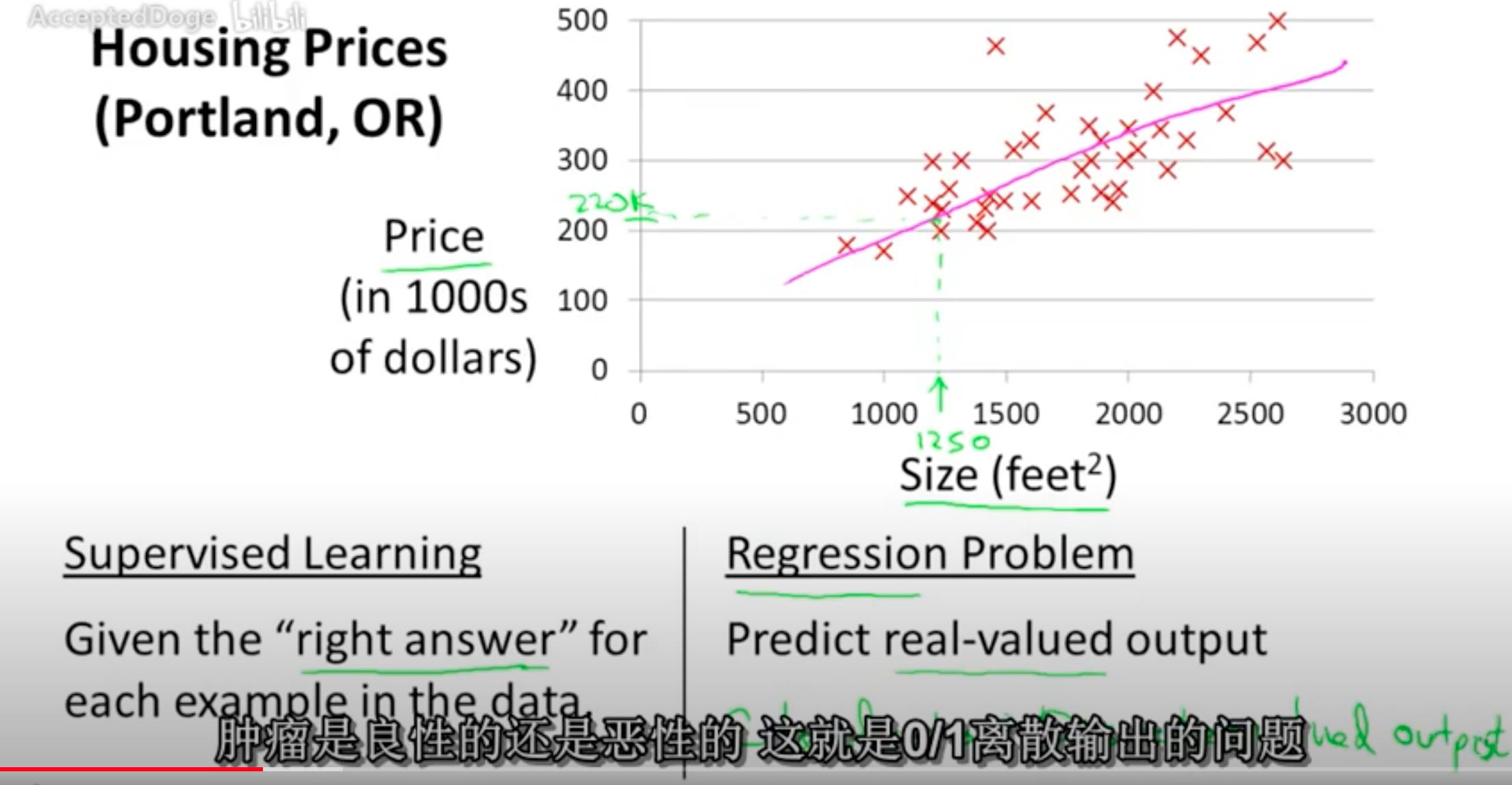

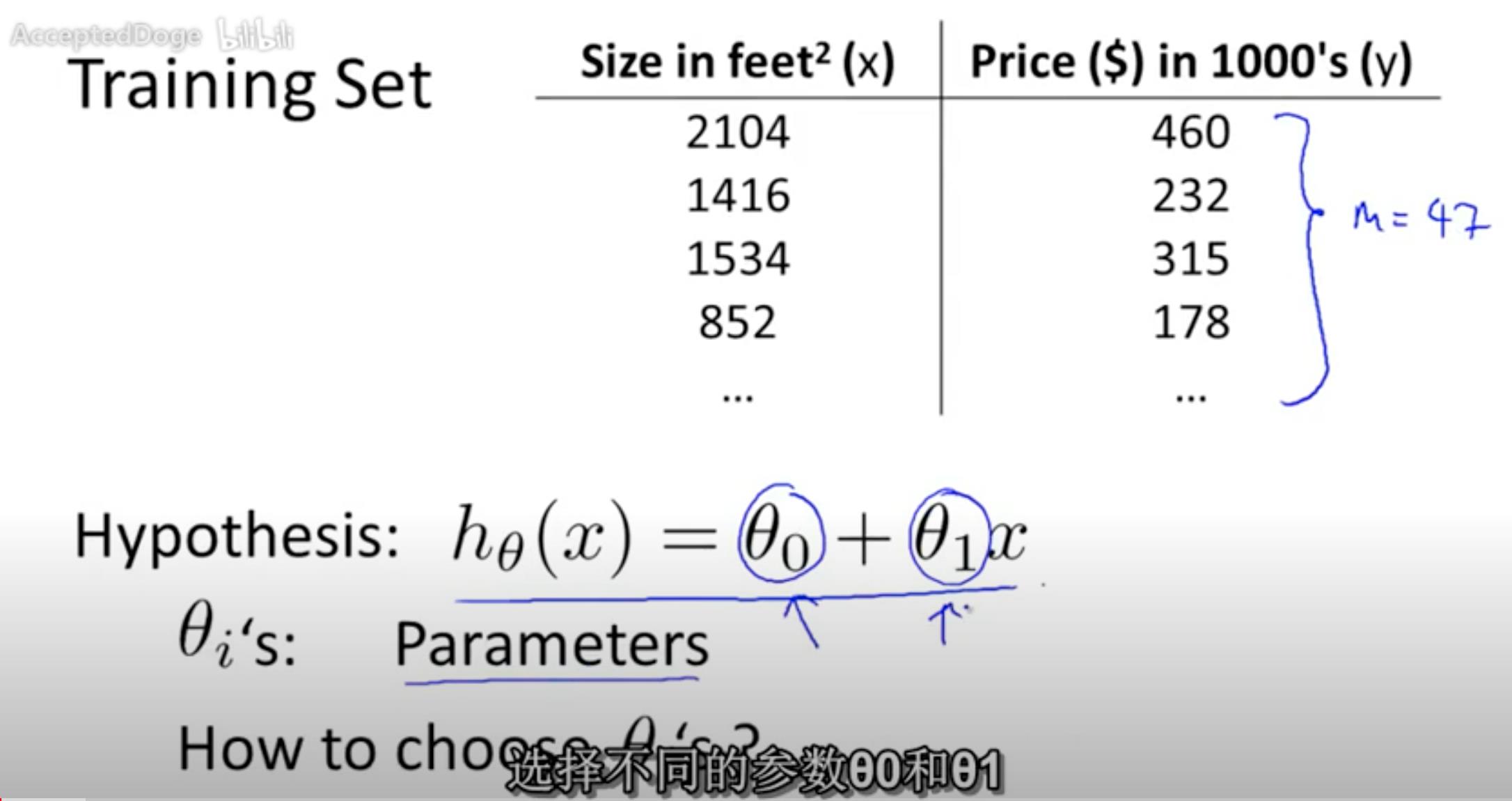

1. 第6课 Model Representation, Linear regression with one variable

例子:预测房价,根据房子大小预测要卖1250 feet^2 大小的房子,价格大概是220k。

因为是线性回归问题,可以用Supervised Learning 监督学习的方法得到模型公式。

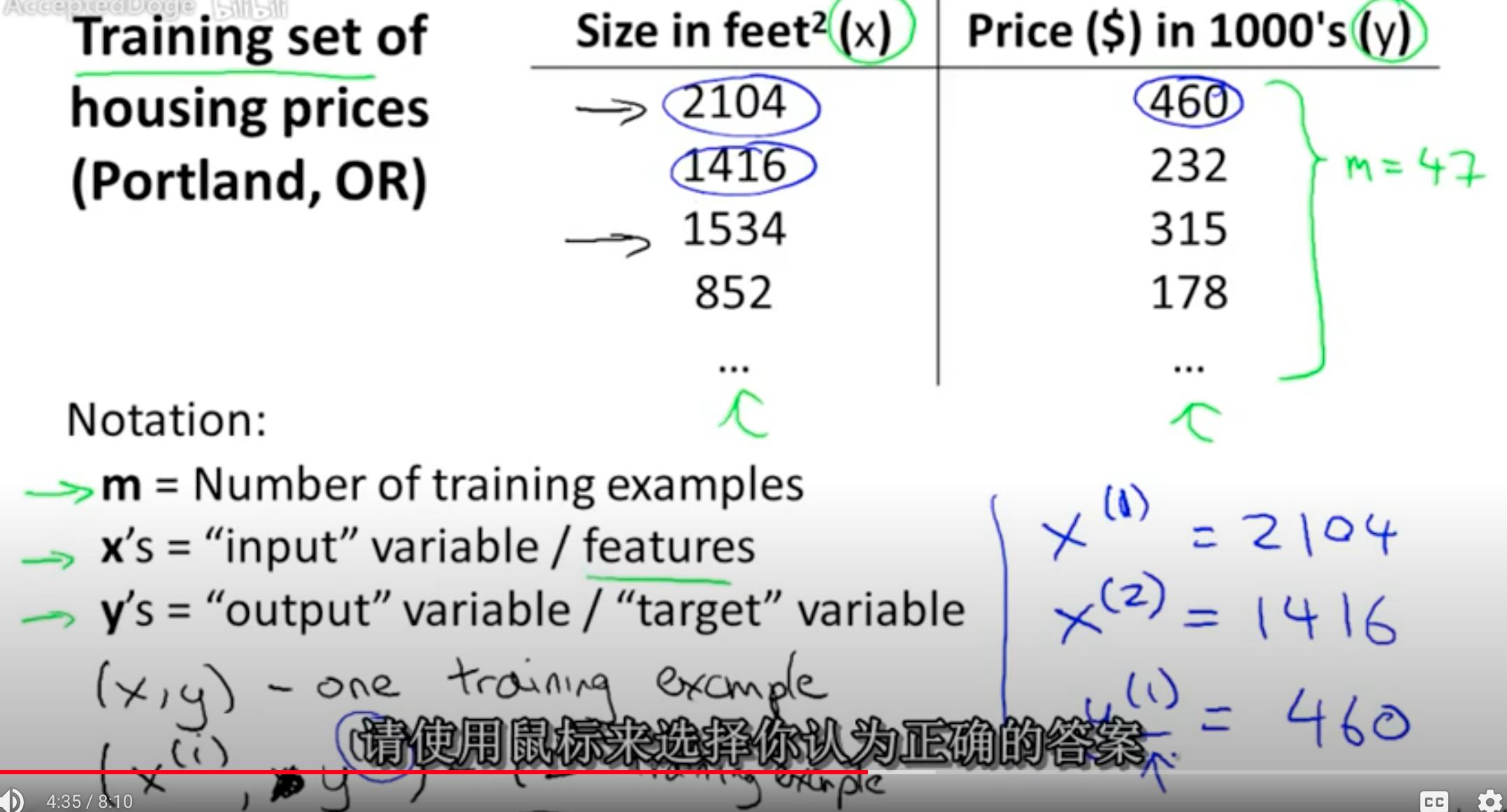

参数解析:

- x为入参房子的大小

- y为预测结果,房子的价格

- 训练的结果为(x, y), 有很多对。

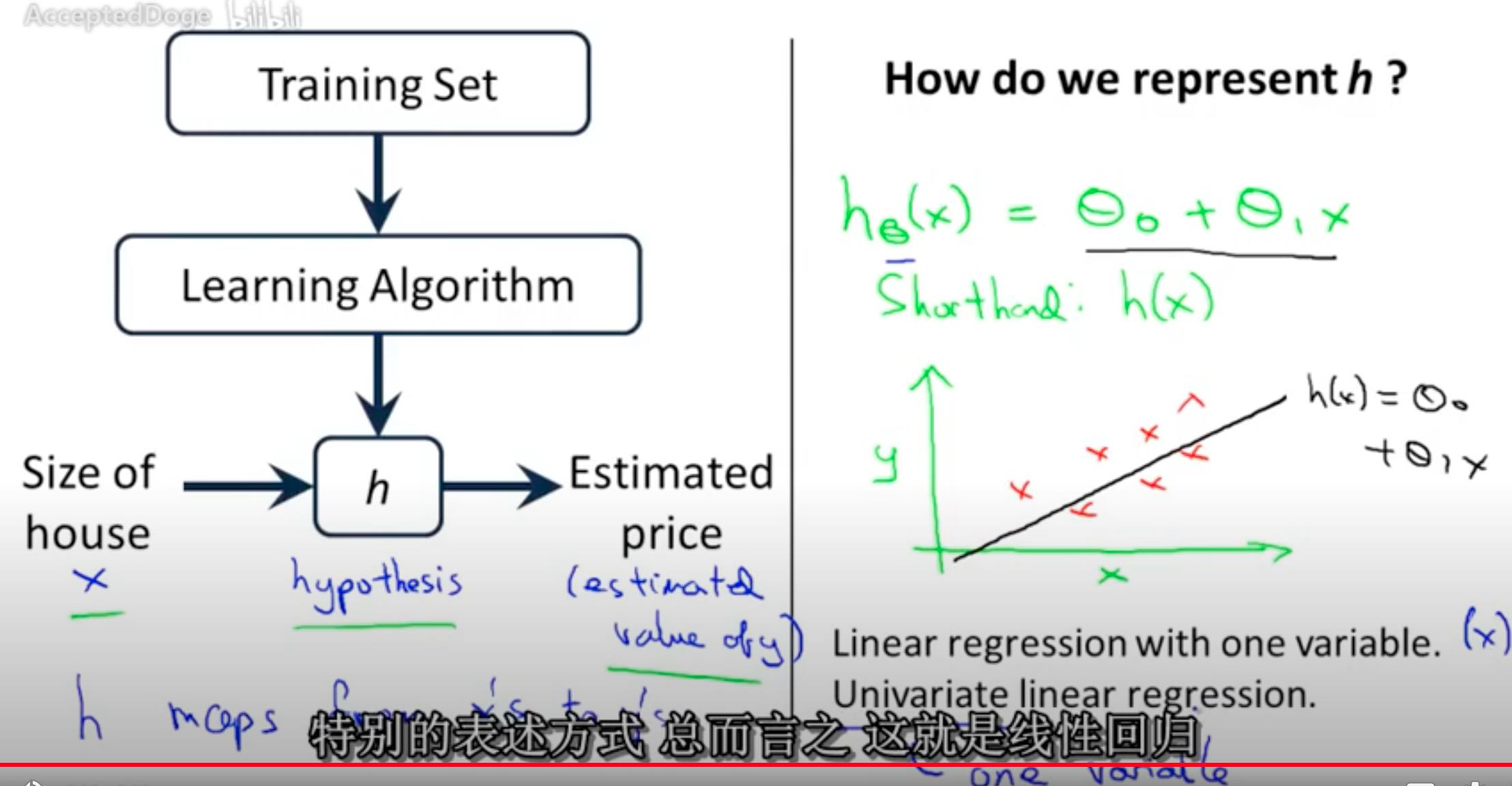

训练步骤为:

- 准备训练数据 Training Set

- 学习算法Learning Algorithm, 这里为线性函数

h(x) = θ0 + θ1 * x - h 表示 hypothesis, 表示map的意思,表示从x 推导出 y。

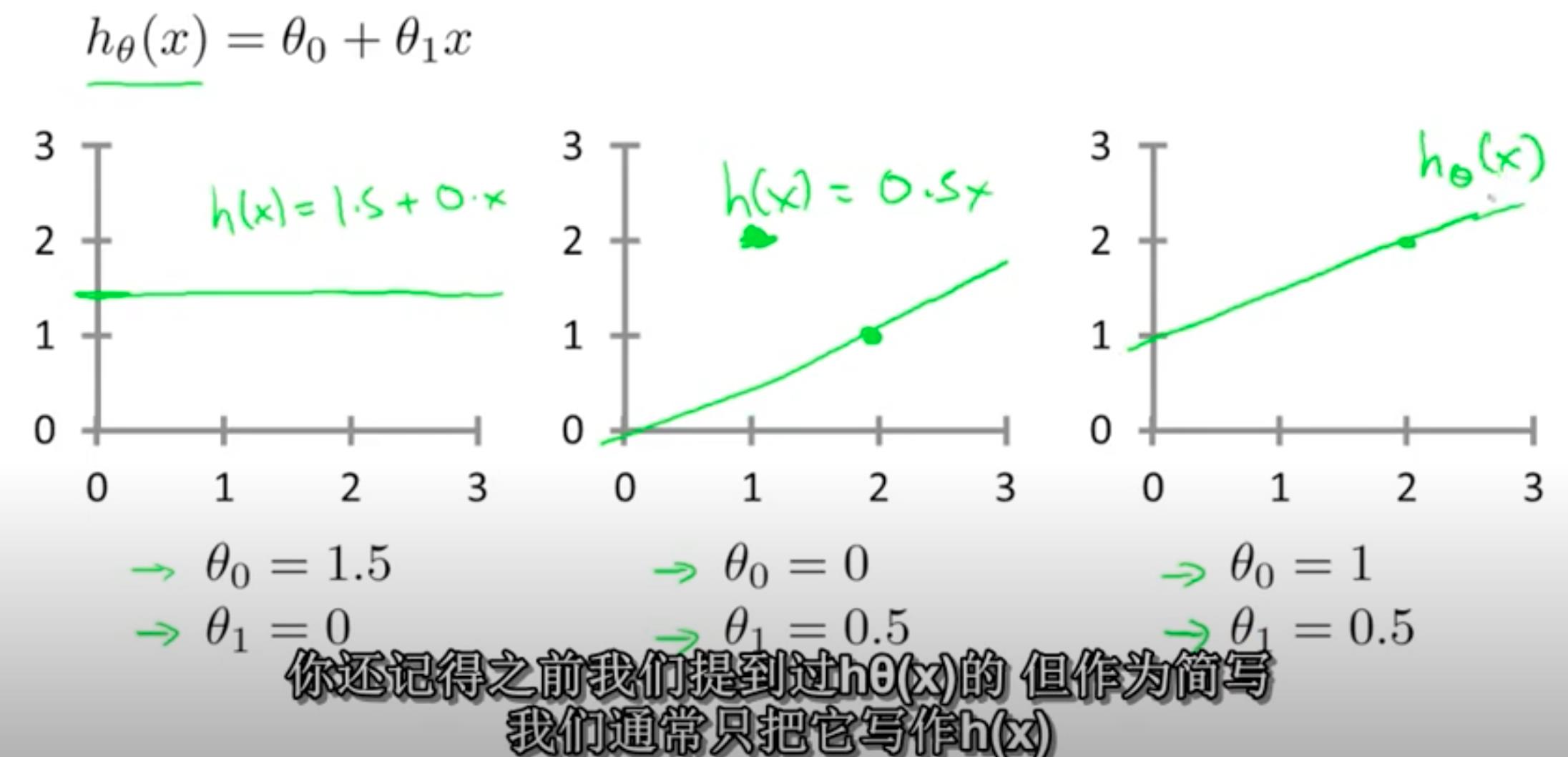

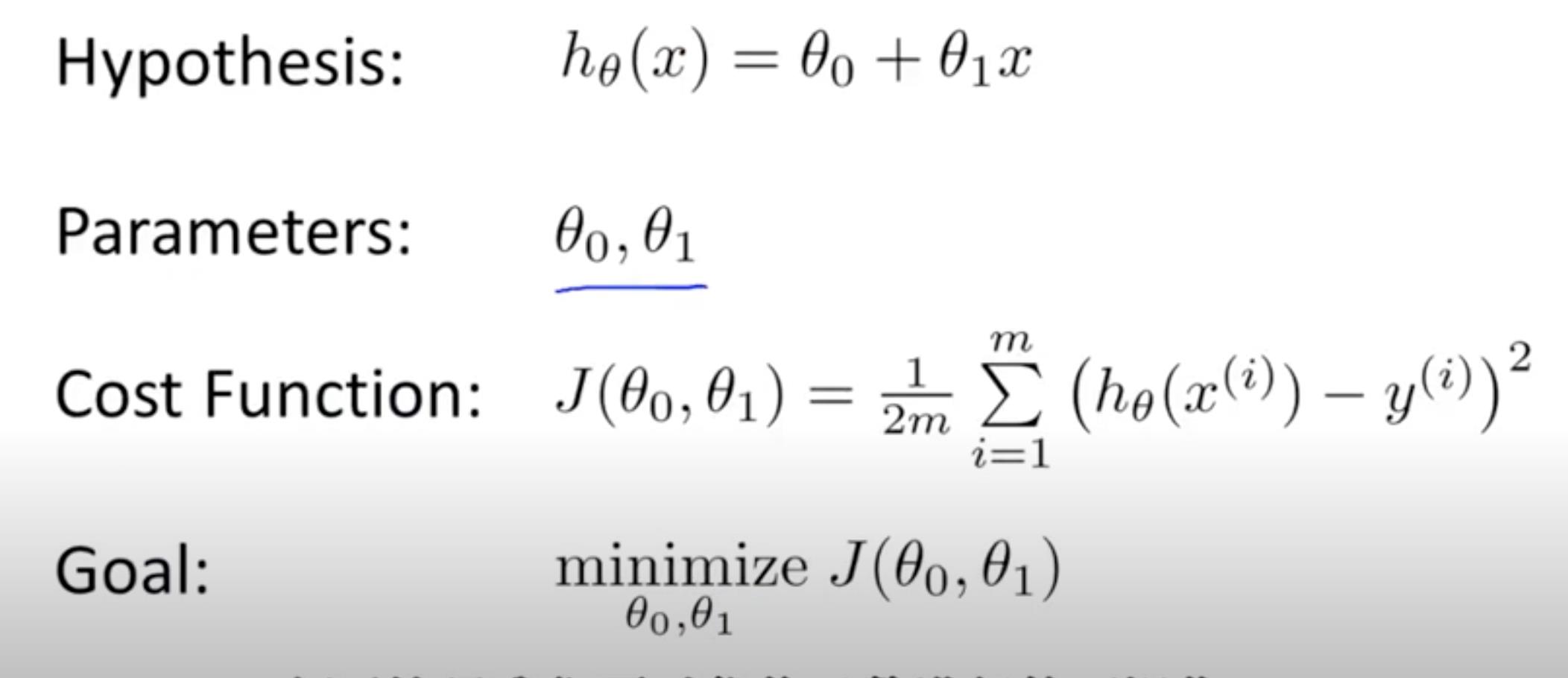

2. 第7课 Cost function - Linear regression with one variable

线性函数 h(x) = θ0 + θ1 * x, 如何选择(θ0, θ1)?

看看如下三个取值的,二维图表示

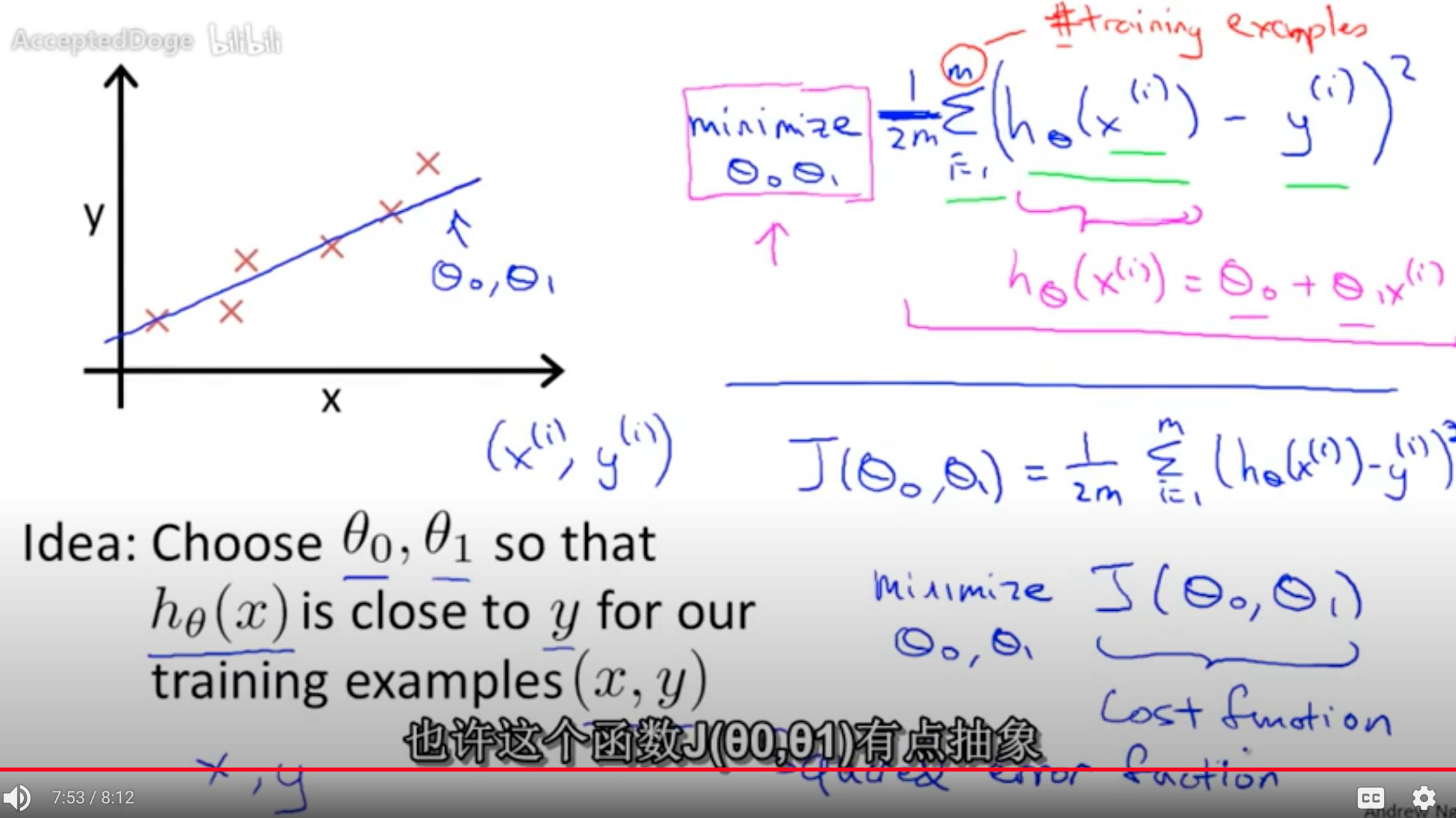

Cost function 计算值与实际值的差的平方之和, 除以 2m就是能耗方程 J(θ0, θ1) 。

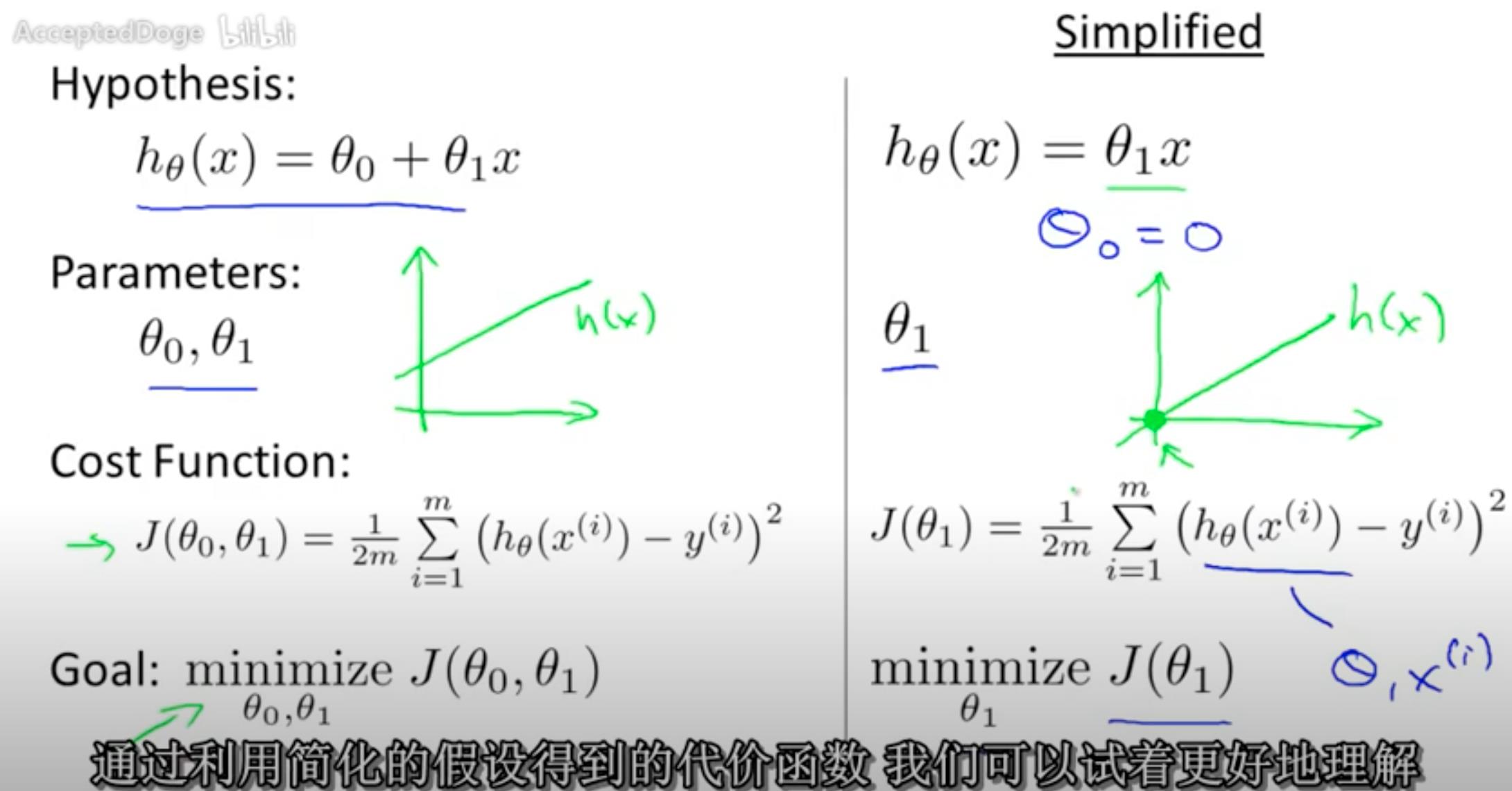

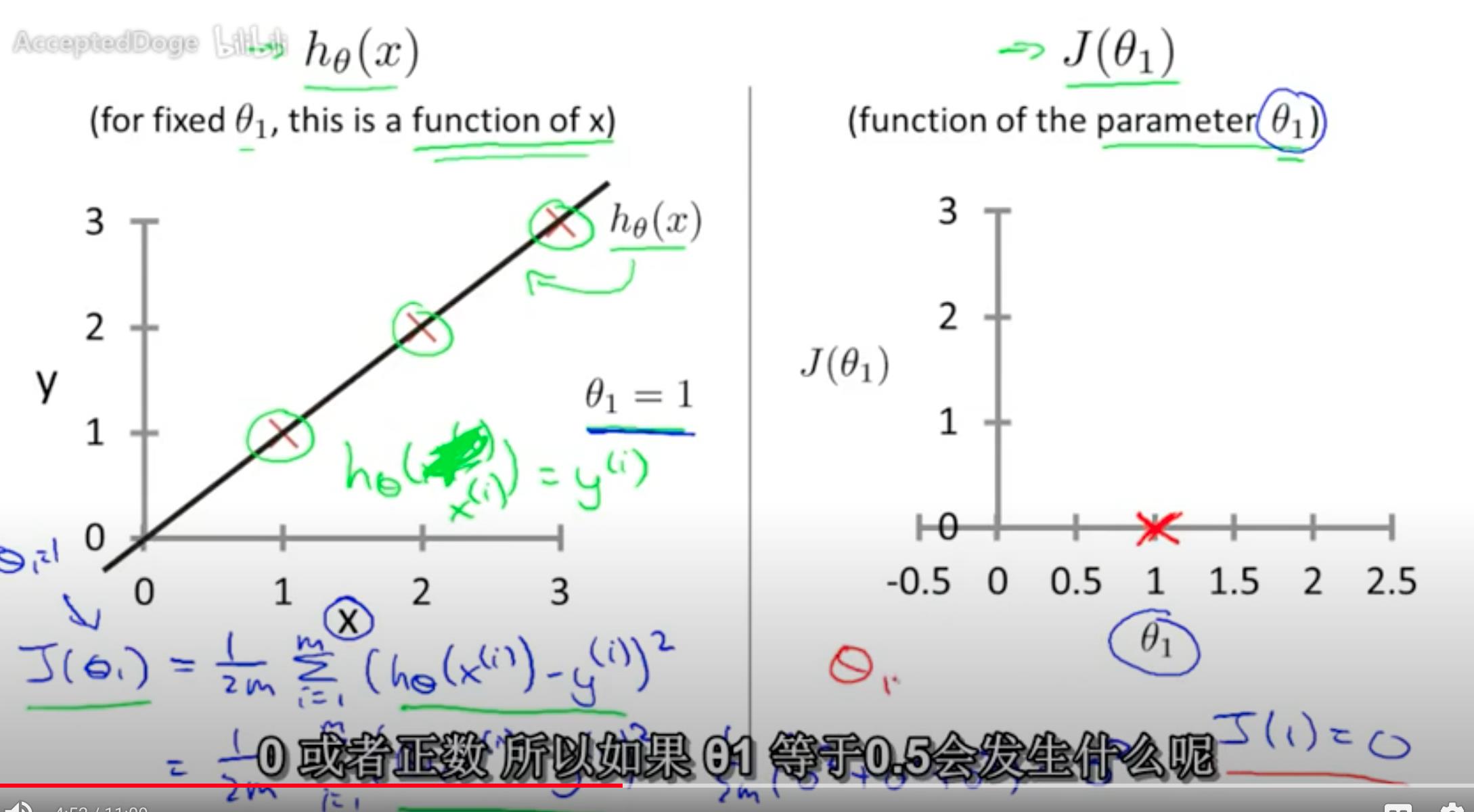

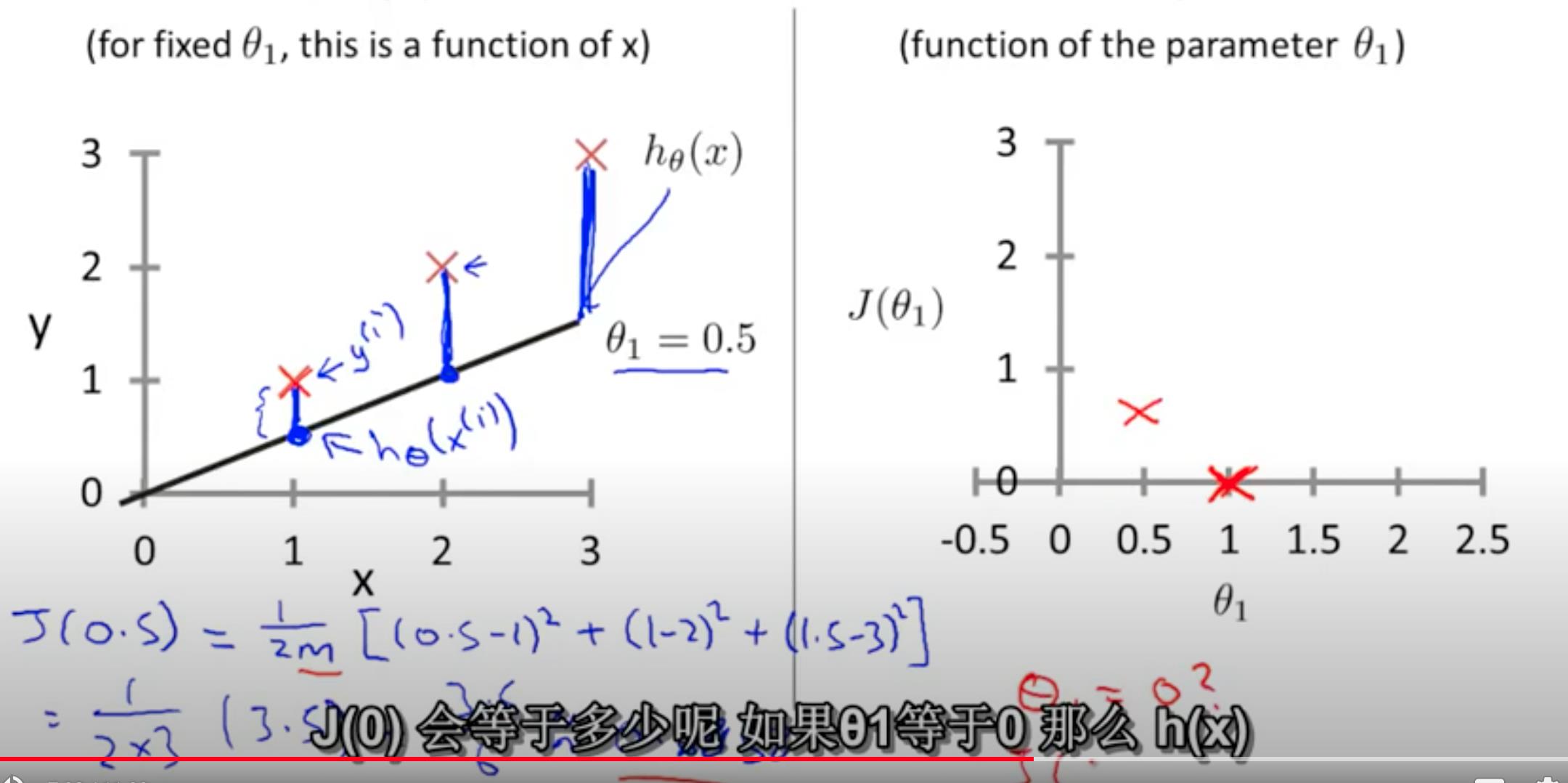

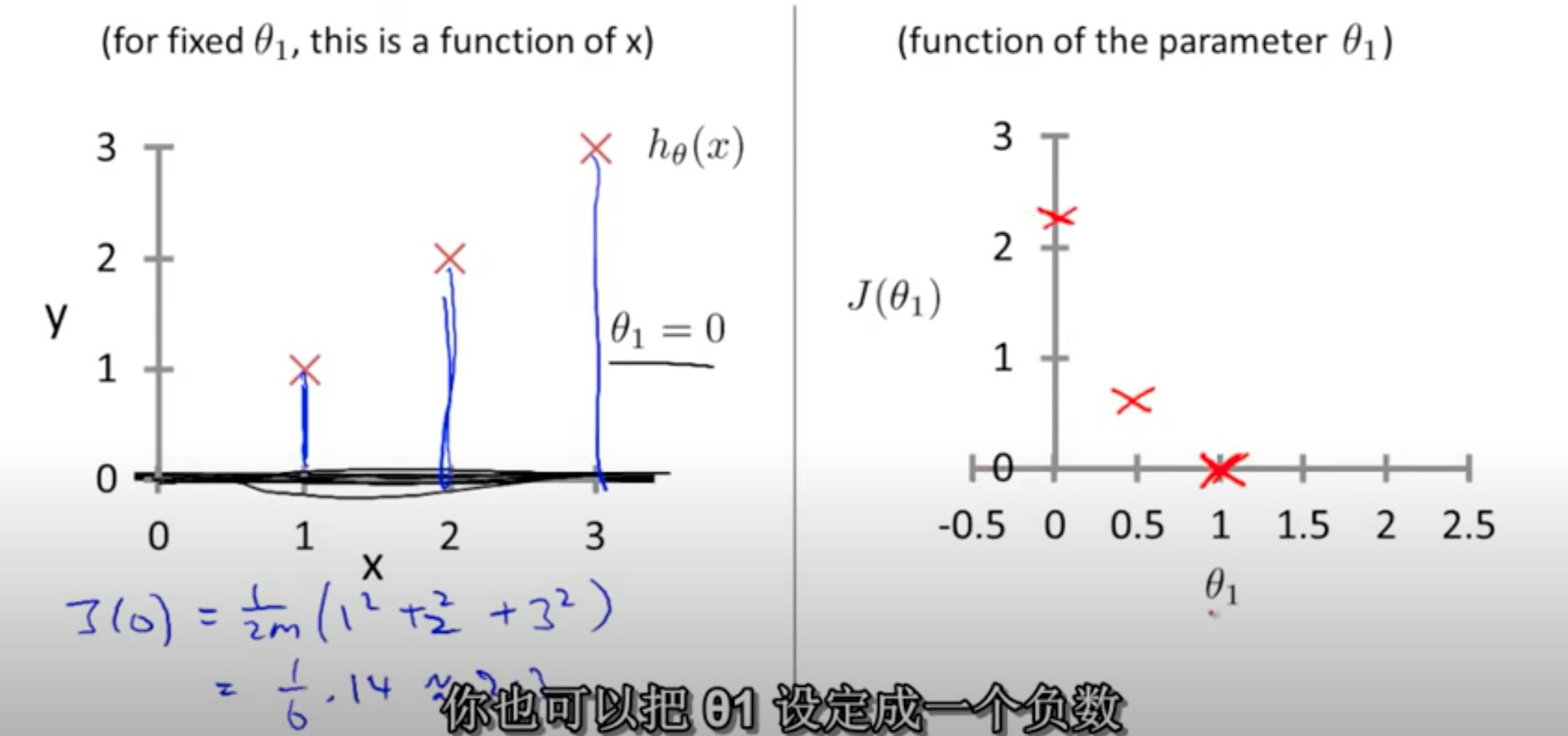

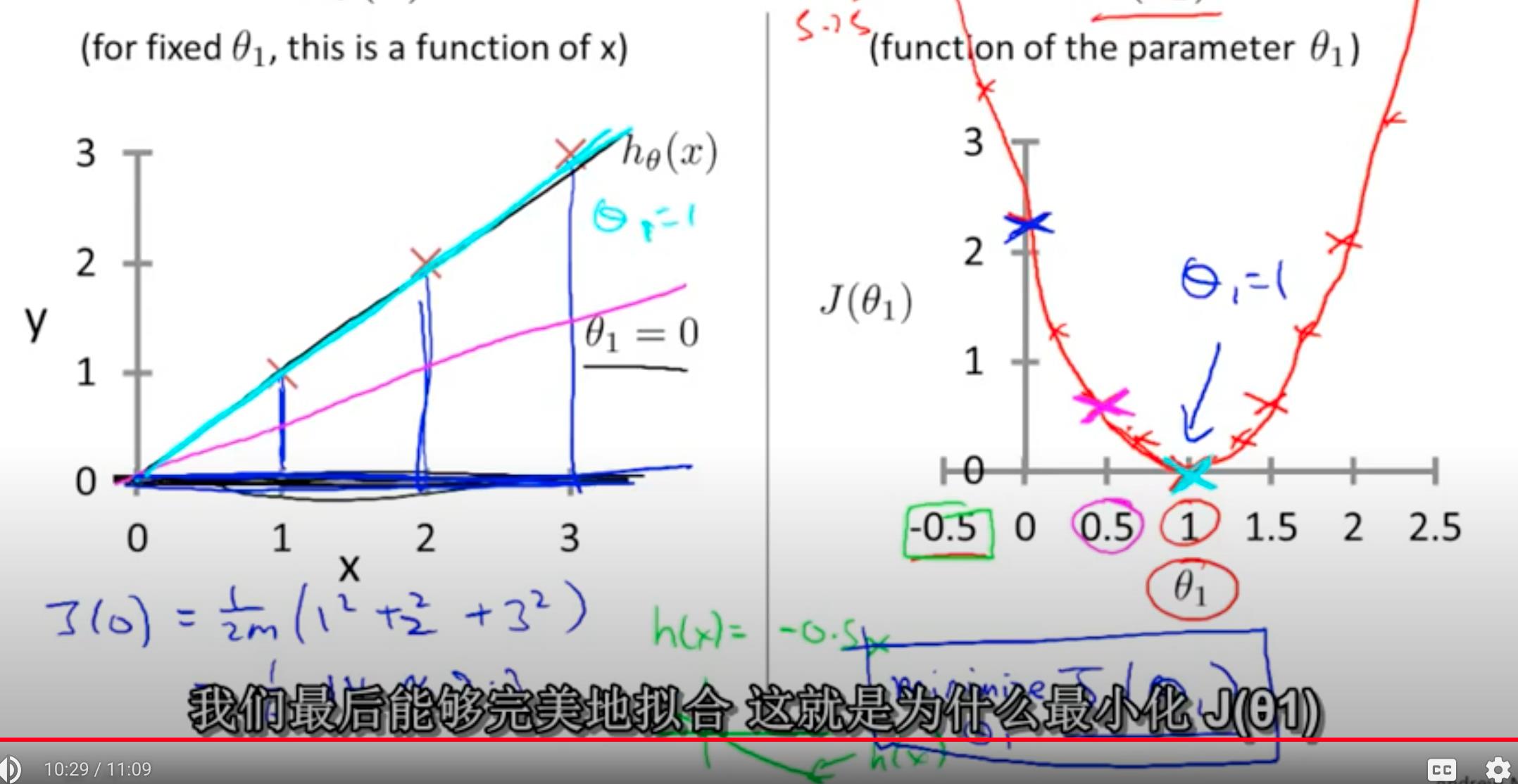

3. 第8课 Cost function intuition I - Linear regression with one variable

一元一次方程h(x) = θ0 + θ1 * x,为了简化说明,去掉了参数θ0,得到简化方程 h(x) = θ1 * x

h(1) -> J(1) = 0

h(0.5) -> J(0.5) = 0.68

h(0) -> J(0) = 2.3

能耗方程是为了计算最小值为最优解,也就是h(1) -> J(1) = 0

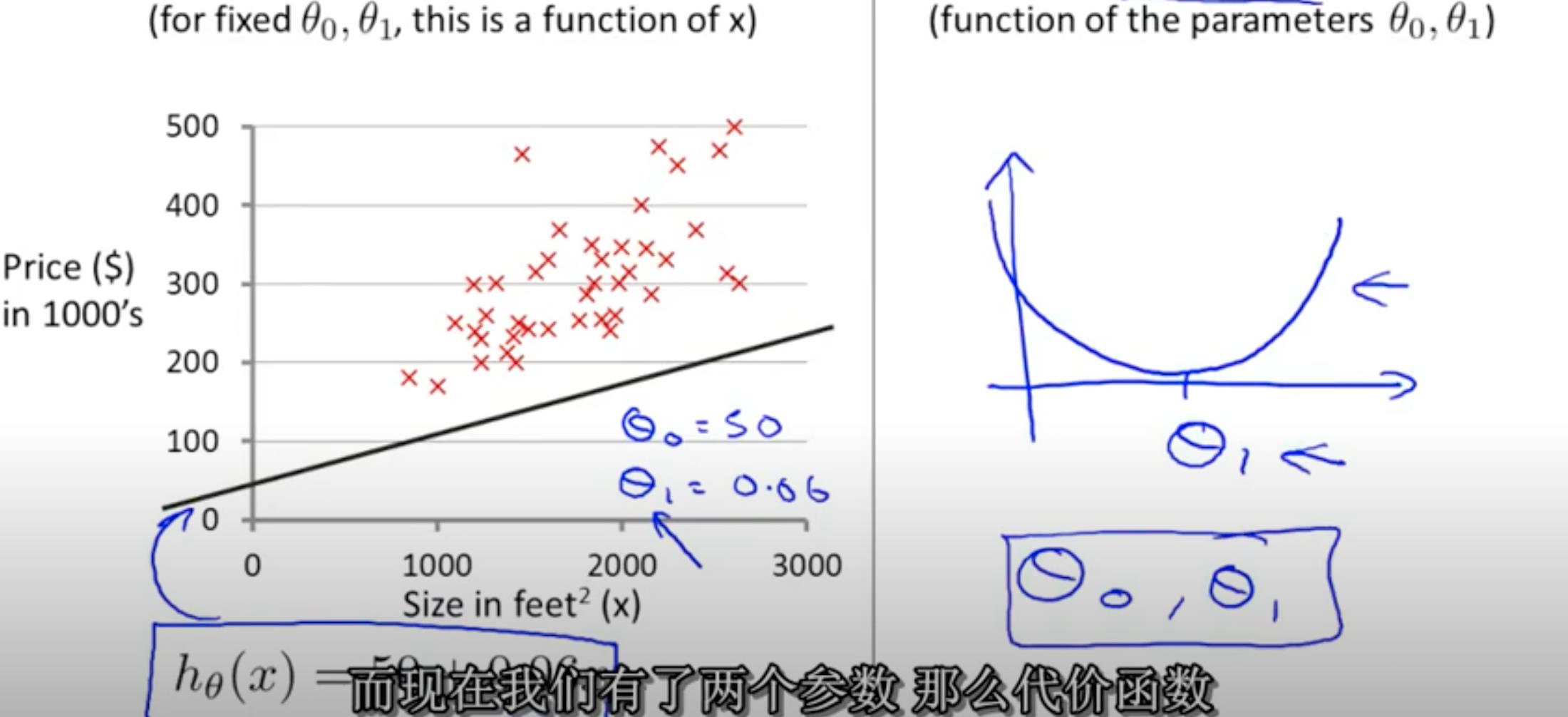

4. 第9课 Cost function intuition II - Linear regression with one variable

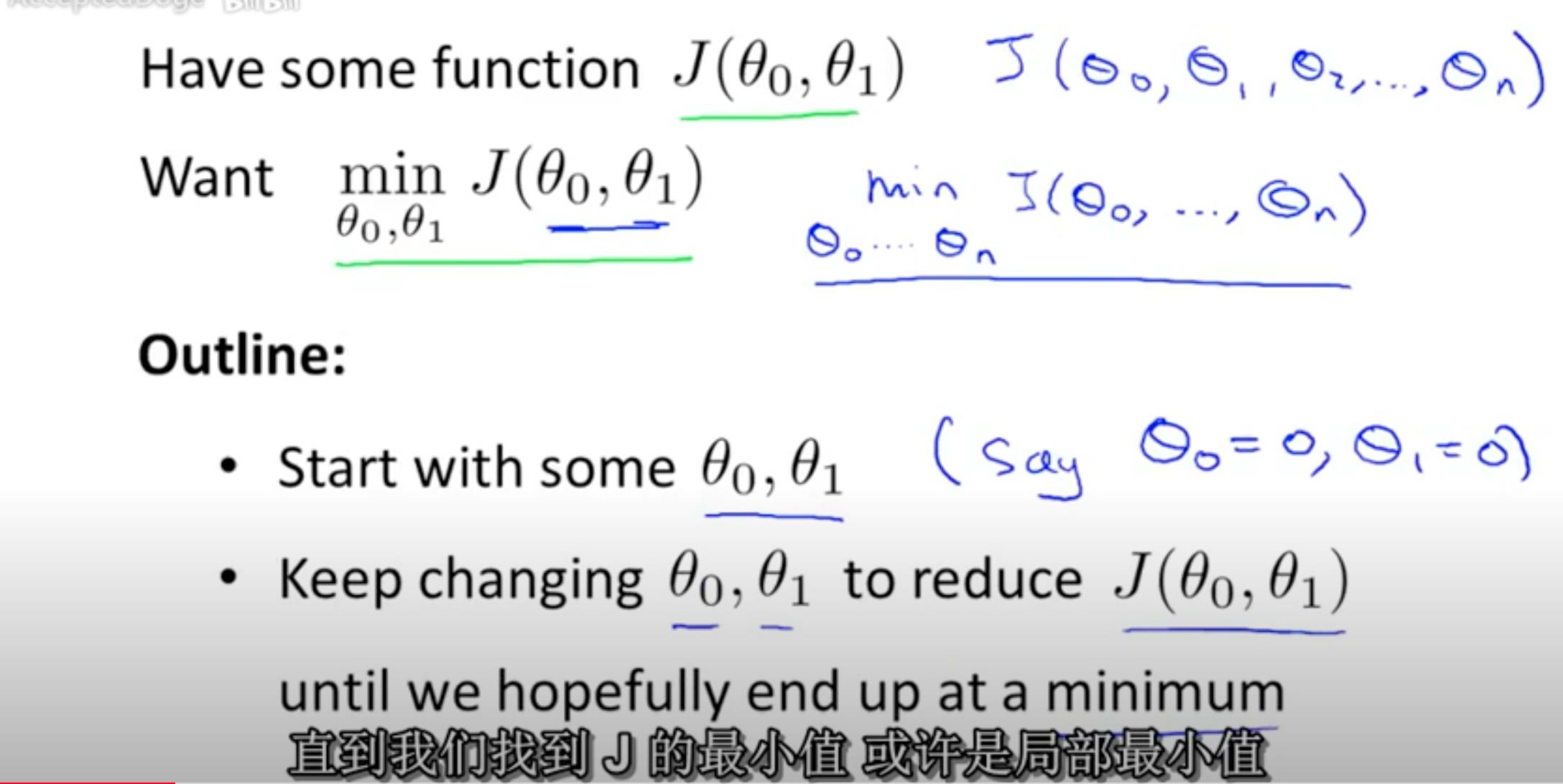

线性回归涉及到的方程和目标如下

线性回归,假设 f(x) = a * x 的能耗图如右侧所示

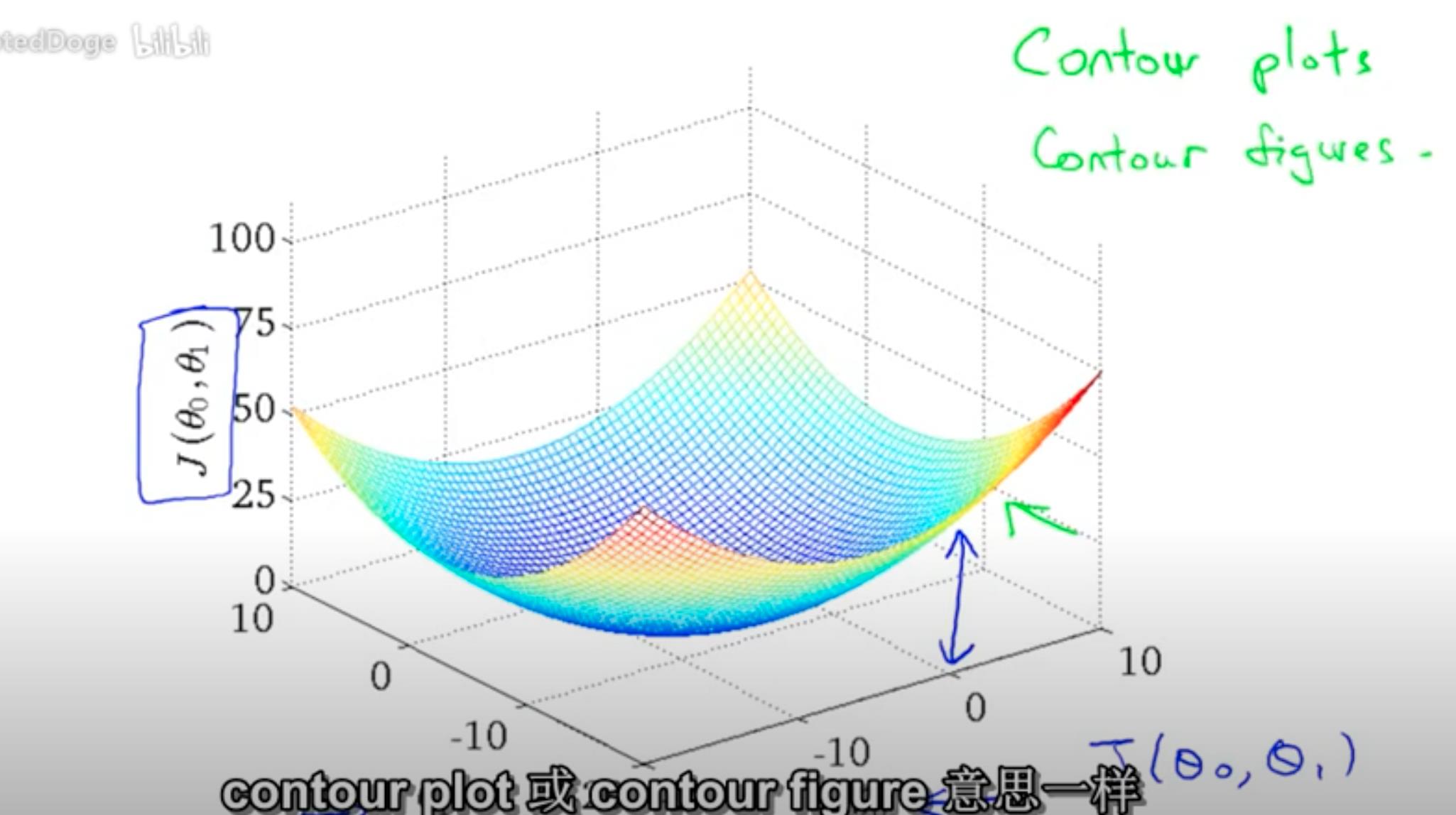

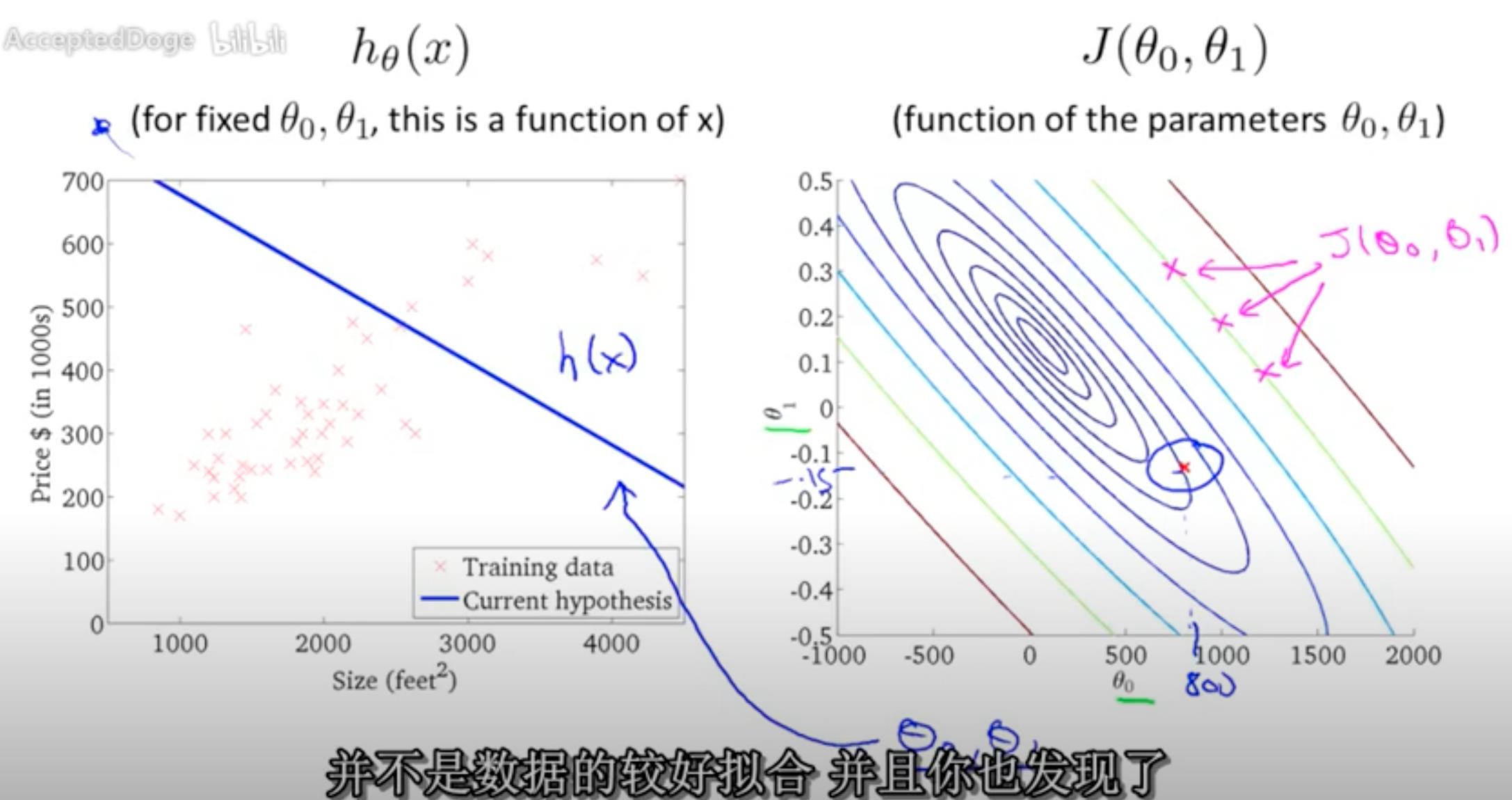

线性回归方程 h(x) = θ0 + θ1 * x , 能耗图为如下 3维弓形图

能耗的3维弓形图,每个横截面都是环形,同一个环的点能耗是相同的。

5 第10课 Gradient descent 阶梯式下降算法 - Linear regression with one variable

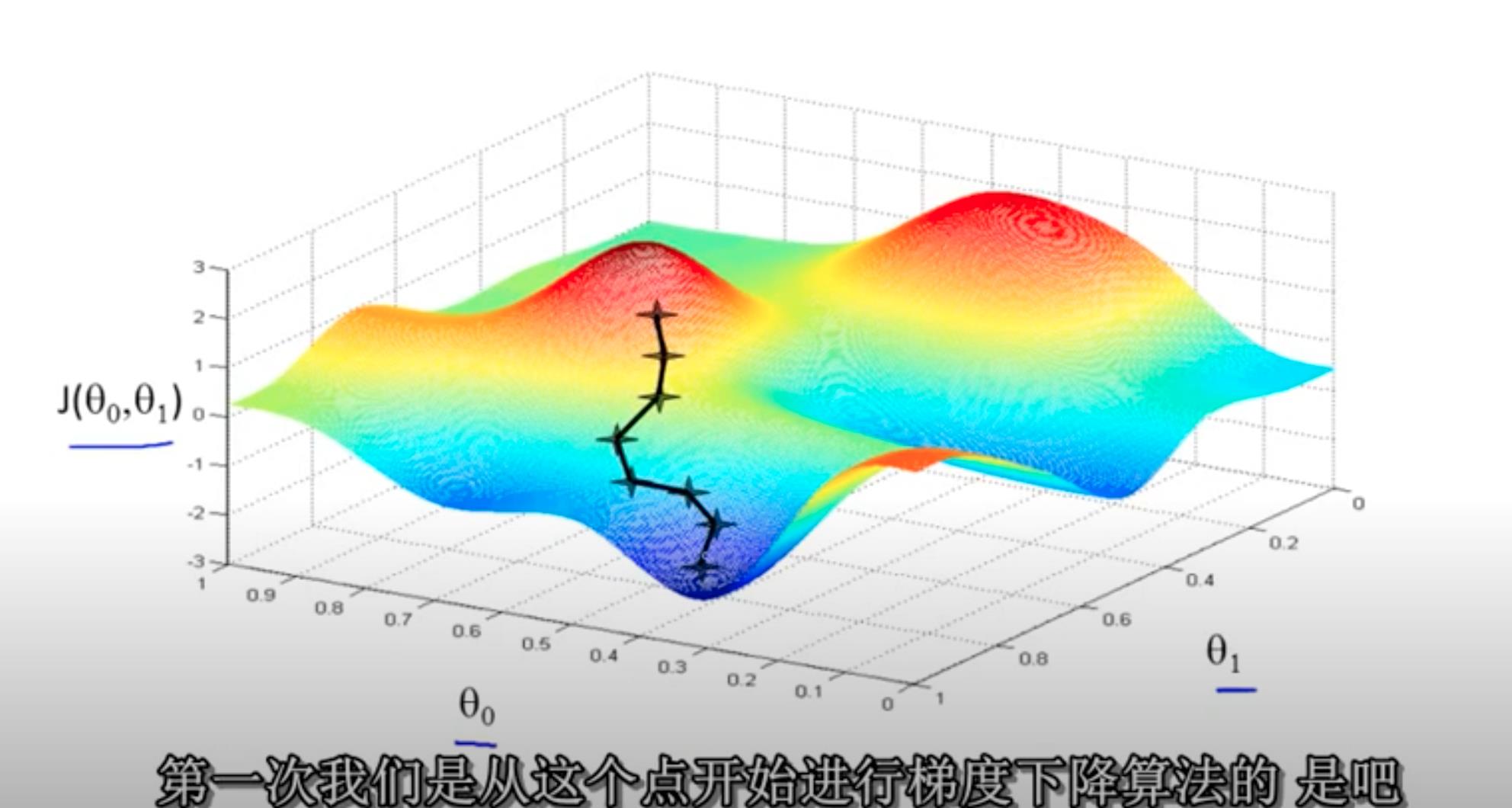

阶梯式下降算法的流程:

- 先初始化一个点;

- 逐步缩小能耗值

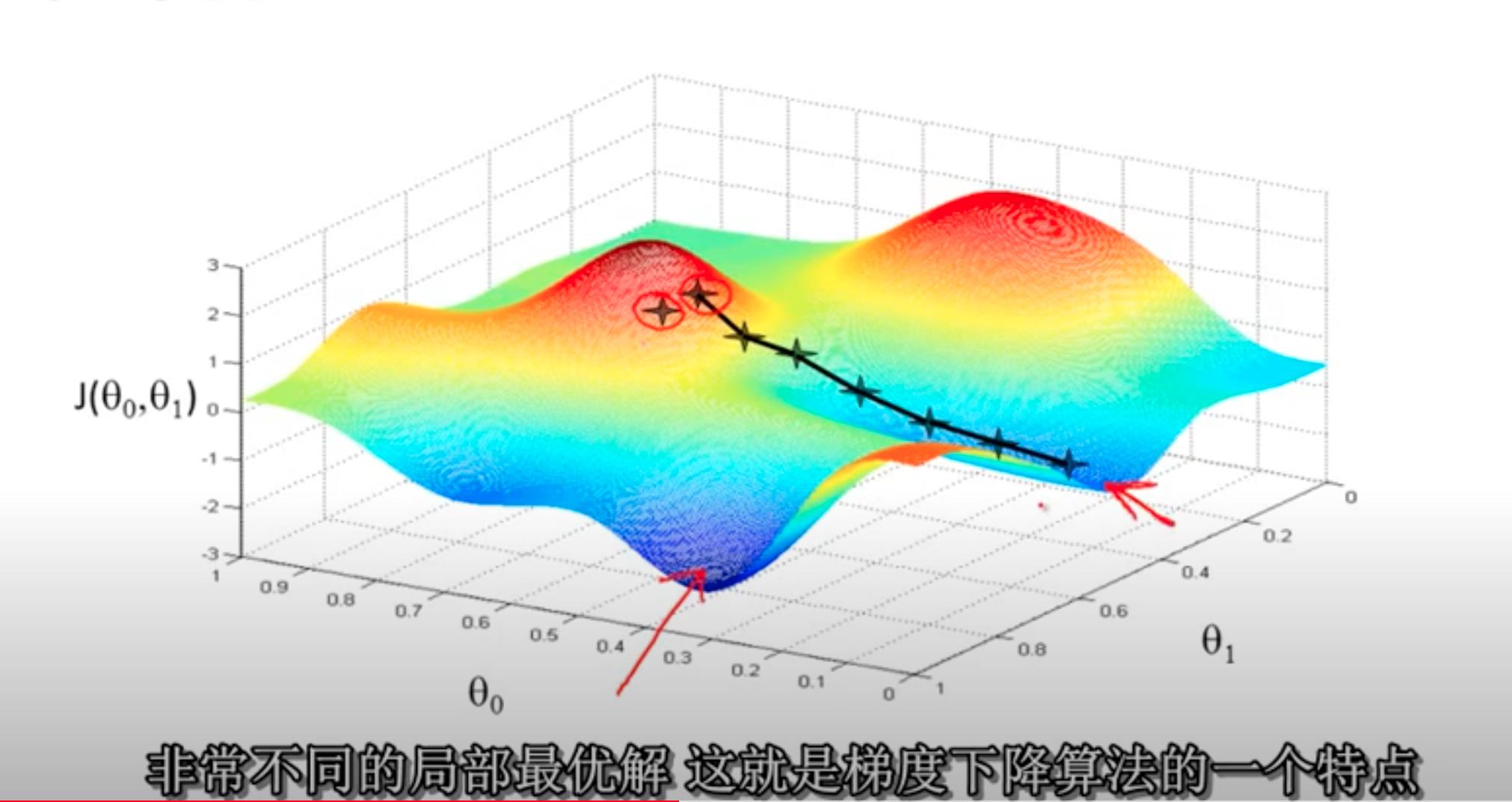

J(θ0 + θ1), 直到最小; - 注意选取的初始值不同,得到的最小值也不一定相同,类似于贪心算法。(下面会有两个初始值的距离)

初始值1的结果:

初始值2的结果

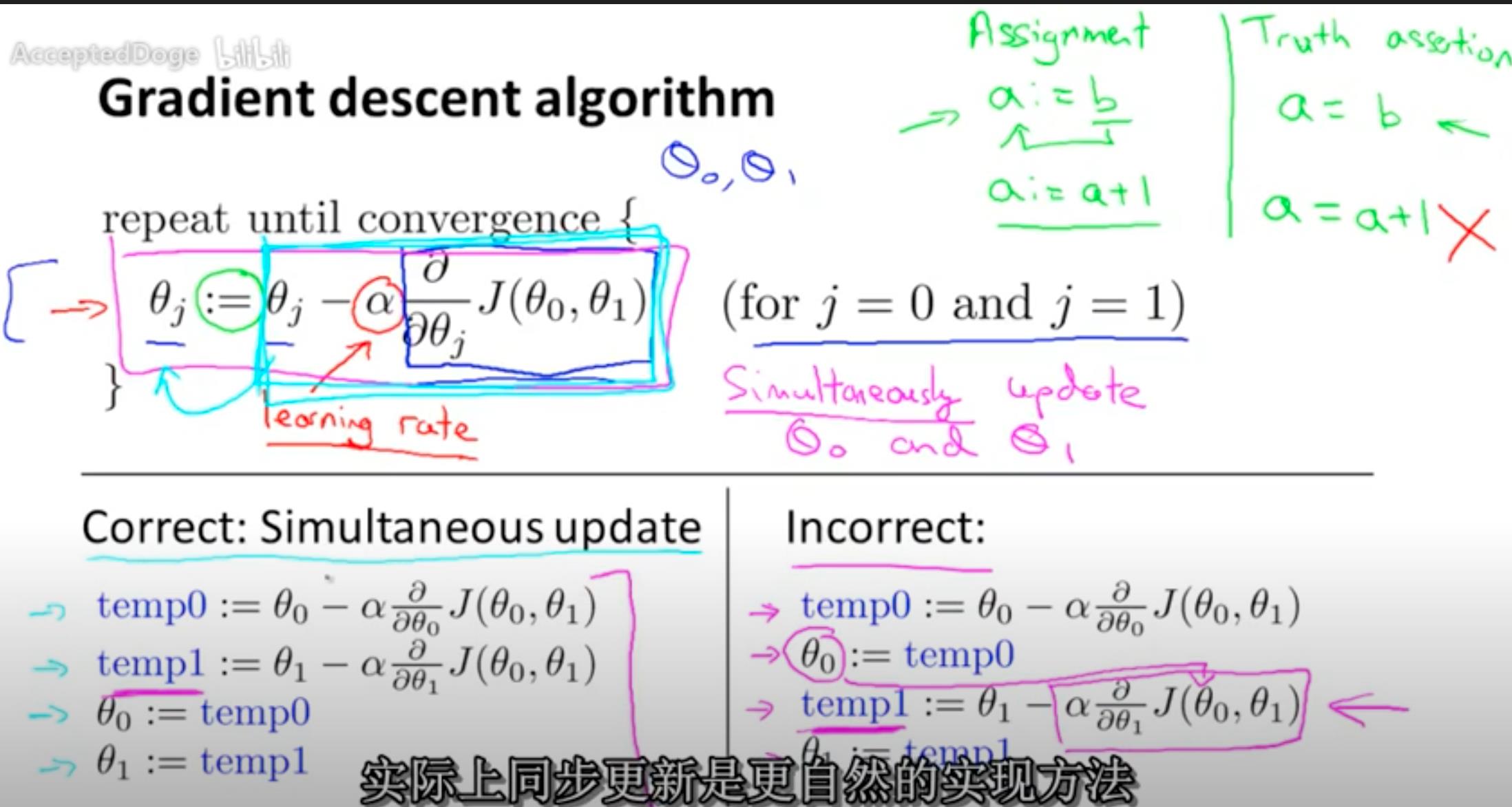

同步更新算法才是正确的:Correct: Simultaneous update

alpha 表示learning rate,也就是学习的速率。速率决定是快速拟合,还是慢速拟合(找到最佳值)。

以上是关于机器学习 Machine Learning- 吴恩达Andrew Ng 第6~10课总结的主要内容,如果未能解决你的问题,请参考以下文章