大数据课后作业:从零搭建canal实时采集数据

Posted ChinaManor

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了大数据课后作业:从零搭建canal实时采集数据相关的知识,希望对你有一定的参考价值。

文章目录

大数据课后作业:从零搭建canal实时采集数据

作业:从零搭建canal实时采集数据

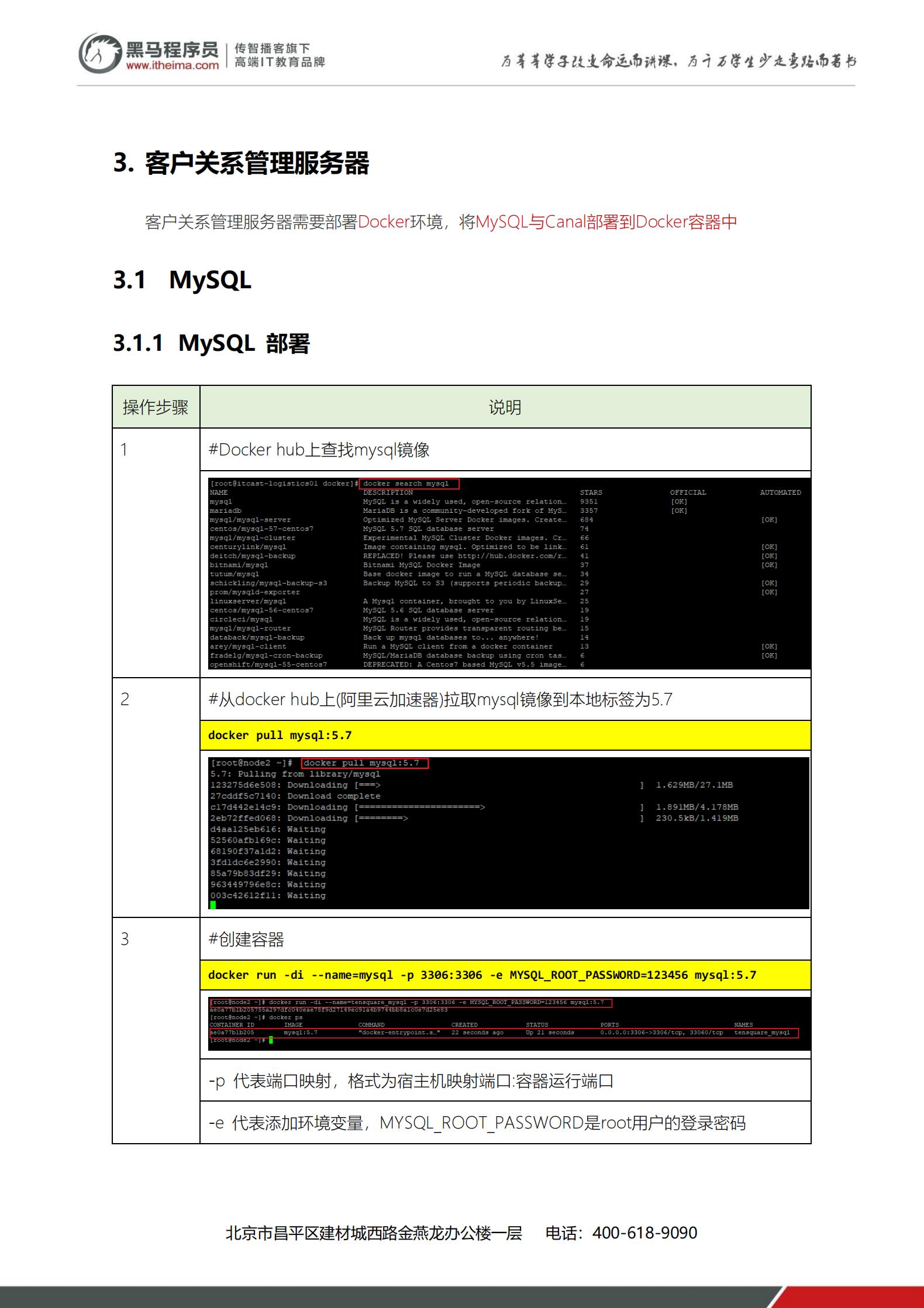

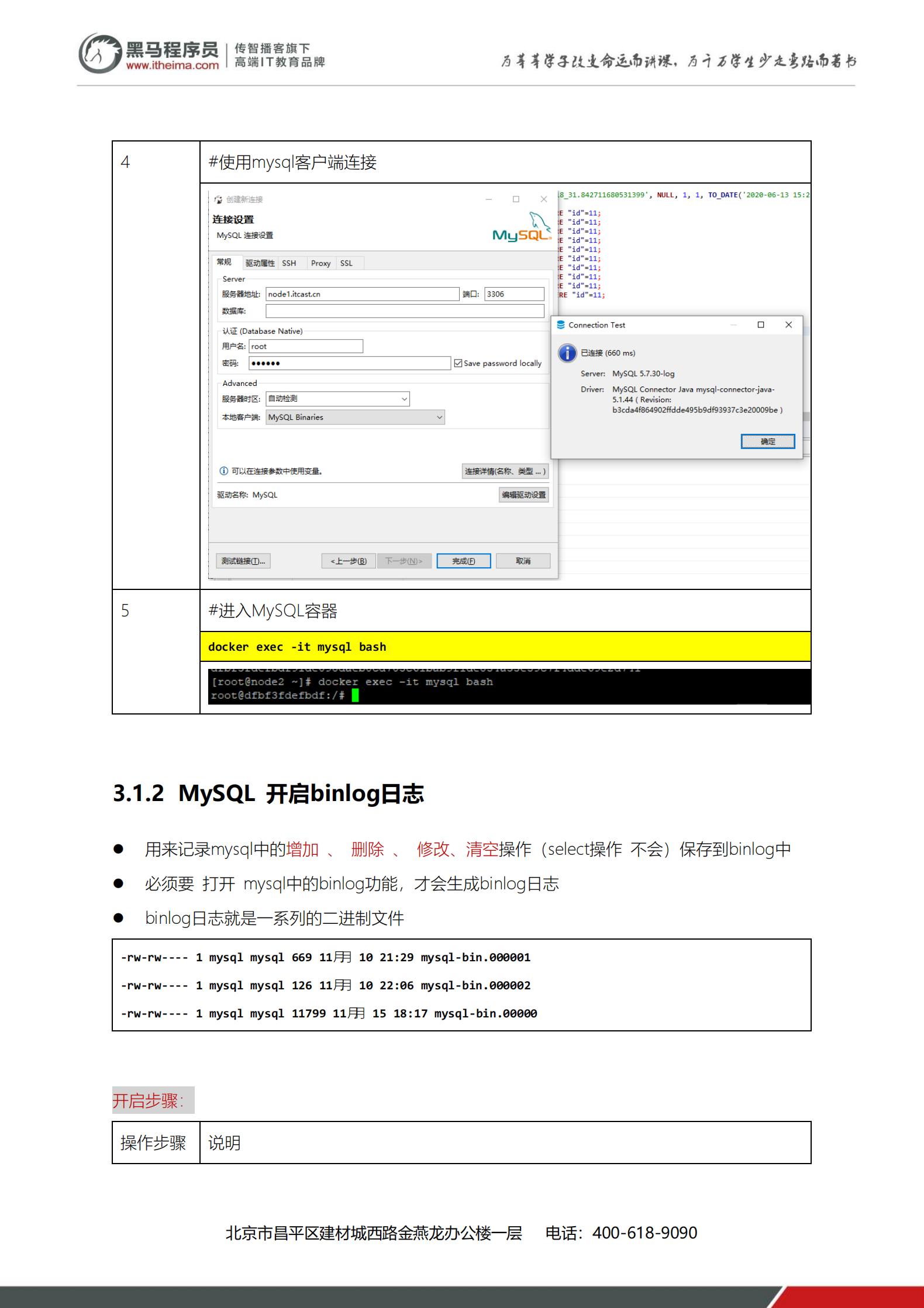

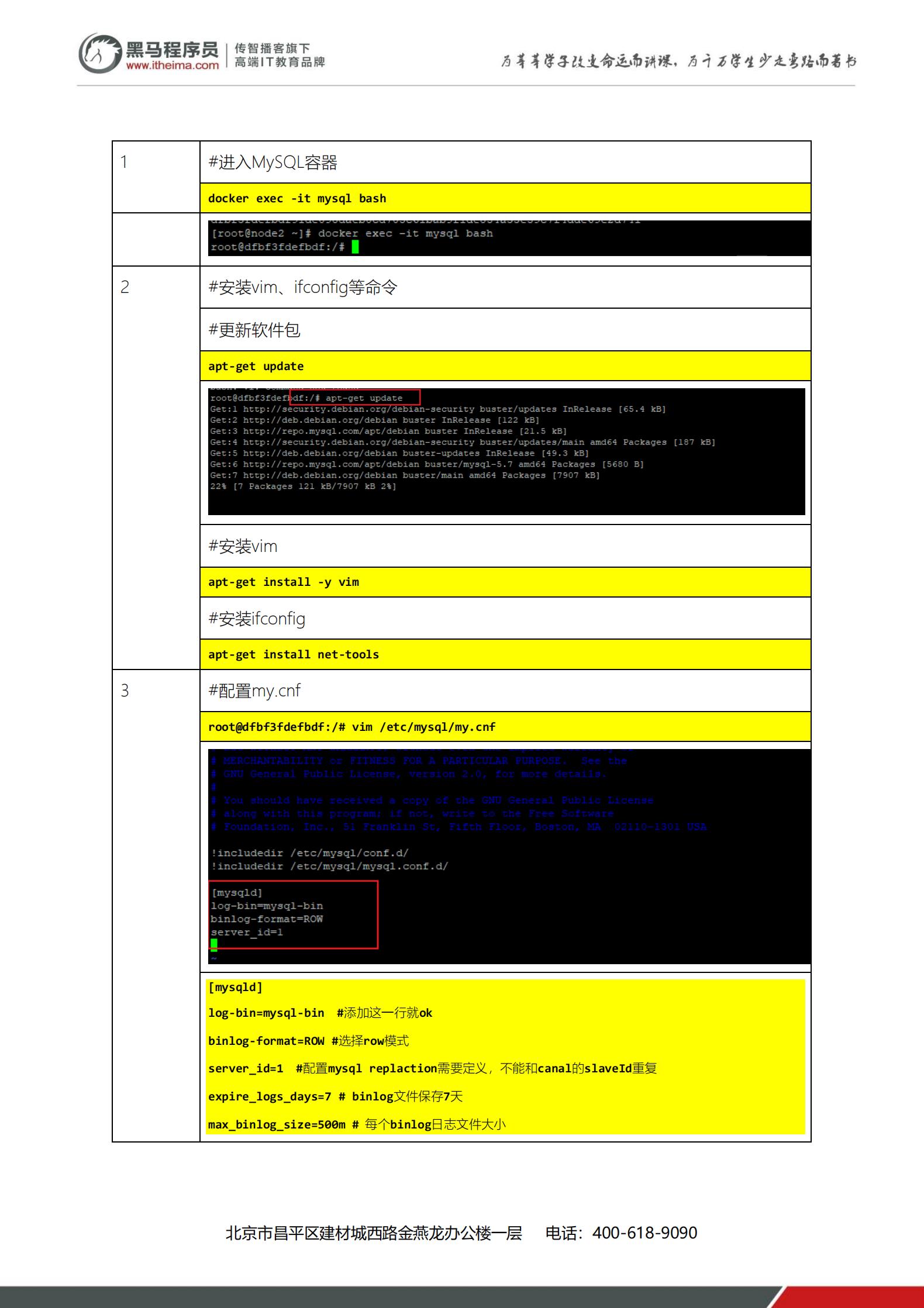

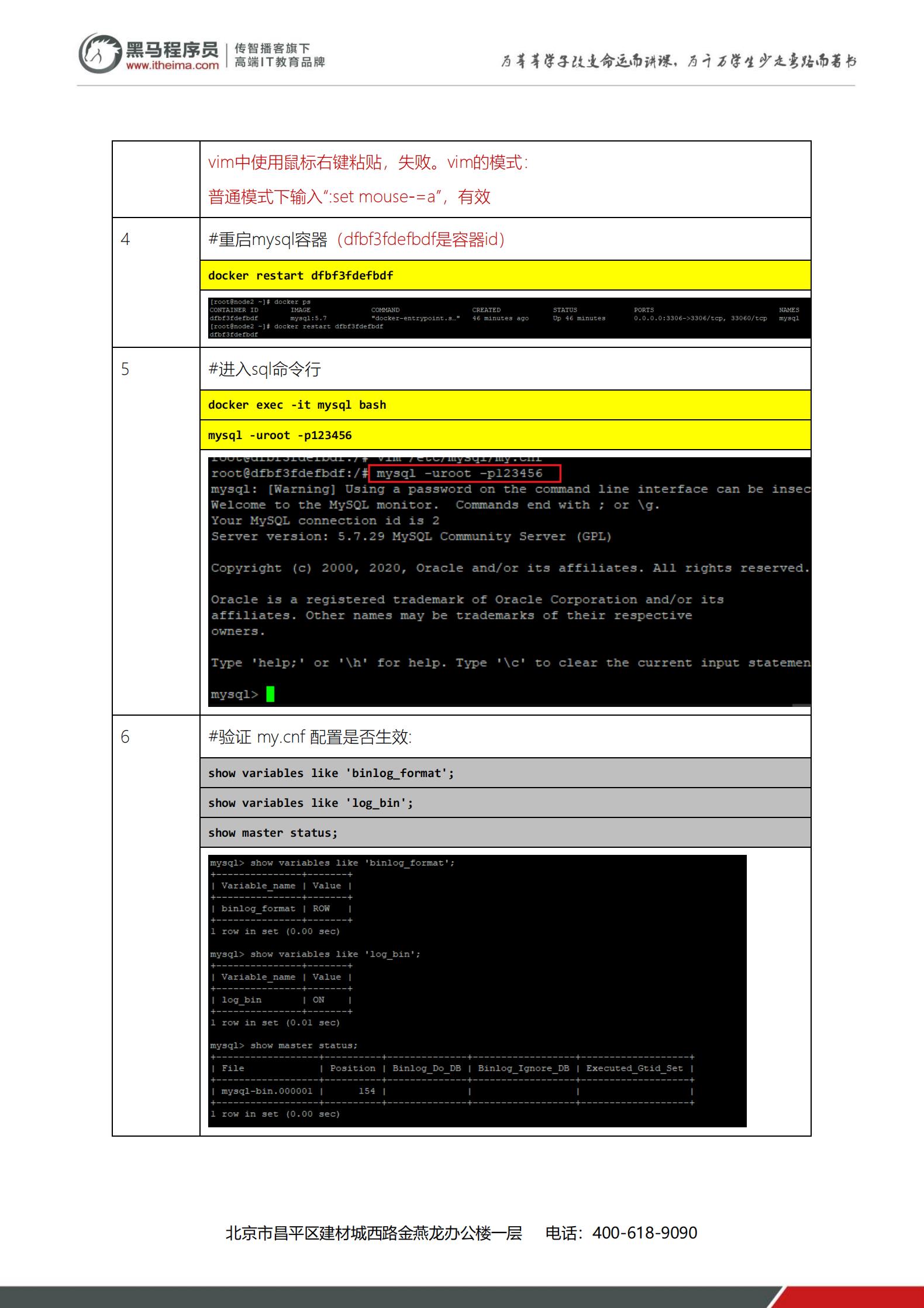

1、Linu操作系统安装5.6、5.7、8.x也行

安装MSQL数据库

2、采用 Docker容器部署安装Cana1,并且配置

Docker容器部署 Canal

3、搭建 Kafka单机版

JDK、 Zookeeper和 Kafka

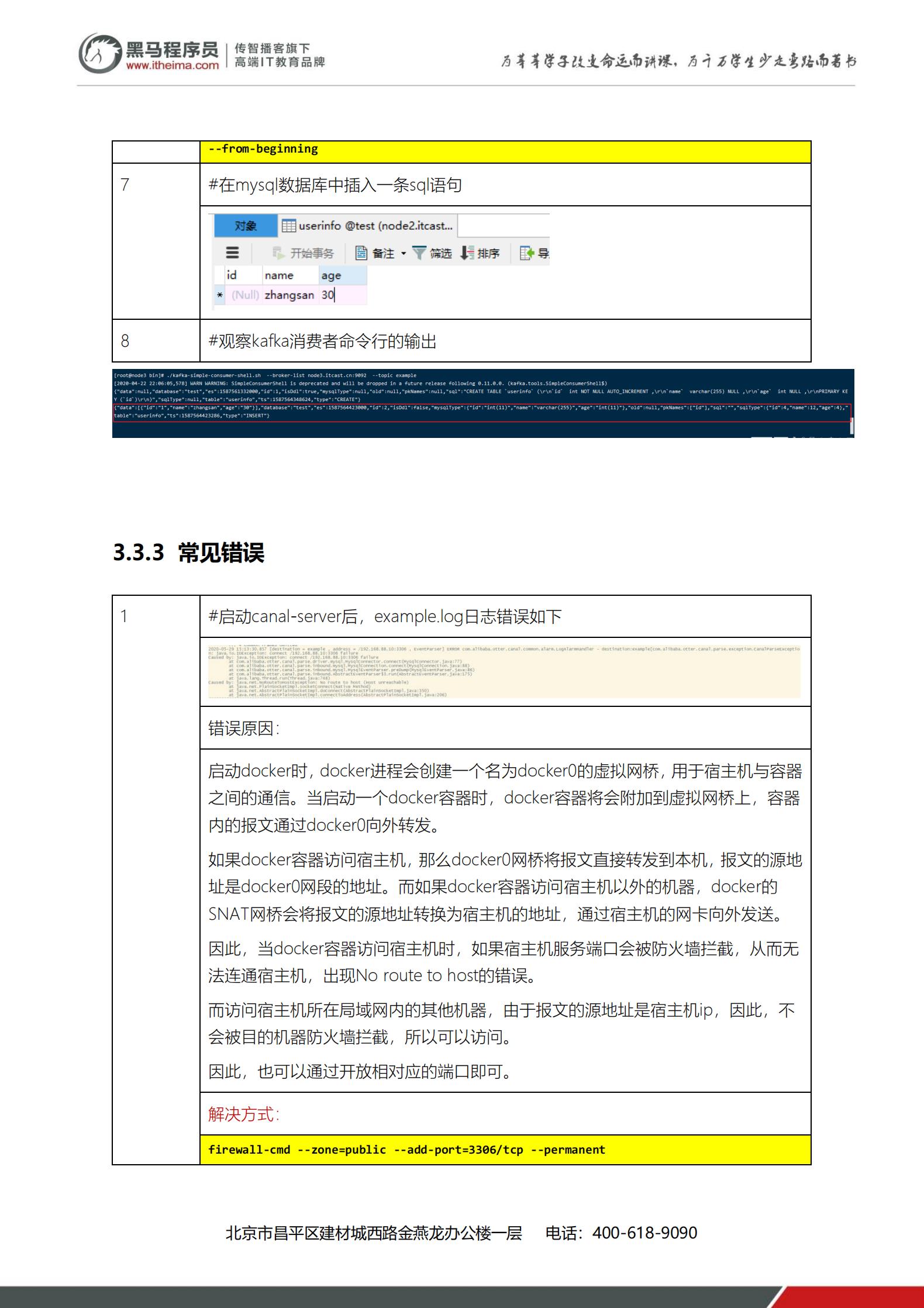

4、联动测试

向MSQL表中写入数据,Cana实时采集到, Kafka分布式消息队列

安装MSQL数据库

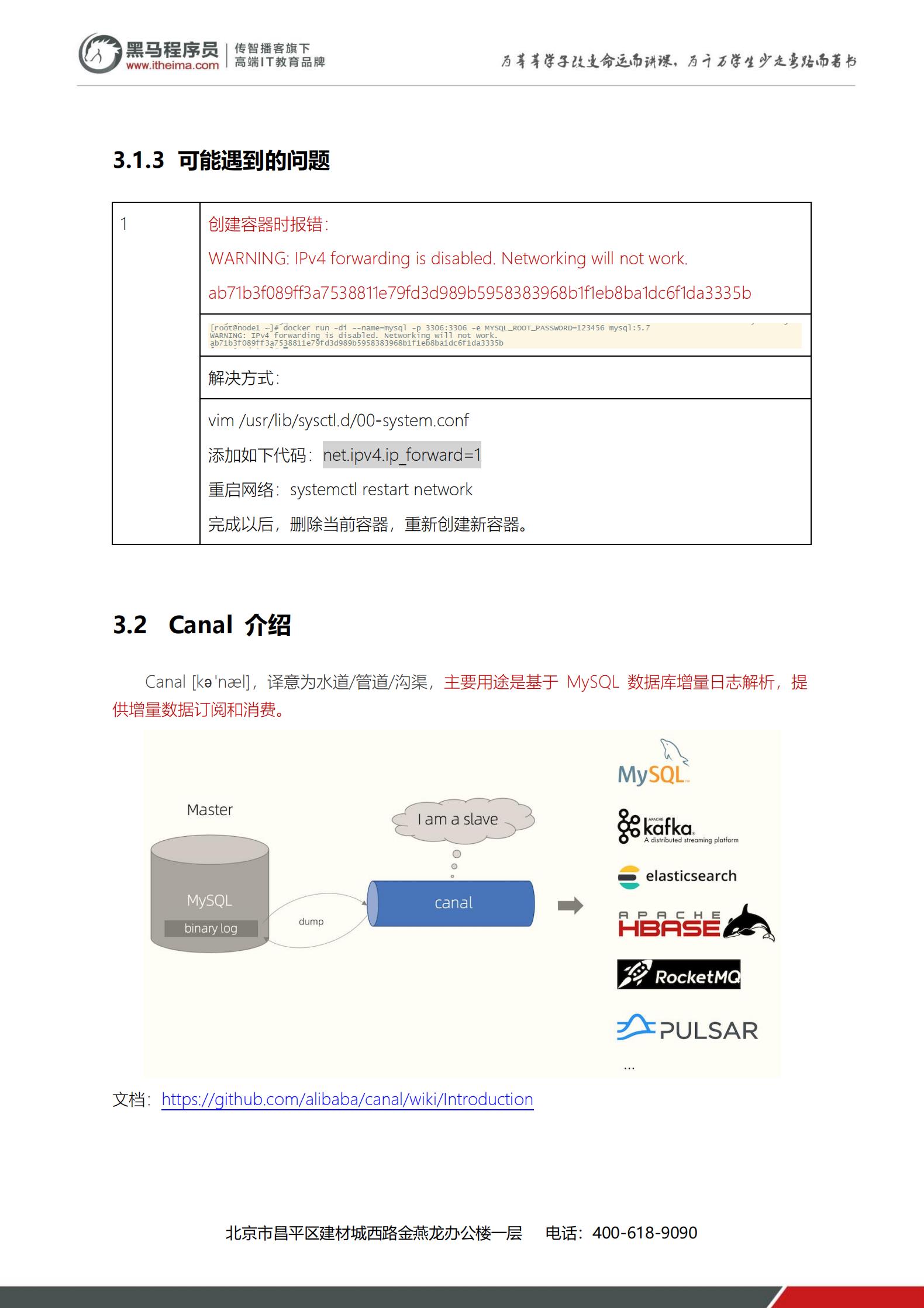

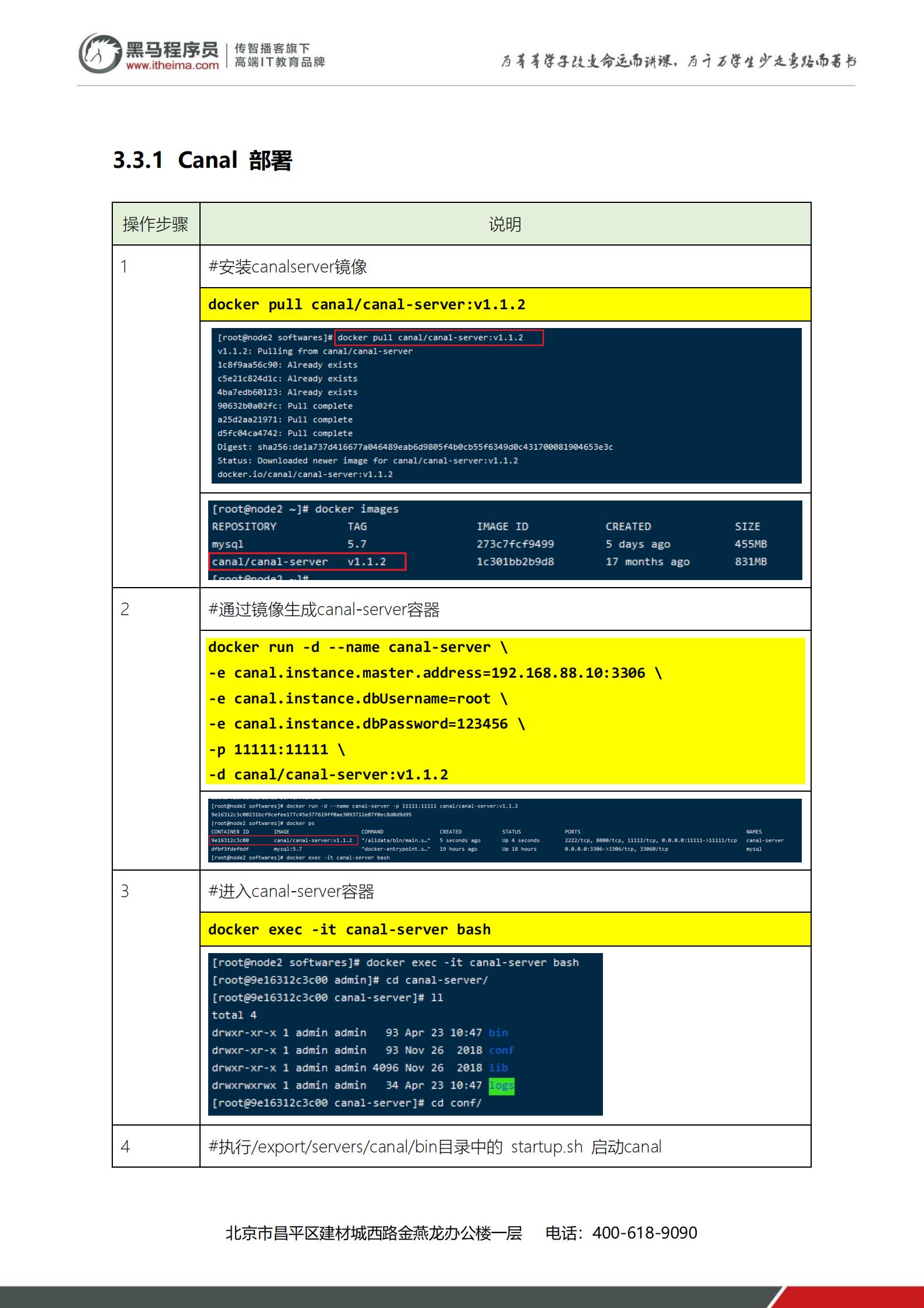

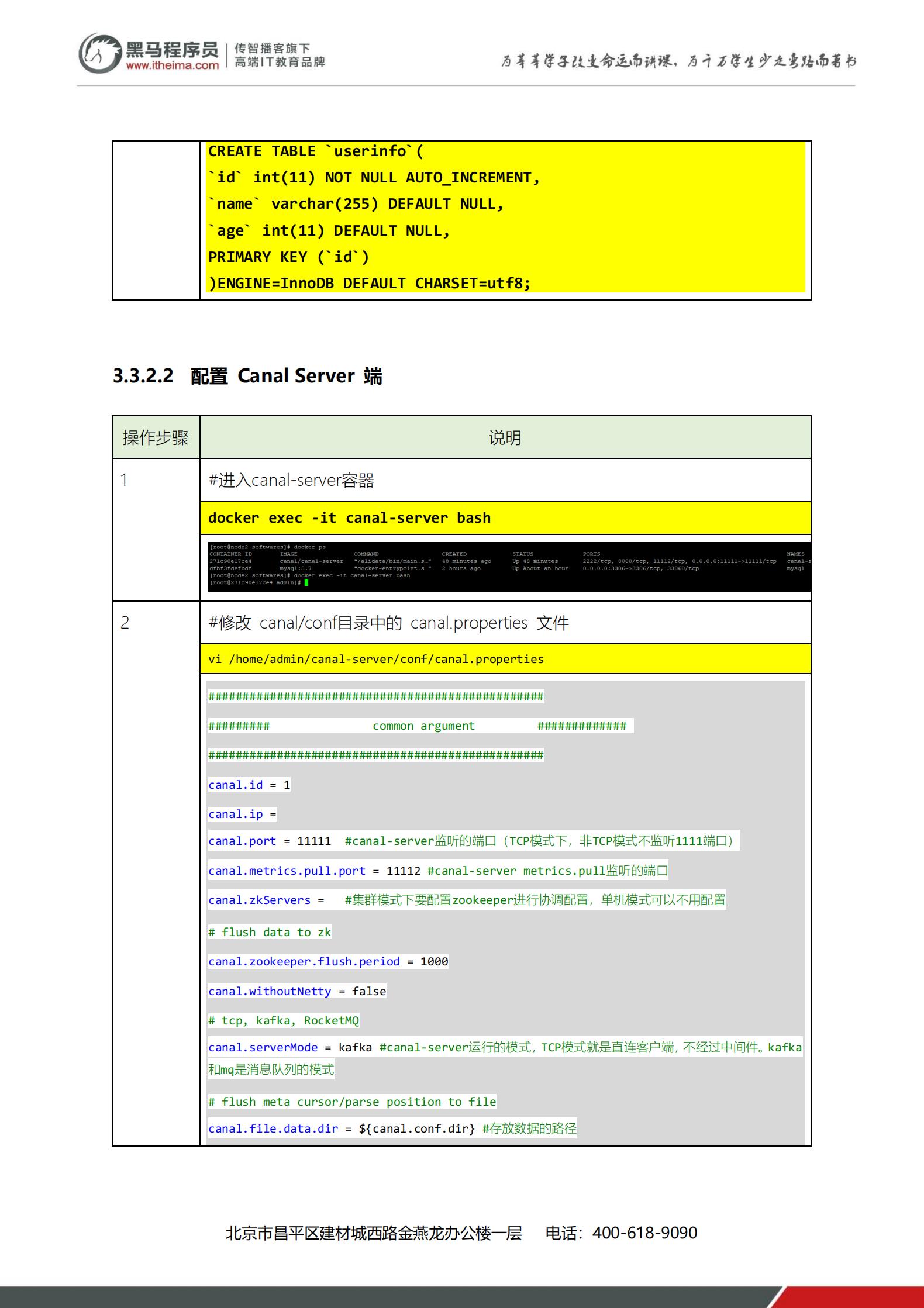

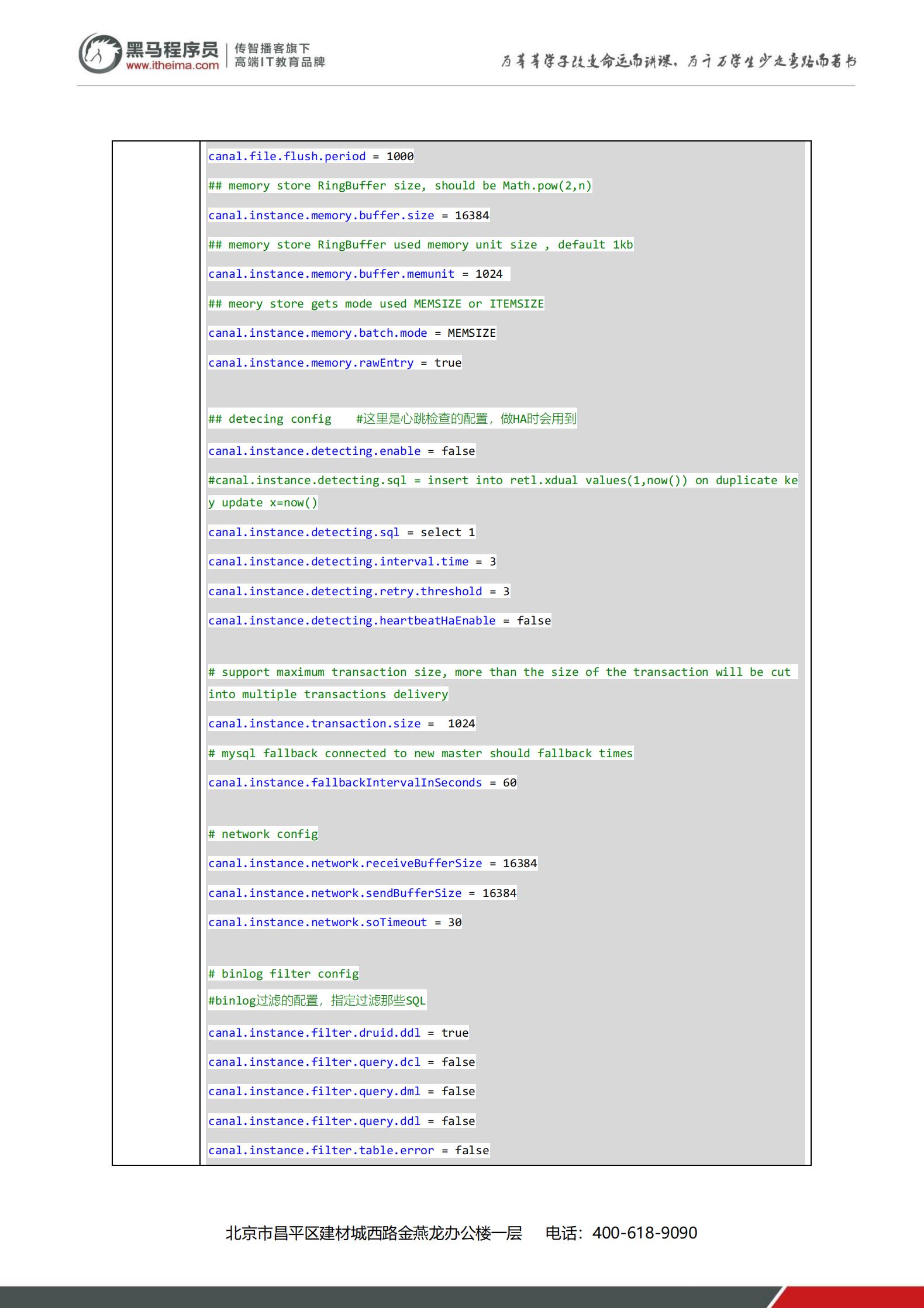

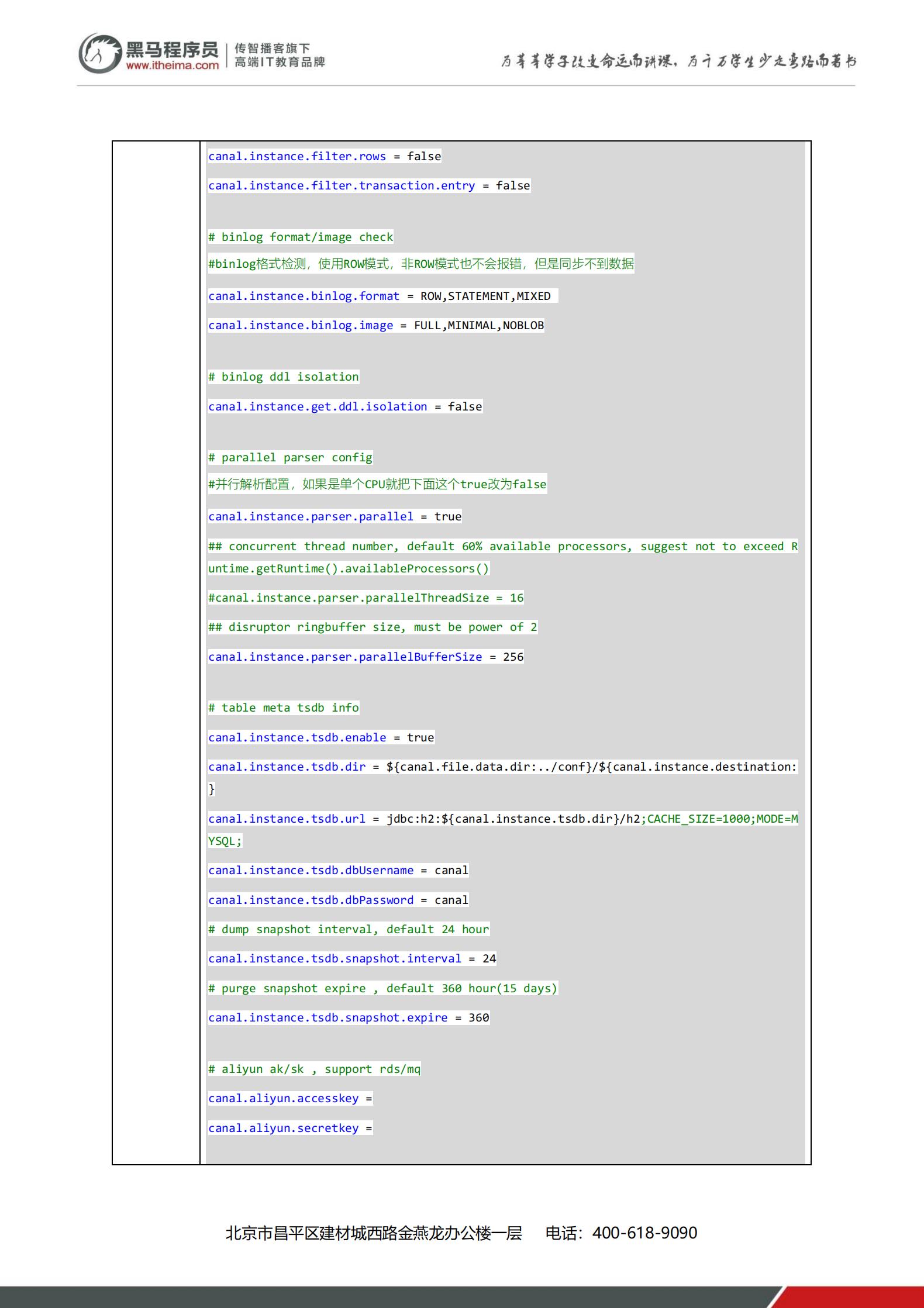

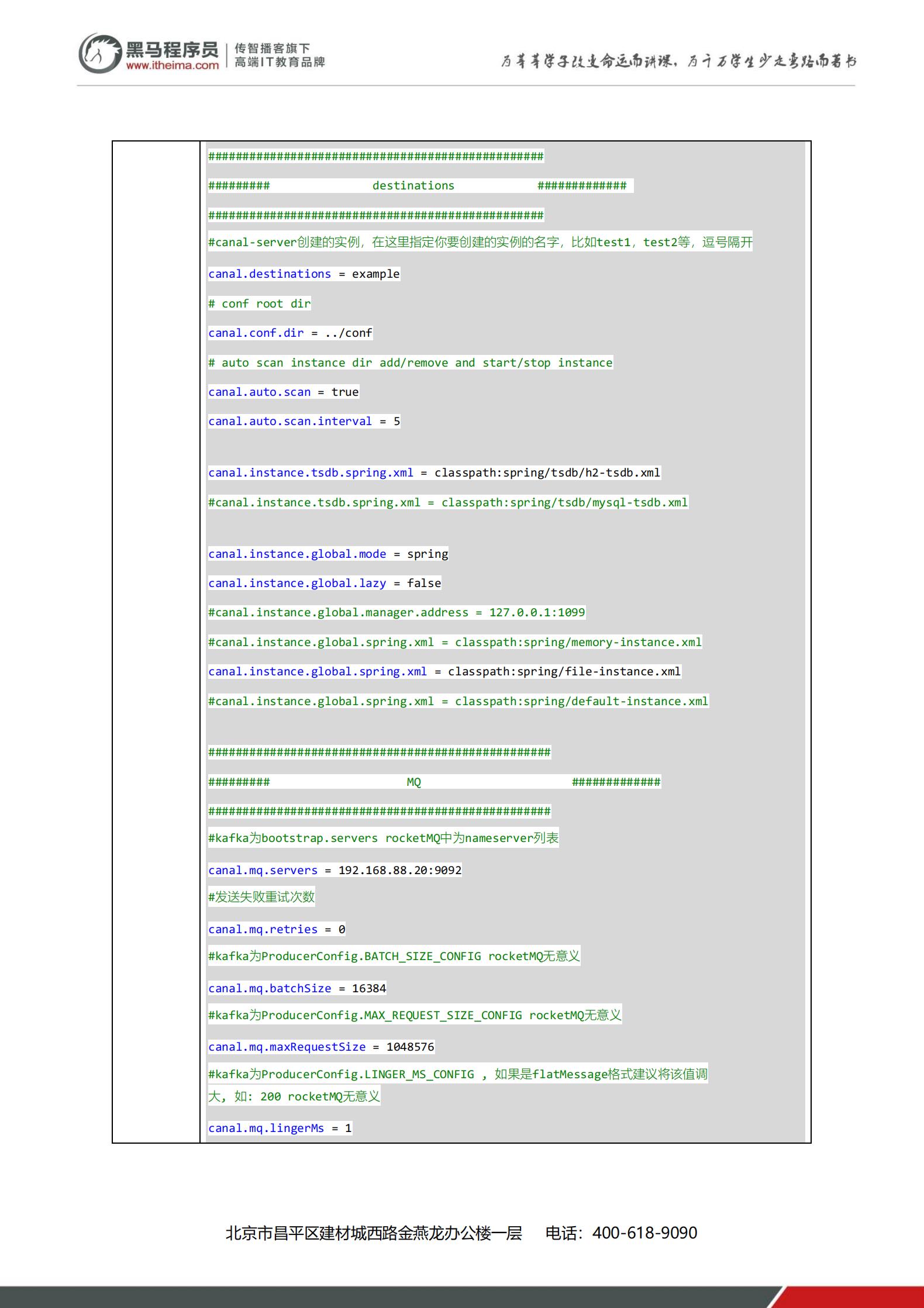

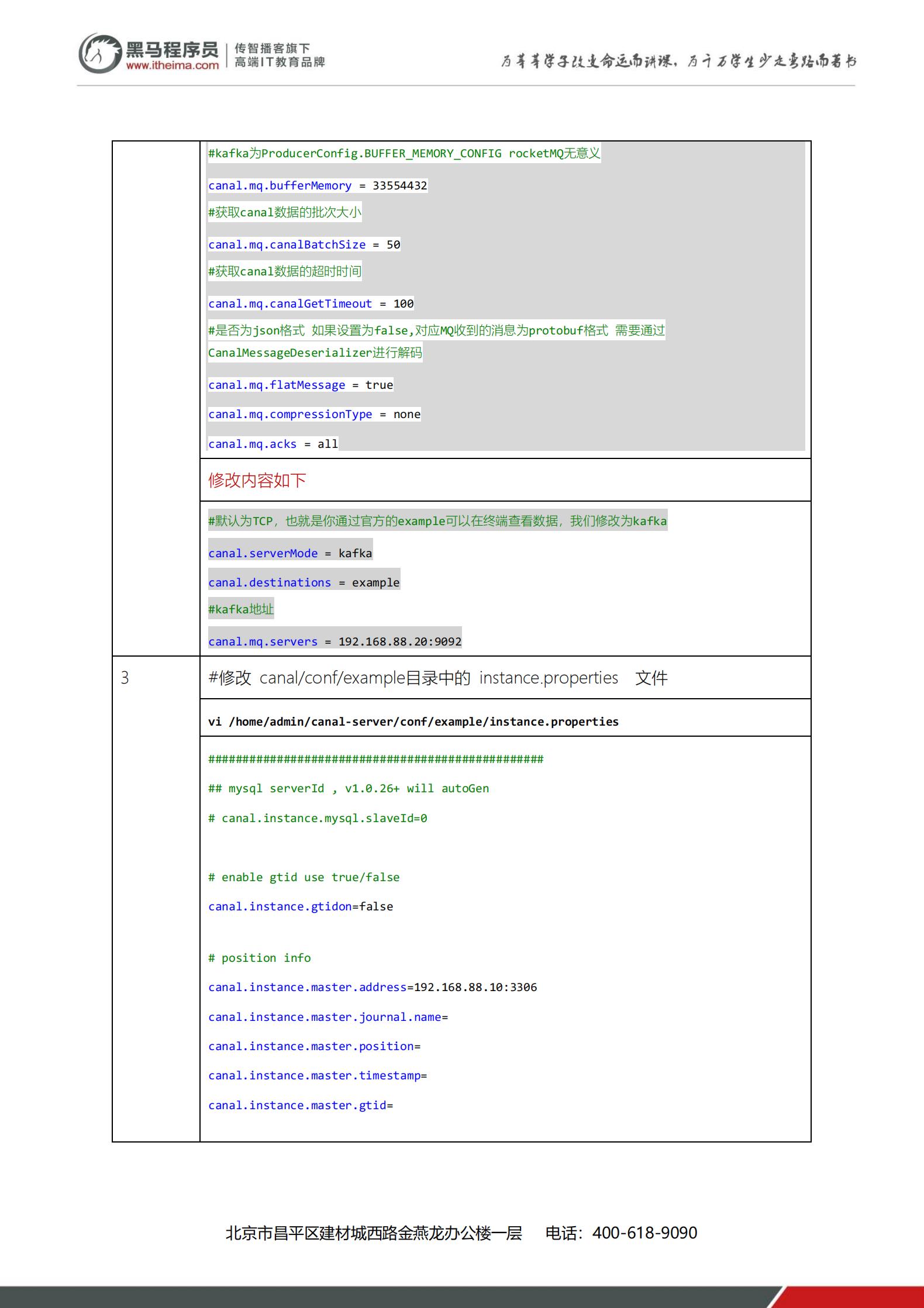

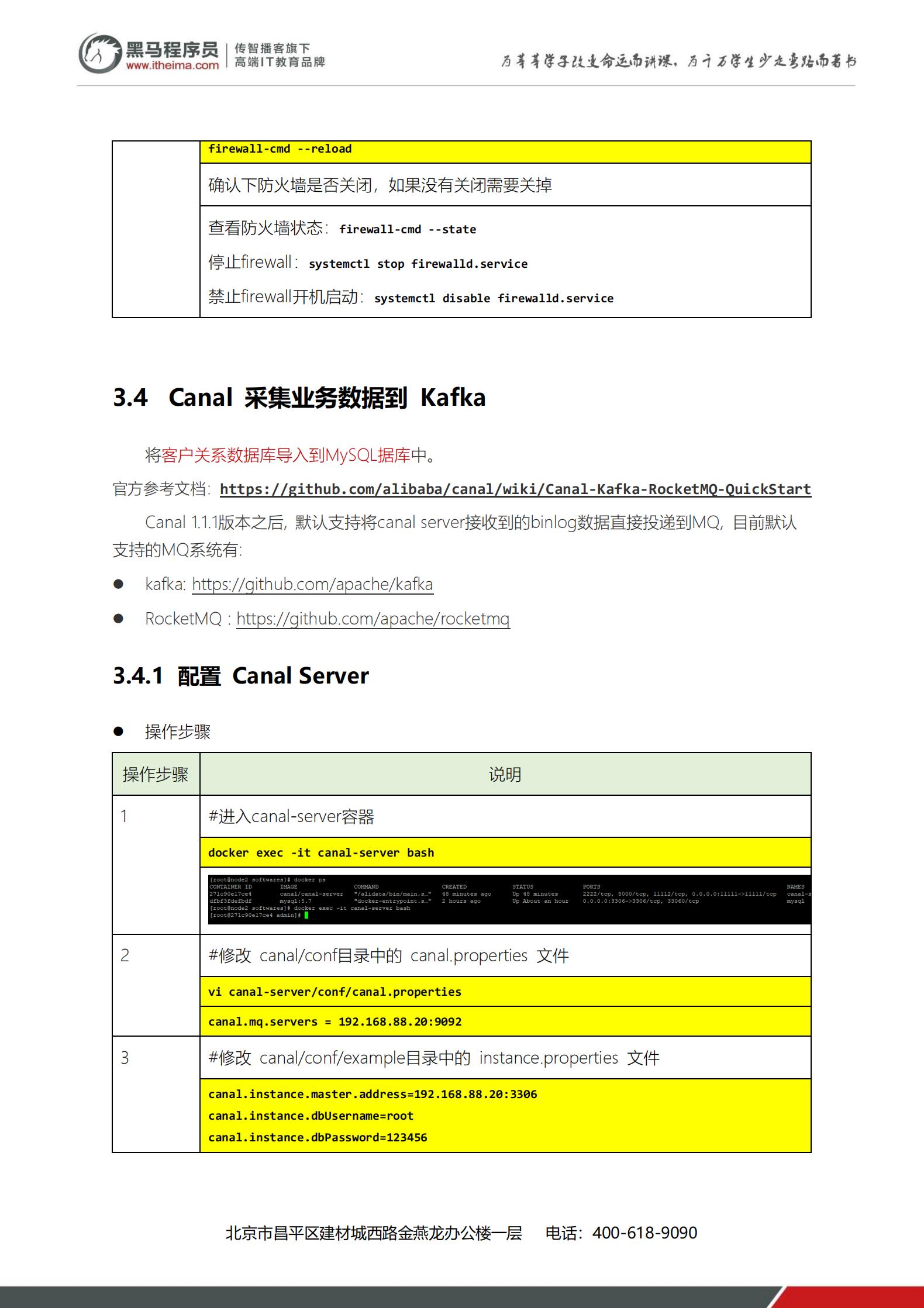

Docker容器部署 Canal

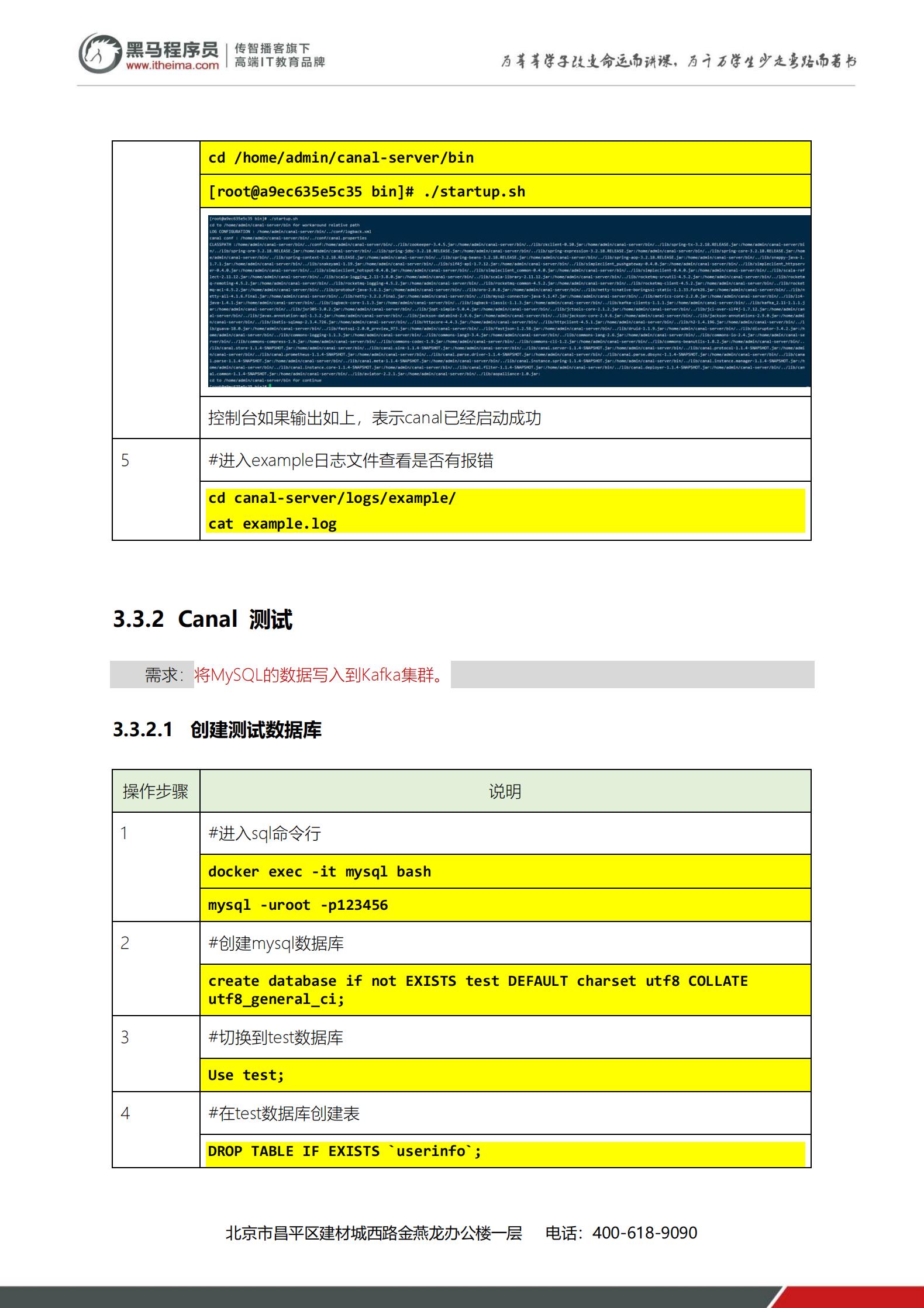

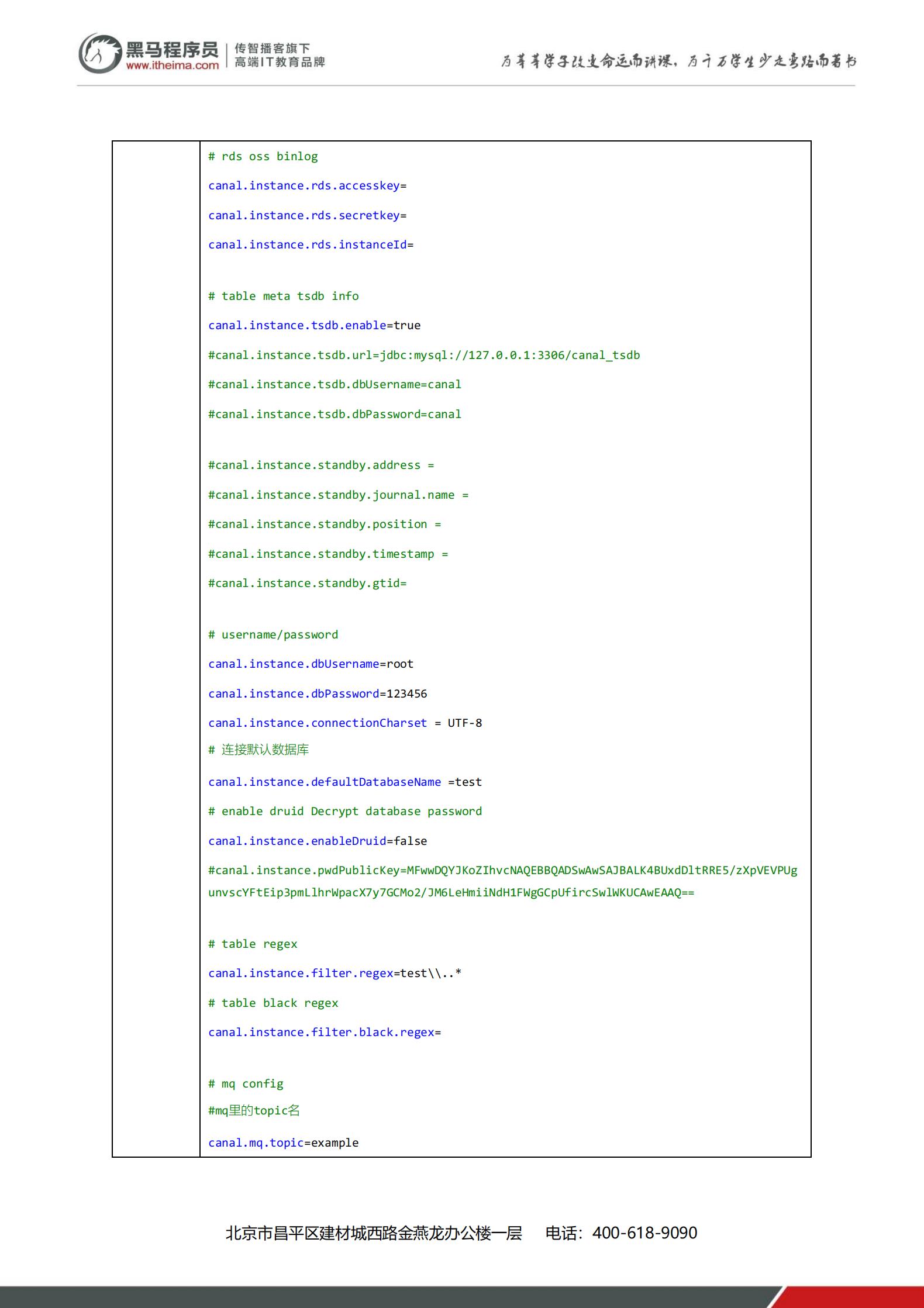

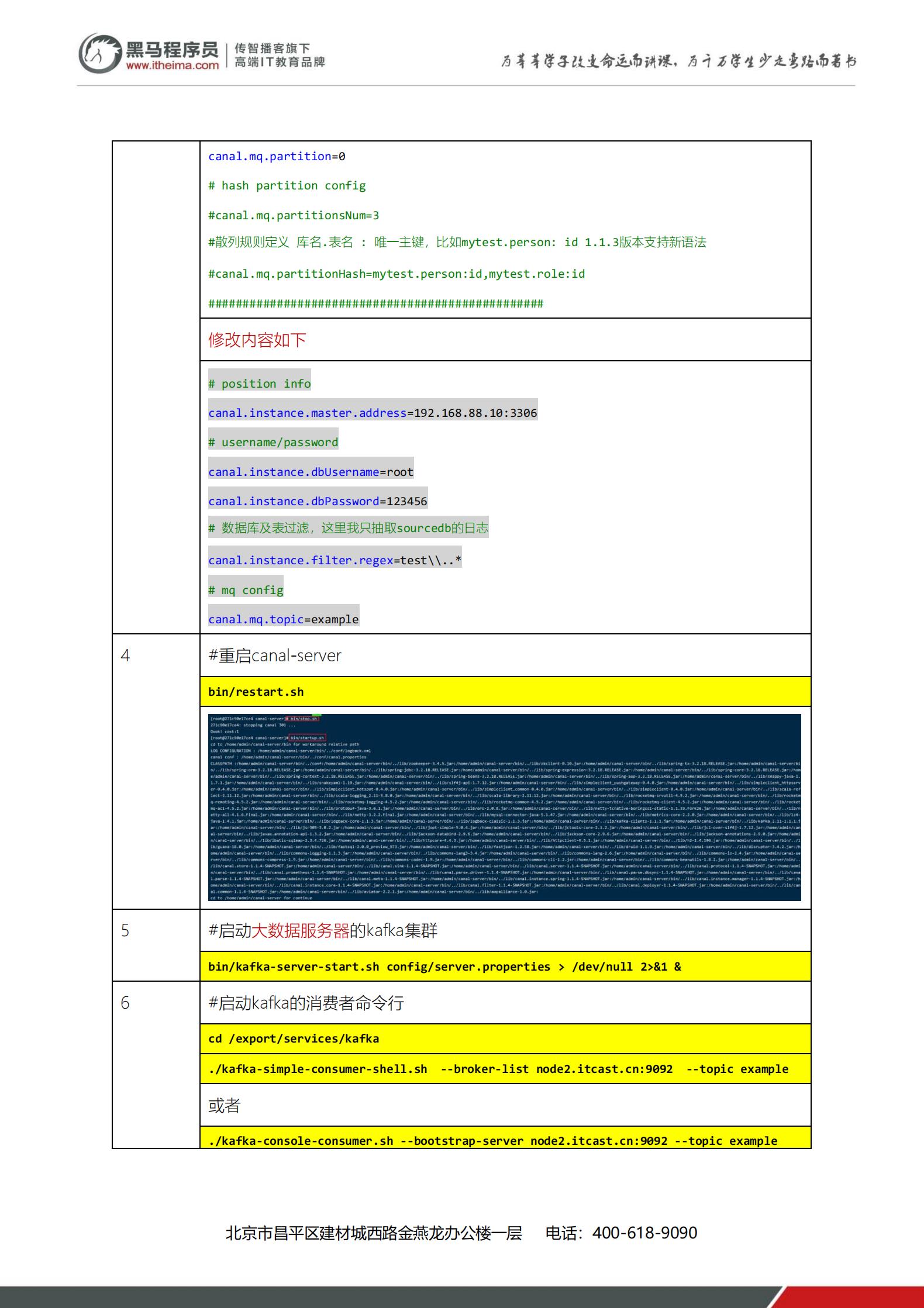

mysql采集数据到Canal

搭建Kafka集群

-

将Kafka的安装包上传到虚拟机,并解压

cd /export/software/

tar -xvzf kafka_2.12-2.4.1.tgz -C …/server/

cd /export/server/kafka_2.12-2.4.1/ -

修改 server.properties

cd /export/server/kafka_2.12-2.4.1/config

vim server.properties

指定broker的id

broker.id=0

指定Kafka数据的位置

log.dirs=/export/server/kafka_2.12-2.4.1/data

配置zk的三个节点

zookeeper.connect=node1.itcast.cn:2181,node2.itcast.cn:2181,node3.itcast.cn:2181

3.将安装好的kafka复制到另外两台服务器

cd /export/server

scp -r kafka_2.12-2.4.1/ node2.itcast.cn:

P

W

D

s

c

p

−

r

k

a

f

k

a

2

.

12

−

2.4.1

/

n

o

d

e

3.

i

t

c

a

s

t

.

c

n

:

PWD scp -r kafka_2.12-2.4.1/ node3.itcast.cn:

PWDscp−rkafka2.12−2.4.1/node3.itcast.cn:PWD

修改另外两个节点的broker.id分别为1和2

---------node2.itcast.cn--------------

cd /export/server/kafka_2.12-2.4.1/config

vim erver.properties

broker.id=1

--------node3.itcast.cn--------------

cd /export/server/kafka_2.12-2.4.1/config

vim server.properties

broker.id=2

4.配置KAFKA_HOME环境变量

vim /etc/profile

export KAFKA_HOME=/export/server/kafka_2.12-2.4.1

export PATH=:

P

A

T

H

:

PATH:

PATH:{KAFKA_HOME}

分发到各个节点

scp /etc/profile node2.itcast.cn:

P

W

D

s

c

p

/

e

t

c

/

p

r

o

f

i

l

e

n

o

d

e

3.

i

t

c

a

s

t

.

c

n

:

PWD scp /etc/profile node3.itcast.cn:

PWDscp/etc/profilenode3.itcast.cn:PWD

每个节点加载环境变量

source /etc/profile

5.启动服务器

启动ZooKeeper

nohup bin/zookeeper-server-start.sh config/zookeeper.properties &

启动Kafka

cd /export/server/kafka_2.12-2.4.1

nohup bin/kafka-server-start.sh config/server.properties &

测试Kafka集群是否启动成功

bin/kafka-topics.sh --bootstrap-server node1.itcast.cn:9092 --list

生产数据

bin/kafka-console-producer.sh --broker-list node1.itcast.cn:9092 --topic crm

消费数

bin/kafka-console-consumer.sh --bootstrap-server node1.itcast.cn:9092 --topic crm

以上是关于大数据课后作业:从零搭建canal实时采集数据的主要内容,如果未能解决你的问题,请参考以下文章