Stanford CoreNLP超简单安装及简单使用,句法分析及依存句法分析

Posted 猫猫头丁

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Stanford CoreNLP超简单安装及简单使用,句法分析及依存句法分析相关的知识,希望对你有一定的参考价值。

Stanford CoreNLP超简单安装及简单使用,句法分析及依存句法分析,使用jupyter notebook

今天我们来使用Stanford CoreNLP进行简单的句法分析,我使用的是jupyter notebook。网上关于Stanford CoreNLP工具的安装五花八门,大家其实完全没必要看,在jupyter notebook上面一句话就行了。

Stanford CoreNLP安装

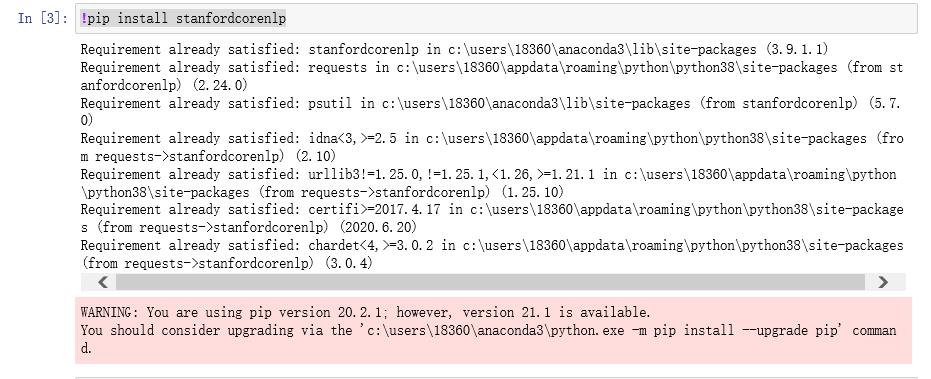

首先安装Stanford CoreNLP工具,

代码:

!pip install stanfordcorenlp

因为我之前已经运行过这句话,所以直接显示已经安装好了,大家在安装的时候可能也会出现warning,不过warning嘛,没必要管它。

因为我之前已经运行过这句话,所以直接显示已经安装好了,大家在安装的时候可能也会出现warning,不过warning嘛,没必要管它。

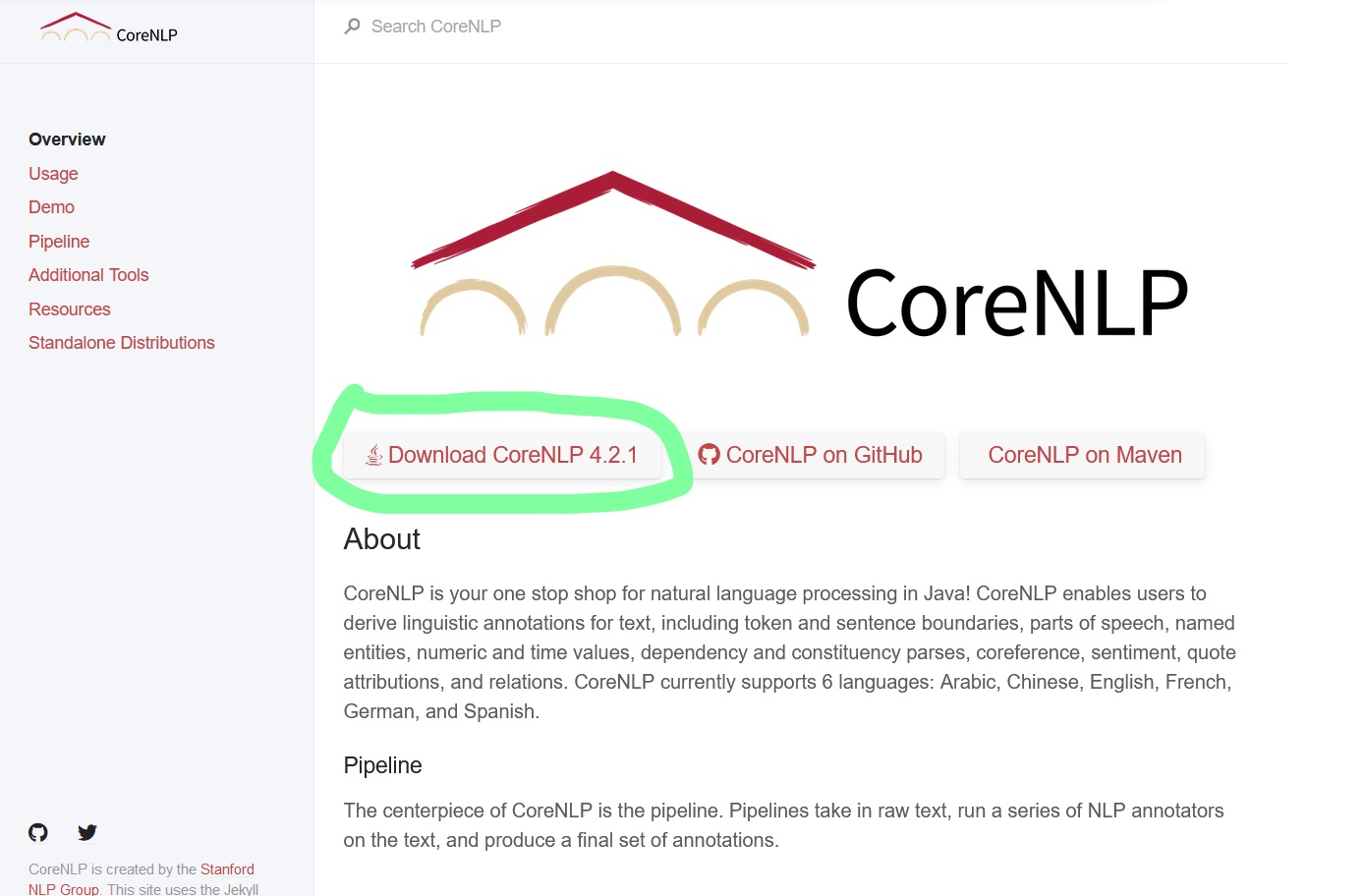

接下来我们下载Stanford CoreNLP模型,大家直接到官网下载,又快又不会连带着下一些垃圾软件下来,百度上的一些东西,有时候会下载一群垃圾软件。

官网:https://stanfordnlp.github.io/CoreNLP/.

点击Download CoreNLP4.2.1进行下载,下载到任意位置都可以,这个没有什么要求。

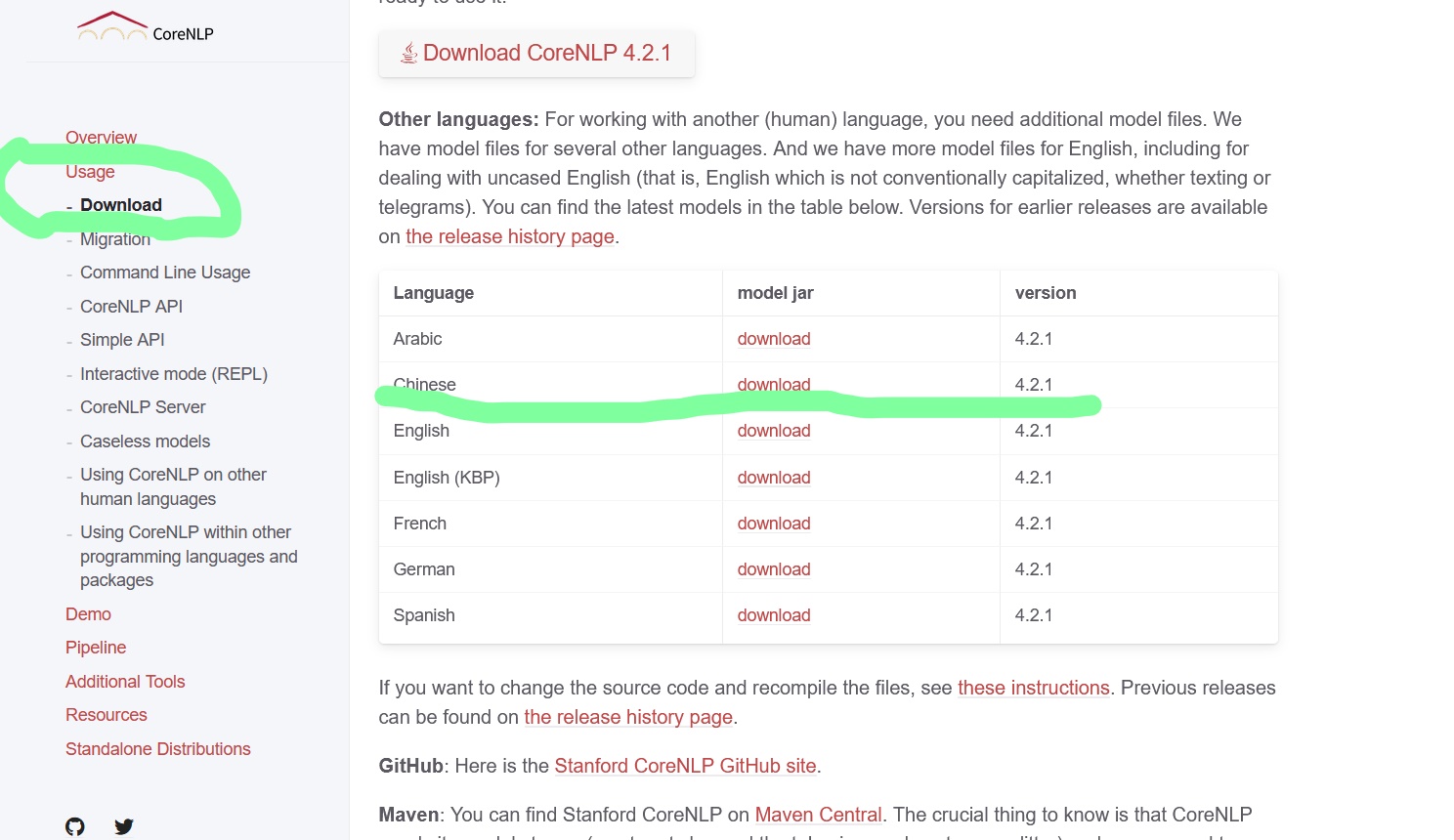

因为我们需要对中文进行句法分析,所以大家在下载好这个包之后,还需要下载一个Chinese专属jar包。

这个也非常简单,我们看到左边侧栏有一个“usage”选项,点击去,然后点击Download。可以看到界面如下,我们下载Chinese对应的jar包。

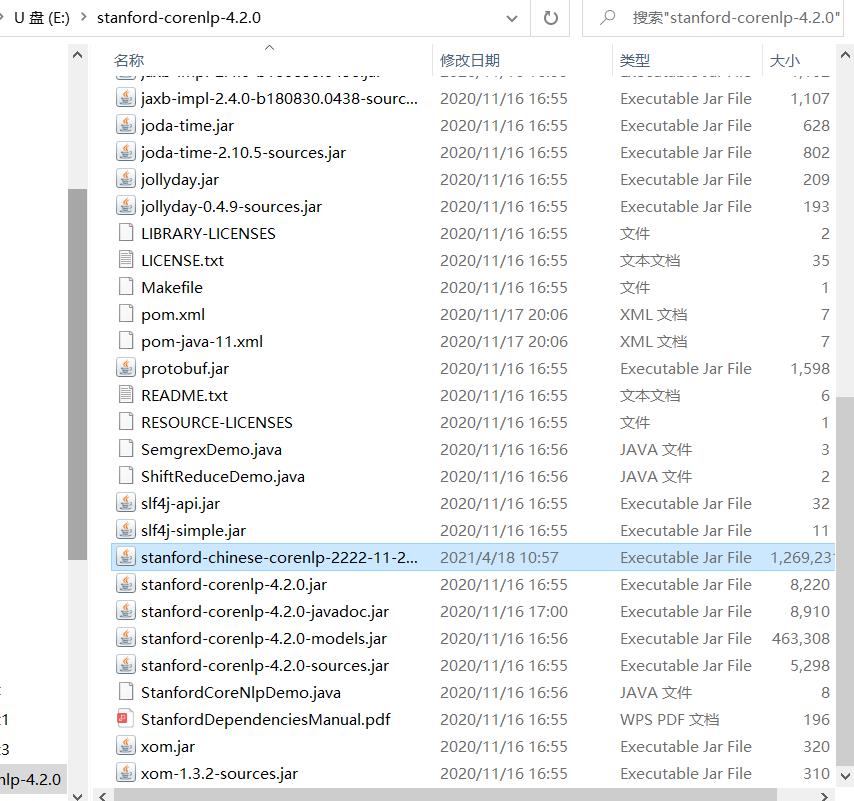

将Chinese对应的jar包解压后,放入我们之前下载好的Stanford CoreNLP包里面。如下:

将Chinese对应的jar包解压后,放入我们之前下载好的Stanford CoreNLP包里面。如下:

好啦,安装完成,接下来就可以使用啦!

好啦,安装完成,接下来就可以使用啦!

Stanford CoreNLP使用

回到我们的jupyter notebook

from stanfordcorenlp import StanfordCoreNLP

#如果要用其他语言,需要单独设置

nlp = StanfordCoreNLP(r'E:\\stanford-corenlp-4.2.0')

nlp_ch= StanfordCoreNLP(r'E:\\stanford-corenlp-4.2.0', lang='zh')

其中nlp是处理英文的,nlp_ch是处理中文的。

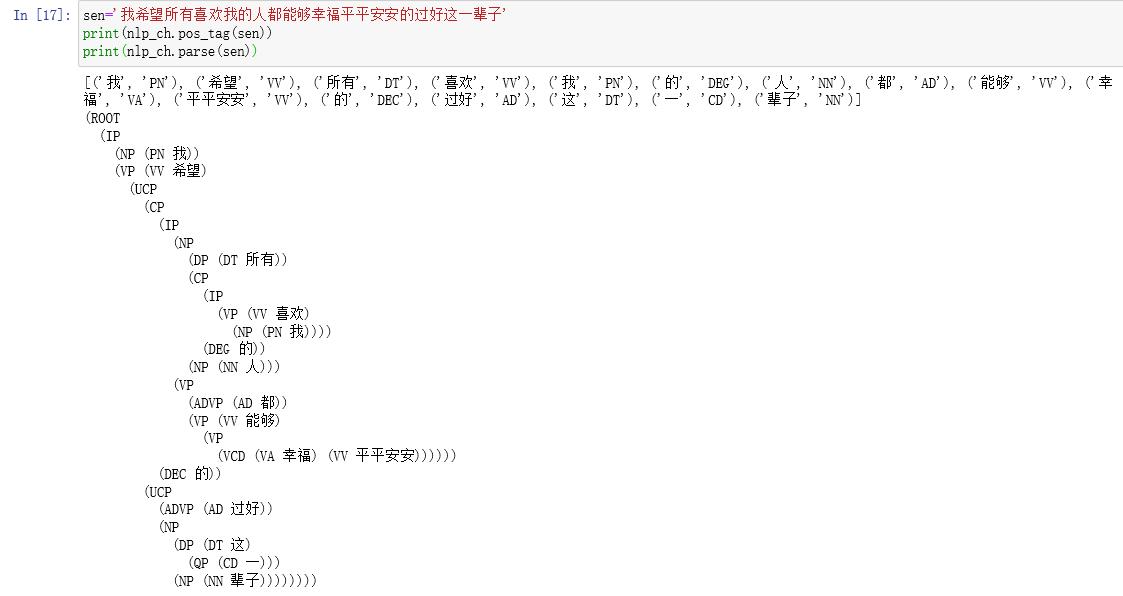

接下来我们以“我希望所有喜欢我的人都能够幸福平平安安的过好这一辈子”为例来进行句法分析和依存句法分析。没错,相信大家已经看出来了,这次还是王一博语录,嘿嘿。

sen='我希望所有喜欢我的人都能够幸福平平安安的过好这一辈子'

print(nlp_ch.pos_tag(sen))

print(nlp_ch.parse(sen))

这次就这样啦,下次我们开始进行可视化,以及保存在json文件中。

完整代码和运行结果以及语料都已经上传到资源啦,欢迎大家下载,CSDN必须要设置成收费或积分,大家如果不着急,可以私聊我私发哦。

资源下载:https://download.csdn.net/download/weixin_46570668/18234525.

哦对啦,我开始把讲解更新B站和抖音啦,名字都叫猫猫头丁,欢迎大家来关注啊!!!

B站:https://space.bilibili.com/410893912.

以上是关于Stanford CoreNLP超简单安装及简单使用,句法分析及依存句法分析的主要内容,如果未能解决你的问题,请参考以下文章