PyTorch学习,RNN分类

Posted My heart will go ~~

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了PyTorch学习,RNN分类相关的知识,希望对你有一定的参考价值。

数据集与先前下载的数据集一致,所以此次就不再下载,但仍然呈现了下载的代码

代码如下,大部分都加了详细的注释

import torch

import torch.nn as nn

from torch.autograd import Variable

import torch.utils.data as Data

import torchvision

EPOCH=1 #训练整批数据的次数

BATCH_SIZE = 64#批训练的数据个数

TIME_STEP=28#考虑多少时间点的数据,

INPUT_SIZE=28#每个时间点给RNN多少个数据点

LR = 0.01 # 学习率

DOWNLOAD_MNIST = False

train_data=torchvision.datasets.MNIST(#下载数据的代码

root='./mnist',

train=True,

transform=torchvision.transforms.ToTensor(), #(网上数据改为tensor),0-1之间,并复制到train_data中

download=DOWNLOAD_MNIST#没有下载就=true,下载了就用false

)

train_loader=Data.DataLoader(dataset=train_data,batch_size=BATCH_SIZE,shuffle=True)#为了更方便的训练数据

#测试集

test_data=torchvision.datasets.MNIST(root='./mnist/',train=False)

test_x = Variable(torch.unsqueeze(test_data.test_data, dim=1),volatile=True).type(torch.FloatTensor)[:2000]/255.

test_y = test_data.test_labels[:2000]

class RNN(nn.Module):

def __init__(self):

super(RNN,self).__init__()

self.rnn=nn.LSTM(

input_size=INPUT_SIZE,

hidden_size=64,

num_layers=1,

batch_first=True,#batch放在第一个维度

)

self.out=nn.Linear(64,10)

def forward(self,x):

r_out,(h_n,h_c)=self.rnn(x,None) #x(batch,time_step,input_size)

out=self.out(r_out[:,-1,:])#选取最后一个时刻的output,因为(batch,tims step,input)、

return out

rnn=RNN()

print(rnn)

#优化

optimizer = torch.optim.Adam(rnn.parameters(), lr=LR) # optimize all cnn parameters

loss_func = nn.CrossEntropyLoss()

for epoch in range(EPOCH):

for step, (x, y) in enumerate(train_loader): # gives batch data

b_x = x.view(-1, 28, 28) # (batch, time_step, input_size)

b_y=Variable(y)

output = rnn(b_x) # rnn output

loss = loss_func(output, b_y)

optimizer.zero_grad()

loss.backward()

optimizer.step()

#测试一下前十个数据

test_output = rnn(test_x[:10].view(-1, 28, 28))

pred_y = torch.max(test_output, 1)[1].data.numpy().squeeze()

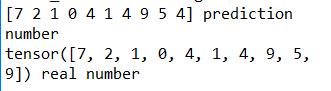

print(pred_y, 'prediction number')

print(test_y[:10], 'real number')

其中,最后测试集的测试结果如下:

以上是关于PyTorch学习,RNN分类的主要内容,如果未能解决你的问题,请参考以下文章