pytorch学习笔记:加载数据集

Posted Z|Star

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了pytorch学习笔记:加载数据集相关的知识,希望对你有一定的参考价值。

理清三个概念:

1、Epoch 训练次数

2、Batch-Size:各批量的大小

3、Iteration:使用批量的次数

Iteration*Batch-Size=Number of samples

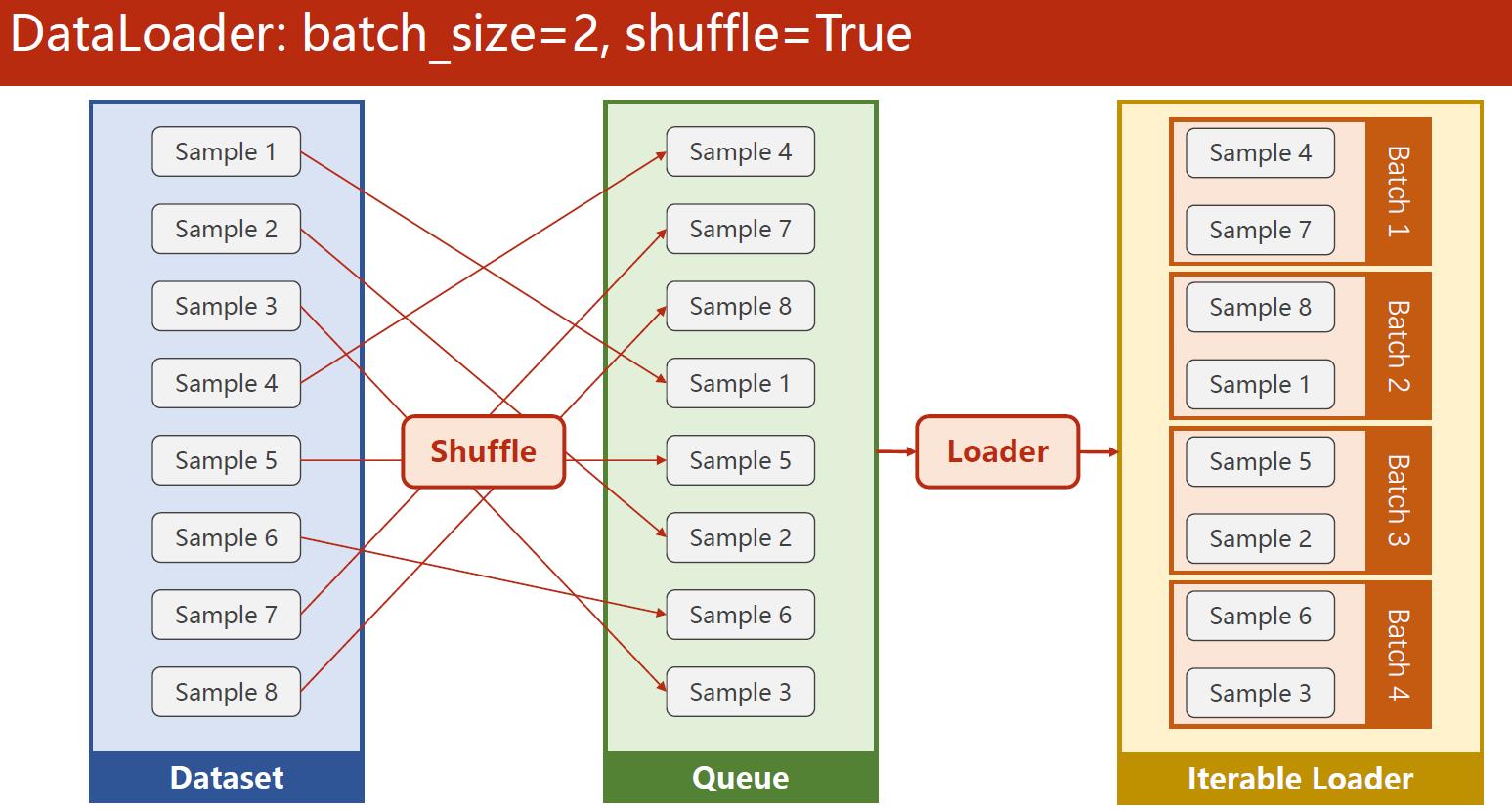

shuffle = True 打乱顺序(洗牌)

一般训练集需要打乱顺序,测试集不需要(无意义)

具体构建Dataset

import torch

from torch.utils.data import Dataset

from torch.utils.data import DataLoader

class DiabetesDataset(Dataset):

def __init__(self):

pass

def __getitem__(self, index):

pass

def __len__(self):

pass

dataset = DiabetesDataset()

train_loader = DataLoader(dataset=dataset,

batch_size=32,

shuffle=True,

num_workers=2)

DataLoader包含四个参数 num_workers代表使用线程数,根据CPU核来合理设置一般2,4,8

注:在windows系统下,不加if name == ‘main’:直接开始训练会发生报错

使用样例

构建数据集:

class DiabetesDataset(Dataset):

def __init__(self):

xy = np.loadtxt(filepath, delimiter =',', dtype=np.float32)

self.len = xy.shape[0]

self.x_data = torch.from_numpy(xy[:, :-1])

self.y_data = torch.from_numpy(xy[:, [-1]])

def __getitem__(self, index):

return self.x_data[index], self.y_data[index]

def __len__(self):

return self.len

dataset = DiabetesDataset('diabetes.csv.gz')

train_loader = DataLoader(dataset=dataset,

batch_size=32,

shuffle=True,

num_workers=2)

由于数据量不大,直接将所有数据读入内存之中

训练:

for epoch in range (100):

for i, data in enumerate (train_loader, 0):

# 1. Prepare data

inputs, labels = data

# 2. Forward

y_pred = model(inputs)

loss = criterion(y_pred, labels)

print (epoch, i, loss.item())

# 3. Backward

optimizer.zero_grad()

loss.backward()

# 4. Update

optimizer.step()

enumerate函数 i为下标,0代表i从0开始

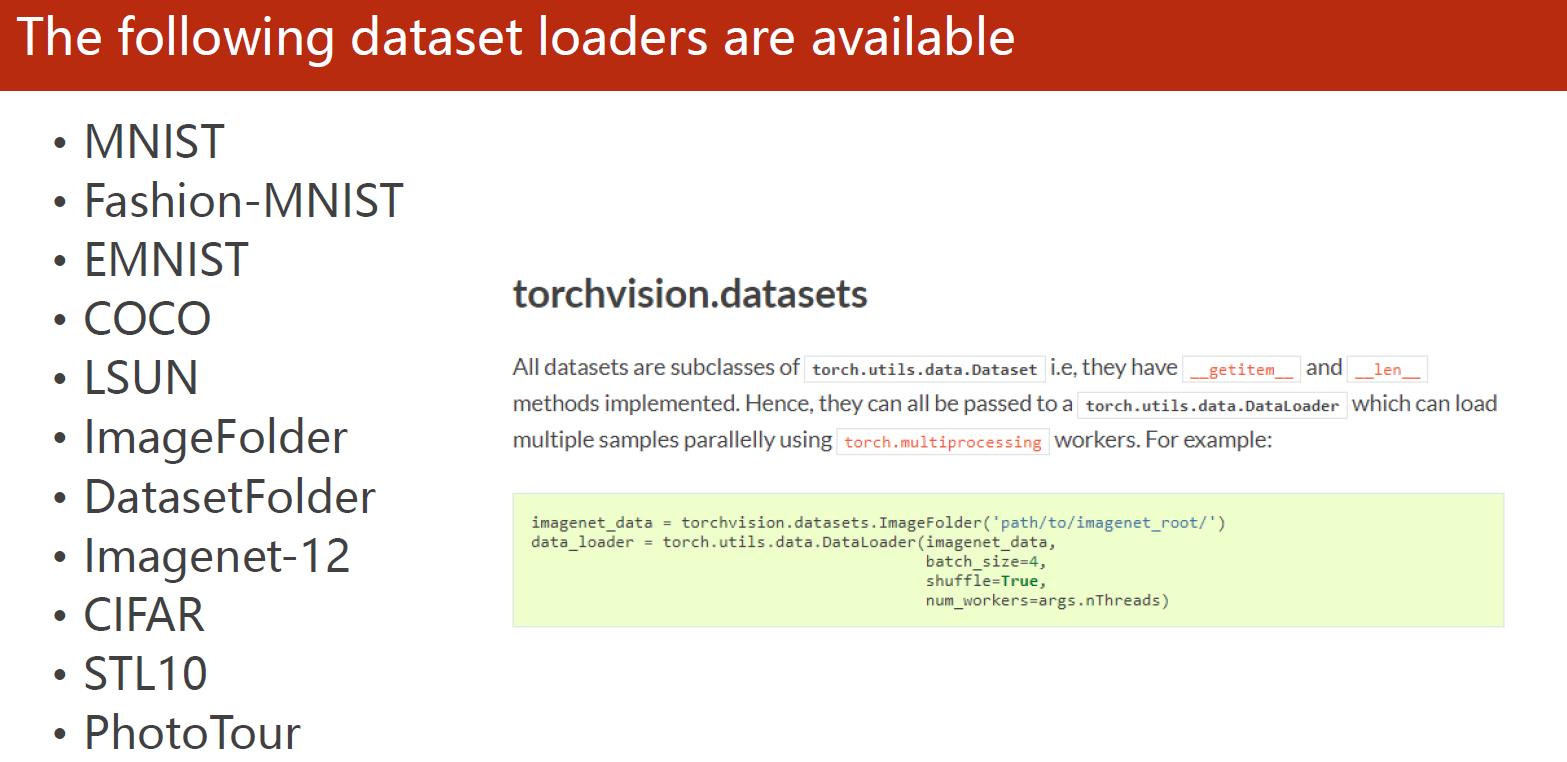

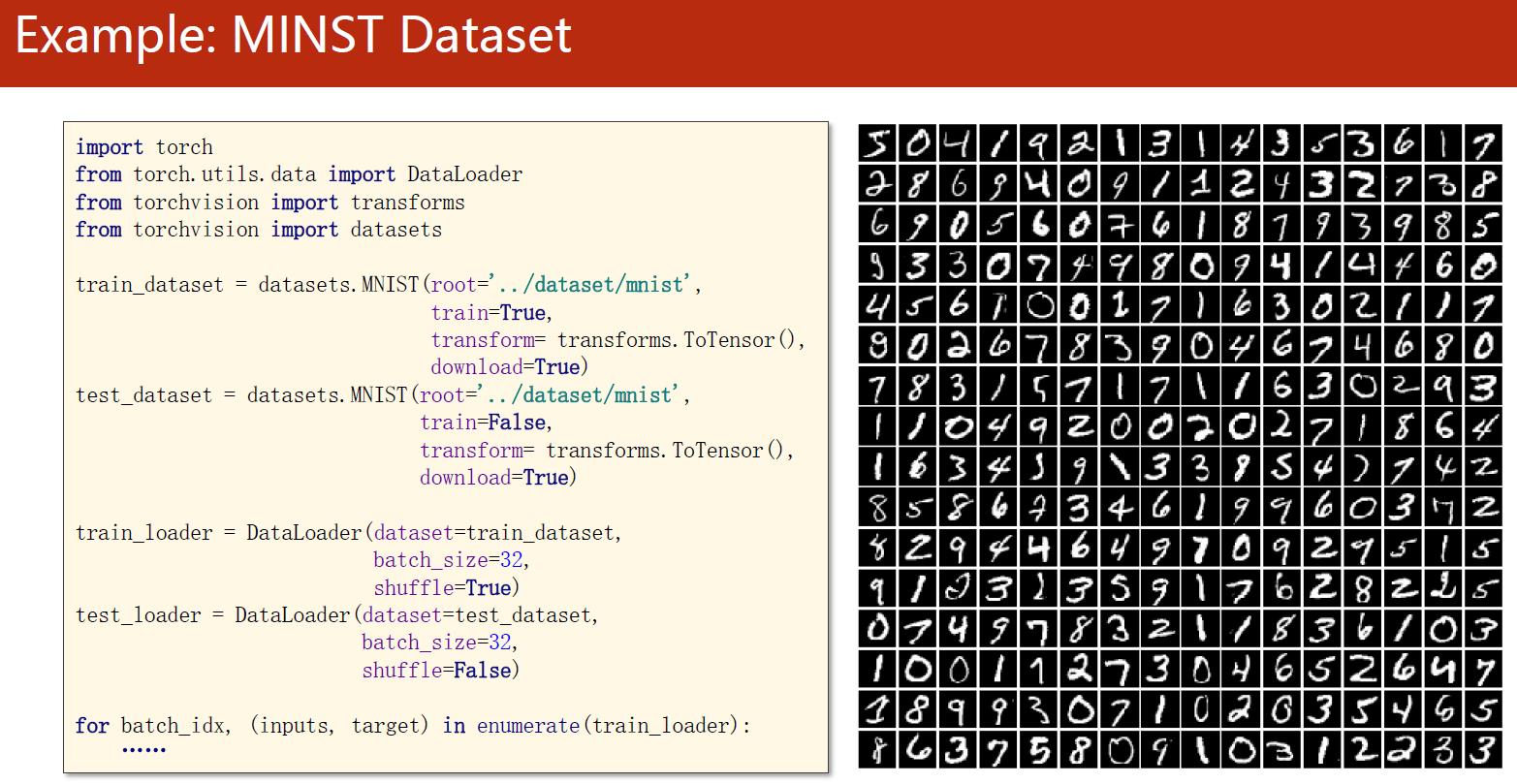

其它训练集的使用

以上是关于pytorch学习笔记:加载数据集的主要内容,如果未能解决你的问题,请参考以下文章