大佬带你用 python爬虫获取指定网站所有连接下图片单线程

Posted 不加班的程序员丶

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了大佬带你用 python爬虫获取指定网站所有连接下图片单线程相关的知识,希望对你有一定的参考价值。

- 第一步.获取入口网页源码

- 第二步.解析源码获取页面中所有的跳转链接

- 第三步.获取页面源码中所有的图片链接

- 第四部.下载图片到本地文件夹

- 第五步.递归重复二三四

实现逻辑:

首先,定义入口程序:

在入口程序中调用第一步,抓取入口地址源码

get_page_urls 这个方法是本例中主要逻辑,先附代码再讲解:

这是一个递归的方法,首先根据入口程序传过来的入口网址通过 requests.get(url) 方法获取对应入口网址的源码。

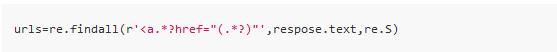

解析源码,通过写好的抓取规则获取所有a标签的 链接网址href:

抓取规则根据需要可自行调整。

然后。同样根据指定规则获取当前页面 所有img标签的图片链接。拿到图片链接,就可以实现下载图片到本地的操作。下载的代码稍后提供。

拿到源码中的 a标签链接后通过遍历链接递归调取get_page_urls获取所有相关页面的所有链接以及图片,为防止,网站中有重复调用的链接,这里先将每次成功抓取的链接备份到 usedUrl列表中。

最后提供下载图片的方法,实现比较简单。只是获取图片内容重写到本地文件中,为防止图片名称重复这里使用时间戳作为图片名:

需要相关资料的可以扫一扫备注【python】

以上是关于大佬带你用 python爬虫获取指定网站所有连接下图片单线程的主要内容,如果未能解决你的问题,请参考以下文章