FFmpeg进行推流的两种方法

Posted 老樊Lu码

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了FFmpeg进行推流的两种方法相关的知识,希望对你有一定的参考价值。

FFmpeg的推流一般有两种:

1.使用cmd进行推流,这种推流方式一般可用于简单的推流验证

这里拿Mp4文件举个简单的例子:利用无人机拍摄了一份推流Mp4文件

- 视频文件地址:/Users/jack/test.mp4

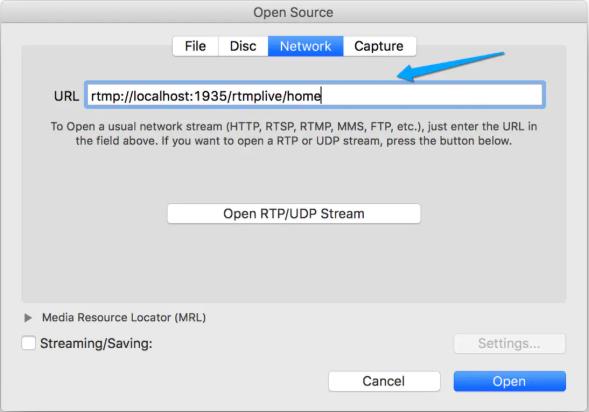

- 推流拉流地址:rtmp://localhost:1935/rtmplive/home

- acc:RTMP的音频格式

- flv: RTMP的视频格式

ffmpeg -re -i /Users/jack/test.mp4 -vcodec libx264 -acodec aac -f flv rtmp://localhost:1935/rtmplive/homeRTMP是Real Time Messaging Protocol(实时消息传输协议)的首字母缩写。是Adobe公司开发的一个基于TCP的应用层协议,也就是说,RTMP是和HTTP/HTTPS一样,是应用层的一个协议族。RTMP在TCP通道上一般传输的是flv 格式流。请注意,RTMP是网络传输协议,而flv则是视频的封装格式。flv封装格式设计出来的目的是为了用于网络传输使用的,因此RTMP+FLV可以说是”黄金搭档“。

RTMP协议包括:基本协议及RTMPT/RTMPS/RTMPE等多种变种。从视频协议学习:推流拉流都擅长的 RTMP了解到,RTMP协议家族有以下几个点挺有趣,读者们不妨看看:

- RTMP工作在TCP之上,默认使用端口1935,这个是基本形态;

- RTMPE在RTMP的基础上增加了加密功能;

- RTMPT封装在HTTP请求之上,可穿透防火墙;

- RTMPS类似RTMPT,增加了TLS/SSL的安全功能;

- RTMFP使用UDP进行传输的RTMP;

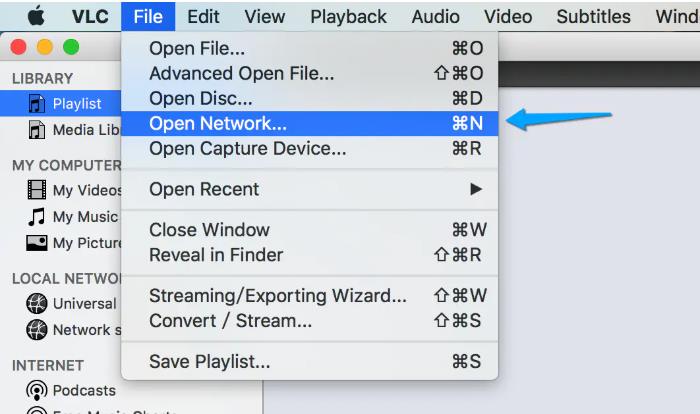

如何验证推流是否成功呢?可以使用VLC进行拉流测试。

设置播放地址:

设置拉流地址:

2.使用代码推流,不废话了,直接上代码

extern "C"

{

#include "libavformat/avformat.h"

#include "libavutil/time.h"

}

#include <iostream>

using namespace std;

#pragma comment(lib,"avformat.lib")

#pragma comment(lib,"avutil.lib")

#pragma comment(lib,"avcodec.lib")

int XError(int errNum)

{

char buf[1024] = { 0 };

av_strerror(errNum, buf, sizeof(buf));

cout << buf << endl;

getchar();

return -1;

}

static double r2d(AVRational r)

{

return r.num == 0 || r.den == 0 ? 0. : (double)r.num / (double)r.den;

}

int main(int argc, char *argv[])

{

const char *inUrl = "test.flv";

const char *outUrl = "rtmp://192.168.32.129/live";

//初始化所有封装和解封装 flv mp4 mov mp3

av_register_all();

//初始化网络库

avformat_network_init();

//

//输入流 1 打开文件,解封装

//输入封装上下文

AVFormatContext *ictx = NULL;

//打开文件,解封文件头

int re = avformat_open_input(&ictx, inUrl, 0, 0);

if (re != 0)

{

return XError(re);

}

cout << "open file " << inUrl << " Success." << endl;

//获取音频视频流信息 ,h264 flv

re = avformat_find_stream_info(ictx, 0);

if (re != 0)

{

return XError(re);

}

av_dump_format(ictx, 0, inUrl, 0);

//

//

//输出流

//创建输出流上下文

AVFormatContext *octx = NULL;

re = avformat_alloc_output_context2(&octx, 0, "flv", outUrl);

if (!octx)

{

return XError(re);

}

cout << "octx create success!" << endl;

//配置输出流

//遍历输入的AVStream

for (int i = 0; i < ictx->nb_streams; i++)

{

//创建输出流

AVCodec *codec = avcodec_find_decoder(ictx->streams[i]->codecpar->codec_id);

AVStream *out = avformat_new_stream(octx, codec);

//AVStream *out = avformat_new_stream(octx, );

if (!out)

{

return XError(0);

}

//复制配置信息,同于MP4

//re = avcodec_copy_context(out->codec, ictx->streams[i]->codec);

re = avcodec_parameters_copy(out->codecpar, ictx->streams[i]->codecpar);

//out->codec->codec_tag = 0;

}

av_dump_format(octx, 0, outUrl, 1);

//

//rtmp推流

//打开io

re = avio_open(&octx->pb, outUrl, AVIO_FLAG_WRITE);

if (!octx->pb)

{

return XError(re);

}

//写入头信息

re = avformat_write_header(octx, 0);

if (re < 0)

{

return XError(re);

}

cout << "avformat_write_header " << re << endl;

AVPacket pkt;

long long startTime = av_gettime();

for (;;)

{

re = av_read_frame(ictx, &pkt);

if (re != 0)

{

break;

}

cout << pkt.pts << " " << flush;

//计算转换pts dts

AVRational itime = ictx->streams[pkt.stream_index]->time_base;

AVRational otime = octx->streams[pkt.stream_index]->time_base;

pkt.pts = av_rescale_q_rnd(pkt.pts, itime, otime, (AVRounding)(AV_ROUND_NEAR_INF | AV_ROUND_NEAR_INF));

pkt.dts = av_rescale_q_rnd(pkt.pts, itime, otime, (AVRounding)(AV_ROUND_NEAR_INF | AV_ROUND_NEAR_INF));

pkt.duration = av_rescale_q_rnd(pkt.duration, itime, otime, (AVRounding)(AV_ROUND_NEAR_INF | AV_ROUND_NEAR_INF));

pkt.pos = -1;

//视频帧推送速度

if (ictx->streams[pkt.stream_index]->codecpar->codec_type == AVMEDIA_TYPE_VIDEO)

{

AVRational tb = ictx->streams[pkt.stream_index]->time_base;

//已经过去的时间

long long now = av_gettime() - startTime;

long long dts = 0;

dts = pkt.dts * (1000 * 1000 * r2d(tb));

if (dts > now)

av_usleep(dts - now);

}

re = av_interleaved_write_frame(octx, &pkt);

if (re < 0)

{

return XError(re);

}

}

cout << "file to rtmp test" << endl;

getchar();

return 0;

}

在推流开始时候几下时间start(1970至今的时间,单位为微妙 微秒:百万分之一秒),然后解封转后每一帧,得到pts 和 dts,然后将packet 的pts 和 dts转化为outAvformatContext 的,并且如果dts 转化为与start一样时间单位时候,如果大于 now - start ,就休眠 dts-(now - start)

这里用到了2个ffmpeg的函数:

av_strerror 输出错误信息

int XError(int errNum)

{

char buf[1024] = { 0 };

av_strerror(errNum, buf, sizeof(buf));

cout << buf << endl;

getchar();

return -1;

}- av_gettime:1970至今的时间,单位为微妙 微秒:百万分之一秒

- av_rescale_q_rnd 将输入的pts格式转化为输出上下文的格式

int64_t av_rescale_rnd(int64_t a, int64_t b, int64_t c, enum AVRounding rnd)最后一个参数转换的方式:

AV_ROUND_ZERO = 0, // Round toward zero. 趋近于0

AV_ROUND_INF = 1, // Round away from zero. 趋远于0

AV_ROUND_DOWN = 2, // Round toward -infinity. 趋于更小的整数

AV_ROUND_UP = 3, // Round toward +infinity. 趋于更大的整数

AV_ROUND_NEAR_INF = 5, // Round to nearest and halfway cases away from zero.

// 四舍五入,小于0.5取值趋向0,大于0.5取值趋远于0

以上是关于FFmpeg进行推流的两种方法的主要内容,如果未能解决你的问题,请参考以下文章