java数组怎么定义,上岸蚂蚁金服!

Posted 爱看动漫的Java程序员

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了java数组怎么定义,上岸蚂蚁金服!相关的知识,希望对你有一定的参考价值。

简介

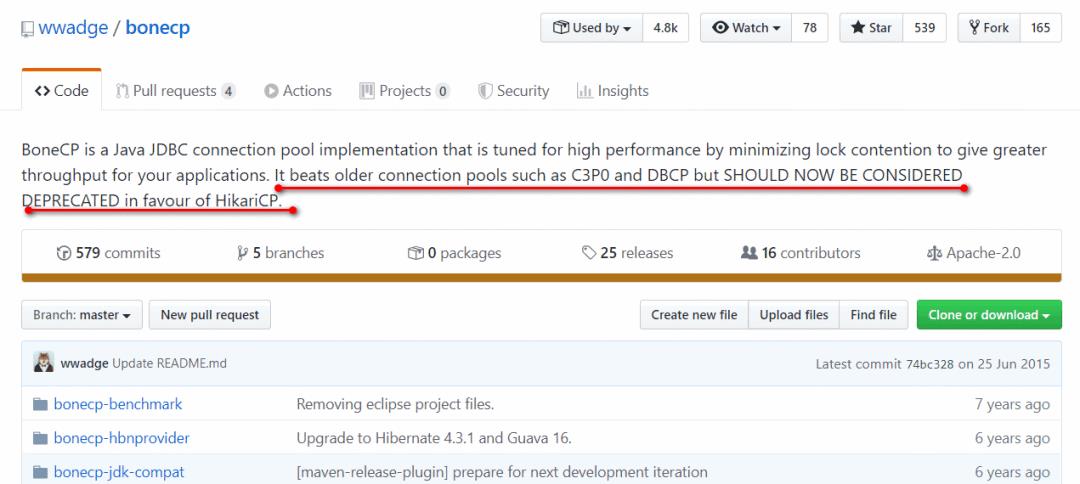

HikariCP 是用于创建和管理连接,利用“池”的方式复用连接减少资源开销,和其他数据源一样,也具有连接数控制、连接可靠性测试、连接泄露控制、缓存语句等功能,另外,和 druid 一样,HikariCP 也支持监控功能。HikariCP 是目前最快的连接池,就连风靡一时的 BoneCP 也停止维护,主动让位给它,SpringBoot 也把它设置为默认连接池。

看过 HikariCP 源码的同学就会发现,相比其他连接池,它真的非常轻巧且简单,有许多值得我们学习的地方,尤其性能提升方面,本文也就针对这一方面重点分析。本文将包含以下内容(因为篇幅较长,可根据需要选择阅读):

-

HikariCP 的使用方法(入门案例、JDNI 使用、JMX 使用)

-

HikariCP 的配置参数详解

-

HikariCP 源码分析

目录

- Kafka的基本介绍

- Kafka的设计原理分析

- Kafka数据传输的事务特点

- Kafka消息存储格式

- 副本(replication)策略

- Kafka消息分组,消息消费原理

- Kafak顺序写入与数据读取

- 消费者(读取数据)

Kafka的基本介绍

Kafka是最初由Linkedin公司开发,是一个分布式、分区的、多副本的、多订阅者,基于zookeeper协调的分布式日志系统(也可以当做MQ系统),常见可以用于web/nginx日志、访问日志,消息服务等等,Linkedin于2010年贡献给了Apache基金会并成为顶级开源项目。

主要应用场景是:日志收集系统和消息系统。

Kafka主要设计目标如下:

- 以时间复杂度为O(1)的方式提供消息持久化能力,即使对TB级以上数据也能保证常数时间的访问性能。

- 高吞吐率。即使在非常廉价的商用机器上也能做到单机支持每秒100K条消息的传输。

- 支持Kafka Server间的消息分区,及分布式消费,同时保证每个partition内的消息顺序传输。

- 同时支持离线数据处理和实时数据处理。

Kafka的设计原理分析

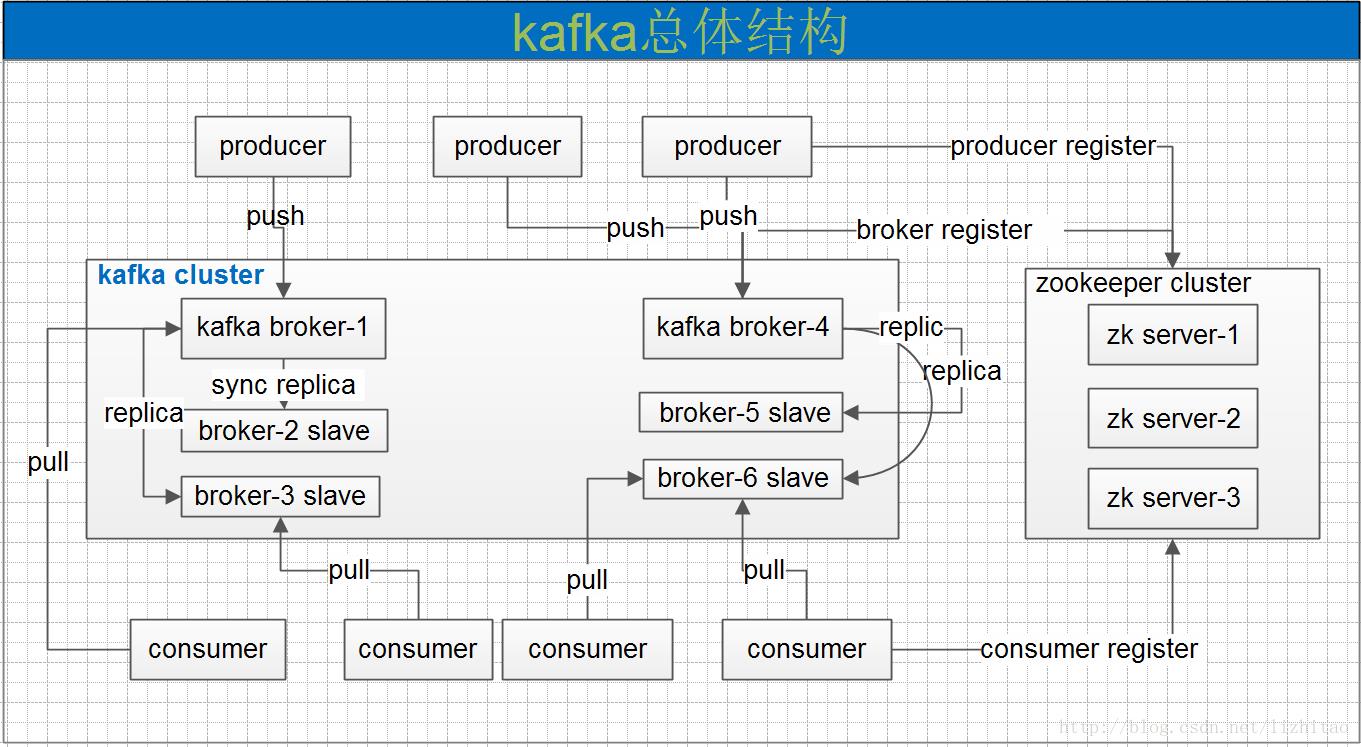

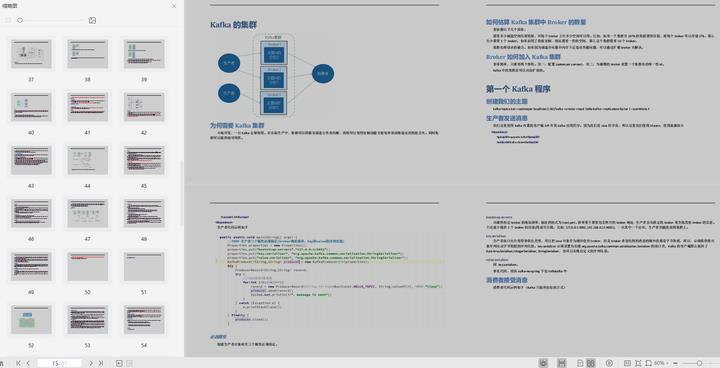

一个典型的kafka集群中包含若干producer,若干broker,若干consumer,以及一个Zookeeper集群。Kafka通过Zookeeper管理集群配置,选举leader,以及在consumer group发生变化时进行rebalance。producer使用push模式将消息发布到broker,consumer使用pull模式从broker订阅并消费消息。

Kafka专用术语:

- Broker:消息中间件处理结点,一个Kafka节点就是一个broker,多个broker可以组成一个Kafka集群。

- Topic:一类消息,Kafka集群能够同时负责多个topic的分发。

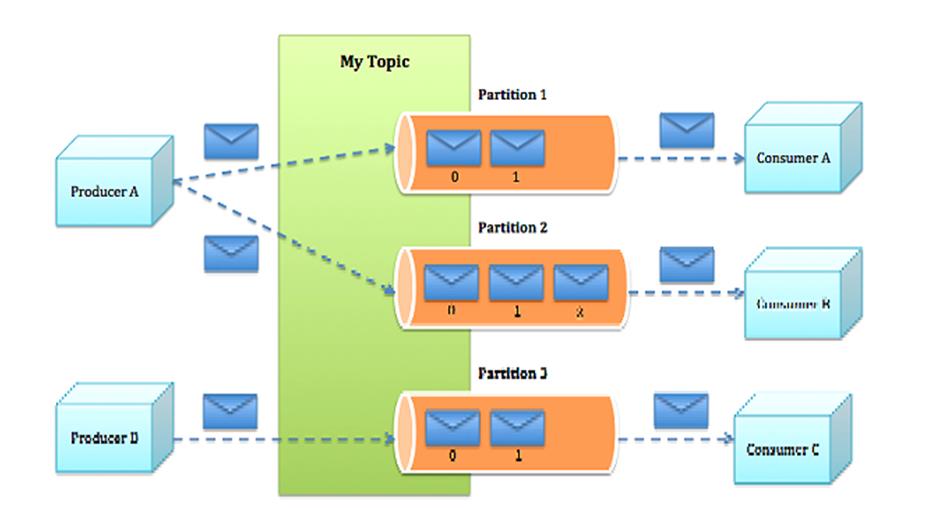

- Partition:topic物理上的分组,一个topic可以分为多个partition,每个partition是一个有序的队列。

- Segment:partition物理上由多个segment组成。

- offset:每个partition都由一系列有序的、不可变的消息组成,这些消息被连续的追加到partition中。partition中的每个消息都有一个连续的序列号叫做offset,用于partition唯一标识一条消息。

- Producer:负责发布消息到Kafka broker。

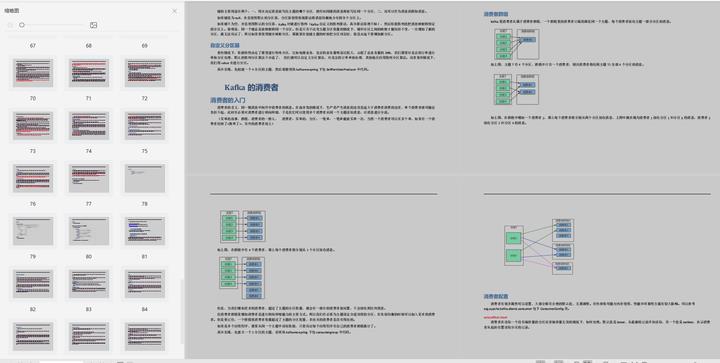

- Consumer:消息消费者,向Kafka broker读取消息的客户端。

- Consumer Group:每个Consumer属于一个特定的Consumer Group。

Kafka数据传输的事务特点

- at most once:最多一次,这个和JMS中"非持久化"消息类似,发送一次,无论成败,将不会重发。消费者fetch消息,然后保存offset,然后处理消息;当client保存offset之后,但是在消息处理过程中出现了异常,导致部分消息未能继续处理。那么此后"未处理"的消息将不能被fetch到,这就是"at most once"。

- at least once:消息至少发送一次,如果消息未能接受成功,可能会重发,直到接收成功。消费者fetch消息,然后处理消息,然后保存offset。如果消息处理成功之后,但是在保存offset阶段zookeeper异常导致保存操作未能执行成功,这就导致接下来再次fetch时可能获得上次已经处理过的消息,这就是"at least once",原因offset没有及时的提交给zookeeper,zookeeper恢复正常还是之前offset状态。

- exactly once:消息只会发送一次。kafka中并没有严格的去实现(基于2阶段提交),我们认为这种策略在kafka中是没有必要的。

通常情况下"at-least-once"是我们首选。

Kafka消息存储格式

Topic & Partition

一个topic可以认为一个一类消息,每个topic将被分成多个partition,每个partition在存储层面是append log文件。

在Kafka文件存储中,同一个topic下有多个不同partition,每个partition为一个目录,partiton命名规则为topic名称+有序序号,第一个partiton序号从0开始,序号最大值为partitions数量减1。

- 每个partion(目录)相当于一个巨型文件被平均分配到多个大小相等segment(段)数据文件中。但每个段segment file消息数量不一定相等,这种特性方便old segment file快速被删除。

- 每个partiton只需要支持顺序读写就行了,segment文件生命周期由服务端配置参数决定。

这样做的好处就是能快速删除无用文件,有效提高磁盘利用率。

- segment file组成:由2大部分组成,分别为index file和data file,此2个文件一一对应,成对出现,后缀".index"和“.log”分别表示为segment索引文件、数据文件.

- segment文件命名规则:partion全局的第一个segment从0开始,后续每个segment文件名为上一个segment文件最后一条消息的offset值。数值最大为64位long大小,19位数字字符长度,没有数字用0填充。

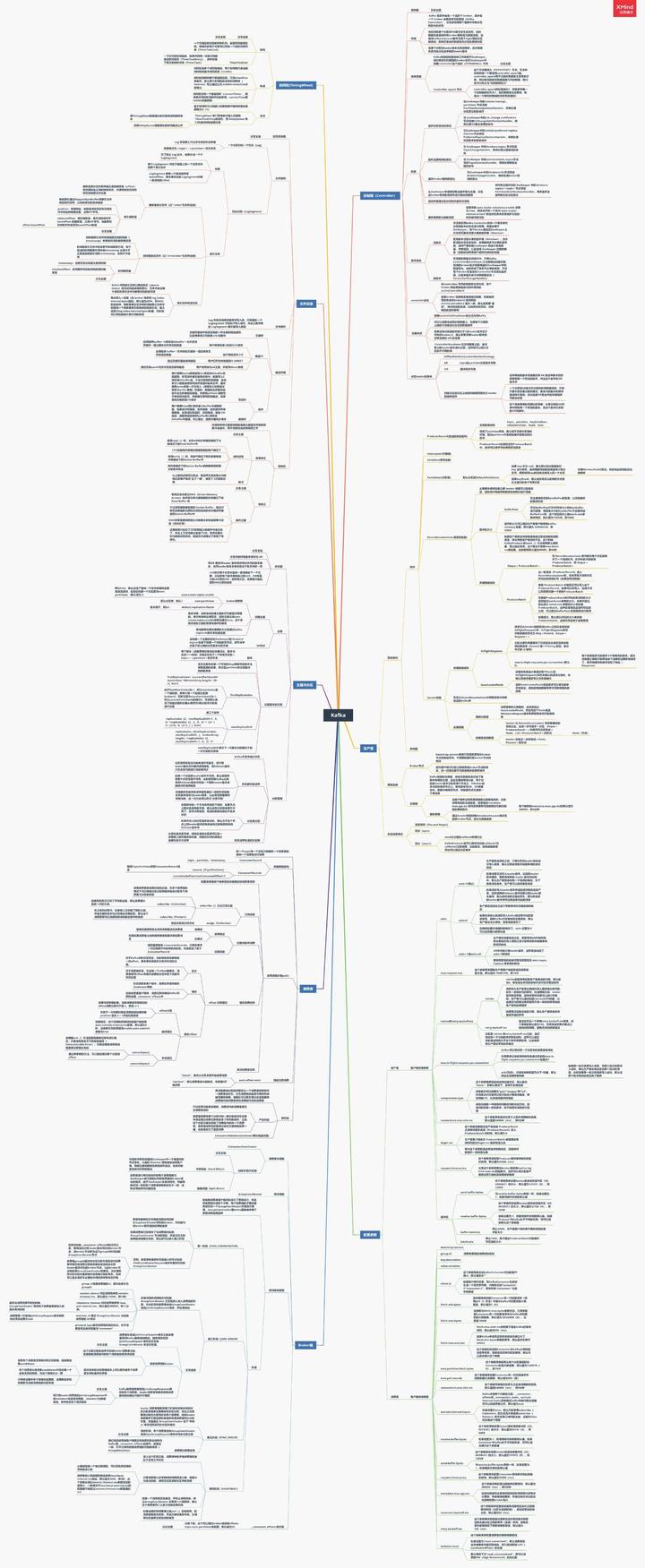

总结:绘上一张Kakfa架构思维大纲脑图(xmind)

其实关于Kafka,能问的问题实在是太多了,扒了几天,最终筛选出44问:基础篇17问、进阶篇15问、高级篇12问,个个直戳痛点,不知道如果你不着急看答案,又能答出几个呢?

若是对Kafka的知识还回忆不起来,不妨先看我手绘的知识总结脑图(xmind不能上传,文章里用的是图片版)进行整体架构的梳理

梳理了知识,刷完了面试,如若你还想进一步的深入学习解读kafka以及源码,那么接下来的这份《手写“kafka”》将会是个不错的选择。

-

Kafka入门

-

为什么选择Kafka

-

Kafka的安装、管理和配置

-

Kafka的集群

-

第一个Kafka程序

-

Kafka的生产者

-

Kafka的消费者

-

深入理解Kafka

-

可靠的数据传递

-

Spring和Kafka的整合

-

SpringBoot和Kafka的整合

-

Kafka实战之削峰填谷

-

数据管道和流式处理(了解即可)

ing和Kafka的整合

-

SpringBoot和Kafka的整合

-

Kafka实战之削峰填谷

-

数据管道和流式处理(了解即可)

[外链图片转存中…(img-vDGRtimK-1622034969751)]

以上是关于java数组怎么定义,上岸蚂蚁金服!的主要内容,如果未能解决你的问题,请参考以下文章