一起看 I/O|ARCore 1.24 版本上线,亮点更新一次看全

Posted 谷歌开发者

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了一起看 I/O|ARCore 1.24 版本上线,亮点更新一次看全相关的知识,希望对你有一定的参考价值。

2021 年的谷歌 I/O 大会发强势回归。由于去年的大会被取消,今年的 I/O 大会有很多更新进展。本次大会采取线上的方式举办,从 5 月 18 日持续到 5 月 20 日,所有人都可以免费参与,让你足不出户,享受科技盛宴,观众也可查看大会开幕式主题演讲回放。

大会开幕式主题演讲回放

https://www.bilibili.com/video/BV1WA411g7fh?from=search&seid=1253898639760612971

在 AR 方面,本次大会展示了在 Google 搜索,直接查找观看运动员的 3D 模型,并用 AR 展示动作的实时演示。在 AR 平台方面,也发布了跟 ARCore 有关的最新进程。从扩大兼容设备,到跟踪改进和新功能,特别是两个主要功能——Raw Depth API,Record and Playback API。除了 3 场演讲,workshop 和 Codelabs 还展示了如何使用主要的 ARCore 功能,如 WebXR API、Cloud Anchors、ARCore Depth、ARCore Record and Playback,并通过代码样本一步步构建一个 AR 应用。

Google 搜索加入 3D 及 AR 展示网球运动员大阪直美的动作实时演示

ARCore 新进更新

创建 ARCore 的初衷就是为了给开发者提供操作简单,且功能强大的工具,帮助人们将数字世界与现实世界无缝融合。作为 Google 搭建的增强现实体验平台,ARCore 自 2017 年发布至今,成功兼容 8.5 亿台设备,让诸多开发者成功打造体验有趣的应用程序,改变人们在 Google 范围内一起玩乐、购物、学习、创造和体验世界的方式。

在今年的 Google I/O 大会上,我们继续优化并构建 AR 开发工具。ARCore 1.24 上线后,我们陆续推出了 Raw Depth API 和 Recording and Playback API。这些新的 API 将帮助开发者创建新的 AR 体验,并加快他们的开发周期。

Raw Depth API——让深度和空间意识更加真实

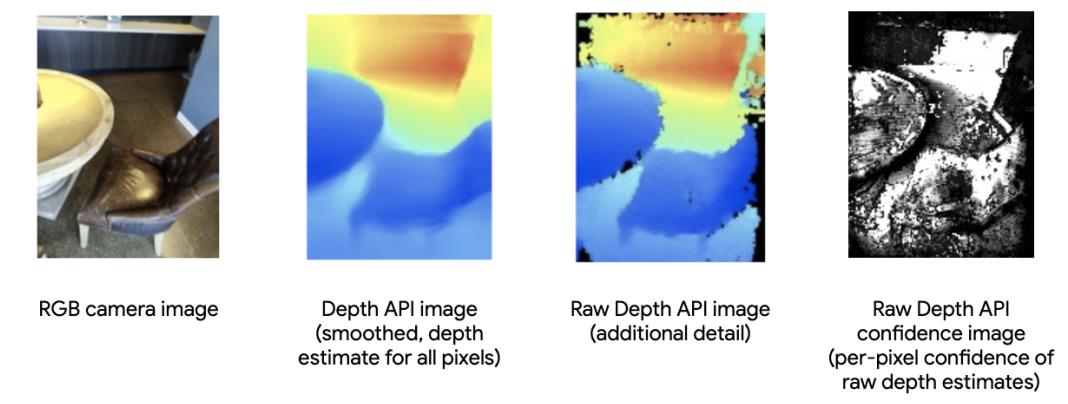

2020 年,Depth API 初次与大家见面。让数以亿计的安卓设备,无需使用专门的深度传感器,就能实时生成深度图。这些深度图中的数据经过平滑处理,成功填补了因视觉信息缺失而产生的空白,让开发者能够轻松创建“遮挡”这样的深度效果。

全新的 ARCore Raw Depth API 可以生成带有“置信图(corresponding confidence images)”的“原始深度图”,从而针对场景中的物体,提供更详细的几何形状。原始深度图包括非平滑数据点,置信图则为原始深度图中的每个像素,提供了深度估计的置信度。

Raw Depth API 改进后的几何图形让深度测量和空间意识更加精确。此外,Raw Depth API 的置信图为开发者提供实时过滤深度数据。例如,TikTok 最新的滤镜让用户能够上传图像,并将图像包覆在真实世界的物体上。使图像素材于现实物体表面高度契合。

TikTok 使用 ARCore Raw Depth API 置信图,

放置图片或视频

开发者过滤高置信度深度数据的能力对于三维物体和场景重建也是至关重要的。3D Live Scanner 应用程序能够帮助用户扫描他们的空间并创建、编辑和分享 3D 模型。

想了解 ARCore Raw Depth API 更多示例,请查看下方视频:

除了应用程序之外,ARCore 深度实验室中同样更新了 Raw Depth API 和深度命中测试的实例。你可以在“适用于 android 的深度 API 概述”网页中上找到与之相关的更多内容,并利用 Android 和 Unity 建构你的 AR。

适用于 Android 的深度 API 概述

https://developers.google.com/ar/develop/java/depth/overview

Recording Playback API——场景轻松复制,提升开发速度

对于 AR 开发者来说,一个反复出现的痛点是,需要在特定的地方和场景中不断进行测试,不但耗时耗力,许多地点并不允许开发者随时随地进出。此外,由于时间不同照明会存在差异和变化,不能确保传感器在每次现场摄像时都捕捉到完全相同的信息,这就对后期开发的调较带来了挑战。

新的 ARCore Recording and Playback API 就是针对这一挑战推出的。利用这个功能,开发者不仅可以录制视频片段,同时还可以记录 IMU 和深度传感器数据。在回放时,开发者可以回访相同的数据,真正实现场景复制,并在任何舒适的工作空间中测试体验。这项功能在非常时期,让无法亲临现场的远端开发测试变成了可能。

滴滴率先尝鲜这一技术,使用 Recording and Playback API 在“滴滴出行 ”App 中建立并测试 AR 指向功能。由于能完全复制场景及数据,滴滴节省了 25% 的研发和测试成本和 60% 的差旅费用。不仅如此,开发周期更是缩短了 6 个月。

“滴滴出行”的 DiDi-Rider 通过 Recording and Playback API

节省了开发资源

Post - Capture AR

除了缩短研发周期,录制和回放还为 AR 体验带来了更多的新机遇,Post-Capture AR 就是基于 Recording and Playback API 的另一项强大功能:使用记录了IMU 和深度传感器数据的视频,带来不同步的 AR 体验,消除时间和地点限制。例如,在放置虚拟 AR 家具时,用户不需要待在一直待在家里,只要调出家中的视频,就能准确地放置 AR 家具。通过这种方式,你可以 把 AR 带到任何地方。

SK 电信的 Jump AR 使用 Recording and Playback API,成功将场景从韩国传输到用户家中,增强与文化宣传相关的 3D AR 内容。

SKT 的 JumpAR 使用 Recording 和 Playback 功能,

将韩国场景带入家中

新升级的 API 正在让 ARCore 日渐强大,帮助开发者打造出更加逼真的 AR 体验。随着兼容设备数量增加,ARCore 让几乎所有拥有智能手机的人都能体验增强现实技术。我们期待有更多的开发者可以利用 ARCore 进行创新,让用户体验 AR 的强大。

点击查看下方视频,深入了解 Recording and Playback API

以上是本次 I/O 大会上 ARCore 的精华亮点,想回顾完整内容,请访问 ARCore developer 网站。或点击阅读全文,查看官方博客文章。

ARCore developer

https://developers.google.com/ar/develop

以上是关于一起看 I/O|ARCore 1.24 版本上线,亮点更新一次看全的主要内容,如果未能解决你的问题,请参考以下文章