爬虫日记(77):Scrapy的命令合法的判断

Posted caimouse

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了爬虫日记(77):Scrapy的命令合法的判断相关的知识,希望对你有一定的参考价值。

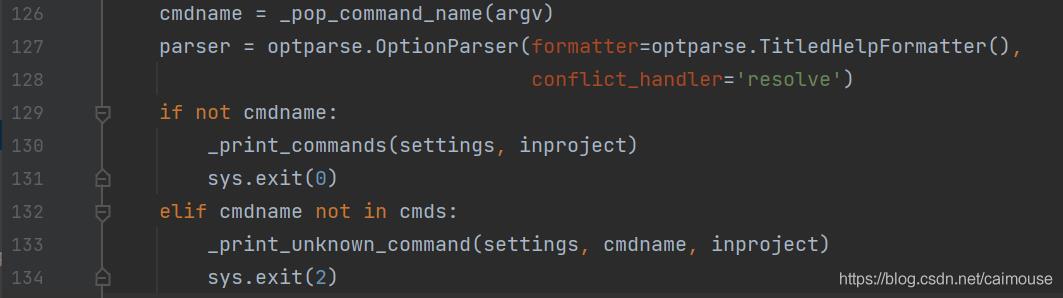

前面已经从三个地方准备好所有可以运行的命令,接着下来就是需要根据命令行的输入内容来判断命令是否合法,参数个数是否合法,参数内容是否合法了。我们分析这一段代码,学会处理命令行参数,以及出错的提示。

第126行调用函数_pop_command_name()来弹出命令行的参数,比如scrapy crawl quotes,它就会返回crawl命令,这时候cmdname就等于crawl,也就是我们需要执行的命令,这个命令就是按字典的方式保存在cmds里。

第127行是创建OptionParser对象,OptionParser 是python内置的功能非常强大的命令行参数解析模块,它使用灵活,可以方便的生成标准的、符合Unix/Posix 规范的命令行说明。formatter: 帮助信息格式;有两种格式:IndentedHelpFormatter和TitledHelpFormatter; 当设定的命令行选项冲突时,用于处理该冲突的一种机制;比如:不小心把两个或多个命令行选项设置成相同的导致冲突的选项字符串;比如:

parser.add_option("-n", "--dry-run",

以上是关于爬虫日记(77):Scrapy的命令合法的判断的主要内容,如果未能解决你的问题,请参考以下文章

爬虫日记(85):Scrapy的ExecutionEngine类