2021-05-08论文

Posted 雷姆是我的

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了2021-05-08论文相关的知识,希望对你有一定的参考价值。

最近一直懒,没更新论文。虽然我向天发誓我论文一直在读的(天:我才不相信你呢)。总之最近要读的论文比较杂,主要是Contrastive Learning+Exploration in RL+Generation。想到哪里说到哪里吧。

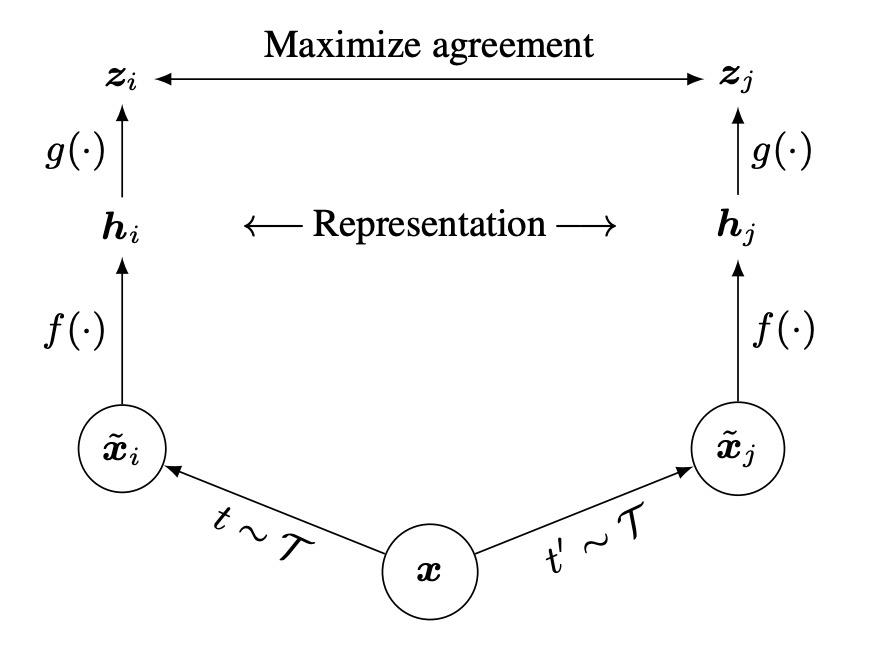

SimCLR估计大家都知道了,大体就是对于不同的instance之间做contrast,如图

注意哈,这里面有两个有意思的东西,首先那个

f

f

f不要小看它,这个metric learning的思想会改变整体的效果;第二个就是他的batch size得超级大。

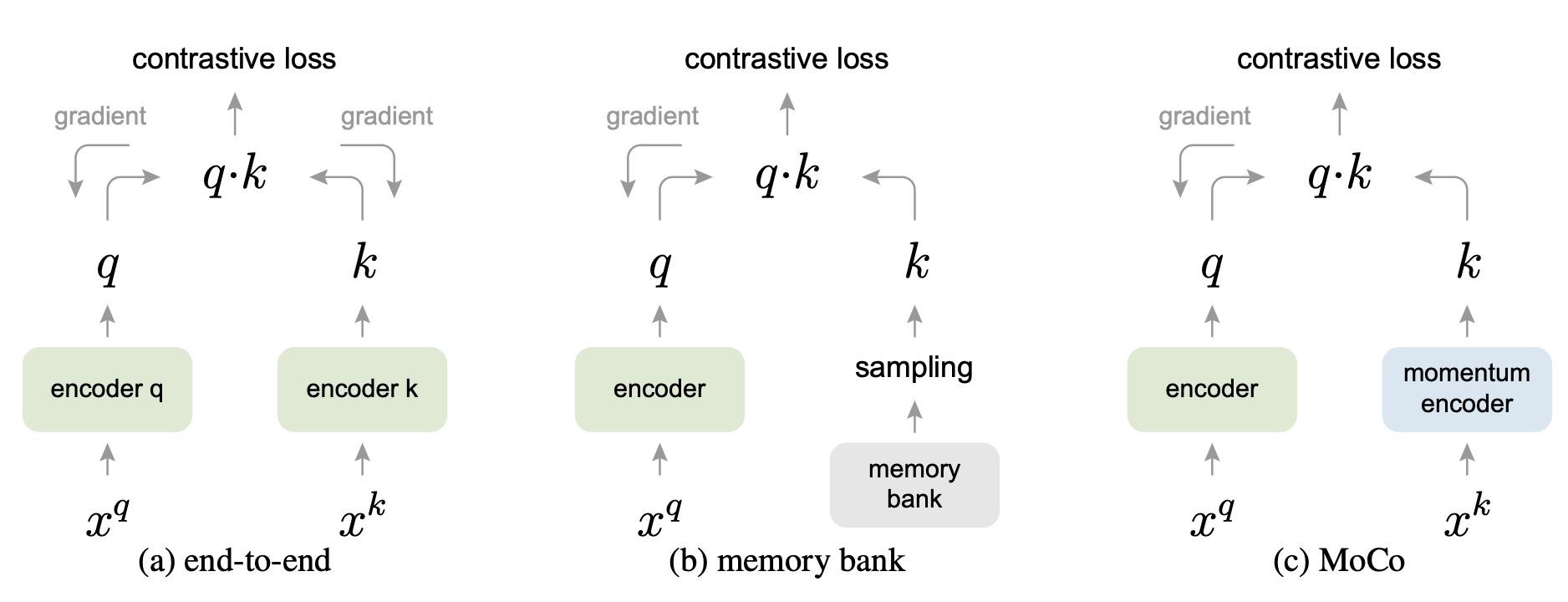

为了解决超级大的问题,MoCoV1和MoCoV2引入了一个机制,就是所谓的momentum。简单来说,不再双向迭代导数,而是用一个滑动均衡,这样减少计算量。如图所示:

对于有label的来说,Supervised Constrastive Learning是你的好伙伴。这里面无非是对loss做了修改,不太清楚效果。

还有一类研究,是使用clustering来做,SwAV

还是一个非常有意思的方法。具体方法有点复杂,因为要online clustering。感兴趣的看原paper吧。这个方法看起来效果还是不错的。

一片跟Mix-Match类似的Mochi把最难的样本拿出来做mixing。这种方法展现出来了triplet mining和constrastive learning之间的一个关系,并且把MixMatch的思想又用了一次。效果不知,各位看官可以尝试。

关于constrastive learning,还有人提出三步走的方法。SimCLR第一步,正常训练第二步,然后constrastive learning + distillation + 真实label。具体见该文章。

由于Constrastive Learning基本上是基于Multiview的,所以选取什么样的view就成为了一个重要的课题。在这篇文章中,作者的基本思路是,如果view把和下游任务有关的东西干掉了,那效果不好;但是如果留下来太多东西,那效果也不好。作者还提出了一个在有lalel情况下可以采用的方式。

最后再发一个有意思的。这篇文章大意是说,在抽取负样本的时候,有很多时候有些样本就卷了进来,所以我们要把假的负样本去掉。为了去掉这些假的负样本,作者做了一大堆数学推导,方法却是非常简单的。这类论文特别适合那种喜欢给自己的论文当中加一大堆理论的同学阅读。

今天就到这里吧。。。我明天看看RL的Exploration。

以上是关于2021-05-08论文的主要内容,如果未能解决你的问题,请参考以下文章