Kafka单节点部署及使用

Posted 怒上王者

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Kafka单节点部署及使用相关的知识,希望对你有一定的参考价值。

Kafka单节点部署及使用

1.下载

从官网下载kafka,由于测试需要,我下载的是kafka_2.11-0.9.0.0.tgz

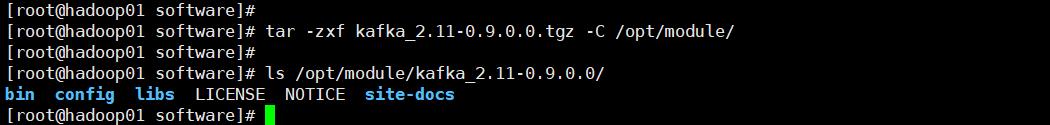

2.上传解压

将安装包上传到/opt/software目录,并解压

tar -zxf kafka_2.11-0.9.0.0.tgz -C /opt/module/

3.修改配置文件

创建logs目录

[root@hadoop01 module]# cd kafka_2.11-0.9.0.0/

[root@hadoop01 kafka_2.11-0.9.0.1]# ll

total 28

drwxr-xr-x 3 root root 4096 Feb 12 2016 bin

drwxr-xr-x 2 root root 4096 Feb 12 2016 config

drwxr-xr-x 2 root root 4096 May 8 09:39 libs

-rw-r--r-- 1 root root 11358 Feb 12 2016 LICENSE

-rw-r--r-- 1 root root 162 Feb 12 2016 NOTICE

drwxr-xr-x 2 root root 46 Feb 12 2016 site-docs

[root@hadoop01 kafka_2.11-0.9.0.1]# mkdir logs

修改server.properties配置文件

[root@hadoop01 kafka_2.11-0.9.0.1]# cd config/

You have new mail in /var/spool/mail/root

[root@hadoop01 config]# vim server.properties

配置以下内容

#broker的全局唯一编号,不能重复

broker.id=0

#删除topic功能使能

delete.topic.enable=true

#处理网络请求的线程数量

num.network.threads=3

#用来处理磁盘IO的现成数量

num.io.threads=8

#发送套接字的缓冲区大小

socket.send.buffer.bytes=102400

#接收套接字的缓冲区大小

socket.receive.buffer.bytes=102400

#请求套接字的缓冲区大小

socket.request.max.bytes=104857600

#kafka运行日志存放的路径

log.dirs=/opt/module/kafka_2.11-0.9.0.0/logs

#topic在当前broker上的分区个数

num.partitions=1

#用来恢复和清理data下数据的线程数量

num.recovery.threads.per.data.dir=1

#segment文件保留的最长时间,超时将被删除

log.retention.hours=168

#配置连接Zookeeper集群地址

zookeeper.connect=hadoop01:2181

4.配置环境变量

[root@hadoop01]# sudo vim /etc/profile

#KAFKA_HOME

export KAFKA_HOME=/opt/module/kafka_2.11-0.9.0.0

export PATH=$PATH:$KAFKA_HOME/bin

[root@hadoop01]# source /etc/profile

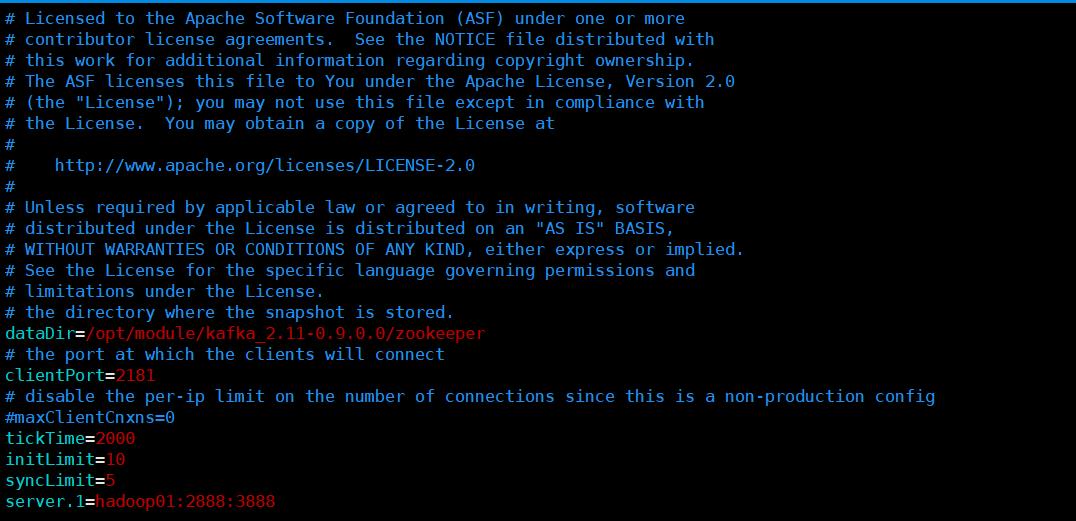

5.修改zookeeper配置

[root@hadoop01 config]# vim zookeeper.properties

dataDir=/opt/module/kafka_2.11-0.9.0.0/zookeeper

# the port at which the clients will connect

clientPort=2181

# disable the per-ip limit on the number of connections since this is a non-production config

#maxClientCnxns=0

tickTime=2000

initLimit=10

syncLimit=5

server.1=hadoop01:2888:3888

在zookeeper的数据目录添加myid文件,写入服务broker.id属性值,如这里的目录是/opt/module/kafka_2.11-0.9.0.1/zookeeper

[root@hadoop01 kafka_2.11-0.9.0.0]# cd /opt/module/kafka_2.11-0.9.0.1/zookeeper

[root@hadoop01 zookeeper]#

[root@hadoop01 zookeeper]# touch myid

[root@hadoop01 zookeeper]# echo 1 > myid

[root@hadoop01 zookeeper]# cat myid

1

[root@hadoop01 zookeeper]#

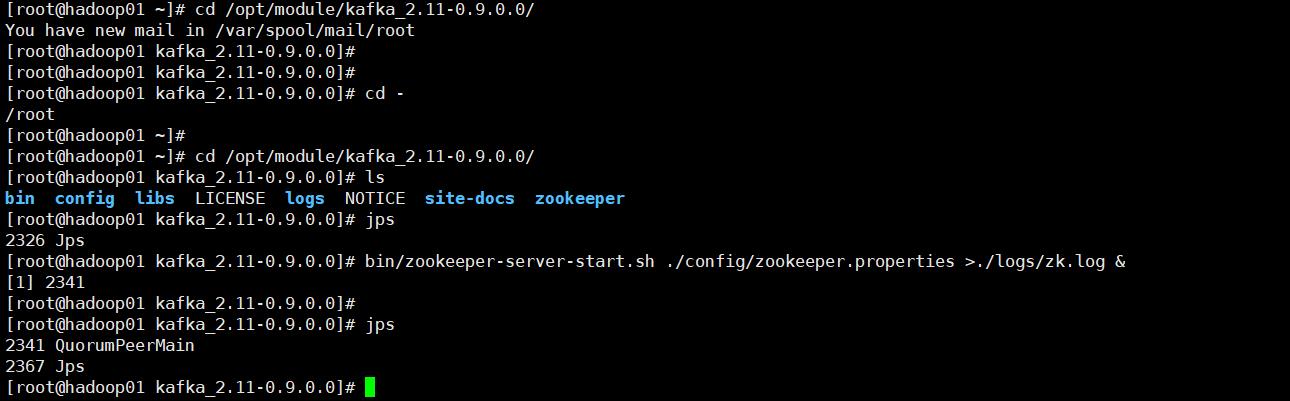

6.启动kafka

启动kafka之前要先启动zookeeper,这里使用的是kafka自带的zk

[root@hadoop01 ~]# cd /opt/module/kafka_2.11-0.9.0.0/

[root@hadoop01 kafka_2.11-0.9.0.0]# ls

bin config libs LICENSE logs NOTICE site-docs zookeeper

[root@hadoop01 kafka_2.11-0.9.0.0]#

[root@hadoop01 kafka_2.11-0.9.0.0]# bin/zookeeper-server-start.sh ./config/zookeeper.properties >./logs/zk.log &

[root@hadoop01 kafka_2.11-0.9.0.0]# jps

2326 Jps

[root@hadoop01 kafka_2.11-0.9.0.0]# bin/zookeeper-server-start.sh ./config/zookeeper.properties >./logs/zk.log &

[1] 2341

[root@hadoop01 kafka_2.11-0.9.0.0]# jps

2341 QuorumPeerMain

2367 Jps

[root@hadoop01 kafka_2.11-0.9.0.0]#

启动kafka

[root@hadoop01 tools]# cd /opt/module/kafka_2.11-0.9.0.0/

[root@hadoop01 kafka_2.11-0.9.0.0]# bin/kafka-server-start.sh -daemon config/server.properties

[root@hadoop01 kafka_2.11-0.9.0.0]#

[root@hadoop01 kafka_2.11-0.9.0.0]# jps

33593 QuorumPeerMain

33707 Kafka

33739 Jps

[root@hadoop01 kafka_2.11-0.9.0.1]#

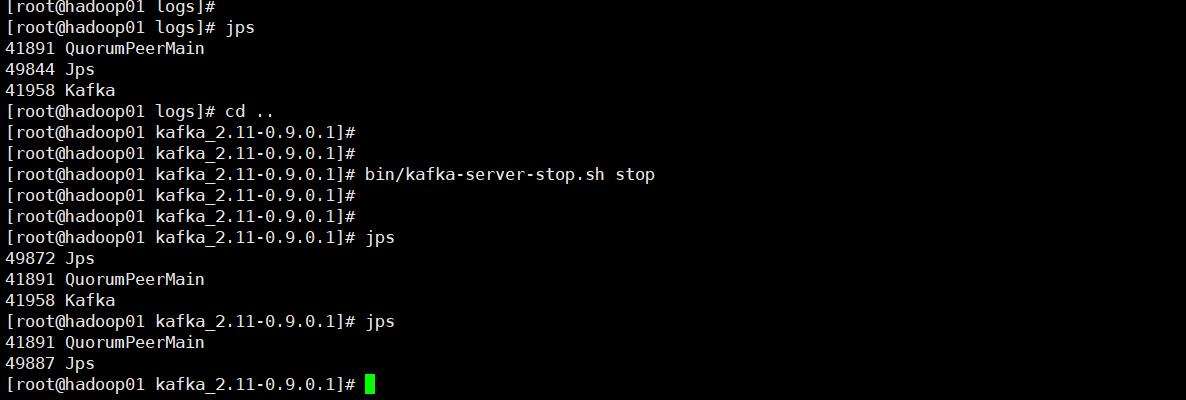

停止kafka

[root@hadoop01 kafka_2.11-0.9.0.1]# bin/kafka-server-stop.sh stop

7.测试

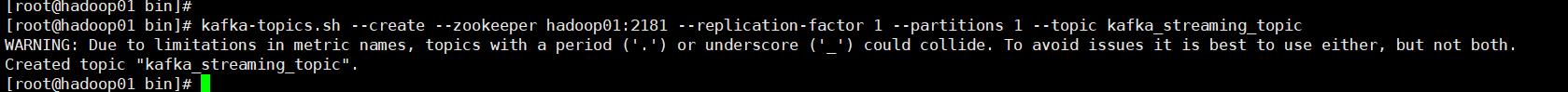

创建topic

[root@hadoop01 kafka_2.11-0.9.0.0]# bin/kafka-topics.sh --create --zookeeper hadoop01:2181 --replication-factor 1 --partitions 1 --topic kafka_streaming_topic

参数说明:

–zookeeper:指定kafka连接zk的连接url,该值和server.properties文件中的配置项{zookeeper.connect}一样

–replication-factor:指定副本数量

–partitions:指定分区数量

–topic:主题名称

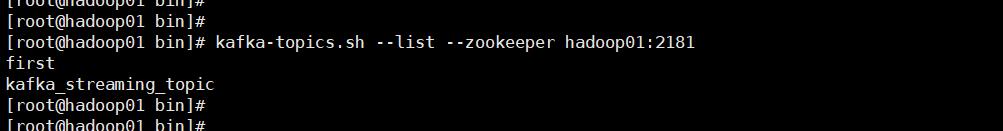

查看kafka中所有topic信息

[root@hadoop01 kafka_2.11-0.9.0.0]# bin/kafka-topics.sh --list --zookeeper hadoop01:2181

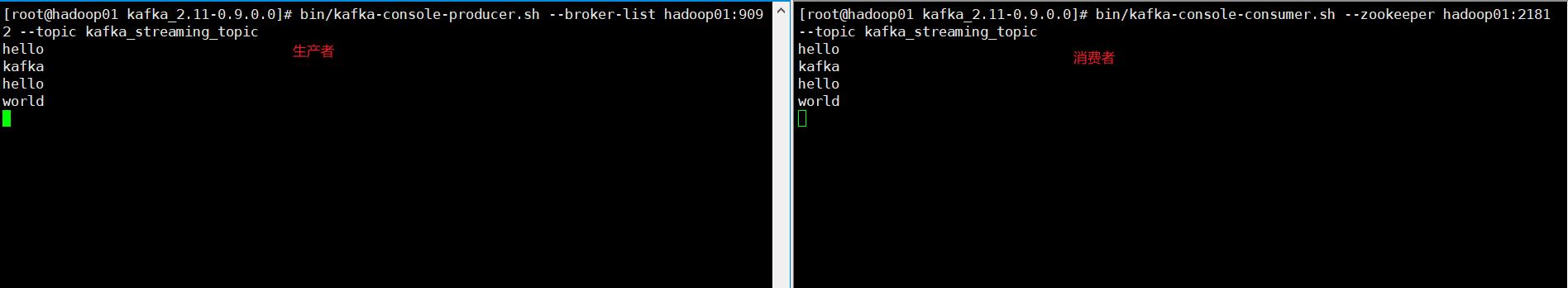

创建生产者

bin/kafka-console-producer.sh --broker-list hadoop01:9092 --topic kafka_streaming_topic

创建消费者

bin/kafka-console-consumer.sh --zookeeper hadoop01:2181 --topic kafka_streaming_topic --from-beginning

参数说明:

–from-beginning 从头开始消费

–bootstrap-server 指的是目标集群kafka的服务器地址,新版本之后(新版本指的是kafka 0.8.0之后的版本)开始使用 --bootstrap-server代替 --zookeeper

以上是关于Kafka单节点部署及使用的主要内容,如果未能解决你的问题,请参考以下文章