华为云&中国信通院|《云原生2.0白皮书》

Posted 云计算360度观察

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了华为云&中国信通院|《云原生2.0白皮书》相关的知识,希望对你有一定的参考价值。

云原生是近几年云计算领域炙手可热的话题,云原生技术已成为驱动业务增长的重要引擎。同时,作为新型基础设施的重要支撑技术,云原生也逐渐在人工智能、大数据、边缘计算、5G 等新兴领域崭露头角。伴随各行业上云的逐步深化,云原生化转型进程将进一步加速。

云原生的技术理念始于 Netflflix 等厂商从 2009 年起在公有云上的开发和部署实践。2015 年云原生基金会 CNCF 成立,标志着云原生从技术理念转化为开源实现,并给出了目前被广泛接受的定义:云原生技术有利于各组织在公有云、私有云和混合云等新型动态环境中,构建和运行可弹性扩展的应用。云原生的代表技术包括容器、服务网格、微服务、不可变基础设施和声明式 API。

云原生开源项目从基础的容器引擎出发,不断扩展应用领域,对边缘、异构等各类场景的适配能力不断深入。从早期开源的容器引擎项目 Docker,到实现容器高效编排的 Kubernetes、Swarm、Mesos,再到为了更好的解决微服务治理的难题,基于 Service Mesh 技术推出的 Istio,以及针对边缘场景推出的 KubeEdge、K3s、OpenYurt,面向高性能异构计算场景的 Volcano 等项目,无一不成为加速云原生与行业融合、推动各行业创新的助推器。

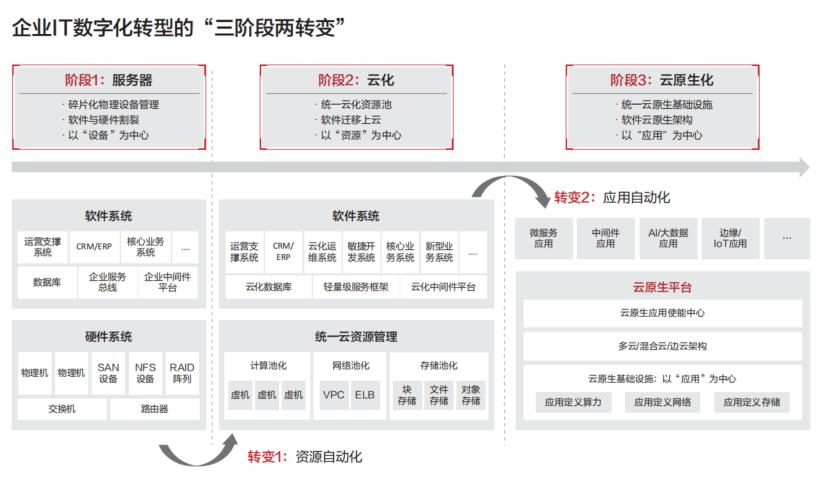

简单来看,企业 IT 建设所依赖的基础资源经历了从服务器到云化资源的发展历程,正在快速进入云原生阶段。

服务器阶段

:其特点是以硬件设备为中心,业务应用随不同厂商设备、操作系统、虚拟化软件的差异化进行定制;设备的安装、调试,应用的部署、运维基本靠人力完成,自动化程度低,缺乏统一的设备和应用管理能力。后期随着虚拟化软件的出现,资源的利用率、扩缩容器的灵活性方面得到一定的提升,但并未从根本上解决基础设施与软件割裂、运维复杂的难题。

云化阶段

:传统模式下分布离散的设备,被统一起来,实现了各类资源如计算、存储、网络的池化,通过统一的虚拟化软件平台,为上层业务软件提供统一的资源管理接口,实现资源管理能力的自动化,屏蔽一部分基础设施的差异,使得应用的通用性增强,但因为虚拟化软件平台差异化较大,尤其是各厂商的一些商业化增强,无法在厂商间进行能力共享,应用还是无法以完全标准化的模式构建,应用部署还是以资源为中心。

云原生阶段:在这一阶段,企业的关注点从以资源为中心转移到以应用为中心,包括应用敏捷交付、快速弹性、平滑迁移、无损容灾等。因此,企业开始考虑如何将基础设施与业务平台融合,为业务应用提供标准的运行、监控、治理平台,并将业务的通用能力下沉到平台侧,更好的帮助企业实现应用的自动化。

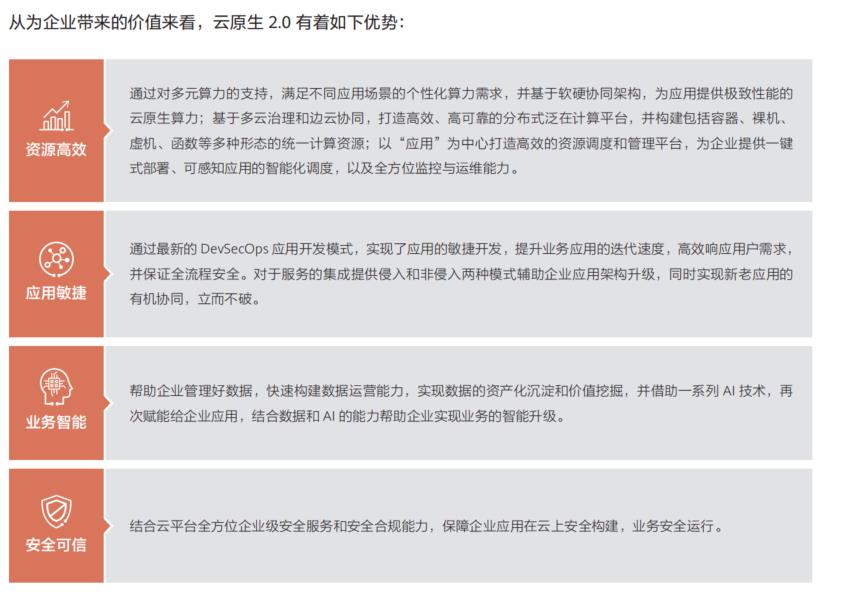

企业数字化转型初期,主要是将业务从线下搬迁上云,在这一阶段企业主要是的把业务简单部署和运行在云上,可以称之为 ON CLOUD。这种形态下,通过资源池云化,解决了 IDC 时代运维、部署、扩容的难题,但传统应用单体架构厚重、烟囱式架构等带来的一系列应用层面的问题并没有得到有效解决,云对业务的价值主要还停留在资源供给的阶段,无法充分发挥出云的价值。

随着企业数字化转型的深入,企业需要充分享受云计算带来的红利,需要让业务能力生于云、长于云,由现在的ON CLOUD 进阶到 IN CLOUD,同时基于云构建的新生能力与既有能力有机协同、立而不破。生于云是指基于云原生的技术、架构和服务来构建企业应用,长于云是指充分利用云的优势来助力企业应用和业务发展,将企业的数字化建设、业务智能升级带入新阶段,我们称之为云原生 2.0 时代。

经过十几年的发展,云计算作为数字化转型的重要基础设施,已经由“以资源为中心”演进到“以应用为中心”的云原生基础设施阶段。云原生基础设施为用户带来了多方面的革新,利用智能的调度、运维系统高效管理更为丰富的应用,天然混合云的架构可将业务快速分发部署到到分布式云的场景中,同时软硬协同的基础设施架构在为应用提供更好的性能的同时,也对隔离性、安全性等多方面能力进行了加强。

容器服务早期的部署形态多基于虚拟机,以虚拟机节点作为容器集群的计算节点,并基于此构建容器的网络、存储和编排能力。这样的堆叠架构虽然可以让整个软件栈分工明确、边界清晰,但是带来了较大的性能损耗和功能冗余,并且难以满足客户对实例安全隔离的较高要求。

在云原生 2.0 时代,基于裸金属搭建容器服务成为一些对性能和实例隔离性较高用户的选择。同时,为了进一步提高容器负载性能和稳定性,原来部署在裸金属之上的非业务负载组件也逐步的由专门的卸载硬件来承载,例如容器存储、容器网络、容器引擎以及服务网格组件。将容器组件下沉到卸载卡后,有两方面好处:

» 资源高效:裸金属节点上的计算资源可以 100% 被业务负载使用,避免了对业务负载的性能干扰。

» 性能提升:容器网络、容器存储组件下沉到卸载卡后可以与传统 IaaS 层的网络、存储组件垂直打通,减少冗余;直接以硬件设备直通方式将存储、网络资源分配给容器实例,缩短 I/O 路径,提高性能。

随着人工智能、5G、HPC、边缘计算等新业务的逐渐落地和普及,对算力多样化提出了更高的要求。针对特定的业务场景采用专有的硬件可以提供更好的计算效能,越来越多的异构计算硬件如 GPU、FPGA、ASIC、SoC 等被应用到专有的领域。云原生 2.0 时代,基础设施的特征之一就是向下统一管理和支持各种异构硬件,向上屏蔽底层多种硬件的差异性。真正做到以应用为中心,应用无需关心底层的硬件设备,无需针对特定硬件做任何特殊处理。

大规模的网络资源供应、泛在的网络安全隔离、极致的网络弹性和细粒度的网络 QoS 是承载大规模云原生业务的基础网络要求。资源供应方面,单 VPC 内多集群的容器端点数可以达到甚至超过百万,灾备场景的集群迁移要求容器级的网络配置、隔离,例如 QoS,带宽限速大批量容器快速发放(10 万 / 分钟);网络弹性方面 ,Serverless/Function 等轻量级云原生运行时的要求毫秒级创建,秒级冷启动(包含网络端到端打通);安全隔离方面,无边界、零信任、海量端点和高动态性的云原生网络安全,要求即时生效的容器粒度安全隔离与 ACL;资源力度方面,在 / 离线业务混部场景下,为了能够发挥出云原生极致资源利用率和性价比,要求容器网口粒度的 QoS(包括带宽保障和优先级支持)。不断变化的云原生业务诉求正推动着云网络架构的不断演进。

传统高性能计算 (HPC) 领域广泛采用 InfifiniBand 技术获得高吞吐和低时延的无损网络通讯能力,但这一技术体系专用网络硬件成本高昂、组网规模不可扩展、技术演进缓慢,无法满足云原生时代的平民化可支付、高弹性大规模使用要求。领先的云厂商开始基于智能网卡的可编程和卸载能力,对无损网络通讯协议进行了重新设计,在主机侧智能网卡中采用创新的拥塞控制算法,在大大降低丢包发生概率的同时,保持转发队列的低水位,从而兼顾大带宽和低时延要求,并且也去除了对 PFC 的依赖,利用普通的以太网交换设备就可以实现大规模组网,解决了横向扩展的问题。以 AWS SRD 和华为云 CurreNET 为代表的高性能协议栈技术在高性能计算(100G)和低时延云存储(10 微秒级时延)技术领域取得突破。未来高性能网络通讯协议在云原生领域的应用将不再局限于传统的高性能计算和存储领域,会在扩展至更广泛的云原生技术和行业应用中,如:ServiceMesh、 云原生的中间件(内存数据库,消息中间件等)等技术,云视频、云原生的金融交易等行业。

|下载《云原生2.0白皮书》可查看具体内容,请关注公众号,后台回复“云原生2.0”。

免责申明:该号主要聚焦于云计算相关商业和技术分享,内容观点不代表本号立场,可追溯内容均注明来源,发布文章若存在版权等问题,请留言删除,谢谢。