机器学习笔记五 决策树

Posted 猛男Banana君

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了机器学习笔记五 决策树相关的知识,希望对你有一定的参考价值。

一、决策树模型&学习

1)决策树的定义:是一种基本的分类与回归方法。

2)决策树的学习分三个步骤:特征选择、决策树的生成、决策树的修剪。

3)决策树能表示给定特征条件下的条件概率分布。

4)决策树学习本质上是从训练数据集中归纳出一组分类规则。

5)决策树学习根据损失函数最小化建立模型,损失函数通常是正则化的极大似然函数,决策树学习的策略是以损失函数为目标函数的最小化。

二、特征选择

1)特征选择(划分选择)是为了使结点纯度更高。

2)特征选择的准则是信息增益或信息增益比。

3)信息增益:(ID3算法)

①定义:表示由于特征A使得对数据集D进行分类的不确定性减少的程度。

②公式:g(D,A)=H(D)-H(D|A)

③含义:值越大,样本集合用属性A来进行划分所获得的“纯度提升”越大,信息增益大的特征具有更强的分类能力。

信息增益率→C4.5算法

基尼指数→CART算法

信息增益和增益率越大越好,基尼指数越小越好。

4)ID3算法的核心是在决策树各个结点上应用信息增益准则选择特征,递归地构建决策树

三、决策树的剪枝

1)在决策树学习中将已生成的树进行简化的过程称为剪枝,通过极小化决策树整体的损失函数或代价函数来实现。

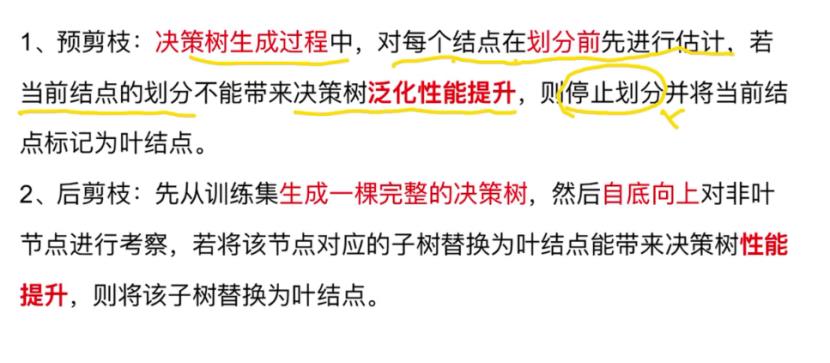

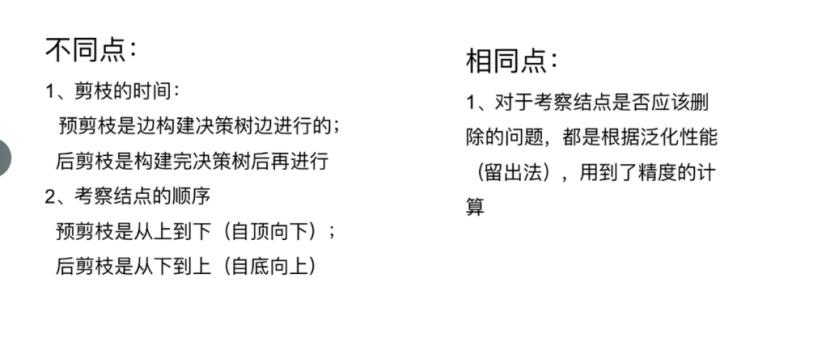

2)分类:预剪枝、后剪枝

两者对比:

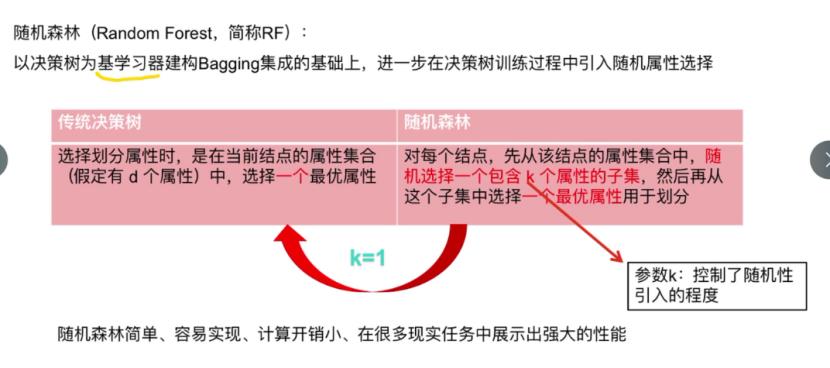

四、随机森林

定义:随机森林就是通过集成学习的思想将多棵树集成的一种算法,它的基本单元是决策树,而它的本质属于集成学习方法。

以上是关于机器学习笔记五 决策树的主要内容,如果未能解决你的问题,请参考以下文章