使用Tensorflow训练BP神经网络实现鸢尾花分类

Posted 你,好

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了使用Tensorflow训练BP神经网络实现鸢尾花分类相关的知识,希望对你有一定的参考价值。

Hello,兄弟们,开始搞深度学习了,今天出第一篇博客,小白一枚,如果发现错误请及时指正,万分感谢。

使用软件

Python 3.8,Tensorflow2.0

问题描述

鸢尾花主要分为狗尾草鸢尾(0)、杂色鸢尾(1)、弗吉尼亚鸢尾(2)。

人们发现通过计算鸢尾花的花萼长、花萼宽、花瓣长、花瓣宽可以将鸢尾花分类。

所以只要给出足够多的鸢尾花花萼、花瓣数据,以及对应种类,使用合适的神经网络训练,就可以实现鸢尾花分类。

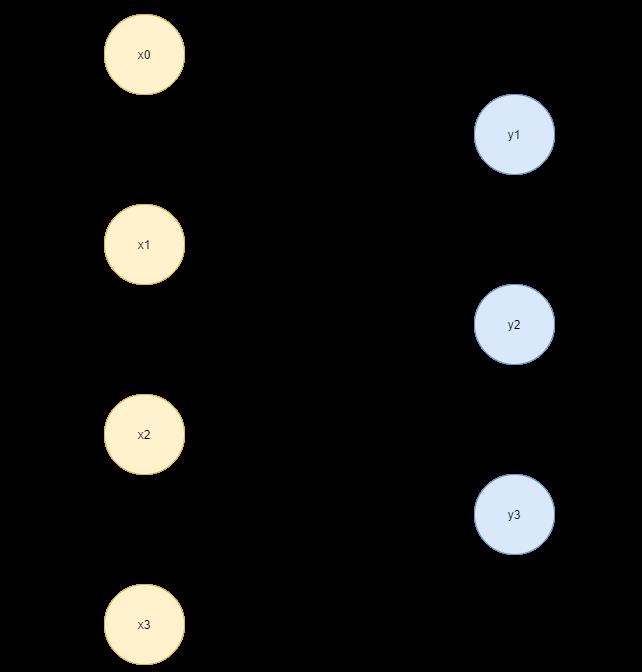

搭建神经网络

输入数据是花萼长、花萼宽、花瓣长、花瓣宽,是n行四列的矩阵。

而输出的是每个种类的概率,是n行三列的矩阵。

我们采用BP神经网络,设X为输入数据,Y为输出数据,W为权重,B偏置。有

y

=

x

∗

w

+

b

y = x*w+b

y=x∗w+b

因为x为n行四列的矩阵,y为n行三列的矩阵,所以w必须为四行三列的矩阵,每个神经元对应一个b,所以b为一行三列的的矩阵。

神经网络如下图。

所以,只要找到合适的w和b,就能准确判断鸢尾花的种类。

下面就开始对这两个参数进行训练。

训练参数

损失函数

损失函数表达的是预测值(y*)和真实值(y)的差距,我们采用均方误差公式作为损失函数。

M

S

E

(

y

,

y

∗

)

=

∑

i

=

0

n

(

y

−

y

∗

)

2

n

=

l

o

s

s

MSE(y, y*) = {\\sum_{i=0}^n (y-y*)^2 \\over n} = loss

MSE(y,y∗)=n∑i=0n(y−y∗)2=loss

损失函数值越小,说明预测值和真实值越接近,w和b就越合适。

如果人来一组一组试,那肯定是不行的。所以我们采用梯度下降算法来找到损失函数最小值。

梯度:对函数求偏导的向量。梯度下降的方向就是函数减少的方向。

w

t

+

1

=

w

t

−

a

∗

∂

l

o

s

s

∂

w

b

t

+

1

=

b

t

−

a

∗

∂

l

o

s

s

∂

b

w_{t+1} = w_t - a*\\frac{\\partial loss}{\\partial w} \\qquad b_{t+1} = b_t - a*\\frac{\\partial loss}{\\partial b}

wt+1=wt−a∗∂w∂lossbt+1=bt−a∗∂b∂loss

其中a为学习率,即梯度下降的步长,如果a太大,就可能错过最优值,如果a太小,则就需要更多步才能找到最优值。所以选择合适的学习率很关键。

参数优化

通过反向传播来优化参数。

反向传播:从后向前,逐层求损失函数对每层神经元参数的偏导数,迭代更新所有参数。

比如

l

o

s

s

=

w

2

∂

l

o

s

s

∂

w

=

2

w

loss = w^2 \\qquad \\frac{\\partial loss}{\\partial w} = 2w

loss=w2∂w∂loss=2w

初始化w为5,学习率a为0.3,带入

w

t

+

1

=

w

t

−

a

∗

∂

l

o

s

s

∂

w

w_{t+1} = w_t - a*\\frac{\\partial loss}{\\partial w}

wt+1=wt−a∗∂w∂loss

| 序号 | w t w_t wt | w t + 1 w_{t+1} wt+1 |

|---|---|---|

| 1 | 5 | 5-0.3*(2*5) = 2 |

| 2 | 2 | 2-0.3*(2*2) = 0.8 |

| 3 | 0.8 | 0.8-0.3*(2*0.8) = 0.32 |

| … | … | … |

可以看到w会逐渐趋向于loss的最小值0。

以上就是我们训练的全部关键点。

代码

数据集

我们使用sklearn包提供的鸢尾花数据集。共150组数据。

打乱保证数据的随机性,取前120个为训练集,后30个为测试集。

# 导入数据,分别为输入特征和标签

x_data = datasets.load_iris().data ## 存花萼、花瓣特征数据

y_data = datasets.load_iris().target # 存对应种类

# 随机打乱数据(因为原始数据是顺序的,顺序不打乱会影响准确率)

# seed: 随机数种子,是一个整数,当设置之后,每次生成的随机数都一样(为方便教学,以保每位同学结果一致)

np.random.seed(116) # 使用相同的seed,保证输入特征和标签一一对应

np.random.shuffle(x_data)

np.random.seed(116)

np.random.shuffle(y_data)

tf.random.set_seed(116)

# 将打乱后的数据集分割为训练集和测试集,训练集为前120行,测试集为后30行

x_train = x_data[:-30]

y_train = y_data[:-30]

x_test = x_data[-30:]

y_test = y_data[-30:]

# 转换x的数据类型,否则后面矩阵相乘时会因数据类型不一致报错

x_train = tf.cast(x_train, tf.float32)

x_test = tf.cast(x_test, tf.float32)

# from_tensor_slices函数使输入特征和标签值一一对应。(把数据集分批次,每个批次batch组数据)

train_db = tf.data.Dataset.from_tensor_slices((x_train, y_train)).batch(32)

test_db = tf.data.Dataset.from_tensor_slices((x_test, y_test)).batch(32)

参数

# 生成神经网络的参数,4个输入特征故,输入层为4个输入节点;因为3分类,故输出层为3个神经元

# 用tf.Variable()标记参数可训练

w1 = tf.Variable(tf.random.truncated_normal([4, 3], stddev=0.1)) # 四行三列,方差为0.1

b1 = tf.Variable(tf.random.truncated_normal([3], stddev=0.1)) # 一行三列,方差为0.1

训练

a = 0.1 # 学习率为0.1

epoch = 500 # 循环500轮

# 训练部分

for epoch in range(epoch): # 数据集级别的循环,每个epoch循环一次数据集

for step, (x_train, y_train) in enumerate(train_db): # batch级别的循环 ,每个step循环一个batch

with tf.GradientTape() as tape: # with结构记录梯度信息

y = tf.matmul(x_train, w1) + b1 # 神经网络乘加运算

y = tf.nn.softmax(y) # 使输出y符合概率分布

y_ = tf.one_hot(y_train, depth=3) # 将标签值转换为独热码格式,方便计算loss

loss = tf.reduce_mean(tf.square(y_ - y)) # 采用均方误差损失函数mse = mean(sum(y-y*)^2)

# 计算loss对w, b的梯度

grads = tape.gradient(loss, [w1, b1])

# 实现梯度更新 w1 = w1 - lr * w1_grad b = b - lr * b_grad

w1.assign_sub(a * grads[0]) # 参数w1自更新

b1.assign_sub(a * grads[1]) # 参数b自更新

测试

# 测试部分

total_correct, total_number = 0, 0

for x_test, y_test in test_db:

# 前向传播求概率

y = tf.matmul(x_test, w1) + b1

y = tf.nn.softmax(y)

predict = tf.argmax(y, axis=1) # 返回y中最大值的索引,即预测的分类

# 将predict转换为y_test的数据类型

predict = tf.cast(predict, dtype=y_test.dtype)

# 若分类正确,则correct=1,否则为0,将bool型的结果转换为int型

correct = tf.cast(tf.equal(predict, y_test), dtype=tf.int32)

# 将每个batch的correct数加起来

correct = tf.reduce_sum(correct)

# 将所有batch中的correct数加起来

total_correct += int(correct)

# total_number为测试的总样本数,也就是x_test的行数,shape[0]返回变量的行数

total_number += x_test.shape[0]

# 总的准确率等于total_correct/total_number

acc = total_correct / total_number

print("测试准确率 = %.2f %%" % (acc * 100.0))

my_test = np.array([[5.9, 3.0, 5.1, 1.8]])

print("输入 5.9 3.0 5.1 1.8")

my_test = tf.convert_to_tensor(my_test)

my_test = tf.cast(my_test, tf.float32)

y = tf.matmul(my_test, w1) + b1

y = tf.nn.softmax(y)

species = {0: "狗尾鸢尾", 1: "杂色鸢尾", 2: "弗吉尼亚鸢尾"}

predict = np.array(tf.argmax(y, axis=1))[0] # 返回y中最大值的索引,即预测的分类

print("该鸢尾花为:" + species.get(predict))

结果:

结语

以上就是全部内容,鸢尾花分类作为经典案例,应该重点掌握理解。有一起学习的伙伴可以把想法打在评论区,大家多多交流,我也会及时回复的!

以上是关于使用Tensorflow训练BP神经网络实现鸢尾花分类的主要内容,如果未能解决你的问题,请参考以下文章

BP神经网络训练自己的数据(Tensorflow2.x版本)

BP神经网络训练自己的数据(Tensorflow2.x版本)

Tensorflow2.0使用神经网络实现鸢尾花分类的详细步骤