人工智能,机器学习,深度学习,到底有何区别

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了人工智能,机器学习,深度学习,到底有何区别相关的知识,希望对你有一定的参考价值。

有人说,人工智能(AI)是未来,人工智能是科幻,人工智能也是我们日常生活中的一部分。这些评价可以说都是正确的,就看你指的是哪一种人工智能。

今年早些时候,Google DeepMind的AlphaGo打败了韩国的围棋大师李世乭九段。在媒体描述DeepMind胜利的时候,将人工智能(AI)、机器学习(machine learning)和深度学习(deep learning)都用上了。这三者在AlphaGo击败李世乭的过程中都起了作用,但它们说的并不是一回事。

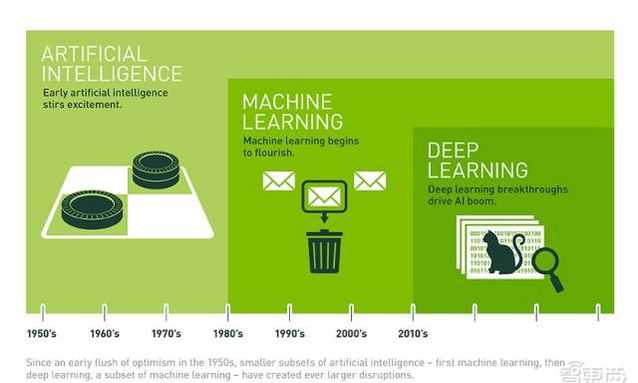

今天我们就用最简单的方法——同心圆,可视化地展现出它们三者的关系和应用。

如上图,人工智能是最早出现的,也是最大、最外侧的同心圆;其次是机器学习,稍晚一点;最内侧,是深度学习,当今人工智能大爆炸的核心驱动。

五十年代,人工智能曾一度被极为看好。之后,人工智能的一些较小的子集发展了起来。先是机器学习,然后是深度学习。深度学习又是机器学习的子集。深度学习造成了前所未有的巨大的影响。

从概念的提出到走向繁荣

1956年,几个计算机科学家相聚在达特茅斯会议(Dartmouth Conferences),提出了“人工智能”的概念。其后,人工智能就一直萦绕于人们的脑海之中,并在科研实验室中慢慢孵化。之后的几十年,人工智能一直在两极反转,或被称作人类文明耀眼未来的预言;或者被当成技术疯子的狂想扔到垃圾堆里。坦白说,直到2012年之前,这两种声音还在同时存在。

过去几年,尤其是2015年以来,人工智能开始大爆发。很大一部分是由于GPU的广泛应用,使得并行计算变得更快、更便宜、更有效。当然,无限拓展的存储能力和骤然爆发的数据洪流(大数据)的组合拳,也使得图像数据、文本数据、交易数据、映射数据全面海量爆发。

让我们慢慢梳理一下计算机科学家们是如何将人工智能从最早的一点点苗头,发展到能够支撑那些每天被数亿用户使用的应用的。

| 人工智能(Artificial Intelligence)——为机器赋予人的智能

早在1956年夏天那次会议,人工智能的先驱们就梦想着用当时刚刚出现的计算机来构造复杂的、拥有与人类智慧同样本质特性的机器。这就是我们现在所说的“强人工智能”(General AI)。这个无所不能的机器,它有着我们所有的感知(甚至比人更多),我们所有的理性,可以像我们一样思考。

人们在电影里也总是看到这样的机器:友好的,像星球大战中的C-3PO;邪恶的,如终结者。强人工智能现在还只存在于电影和科幻小说中,原因不难理解,我们还没法实现它们,至少目前还不行。

我们目前能实现的,一般被称为“弱人工智能”(Narrow AI)。弱人工智能是能够与人一样,甚至比人更好地执行特定任务的技术。例如,Pinterest上的图像分类;或者Facebook的人脸识别。

这些是弱人工智能在实践中的例子。这些技术实现的是人类智能的一些具体的局部。但它们是如何实现的?这种智能是从何而来?这就带我们来到同心圆的里面一层,机器学习。

| 机器学习—— 一种实现人工智能的方法

机器学习最基本的做法,是使用算法来解析数据、从中学习,然后对真实世界中的事件做出决策和预测。与传统的为解决特定任务、硬编码的软件程序不同,机器学习是用大量的数据来“训练”,通过各种算法从数据中学习如何完成任务。

机器学习直接来源于早期的人工智能领域。传统算法包括决策树学习、推导逻辑规划、聚类、强化学习和贝叶斯网络等等。众所周知,我们还没有实现强人工智能。早期机器学习方法甚至都无法实现弱人工智能。

机器学习最成功的应用领域是计算机视觉,虽然也还是需要大量的手工编码来完成工作。人们需要手工编写分类器、边缘检测滤波器,以便让程序能识别物体从哪里开始,到哪里结束;写形状检测程序来判断检测对象是不是有八条边;写分类器来识别字母“ST-O-P”。使用以上这些手工编写的分类器,人们总算可以开发算法来感知图像,判断图像是不是一个停止标志牌。

这个结果还算不错,但并不是那种能让人为之一振的成功。特别是遇到云雾天,标志牌变得不是那么清晰可见,又或者被树遮挡一部分,算法就难以成功了。这就是为什么前一段时间,计算机视觉的性能一直无法接近到人的能力。它太僵化,太容易受环境条件的干扰。

随着时间的推进,学习算法的发展改变了一切。

| 深度学习——一种实现机器学习的技术

人工神经网络(Artificial Neural Networks)是早期机器学习中的一个重要的算法,历经数十年风风雨雨。神经网络的原理是受我们大脑的生理结构——互相交叉相连的神经元启发。但与大脑中一个神经元可以连接一定距离内的任意神经元不同,人工神经网络具有离散的层、连接和数据传播的方向。

例如,我们可以把一幅图像切分成图像块,输入到神经网络的第一层。在第一层的每一个神经元都把数据传递到第二层。第二层的神经元也是完成类似的工作,把数据传递到第三层,以此类推,直到最后一层,然后生成结果。

每一个神经元都为它的输入分配权重,这个权重的正确与否与其执行的任务直接相关。最终的输出由这些权重加总来决定。

我们仍以停止(Stop)标志牌为例。将一个停止标志牌图像的所有元素都打碎,然后用神经元进行“检查”:八边形的外形、救火车般的红颜色、鲜明突出的字母、交通标志的典型尺寸和静止不动运动特性等等。神经网络的任务就是给出结论,它到底是不是一个停止标志牌。神经网络会根据所有权重,给出一个经过深思熟虑的猜测——“概率向量”。

这个例子里,系统可能会给出这样的结果:86%可能是一个停止标志牌;7%的可能是一个限速标志牌;5%的可能是一个风筝挂在树上等等。然后网络结构告知神经网络,它的结论是否正确。

即使是这个例子,也算是比较超前了。直到前不久,神经网络也还是为人工智能圈所淡忘。其实在人工智能出现的早期,神经网络就已经存在了,但神经网络对于“智能”的贡献微乎其微。主要问题是,即使是最基本的神经网络,也需要大量的运算。神经网络算法的运算需求难以得到满足。

不过,还是有一些虔诚的研究团队,以多伦多大学的Geoffrey Hinton为代表,坚持研究,实现了以超算为目标的并行算法的运行与概念证明。但也直到GPU得到广泛应用,这些努力才见到成效。

我们回过头来看这个停止标志识别的例子。神经网络是调制、训练出来的,时不时还是很容易出错的。它最需要的,就是训练。需要成百上千甚至几百万张图像来训练,直到神经元的输入的权值都被调制得十分精确,无论是否有雾,晴天还是雨天,每次都能得到正确的结果。

只有这个时候,我们才可以说神经网络成功地自学习到一个停止标志的样子;或者在Facebook的应用里,神经网络自学习了你妈妈的脸;又或者是2012年吴恩达(Andrew Ng)教授在Google实现了神经网络学习到猫的样子等等。

吴教授的突破在于,把这些神经网络从基础上显著地增大了。层数非常多,神经元也非常多,然后给系统输入海量的数据,来训练网络。在吴教授这里,数据是一千万YouTube视频中的图像。吴教授为深度学习(deep learning)加入了“深度”(deep)。这里的“深度”就是说神经网络中众多的层。

现在,经过深度学习训练的图像识别,在一些场景中甚至可以比人做得更好:从识别猫,到辨别血液中癌症的早期成分,到识别核磁共振成像中的肿瘤。Google的AlphaGo先是学会了如何下围棋,然后与它自己下棋训练。它训练自己神经网络的方法,就是不断地与自己下棋,反复地下,永不停歇。

| 深度学习,给人工智能以璀璨的未来

深度学习使得机器学习能够实现众多的应用,并拓展了人工智能的领域范围。深度学习摧枯拉朽般地实现了各种任务,使得似乎所有的机器辅助功能都变为可能。无人驾驶汽车,预防性医疗保健,甚至是更好的电影推荐,都近在眼前,或者即将实现。

人工智能就在现在,就在明天。有了深度学习,人工智能甚至可以达到我们畅想的科幻小说一般。你的C-3PO我拿走了,你有你的终结者就好了。

参考技术A 都是一个意思,程序经过大数据进行筛选对比分析 参考技术B 摘要: 英国金斯顿大学(Kingston University)的专家将探讨如何将受到人眼启发的人工视觉系统用于未来的机器人——这为在森林深处、战区甚至遥远的行星获取固定镜头带来了新的可能。《每日科学》网刊登了来自英国金斯顿大学的文章,称科学家将为机器人装配人工智能视觉技术。

英国金斯顿大学(Kingston University)的专家将探讨如何将受到人眼启发的人工视觉系统用于未来的机器人——这为在森林深处、战区甚至遥远的行星获取固定镜头带来了新的可能。

这项为期三年的研究项目与伦敦国王学院(King's College London)和伦敦大学学院(University College London)合作,研究如何采集、压缩这些最先进的摄像头所提供的数据,并以远低于现在的能源消耗在机器之间进行数据传输。

该项目得到了英国工程和自然科学研究委员会(Engineering and Physical Sciences Research Council)130万英镑的资助,将致力于利用新开发的动态视觉传感器进行学术研究。这种传感器只更新图像中产生移动的部分,大大降低了对计算能力和数据存储的要求。

这些神经形态传感器模仿哺乳动物的眼睛处理信息的方式,能够快速有效地检测其视野中的光线变化,一位研究人员指出。在该项目中,她领导团队寻找创新的方法来处理和传播通过传感器获得的信息。

“传统的摄像头技术可以在一系列单独的帧或图像中采集视频。如果其中的某些区域比另一些区域变动更多,就可能导致资源浪费。”该研究人员指出,“在一个真正的动态场景中,例如爆炸,由于帧率和处理能力的限制,且使用了太多的数据来表示静态区域,导致最终不能准确采集快速移动的部分。”“但这些传感器是由一家正与我们就该项目进行合作的公司生产,它们会按照不同的速度对现场的不同部分进行采样,且仅在光线条件发生变化时才获取信息。”

这大大降低了摄像头的能源和处理需求。在项目进行期间,研究团队将研究如何从动态视觉传感器中高效地获取高质量的镜头,然后在机器之间共享或上传到云端服务器。

据该研究人员介绍,该研究还可能对这种传感器在医学领域的应用产生广泛的影响。“这种节能措施为机器人、无人机和下一代视网膜植入物等打开了新世界,极大地扩展了这些设备的监视作用和其他用途。”她说,“它们可以用于人类无法进入且无法为电池充电的小型设备中。”

“有时传感器被从飞机上扔到森林里,并停留多年。这样做的目的是让配备了这些传感器的不同设备能够相互高效地共享高质量的数据,而不需要人的干预。”

作为项目的一部分,该团队将探讨这些传感器如何作为物联网(IoT)的一部分协同发挥作用。物联网是通过互联网连接的可以远程操作的设备。 参考技术C 从2015年下半年开始,“人工智能(AI)”一词逐渐出现在了大众的视野当中。近两年来,无论是资本、政府或是民众,对人工智能的关注持续升温:各类人工智能相关创业公司纷纷获得可观的融资,政府的工作报告中多次提到“人工智能”,百度的搜索指数也反映了这一趋势。

不过,“人工智能”并不是自己一个人火起来的,他还有两个形影不离的队友:“机器学习”与“深度学习”。这三个词如同天团组合一般,出现在各种地方,有时甚至互为化身。那么问题来了,人工智能、机器学习、深度学习三者到底是什么关系?它们之间有什么联系与区别?我们这里不干劈概念,从人工智能的发展历程说起。

人工智能的前世今身

1956年夏天,以麦卡锡(John McCarthy)、明斯基(Marvin Minsky)、罗切斯特(Nathaniel Rochester)和香农(Claude Shannon)等为首的一批年轻科学家相聚达特茅斯,共同研究和探讨用机器模拟智能的一系列有关问题(史称“达特茅斯会议”)。在那次会议上,“人工智能”一词被提出,也标志着“人工智能”这门新兴学科的正式诞生。

当时的人工智能研究处于“推理期”,人们认为只要能赋予机器逻辑推理的能力,机器就会具有智能。当时的研究的确取得了一定的成果,比如证明了不少数学定理,部分定理的证明方式甚至比数学家的更为巧妙。

然而,人类的智能不仅来源于逻辑推理能力,也来源于大量经验和知识。比方说假如我从未坐过飞机也从未给别人买过机票,当你问我明天飞北京的机票多少钱,我估计会懵逼,连查携程都不知道,从而显得不那么“智能”,但其实我的推理能力并没有掉线。从20世纪70年代开始,人工智能研究进入了“知识期”,人们希望在推理的基础上,把各领域的知识总结起来告诉机器,让它获得智能。当时大量的专家系统(具有大量的专门知识与经验的程序系统,可进行推理和判断,模拟人类专家的决策过程)问世,在很多应用领域取得了不少成果。

但人们很快认识到,把知识总结起来教给机器是非常困难的(称为“知识工程瓶颈”),因为人类的知识实在太多,还得把这些知识写成机器能够理解的形式。如果我们能够只给机器一些相对原始的数据,然后让机器自己去进行学习,那该多好。所以从20世纪80年代开始,机器学习这一技术路线逐渐主导了人工智能的研究,直到现在。

什么是机器学习

机器学习可以理解为机器从已知的经验数据(样本)中,通过某种特定的方法(算法),自己去寻找提炼(训练/学习)出一些规律(模型);提炼出的规律就可以用来判断一些未知的事情(预测)。

比如我们接触了1w只单身汪(已知样本),通过归纳总结与比较(算法)找出TA们身上一些共性特点,然后将这些共性特点作为判断单身汪的依据(模型),那么下次遇到一个人(未知样本),就可以判断TA是不是单身了(预测)。

既然是从一堆已知的样本中找规律,那么找规律的方式以及找出的规律的形态就会因人而异,也就是算法与模型都可能会有所不同。所以,机器学习本身也是分为不同流派的,每种流派都有它代表性的模型与算法。机器学习主要分为符号主义学习(以决策树模型与相关算法为代表)、连接主义学习(以神经网络模型与相关算法为代表)与统计学习(以支持向量机与相关算法为代表)。符号主义学习与连接主义学习在20世纪80年代至90年代中期非常流行,统计学习则从90年代中期开始迅速占据舞台。值得一提的是,为判断一个人是否为单身汪而找出的一系列特征规律其实就是一棵决策树。

深度学习的崛起

进入21世纪之后,互联网与移动互联网的兴起造成了数据量的爆发式增长,云计算也使得计算能力大幅增强,同时神经网络的相关算法也逐渐成熟,所以导致连接主义的代表——神经网络卷土重来。再次归来的神经网络,往往拥有比原先更为庞大的网络层级结构,所以被称为“深度神经网络”。由于有足够的训练数据和计算能力,深度神经网络在很多(尤其是语音处理、自然语言处理、图像处理等较为复杂的)任务中取得了非常优异的性能。性能的突破促成了人工智能在语音识别、文本翻译、人脸识别等一系列场景的应用,让大家看到了新技术落地所带来的经济效益与想象空间,从而引起了人工智能的热潮。

总结

说了这么多,下面用一幅图来说明人工智能的技术流派类别与演变历程。要注意的是,虽然人工智能的流派在不断演变,但这并非说明过去的技术路线就被抛弃了。这更像是以实际应用为导向的各领风骚——在一个时代,某种技术流派正好能够较好地解决这个时代所需要去解决的实际产业问题,那么自然就会流行。目前有很多不同的机器学习技术正应用于各自适合的场景,比如作为统计学习代表的支持向量机,仍然是文本分类任务的首选技术。

最后来回答文章题目中的问题。人工智能是一个大的概念,是研究如何使机器获得智能的学科;机器学习是人工智能中的一个技术流派,通过从已知样本中提炼规律来获得判断未知样本的“智能”;深度学习则是机器学习的一种,它所学习出来的模型是深度神经网络。 参考技术D 神经网络,机器学习

一张图看懂AI机器学习和深度学习的区别

转自https://blog.csdn.net/dukai392/article/details/70271574

AI(人工智能)是未来,是科幻小说,是我们日常生活的一部分。所有论断都是正确的,只是要看你所谈到的AI到底是什么。

例如,当谷歌DeepMind开发的AlphaGo程序打败韩国职业围棋高手Lee Se-dol,媒体在描述DeepMind的胜利时用到了AI、机器学习、深度学习等术语。AlphaGo之所以打败Lee

Se-dol,这三项技术都立下了汗马功劳,但它们并不是一回事。

要搞清它们的关系,最直观的表述方式就是同心圆,最先出现的是理念,然后是机器学习,当机器学习繁荣之后就出现了深度学习,今天的AI大爆发是由深度学习驱动的。

从衰败到繁荣

1956年,在达特茅斯会议(Dartmouth Conferences)上,计算机科学家首次提出了“AI”术语,AI由此诞生,在随后的日子里,AI成为实验室的“幻想对象”。几十年过去了,人们对AI的看法不断改变,有时会认为AI是预兆,是未来人类文明的关键,有时认为它只是技术垃圾,只是一个轻率的概念,野心过大,注定要失败。坦白来讲,直到2012年AI仍然同时具有这两种特点。

在过去几年里,AI大爆发,2015年至今更是发展迅猛。之所以飞速发展主要归功于GPU的广泛普及,它让并行处理更快、更便宜、更强大。还有一个原因就是实际存储容量无限拓展,数据大规模生成,比如图片、文本、交易、地图数据信息。

AI:让机器展现出人类智力

回到1956年夏天,在当时的会议上,AI先驱的梦想是建造一台复杂的机器(让当时刚出现的计算机驱动),然后让机器呈现出人类智力的特征。

这一概念就是我们所说的“强人工智能(General AI)”,也就是打造一台超棒的机器,让它拥有人类的所有感知,甚至还可以超越人类感知,它可以像人一样思考。在电影中我们经常会看到这种机器,比如

C-3PO、终结者。

还有一个概念是“弱人工智能(Narrow AI)”。简单来讲,“弱人工智能”可以像人类一样完成某些具体任务,有可能比人类做得更好,例如,Pinterest服务用AI给图片分类,Facebook用AI识别脸部,这就是“弱人工智能”。

上述例子是“弱人工智能”实际使用的案例,这些应用已经体现了一些人类智力的特点。怎样实现的?这些智力来自何处?带着问题我们深入理解,就来到下一个圆圈,它就是机器学习。

机器学习:抵达AI目标的一条路径

大体来讲,机器学习就是用算法真正解析数据,不断学习,然后对世界中发生的事做出判断和预测。此时,研究人员不会亲手编写软件、确定特殊指令集、然后让程序完成特殊任务,相反,研究人员会用大量数据和算法“训练”机器,让机器学会如何执行任务。

机器学习这个概念是早期的AI研究者提出的,在过去几年里,机器学习出现了许多算法方法,包括决策树学习、归纳逻辑程序设计、聚类分析(Clustering)、强化学习、贝叶斯网络等。正如大家所知的,没有人真正达到“强人工智能”的终极目标,采用早期机器学习方法,我们连“弱人工智能”的目标也远没有达到。

在过去许多年里,机器学习的最佳应用案例是“计算机视觉”,要实现计算机视觉,研究人员仍然需要手动编写大量代码才能完成任务。研究人员手动编写分级器,比如边缘检测滤波器,只有这样程序才能确定对象从哪里开始,到哪里结束;形状侦测可以确定对象是否有8条边;分类器可以识别字符“S-T-O-P”。通过手动编写的分组器,研究人员可以开发出算法识别有意义的形象,然后学会下判断,确定它不是一个停止标志。

这种办法可以用,但并不是很好。如果是在雾天,当标志的能见度比较低,或者一棵树挡住了标志的一部分,它的识别能力就会下降。直到不久之前,计算机视觉和图像侦测技术还与人类的能力相去甚远,因为它太容易出错了。

深度学习:实现机器学习的技术

“人工神经网络(Artificial Neural Networks)”是另一种算法方法,它也是早期机器学习专家提出的,存在已经几十年了。神经网络(Neural Networks)的构想源自于我们对人类大脑的理解——神经元的彼此联系。二者也有不同之处,人类大脑的神经元按特定的物理距离连接的,人工神经网络有独立的层、连接,还有数据传播方向。

例如,你可能会抽取一张图片,将它剪成许多块,然后植入到神经网络的第一层。第一层独立神经元会将数据传输到第二层,第二层神经元也有自己的使命,一直持续下去,直到最后一层,并生成最终结果。

每一个神经元会对输入的信息进行权衡,确定权重,搞清它与所执行任务的关系,比如有多正确或者多么不正确。最终的结果由所有权重来决定。以停止标志为例,我们会将停止标志图片切割,让神经元检测,比如它的八角形形状、红色、与众不同的字符、交通标志尺寸、手势等。

神经网络的任务就是给出结论:它到底是不是停止标志。神经网络会给出一个“概率向量”,它依赖于有根据的推测和权重。在该案例中,系统有86%的信心确定图片是停止标志,7%的信心确定它是限速标志,有5%的信心确定它是一支风筝卡在树上,等等。然后网络架构会告诉神经网络它的判断是否正确。

即使只是这么简单的一件事也是很超前的,不久前,AI研究社区还在回避神经网络。在AI发展初期就已经存在神经网络,但是它并没有形成多少“智力”。问题在于即使只是基本的神经网络,它对计算量的要求也很高,因此无法成为一种实际的方法。尽管如此,还是有少数研究团队勇往直前,比如多伦多大学Geoffrey Hinton所领导的团队,他们将算法平行放进超级电脑,验证自己的概念,直到GPU开始广泛采用我们才真正看到希望。

回到识别停止标志的例子,如果我们对网络进行训练,用大量的错误答案训练网络,调整网络,结果就会更好。研究人员需要做的就是训练,他们要收集几万张、甚至几百万张图片,直到人工神经元输入的权重高度精准,让每一次判断都正确为止——不管是有雾还是没雾,是阳光明媚还是下雨都不受影响。这时神经网络就可以自己“教”自己,搞清停止标志的到底是怎样的;它还可以识别Facebook的人脸图像,可以识别猫——吴恩达(Andrew

Ng)2012年在谷歌做的事情就是让神经网络识别猫。

吴恩达的突破之处在于:让神经网络变得无比巨大,不断增加层数和神经元数量,让系统运行大量数据,训练它。吴恩达的项目从1000万段YouTube视频调用图片,他真正让深度学习有了“深度”。

到了今天,在某些场景中,经过深度学习技术训练的机器在识别图像时比人类更好,比如识别猫、识别血液中的癌细胞特征、识别MRI扫描图片中的肿瘤。谷歌AlphaGo学习围棋,它自己与自己不断下围棋并从中学习。

有了深度学习AI的未来一片光明

有了深度学习,机器学习才有了许多实际的应用,它还拓展了AI的整体范围。 深度学习将任务分拆,使得各种类型的机器辅助变成可能。无人驾驶汽车、更好的预防性治疗、更好的电影推荐要么已经出现,要么即使出现。AI既是现在,也是未来。有了深度学习的帮助,也许到了某一天AI会达到科幻小说描述的水平,这正是我们期待已久的。你会有自己的C-3PO,有自己的终结者。

以上是关于人工智能,机器学习,深度学习,到底有何区别的主要内容,如果未能解决你的问题,请参考以下文章