Solr 6.2 搭建搜索引擎应用实践

Posted 猿人课堂

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Solr 6.2 搭建搜索引擎应用实践相关的知识,希望对你有一定的参考价值。

一、前言

在开发网站/App项目的时候,通常需要搭建搜索服务。比如,新闻类应用需要检索标题/内容,社区类应用需要检索用户/帖子。

对于简单的需求,可以使用数据库的 LIKE 模糊搜索,示例:

SELECT * FROM news WHERE title LIKE '%法拉利跑车%'

可以查询到所有标题含有 "法拉利跑车" 关键词的新闻,但是这种方式有明显的弊端:

1、模糊查询性能极低,当数据量庞大的时候,往往会使数据库服务中断;

2、无法查询相关的数据,只能严格在标题中匹配关键词。

因此,需要搭建专门提供搜索功能的服务,具备分词、全文检索等高级功能。 Solr 就是这样一款搜索引擎,可以让你快速搭建适用于自己业务的搜索服务。

二、安装

到官网 http://lucene.apache.org/solr/ 下载安装包,解压并进入 Solr 目录:

wget 'http://apache.website-solution.net/lucene/solr/6.2.0/solr-6.2.0.tgz'

tar xvf solr-6.2.0.tgz

cd solr-6.2.0

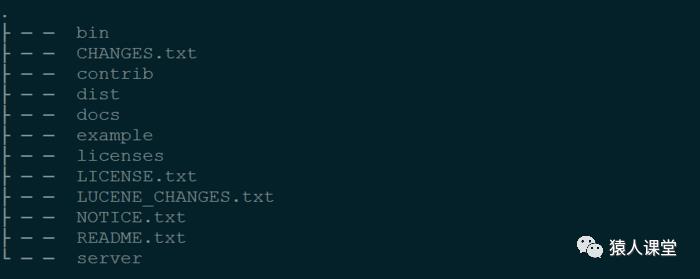

目录结构如下:

Solr 6.2 目录结构

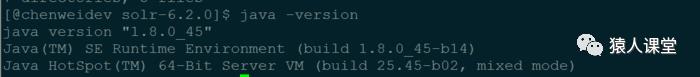

启动 Solr 服务之前,确认已经安装 Java 1.8 :

查看 Java 版本

启动 Solr 服务:

./bin/solr start -m 1g

Solr 将默认监听 8983 端口,其中 -m 1g 指定分配给 JVM 的内存为 1 G。

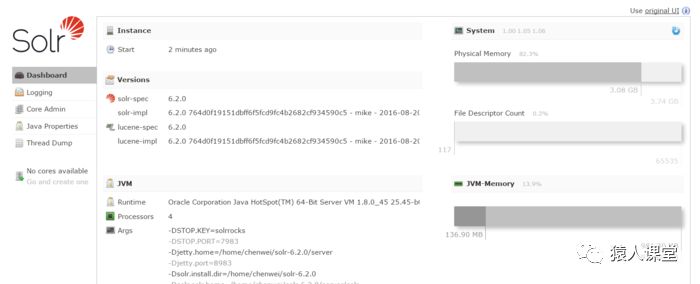

在浏览器中访问 Solr 管理后台:

http://127.0.0.1:8983/solr/#/

Solr 管理后台

创建 Solr 应用:

./bin/solr create -c my_news

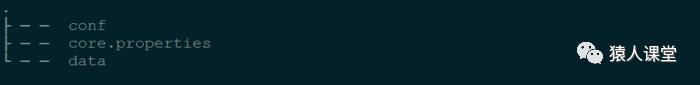

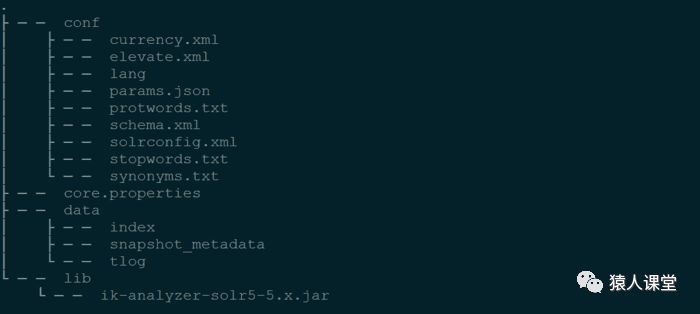

可以在 solr-6.2.0/server/solr 目录下生成 my_news 文件夹,结构如下:

my_news 目录结构

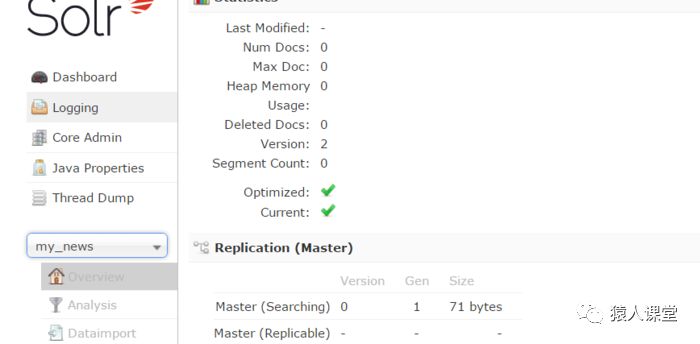

同时,可以在管理后台看到 my_news:

管理后台

三、创建索引

我们将从 mysql 数据库中导入数据到 Solr 并建立索引。

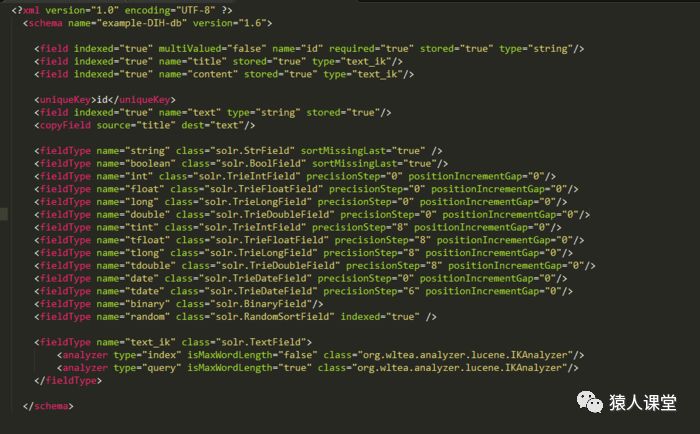

首先,需要了解 Solr 中的两个概念: 字段(field) 和 字段类型(fieldType),配置示例如下:

schema.xml 示例

field 指定一个字段的名称、是否索引/存储和字段类型。

fieldType 指定一个字段类型的名称以及在查询/索引的时候可能用到的分词插件。

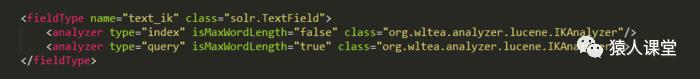

将 solr-6.2.0\server\solr\my_news\conf 目录下默认的配置文件 managed-schema 重命名为 schema.xml 并加入新的 fieldType:

分词类型

在 my_news 目录下创建 lib 目录,将用到的分词插件 ik-analyzer-solr5-5.x.jar 加到 lib 目录,结构如下:

my_news 目录结构

在 Solr 安装目录下重启服务:

./bin/solr restart

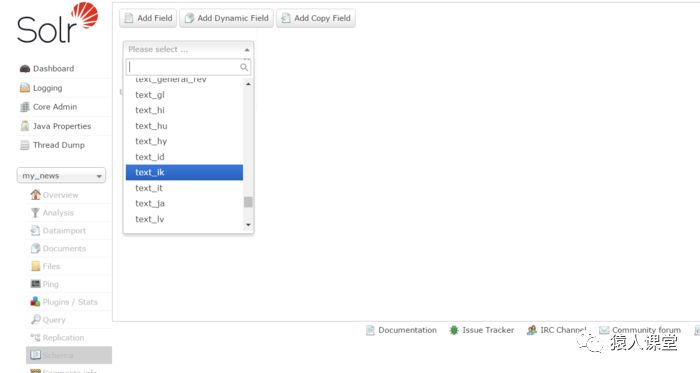

可以在管理后台看到新加的类型:

text_ik 类型

接下来创建和我们数据库字段对应的 field:title 和 content,类型选为 text_ik:

新建字段 title

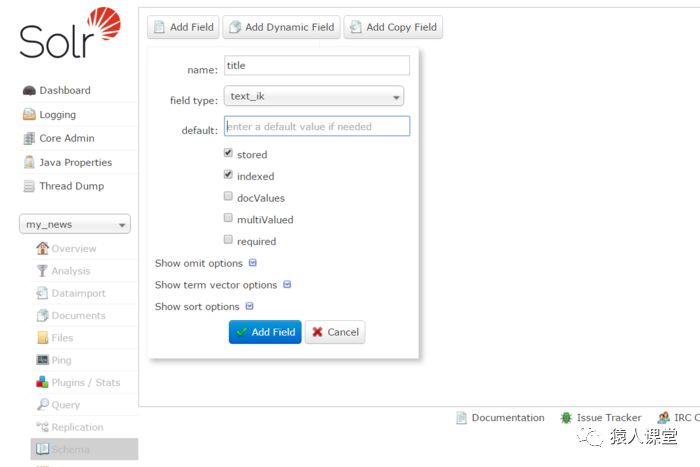

将要导入数据的 MySQL 数据库表结构:

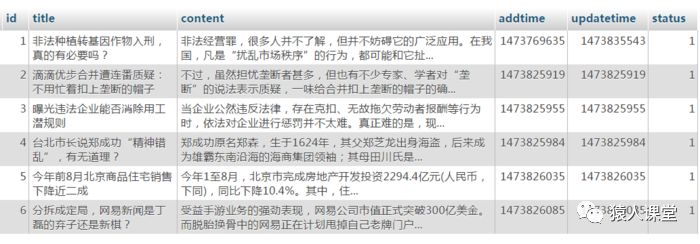

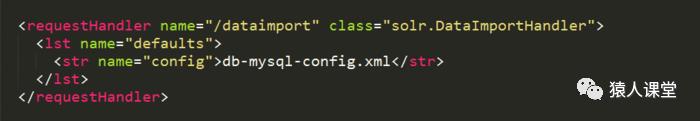

编辑 conf/solrconfig.xml 文件,加入类库和数据库配置:

类库

dataimport config

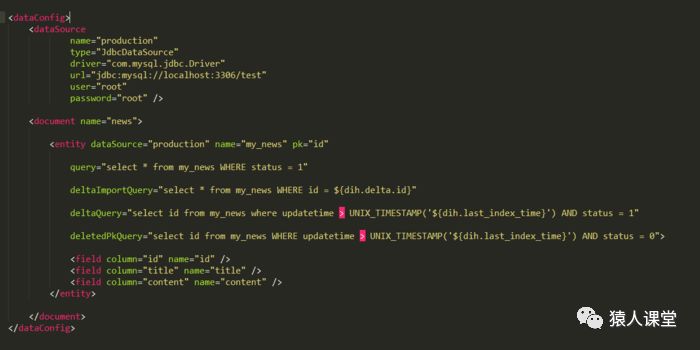

同时新建数据库连接配置文件 conf/db-mysql-config.xml ,内容如下:

数据库配置文件

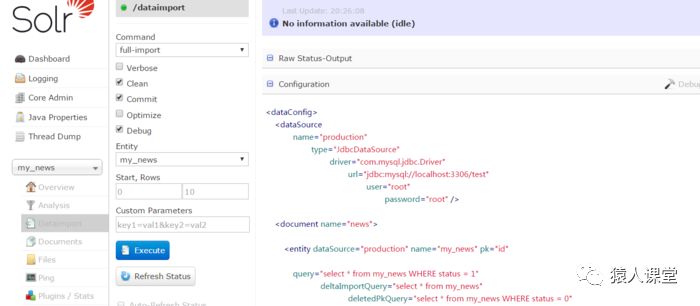

将数据库连接组件 mysql-connector-java-5.1.39-bin.jar 放到 lib 目录下,重启 Solr,访问管理后台,执行全量导入数据:

全量导入数据

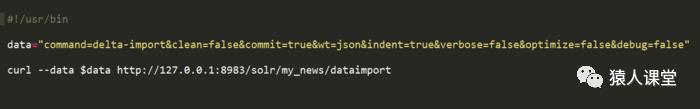

创建定时更新脚本:

定时更新脚本

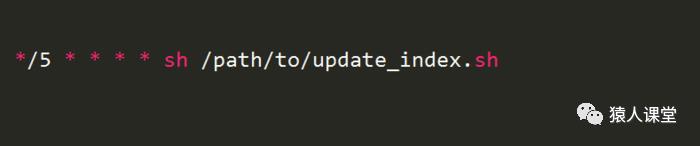

加入到定时任务,每5分钟增量更新一次索引:

定时任务

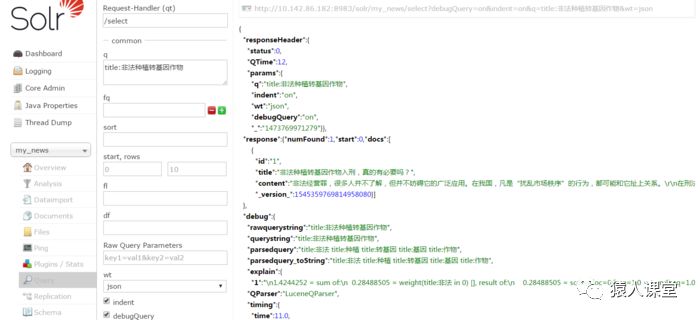

在 Solr 管理后台测试搜索结果:

分词搜索结果

至此,基本的搜索引擎搭建完毕,外部应用只需通过 http 协议提供查询参数,就可以获取搜索结果。

四、搜索干预

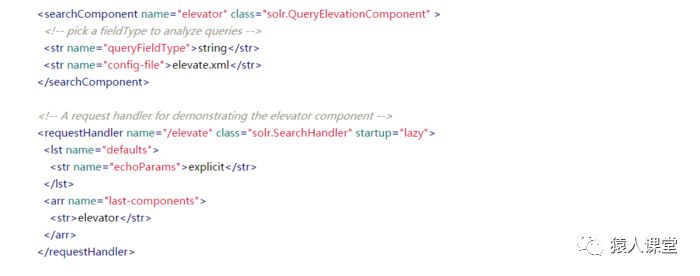

通常需要对搜索结果进行人工干预,比如编辑推荐、竞价排名或者屏蔽搜索结果。Solr 已经内置了 QueryElevationComponent 插件,可以从配置文件中获取搜索关键词对应的干预列表,并将干预结果排在搜索结果的前面。

在 solrconfig.xml 文件中,可以看到:

干预其请求配置

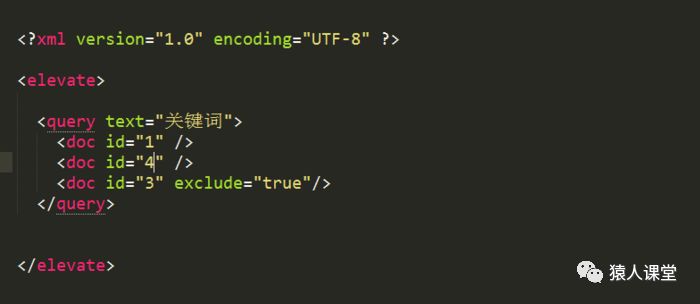

定义了搜索组件 elevator,应用在 /elevate 的搜索请求中,干预结果的配置文件在 solrconfig.xml 同目录下的 elevate.xml 中,干预配置示例:

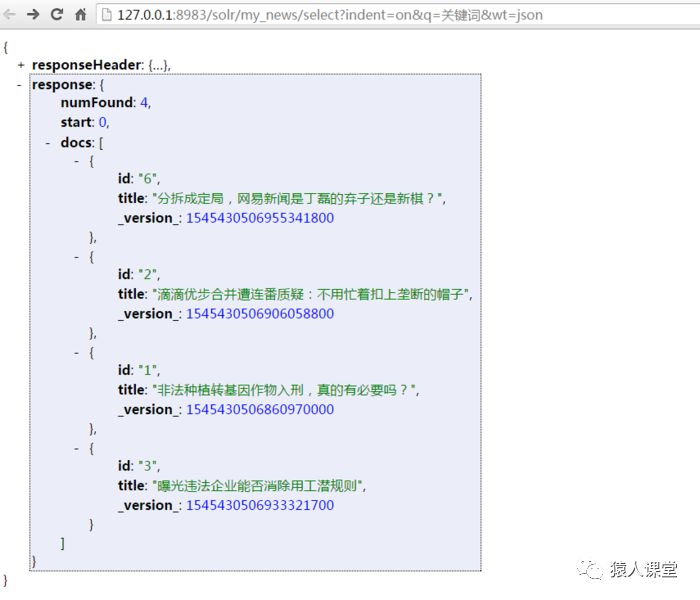

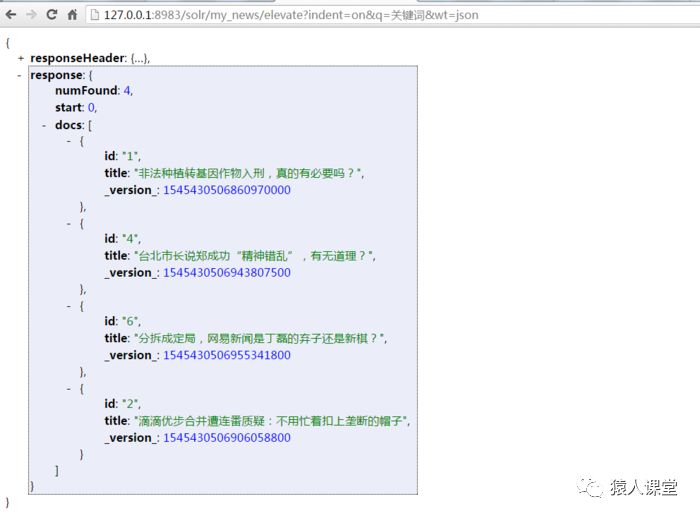

重启 Solr ,当搜索 "关键词" 的时候,id 为 1和 4 的文档将出现在前面,同时 id = 3 的文档被排除在结果之外,可以看到,没有干预的时候,搜索结果为:

无干预结果

当有搜索干预的时候:

干预结果

通过配置文件干预搜索结果,虽然简单,但是每次更新都要重启 Solr 才能生效,稍显麻烦,我们可以仿照 QueryElevationComponent 类,开发自己的干预组件,例如:从 Redis 中读取干预配置。

五、中文分词

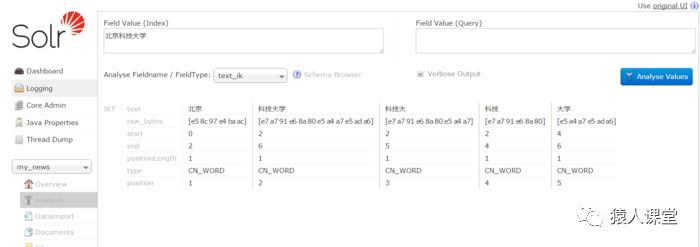

中文的搜索质量,和分词的效果息息相关,可以在 Solr 管理后台测试分词:

分词结果测试

上例可以看到,使用 IKAnalyzer 分词插件,对 “北京科技大学” 分词的测试结果。当用户搜索 “北京”、“科技大学”、“科技大”、“科技”、“大学” 这些关键词的时候,都会搜索到文本内容含 “北京科技大学” 的文档。

常用的中文分词插件有 IKAnalyzer、mmseg4j和 Solr 自带的 smartcn 等,分词效果各有优劣,具体选择哪个,可以根据自己的业务场景,分别测试效果再选择。

分词插件一般都有自己的默认词库和扩展词库,默认词库包含了绝大多数常用的中文词语。如果默认词库无法满足你的需求,比如某些专业领域的词汇,可以在扩展词库中手动添加,这样分词插件就能识别新词语了。

分词插件扩展词库配置示例

分词插件还可以指定停止词库,将某些无意义的词汇剔出分词结果,比如:“的”、“哼” 等,例如:

去除无意义的词

六、总结

以上介绍了 Solr 最常用的一些功能,Solr 本身还有很多其他丰富的功能,比如分布式部署。

希望对你有所帮助。

七、附录

1、参考资料:

https://wiki.apache.org/solr/

http://lucene.apache.org/solr/quickstart.html

https://cwiki.apache.org/confluence/display/solr/Apache+Solr+Reference+Guide

2、上述 Demo 中用到的所有配置文件、Jar 包:

https://github.com/Ceelog/OpenSchool/blob/master/my_news.zip

以上是关于Solr 6.2 搭建搜索引擎应用实践的主要内容,如果未能解决你的问题,请参考以下文章