多模态最强综述,浅显易懂娓娓道来 Generalized Visual Language Models

Posted Charmve

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了多模态最强综述,浅显易懂娓娓道来 Generalized Visual Language Models相关的知识,希望对你有一定的参考价值。

点击上方“迈微AI研习社”,选择“星标★”公众号

重磅干货,第一时间送达

多年来,人们一直在研究处理图像以生成文本,例如图像字幕和视觉问答。传统上,此类系统依赖对象检测网络作为视觉编码器来捕获视觉特征,然后通过文本解码器生成文本。鉴于现有的大量文献,在这篇文章中,我想只关注解决视觉语言任务的一种方法,即扩展预训练的通用语言模型以能够消费视觉信号。

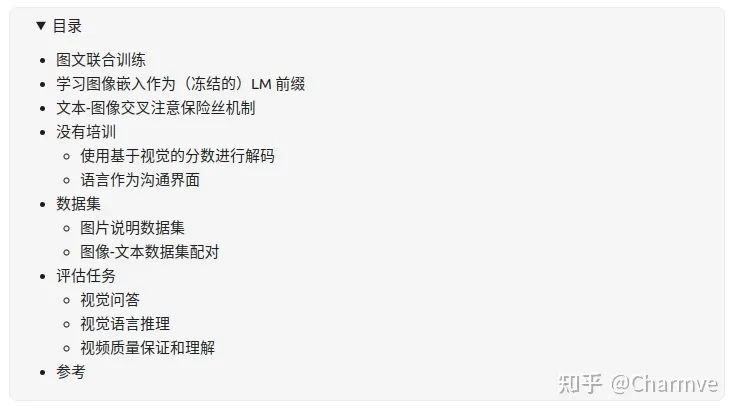

我将此类视觉语言模型 (VLM) 大致分为四个类别:

-

将图像转换为可以与令牌嵌入联合训练的嵌入特征。

-

学习可以作为冻结的、预先训练的语言模型的前缀的良好图像嵌入。

-

使用专门设计的交叉注意机制将视觉信息融合到语言模型的各个层中。

-

无需任何培训即可结合视觉和语言模型。

图文联合训练

将视觉信息融合到语言模型中的一种直接方法是将图像视为普通文本标记,并在文本和图像的一系列联合表示上训练模型。准确地说,图像被分成多个较小的块,每个块在输入序列中被视为一个“标记”。

VisualBERT ( Li et al. 2019 ) 将文本输入和图像区域都输入到BERT中,以便能够通过自注意机制发现图像和文本之间的内部对齐。

以上是关于多模态最强综述,浅显易懂娓娓道来 Generalized Visual Language Models的主要内容,如果未能解决你的问题,请参考以下文章