C++卷积神经网络实例:tiny_cnn代码详解——层间继承关系

Posted 山在岭就在

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了C++卷积神经网络实例:tiny_cnn代码详解——层间继承关系相关的知识,希望对你有一定的参考价值。

在上一篇博文中我们顺利将tiny_cnn的程序调试通过,在这篇博文中我们尝试从整体角度给出对tiny_cnn这个深度学习框架的解读,重点论述一下其各个层直接类封装的继承关系。

一、卷积神经网络快速入门

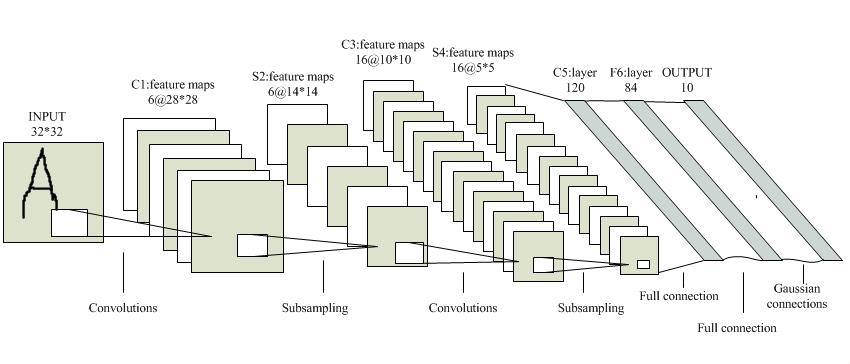

tiny_cnn作为卷积神经网络的一种实现形式,在探讨其框架结构之前,首先需要简要介绍一些卷积神经网络相关的知识。首先,给出经典卷积神经网络的网络结构:

这个是经典的LeNet-5的网络结构图,五层网络、最早用于支票上的手写数字识别,也是最早的商业化的深度学习模型。从上图中可以看出,卷积神经网络主要分为输入层、卷积层、下采样层、全连接层这几部分,这里的tiny_cnn框架在组成部分上同样借鉴了上图中的传统网络结构。至于有关卷积神经网络基本原理方面的知识由于我在之前的博文中已经详细的介绍过,这里不再赘述,具体参见深度学习Matlab工具箱代码详解,里面提供了相关的学习资料。

二、tiny_cnn的网络结构

tiny_cnn框架中同样封装了卷积神经网络的基本组件,并且将其封装成了相应的C++类,并建立了各个类之间的继承关系,来满足层结构之间的相似性和扩展性,这里首先给出tiny_cnn的各个网络层的类结构:

可见在tiny_cnn中一共构造了以上几个类来表示具体的网络结构。Layer_base作为所有层结构的基类,里面定义了各个层所共有的基本属性,并且这个类是一个抽象类,其中定义了一些虚函数和纯虚函数,以便各个子类对其进行重写,实现彼此层之间不同的作用,这也是C++编程中多态性的良好体现。在Layer_base的基础上以public的形式派生出Layer子类,在其中对Layer_base的变量和成员函数做了一定的实现和扩展。在Layer的基础上公有派生出四个子类:Input_layer、Partial_connected_layer、Fully_connected_layer、Max_pooling_layer,这四个类已经能够进行一些实例化操作,完成卷积神经网络的映射任务了。在此基础上,从Partial_connected_layer类中派生得到verage_pooling_layer、Convolutional_layer两个子类,从Fully_connected_layer类的基础上派生得到Fully_connected_dropout_layer子类。以上便是tiny_cnn中与各个层结构相关的类定义。

三、各个层结构类的简要说明

接下来我们针对以上各个层结构类的功能做一下简要说明:

1、Layer_base和Layer:这两个没什么说的,作为基类,封装的都是各个层所公有的操作,其内部的功能函数大都是虚函数和纯虚函数,依赖子类的多态性实例化。

2、Input_layer:输入层,基本的层构造操作,以及前向传播的的入口和反向传播的终点,在这一层完成数据(图像矩阵)的输入以及前向传播的开始,同时准备接受反向传播的结果。

3、convolutional_layer:卷积层,这是卷积神经网络的主力层,保存对应的卷积核和偏置核,方便在前向传播和反向传播过程中调用计算,同时提供了图像可视化结构,能够将保存的权重矩阵转换为图像形式进行可视化输出。

4、average_pooling_layer:均值下采样层,这一层主要有两个作用,对卷积层的输出结果进行下采用并可视化输出。

5、fully_connected_layer:全连接层,作为网络末尾的输出层,最终的输出结果就是网络的最终判决结果,即一个标签向量,这里面主要实现了前向传播算法和反向传播算法的全连接版(和卷积层略有不同)。

以上就是在主测试程序中直接调用到的层结构,在接下来的博文中将对这些层结构类逐个进行剖析,分析其结构组成以及内部功能函数的实现方法,有一种一层一层逐层深入的意味,OK,这篇博文暂时写到这里。

如果觉得这篇文章对您有所启发,欢迎关注我的公众号,我会尽可能积极和大家交流,谢谢。

以上是关于C++卷积神经网络实例:tiny_cnn代码详解——层间继承关系的主要内容,如果未能解决你的问题,请参考以下文章

C++卷积神经网络实例:tiny_cnn代码详解(12)——从CNN中看多态性

C++卷积神经网络实例:tiny_cnn代码详解——fully_connected_layer层结构类分析

C++卷积神经网络实例:tiny_cnn代码详解(11)——层结构容器layers类源码分析

C++卷积神经网络实例:tiny_cnn代码详解(12)——从CNN中看多态性