MAFormer: 基于多尺度注意融合的变压器网络视觉识别

Posted AI浩

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了MAFormer: 基于多尺度注意融合的变压器网络视觉识别相关的知识,希望对你有一定的参考价值。

文章目录

摘要

链接:https://arxiv.org/abs/2209.01620v1

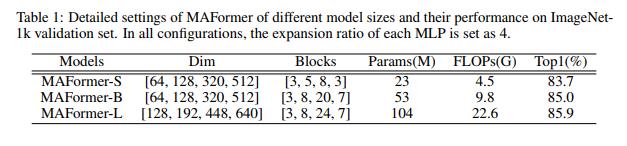

Vision Transformer及其变体在各种计算机视觉任务中显示出了巨大的潜力。但是传统的Vision Transformer通常关注粗级别的全局依赖,这在令牌级别的全局关系和细粒度表示方面面临学习挑战。在本文中,我们将多尺度注意力融合到Transformer(MAFormer)中,探讨了双流框架下的局部聚集和全局特征提取。我们开发了一个简单但有效的模块,通过在令牌级别学习细粒度和粗粒度特性并动态融合它们,来探索可视化表示Transformer的全部潜力。我们的多尺度注意融合(MAF)块包括:i)一个本地窗口注意分支,它学习窗口内的短程交互,聚合细粒度的本地特征;ii)通过一种新的全局学习与下采样(GLD)操作进行全局特征提取,以有效地获取整个图像内的远程上下文信息;Iii)一个融合模块,通过关注自我探索两种功能的整合。我们的MAFormer在常见的视觉任务上达到了最先进的性能。特别是,MAFormer-L在ImageNet上的Top-1准确率达到85.9%,分别超过CSWin-B和liv - vitl 1.7%和0.6%。在MSCOCO上,MAFormer在目标检测方面比现有技术CSWin的map性能高出1.7%,在具有相似大小参数的实例分割方面高出1.4%,显示出成为通用骨干网的潜力。

1 简介

自ViT[11]技术突破以来,Transformer在计算视觉领域占据了主导地位,在图像识别、目标检测、语义分割等多种视觉任务中都取得了优异的成绩。尽管取得了这些进展,但符合ViT[11,21]的全局自注意机制对输入图像大小的计算复杂度为二次元,这对于高分辨率的场景来说是无法忍受的。为了降低复杂性,引入了几种变体,将全局自我关注替换为局部自我关注。Swin Transformer[24]具有层次结构,将输入特性划分到不重叠的窗口中,并按层移动窗口位置。在此基础上,设计了各种窗口划分机制,以更好地捕获局部特征。CSWin Transformer[10]将特征并行分割为水平和垂直条纹,旨在扩大窗口接受域。但是,它只关注窗口内的信息,而忽略了窗口之间的依赖关系。Shuffle Transformer[16]重新访问ShuffleNet[26],并在本地窗口中嵌入空间洗牌,以加强它们的连接。虽然这些基于局部窗口的注意方法已经取得了出色的性能,甚至优于卷积神经网络(CNN)的对应方法(例如ResNets[13,35]),但它们在全局关系的学习方面存在挑战,而全局关系是更好的特征表示所不可或缺的。

另一个研究方向是将cnn与Transformer结合起来,这是局部模式与全局模式之间的权衡。CvT[52]将自注意块中的线性投影转换为卷积投影。CoatNet[46]通过简单的相对注意将深度卷积与自我注意合并,并将卷积与注意层进行有原则的堆叠。DS-Net[27]提出了一种双流框架,通过交叉注意融合了卷积和自我注意,在这种框架中,每一种规模形式都学会了与另一种规模保持一致。然而,如DS-Net[27]所示,卷积和注意具有内在冲突的性质,可能导致训练中的模糊性。例如,在高分辨率特征图中,全局自注意捕获的远程信息可能会干扰卷积的邻近细节,从而损害全局和局部表示。

在本文中,我们开发了一个多尺度注意融合Transformer(MAFormer),在双流transformers框架下探索局部聚合和全局特征提取。为了避免卷积和自注意不兼容的风险,我们利用局部窗口注意提取细粒度特征表示。我们还设计了一个全局学习下采样(GLD)模块来提取全局特征,该模块基于全尺寸输入捕获粗粒度特征。我们进一步通过位置嵌入将输入的标记级位置信息编码到全局表示中。此外,我们描述了基于不同融合策略的两种双流架构,特别是多尺度注意力融合(MAF)方案,可以充分挖掘这两个特性的潜力。它的有效性可以解释为MAF块可以增强每个局部-全局令牌对之间的交互,局部特征和全局特征在统一的框架中被联合训练,形成了更丰富和信息量更大的表示。这项工作的贡献总结如下:

-

引入MAFormer网络在令牌级别提取和融合细粒度和粗粒度特征,通过注意自探索两种特征的集成,提高输入图像的表示能力。

-

首先引入局部窗口注意分支来学习局部窗口内的短程交互。我们进一步在双分支上引入了全局学习下采样(GLD)模块,有效地捕获了整个图像内的远程上下文信息。

-

我们基于不同的融合策略开发了两种双流架构,特别是多尺度注意力融合(MAF)方案,可以充分挖掘这两个特性的潜力。

-

在没有铃铛和哨子的情况下,提出的MAFormer在识别性能方面大大优于先前的视觉transformers。我们还在类似参数的对象检测和实例分割方面,取得了比以前最好的CSWin最先进的结果

2 相关工作

Vision transformers。基于自注意的体系结构,特别是transformer[39],已经成为自然语言处理(NLP)的主要模型。受其在NLP中的成功的激励,ViT[11]创新地将纯转换器架构应用于图像,方法是将图像分割为多个补丁,并将它们与标记(单词)等同起来。ViT对分类任务[9]表现出竞争效应。许多人致力于将ViT应用于各种视觉任务,包括目标检测[2,55,49,40,31]、语义分割[5,33,44]、姿态估计[22,48,51]、再识别[14]和底层图像处理[4]。这些结果验证了transformers作为通用视觉骨干网络的出色能力。然而,自注意机制对低级特征的编码效率较低,阻碍了它们高效表示学习的潜力。

基于局部窗口注意的transformers。Vision transformers在建模远程依赖关系方面表现出很高的能力,这对于处理下游任务中的高分辨率输入尤其有帮助。但该方法采用原始的全自注意,计算复杂度为图像大小的二次元。为了降低成本,最近的一些视觉transformers[24,38]采用了局部窗口自注意机制[30]及其移位/光晕版本,增加了不同窗口之间的交互。为了扩大接受域,轴向自我注意[15]和交叉注意[17]提出沿着水平或/和垂直轴在条纹内计算注意,而不是将局部窗口固定为正方形。受轴向自注意和十字形自注意的启发,[10]方法提出了十字形窗口自注意。CSWin在水平和垂直条纹中并行进行自我注意计算,每条条纹都是将输入特征分割成等宽的条纹得到的。

transformers中的卷积。根据最近的分析[28,8],卷积网络和transformers有着不同的优点。而卷积运算保证了更好的泛化和快速收敛,由于其归纳偏差,注意公式网络具有更高的模型容量。因此,将卷积层和注意层结合起来,可以将这些优点结合起来,同时获得更好的泛化能力和容量。一些现有的transformers探索混合体系结构,以合并两种操作,以获得更好的视觉表现。Comformer[28]提出了特征耦合单元,以交互式的方式将卷积局部特征与基于transformers的全局表示融合在一起。CvT[42]设计了卷积令牌嵌入和卷积transformers块,以捕获更精确的局部空间上下文。随后,CoatNet[8]将深度卷积合并为具有简单相对注意的注意层。除了包含显式卷积外,一些著作[24,10,50,41]尝试将卷积的一些理想性质融入Transformer主干。

3 方法

3.1 总体架构

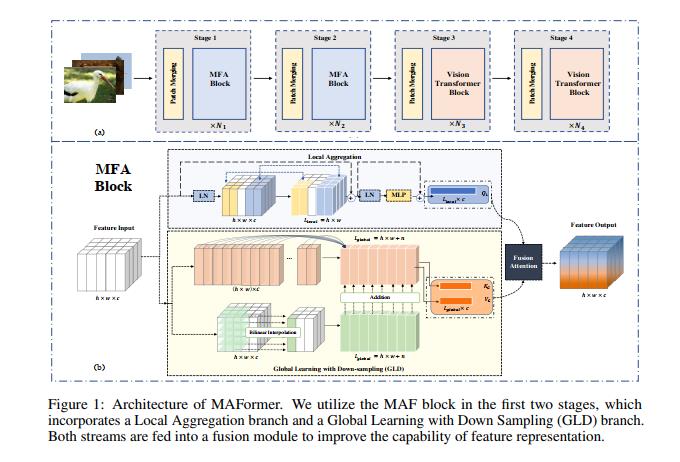

提出了多尺度注意融合机制,在标记级提取细粒度和粗粒度特征并动态融合,形成了通用视觉转换骨干网络,定义为MAFormer,提高了在各种视觉任务中的性能。图一(a)为MAFormer的整体架构。它采用 X ∈ R H × W × 3 \\mathcalX \\in R^H \\times W \\times 3 X∈RH×W×3作为图像的输入,其中W和H表示输入图像的宽度和高度,并采用分层设计。通过降低特征映射的分辨率,该网络可以捕获不同阶段的多尺度特征。我们将输入图像划分为多个补丁并进行补丁合并,接收带有C特征通道的 H 4 × W 4 \\fracH4 \\times \\fracW4 4H×4W可视标记。从那里,令牌通过两个阶段的MAF块和两个阶段的原始视觉转换块。在每个阶段中,MAFormer采用了一个约定的补丁合并层,对特征映射的空间大小进行2 倍的下采样,同时增加特征通道的维数。

根据最近对特征表示[29]的研究,像ViT这样的视觉transformers在较低的层中参与局部和全局,但主要关注较高层的全局信息。根据该模式,我们在MAFormer的前两个阶段引入多尺度特征表示,后两个阶段利用原有的视觉转换块,降低了特征的分辨率,使充分关注的计算成本变得可承受。

3.2 多尺度注意融合块

在本节中,我们详细阐述了我们的多尺度注意融合(MAF)块的细节。如图1(b)所示,MAF块包括一个Local Aggregation分支和一个Global Learning with Down Sampling (GLD)分支,分别生成令牌级细粒度和粗粒度特征。两种流都被输入到一个融合模块中,以提高特征表示能力。

局部聚合。以前的混合网络[8,[20]]利用cnn提取本地特征,这些特征进一步集成到Transformer分支中。然而,这样的方法冒着卷积和自我注意不匹配的风险。在MAF中,我们避免了这种不兼容,并探索了使用基于局部窗口的多头注意机制作为细粒度表示。考虑输入

X

∈

R

H

×

W

×

C

,局部聚合

X

L

L

X \\in \\mathbfR^H \\times W \\times C,局部聚合X_L^L

X∈RH×W×C,局部聚合XLL定义为:

X

L

l

=

Local

−

Window-Attention

(

L

N

(

X

l

−

1

)

)

+

X

l

−

1

,

X

L

l

=

MLP

(

X

L

l

)

+

X

L

l

(1)

\\beginaligned X_L^l &=\\operatornameLocal-\\text Window-Attention \\left(\\mathrmLN\\left(X^l-1\\right)\\right)+X^l-1, \\\\ X_L^l &=\\operatornameMLP\\left(X_L^l\\right)+X_L^l \\endaligned \\tag1

XLlXLl=Local− Window-Attention (LN(Xl−1))+Xl−1,=MLP(XLl)+XLl(1)

其中

X

l

X^l

Xl表示第l个transformers块的输出。

全局特征提取。尽管局部窗口自注意方法已经取得了出色的性能,但它们只能捕获窗口相关的信息,无法探索它们之间的依赖关系。此外,由于对粗粒度上下文信息的利用不足,现有的方法在全局依赖关系提取方面仍然面临挑战。因此,有效地捕获全局依赖关系是模型表示的本构。

为了解决这些问题,我们引入了一个带有下采样的全局学习(GLD)模块,从大型输入中提取全局信息。为此,我们首先利用与特征输入完全连接的单个神经元层。在不删除任何维度的情况下,它输出一个动态学习的下采样上下文抽象。如图1©所示,首先将输入 R H × W × c \\mathbfR^H \\times W \\times c RH×W×c扁平为 X G ∈ R C × L X_G \\in \\mathbfR^C \\times L XG∈RC×L,其中L等于H× w,然后用全连接层全局提取 X G ∈ R C × L X_G \\in \\mathbfR^C \\times L XG∈RC×L,缩小为缩放比N。在实验中,我们对N进行了几个值的调优,0.5是最优值,在MAFormer中设置为默认值。此外,我们通过位置嵌入将输入的标记级位置信息编码到全局表示中。如图1©所示,Pos操作使用分层双线性插值作为度量,FC表示为完全连接。

X G l = Pos ( X G l − 1 ) + F C ( X G l − 1 ) , (2) X_G^l=\\operatornamePos\\left(X_G^l-1\\right)+F C\\left(X_G^l-1\\right), \\tag2 XGl=Pos(XGl−1)+FC(XGl−1),(2)

其中

X

G

l

X_G^l

XGl表示第l个transformers块的全局分支输出。

多尺度注意融合。我们开发了两种类型的双流多尺度表示,如图2所示。首先,我们在本地表示的顶部提取全局依赖项作为一种增强,旨在提供跨本地窗口的信息流。如图2(b)所示,GLD模块获取局部窗口注意的输出,并将全局表示融合回局部表示。然而,这种方法只能捕获局部属性之间的全局相关性,而不能从输入中获取。因此,我们提出了多尺度注意融合(MAF)测度,直接和分别提取输入的局部和全局尺度。如图2©所示,两种信息流通过注意力被输入到融合块中。通过这种方式,我们的MAF块可以捕获每个局部-全局令牌对之间的相关性,并提示局部特征自适应地探索它们与全局表示的关系,使它们自己更具代表性和信息量。

给定提取的局部特征 X L ∈ R C × L local X_L \\in \\mathbfR^C \\times L_\\text local XL∈RC×Llocal 和全局特征 X G ∈ R C × L global X_G \\in \\mathbfR^C \\times L_\\text global XG∈RC×Lglobal ,定义多尺度注意融合为:

Q

L

=

X

L

W

Q

local

,

K

G

=

X

G

W

K

global

,

V

G

=

X

G

W

V

global

,

(3)

\\beginarrayc Q_L=X_L W_Q^\\text local , \\\\ K_G=X_G W_K^\\text global , \\\\ V_G=X_G W_V^\\text global , \\endarray \\tag3

QL=XLWQlocal ,KG=XGWKglobal ,VG=XGWVglobal ,(3)

其中

W

Q

local

、

W

K

global

、

W

V

global

W_Q^\\text local 、W_K^\\text global 、W_V^\\text global

WQlocal 、WK