Hadoop大数据技术-通过shell命令访问HDFS

Posted 春日捕月_

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Hadoop大数据技术-通过shell命令访问HDFS相关的知识,希望对你有一定的参考价值。

通过shell命令访问HDFS

HDFS shell大致可以分为操作命令、管理命令、其他命令三类。

注意:当命令以“$”开头时,当前用户为普通用户;以“#”开头时,当前用户为root用户。

1 操作命令

操作命令是以“hdfs dfs”开头的命令,用户可以通过执行这些命令,完成对文件的查找、上传、删除等操作。

1.1 创建文件夹

hdfs dfs -mkdir [-p] <paths>

[-p]:表示如果父目录不存在,先创建父目录

示例代码如下:

#新建文件夹/202012716/mydemo2

hdfs dfs -mkdir /202012716/mydemo2

#新建文件夹/202012716/mydemo/x/y/z

hdfs dfs -mkdir -p /202012716/mydemo/x/y/z

#在/202012716目录下新建文件夹mydemo3、mydemo4、mydemo5

hdfs dfs -mkdir /202012716/mydemo3 /202012716/mydemo4 /202012716/mydemo5

1.2 列出指定的文件和目录

hdfs dfs -ls [-d] [-h] [-R] <paths>

[-d]:返回path。

[-h]:显示文件大小。

[-R]:级联显示paths下的文件

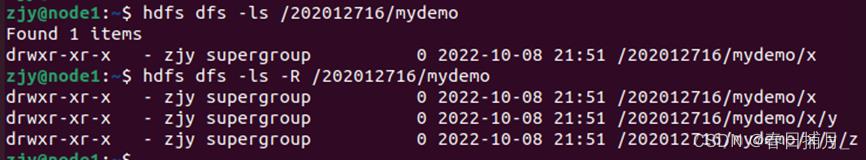

示例 列出HDFS文件下名为/202012716/mydemo的文件夹中的文件:

hdfs dfs -ls /202012716/mydemo

输出为:

1.3 上传文件

hdfs dfs -put [-f] [-p] <localsrc> <dst>

hdfs dfs -copyFromLocal [-f] [-p] [-l] <localsrc> <dst>

put 或copyFromLocal 命令是将本地文件上传到HDFS。

localsre:表示本地文件路径。

dst:表示保存在HDFS上的路径。

示例 将本地文件上传到HDFS上:

#将本地目录txt1.txt文件上传到HDFS并重命名为hdfs1.txt

hdfs dfs -put txt1.txt /202012716/mydemo/hdfs1.txt

#将本地目录txt2.txt文件上传到HDFS并重命名为hdfs2.txt

hdfs dfs -copyFromLocal txt2.txt /202012716/mydemo/hdfs2.txt

1.4 下载文件

hdfs dfs -get [-p] <src> <localdst>

hdfs dfs -copyToLocal [-p] [-ignoreCrc] [-crc] <src> <localdst>

get 或copyToLocal 命令是将把文件从分布式系统保存至本地。

示例 将hdfs中的文件保存到本地并重命名:

#将HDFS中的hdfs1.txt文件复制到本地系统并重命名为txt11.txt

hdfs dfs -get /202012716/mydemo/hdfs1.txt txt11.txt

#将HDFS中的hdfs3.txt文件复制到本地系统并重命名为txt3.txt

hdfs dfs -copyToLocal /202012716/mydemo/hdfs3.txt txt3.txt

1.5 查看文件

hdfs dfs -cat/text [-ignoreCrc] <src>

hdfs dfs -tail [-f] <file>

-ignoreCrc:忽略循环检验失败的文件。

-f:动态更新显示数据。

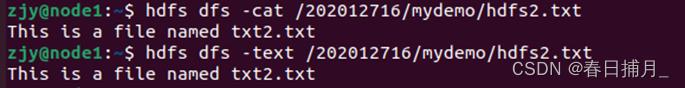

示例 查看HDFS下/202012716/mydemo/hdfs2.txt文件中的内容:

hdfs dfs -cat /202012716/mydemo/hdfs2.txt

输出为:

1.6 删除目录或文件

hdfs dfs -rm [-f] [-r] <src>

-f:如果要删除的文件不存在,不显示错位信息。

-r/R:级联删除目录下所有文件和子目录下的文件。

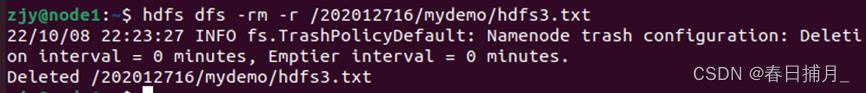

示例 删除HDFS下名为hdfs3的文件:

#级联删除hdfs3.txt

hdfs dfs -rm -r /202012716/mydemo/hdfs3.txt

输出为:

1.7 文件或文件夹的复制、移动

这里是hdfs内部的文件移动和复制,与文件和从本地到分布式系统的移动不同。

hdfs dfs -cp [-f] [-p|-p[topax]] <src> <dst>

hdfs dfs -mv <src> <dst>

文件复制cp命令的参数:

-f:如果目标文件存在,将其强行覆盖。

-p:将保存文件的属性。

示例 将hdfs1.txt复制到hdfs3.txt中,将hdfs3.txt移动到hdfs4.txt中:

hdfs dfs -cp /202012716/mydemo/hdfs1.txt /202012716/mydemo/hdfs3.txt

hdfs dfs -mv /202012716/mydemo/hdfs3.txt /202012716/mydemo/hdfs4.txt

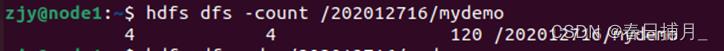

1.8 count统计

hdfs dfs -count [-p] [-h] <path>

count统计某个目录下的子目录与文件的个数及文件大小,统计结果包含目录数、文件数、文件大小。

示例如下:

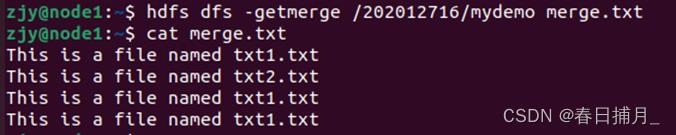

先将/202012716/mydemo下的文件合并成一个文件merge.txt,并用命令查看merge.txt的内容。

#合并文件

hdfs dfs -getmerge /202012716/mydemo merge.txt

#查看merge.txt

cat merge.txt

merge.txt文件内容如下:

查看/202012716/mydemo的目录个数、文件个数、文件总计大小

hdfs dfs -count /202012716/mydemo

输出为:

1.9 显示占用的磁盘空间大小

hdfs dfs -du [-s] [-h] <path>

按字节显示指定目录所占空间大小。

-s:显示目录下文件总的大小。

-h:表示按照人性化的单位显示文件大小。

示例 查看/202012716/mydemo目录下文件的大小:

hdfs dfs -du /202012716/mydemo

输出为:

2 管理命令

管理命令是以“hdfs dfsadmin”开头的命令。

2.1 安全模式相关

安全模式是HDFS所处的一种特殊状态,在这种状态下,文件系统只接受读数据请求,而不接受删除、修改等变更请求。

查看用户是否处于安全模式:

hdfs dfsadmin -safemode get

进入安全模式:

hdfs dfsadmin -safemode enter

离开安全模式:

hdfs dfsadmin -safemode leave

2.2 快照

快照功能为虚拟机保存了某个状态,若系统遭到某种破坏,可快速复原。

开启和禁用快照功能:

#开启/202012716/mydemo的快照功能

hdfs dfsadmin -allowSnapshot /202012716/mydemo

#关闭/202012716/mydemo2的快照功能

hdfs dfsadmin -disallowSnapshot /202012716/mydemo

创建、重命名和删除快照:

#为/202012716/mydemo创建快照s1

hdfs dfsadmin -createSnapshot /202012716/mydemo

#将/202012716/mydemo的快照改名为s2

hdfs dfsadmin -renameSnapshot /202012716/mydemo s1 s2

#删除快照s2

hdfs dfsadmin -deleteSnapshot /202012716/mydemo s2

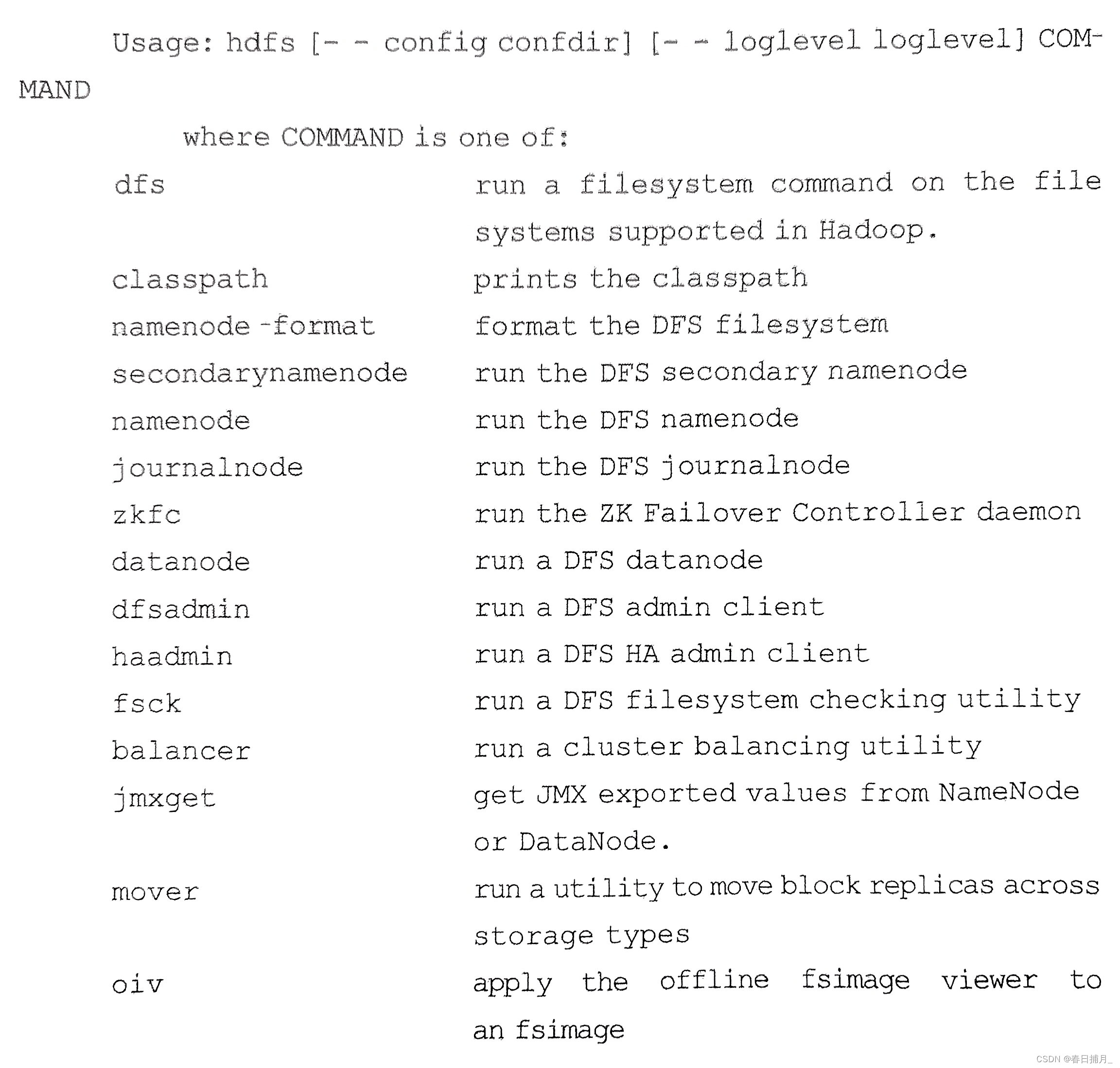

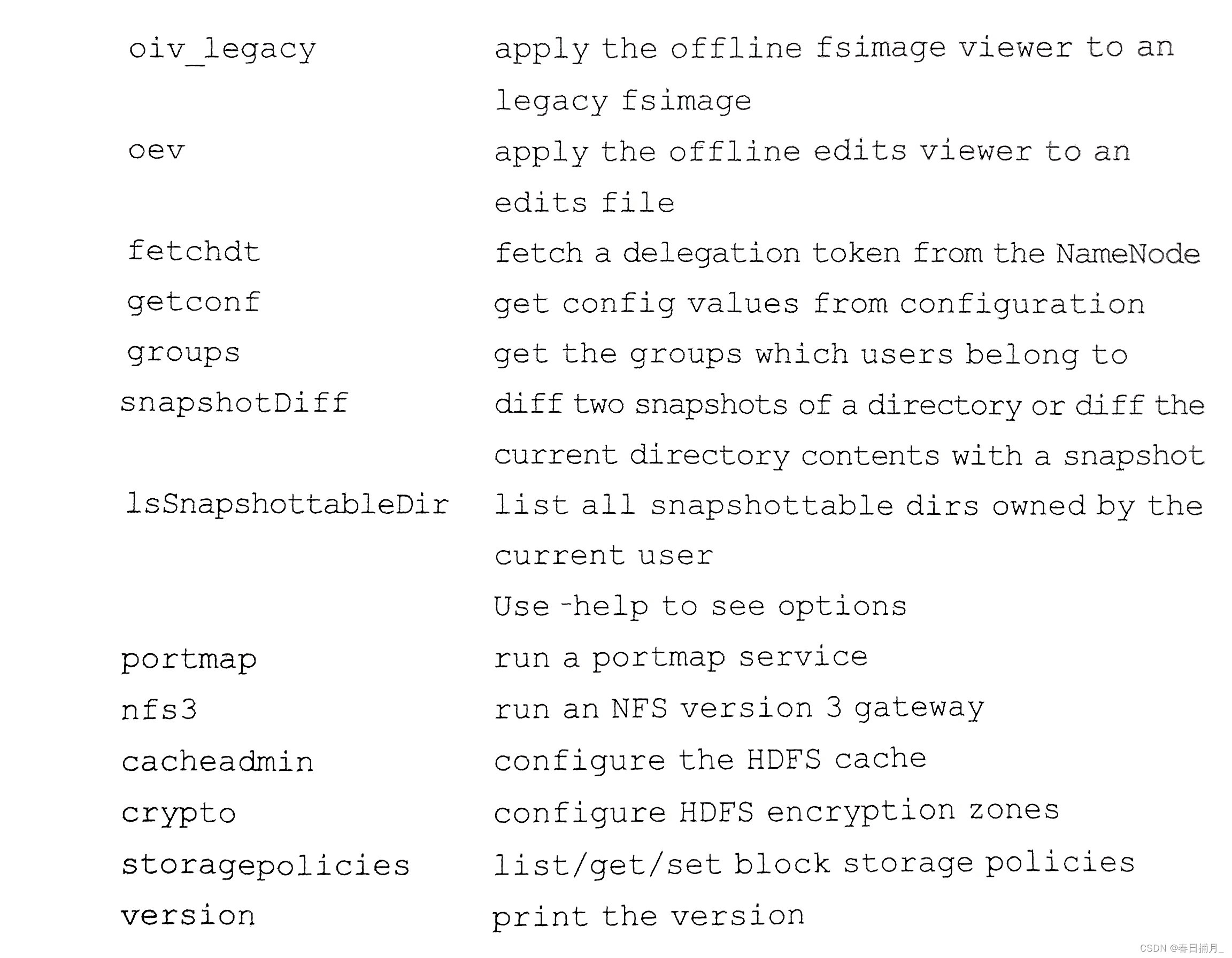

3 其他命令

我们把操作命令"hdfs dfs"、管理命令"hdfs dfsadmin"之外的命令称为其他命令。

下面是输入“hdfs”后支持的所有子命令:

以上是关于Hadoop大数据技术-通过shell命令访问HDFS的主要内容,如果未能解决你的问题,请参考以下文章

大数据技术之Hadoop(HDFS)概述Shell操作API操作读写流程工作机制