clickhouse 超底层原理 + 高可用实操 (史上最全)

Posted 架构师-尼恩

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了clickhouse 超底层原理 + 高可用实操 (史上最全)相关的知识,希望对你有一定的参考价值。

文章很长,建议收藏起来慢慢读! 总目录 博客园版 为大家准备了更多的好文章!!!!

推荐:尼恩Java面试宝典(持续更新 + 史上最全 + 面试必备)具体详情,请点击此链接

尼恩Java面试宝典,34个最新pdf,含2000多页,不断更新、持续迭代 具体详情,请点击此链接

本文背景

这段时间给大家 做简历指导,发现大家都缺少优质实操项目,所以打算介绍一个《100W级别qps日志平台实操》,基于clickhouse+netty,于是,就写了此文

此文设计到大量的底层原理,和高并发的实操知识,建议大家慢慢读,

并且强烈建议大,对着此文,实操一下。

MPP数据库简介

什么是OLTP与OLAP?

OLTP(OnLine Transaction Processing ) 联机事务处理 系统

例如mysql。

擅长事务处理,在数据操作中保持着很强的一致性和原子性 ,能够很好的支持频繁的数据插入和修改 ,但是,一旦数据量过大,OLTP便力不从心了。

OLAP(On-Line Analytical Processing)联机分析处理 系统

例如clickhouse,greenplum,Doris。

不特别关心对数据进行输入、修改等事务性处理,而是关心对已有 的大量数据进行多维度的、复杂的分析的一类数据系统 。

ClickHouse 简介

ClickHouse的全称是Click Stream,Data WareHouse。

ClickHouse 是俄罗斯的 Yandex (俄罗斯第一大搜索引擎) 于 2016 年开源的用于在线分析处理查询(OLAP :Online Analytical Processing)MPP架构的列式存储数据库(DBMS:Database Management System),能够使用 SQL 查询实时生成分析数据报告。

ClickHouse 使用 C++ 语言编写,主要用于在线分析处理查询(OLAP),能够使用 SQL 查询实时生成分析数据报

告。

clickhouse可以做用户行为分析,流批一体

clickhouse没有走hadoop生态,采用 Local attached storage 作为存储

令人惊喜的是,ClickHouse 的性能大幅超越了很多商业 MPP 数据库软件,比如 Vertica,InfiniDB.

相比传统的数据库软件,ClickHouse 要快 100-1000X:

100Million 数据集:

ClickHouse 比 Vertica 约快 5 倍,比 Hive 快 279 倍,比 My SQL 快 801 倍

1Billion 数据集:

ClickHouse 比 Vertica 约快 5 倍,MySQL 和 Hive 已经无法完成任务了

Greenplum简介

Greenplum是一家总部位于美国加利福尼亚州,为全球大型企业用户提供新型企业级数据仓库(EDW)、企业级数据云(EDC)和商务智能(BI)提供解决方案和咨询服务的公司,

在全球已有:[纳斯达克,[纽约证券交易所,Skype. FOX,T-Mobile;

中国已有:中信实业银行,东方航空公司,阿里巴巴,华泰保险,中国远洋,李宁公司等大型企业用户选择Greenplum的产品。

Greenplum的架构采用了MPP(大规模并行处理)。

Greenplum名字来源

Greenplum的大中华区总裁Stanley Chen告诉我们:“Greenplum这个名字是一个7岁小女孩无意中脱口而出的。”起初几个创始人在斟酌公司名字的时候都很没头绪,于是他们去问了朋友的孩子,一个年仅7岁的可爱小姑娘告诉他们叫“Apple”,但是爸爸告诉她,这个名字已经被别人用了,还有其他的么?很快孩子便随口说了“Greenplum”,于是“Greenplum”公司的名字就这样诞生了。**

Doris简介

Doris由百度大数据部研发 ,之前叫百度 Palo,2018年贡献到 Apache 社区后,更名为 doris

Doris是一个MPP的OLAP系统,以较低的成本提供在大数据集上的高性能分析和报表查询功能。

StoneDB介绍

此处的介绍,目的是 推广国产软件, 国产软件,不容易呀

StoneDB是国内首款基于MySQL的实时HTAP数据库产品, 由杭州石原子科技有限公司自主设计、研发的 基于 MySQL 内核打造的开源 HTAP(Hybrid Transactional and Analytical Processing)融合型数据库产品,可实现与 MySQL 的无缝切换。StoneDB 具备高性能、实时分析等特点,为用户提供一站式HTAP解决方案。StoneDB是一款兼容 MySQL的 HTAP 数据库,可以实现从MySQL到StonDB的无缝切换。

StoneDB 是基于 MySQL 内核打造的开源 HTAP (Hybrid Transactional and Analytical Processing) 融合型数据库,可实现与 MySQL 的无缝切换。StoneDB 具备超高性能、实时分析等特点,为用户提供一站式 HTAP 解决方案。

StoneDB 包含 100% 兼容 MySQL 5.6、5.7 协议,以及 MySQL 生态等重要特性,支持 MySQL 常用的功能及语法,支持 MySQL 生态中的系统工具和客户端,如 Navicat、Workbench、mysqldump、mydumper。由于 100% 兼容 MySQL,因此 StoneDB 的所有工作负载都可以继续使用 MySQL 数据库体系运行。

StoneDB 专门针对 OLAP 应用程序进行了设计和优化,支持百亿数据场景下进行高性能、多维度字段组合的复杂查询。

StoneDB 采用基于知识网格技术和列式存储引擎,该存储引擎为海量数据背景下 OLAP 应用而设计,通过列式存储数据、知识网格过滤、高效数据压缩等技术,为应用系统提供低成本和高性能的数据查询支持。

什么是MPP 系统

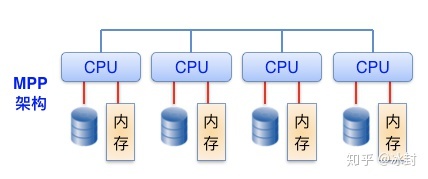

什么是 大规模并行处理 MPP架构?(Massively Parallel Processing)

MPP架构是将任务并行的分散到多个服务器和节点上,在每个节点上计算完成后,将各自部分的结果汇总在一起得到最终的结果。

采用MPP架构的数据库称为MPP数据库。

在 MPP 系统中,每个 单节点也可以运行自己的操作系统、数据库等。

换言之,每个节点内的 CPU 不能访问另一个节点的内存。

节点之间的信息交互是通过节点互联网络实现的,这个过程一般称为数据重分配(Data Redistribution) 。

与传统的单体架构 明显不同,MPP系统因为 要在不同处理单元之间传送信息,

- 当数据规模很小的时候,MPP的效率要比单体架构要差一点,

- 但是当数据规模上来之后,MPP的效率要比 单体架构 好。

这就是看通信时间占用计算时间的比例而定,如果通信时间比较多,那MPP系统就不占优势了,相反,如果通信时间比较少,那MPP系统可以充分发挥资源的优势,达到高效率。

为什么需要MPP数据库?

海量数据的分析需求

传统数据库无法支持大规模集群与PB级别数据量

单台机器性能受限、成本高昂,扩展性受限

支持复杂的结构化查询(这里是重点)

复杂查询经常使用多表联结、全表扫描等,牵涉的数据量往往十分庞大;

支持复杂sql查询和支持大数据规模;

Hadoop技术的先天不足

Hive等sql-on-hadoop性能太慢,分析场景不一样,SQL兼容性与支持不足

MPP数据库应用领域

大数据分析:

MPP数据库做大数据计算或分析平台非常适合,例如:数据仓库系统、历史数据管理系统、数据集市等。

MPP数据库有很强的并行数据计算能力和海量数据存储能力,、

所以,**报表统计分析、**运维统计数据,快速生成报表展示都可以使用mpp数据库。

符合几个条件:不需要更新数据,不需要频繁重复离线计算,不需要并发大。

有上百亿以上离线数据,不更新,结构化,需要各种复杂分析的sql语句,那就可以选择他。

几秒、几十秒立即返回你想要的分析结果。

例如sum,count,group by,order,好几层查询嵌套,在几百亿数据里分分钟出结果

这类的数据库:,clickhouse,greenplum,Doris

MPP数据库不擅长高频的小规模数据插入、修改、删除,每次事务处理的数据量不大。

这类数据衡量指标是TPS,适用的系统是OLTP数据库。

Clickhouse特性

Clickhouse是一个列式数据库管理系统,在OLAP领域像一匹黑马一样,以其超高的性能受到业界的青睐。

Clickhouse的优势特性:

数据分区与线程级并行

ClickHouse支持PARTITION BY子句,在建表时可以指定按照任意合法表达式进行数据分区操作,

比如通过toYYYYMM()将数据按月进行分区、toMonday()将数据按照周几进行分区。

分区条件查询,只能读取包含适当分区数据块,而不扫描过多的数据。

灵活的使用,可以大大提升查询的性能。

ClickHouse 将数据划分为多个 partition,每个 partition 再进一步划分为多个 index granularity(索引粒度),

然后通过多个 CPU核心分别处理其中的一部分来实现并行数据处理。

在这种设计下,单条 Query 就能利用整机所有 CPU。

极致的并行处理能力,极大的降低了查询延时。

所以,ClickHouse 即使对于大量数据的查询也能够化整为零平行处理。

但是有一个弊端就是对于单条查询使用多 cpu,就不利于同时并发多条查询。所以对于高 qps 的查询业务,ClickHouse 并不是强项。

采用列式存储,数据类型一致,压缩性能更高

在一些列式数据库管理系统中(例如InfiniDB CE和MonetDB) 并没有使用数据压缩。>

InfiniDB Community Edition(社区版)提供一个可伸缩的分析型数据库引擎,主要为数据仓库、商业智能、以及对实时性要求不严格的应用而开发。基于MySQL搭建。包括对查询、事务处理以及大数据量加载的支持。

MonetDB是一个开源的面向列的数据库管理系统。MonetDB被设计用来为较大规模数据(如几百万行和数百列的数据库表)提供高性能查询的支持。

但是, 若想达到比较优异的性能,数据压缩确实起到了至关重要的作用。

提供 LZ4、ZSTD 两种数据压缩格式

硬件利用率高,连续IO,提高了磁盘驱动器的效率

许多的列式数据库(如 SAP HANA, Google PowerDrill)只能在内存中工作,这种方式会造成比实际更多的设备预算。

ClickHouse被设计用于工作在传统磁盘上的系统,它提供每GB更低的存储成本,但如果有可以使用SSD和内存,它也会合理的利用这些资源

向量化引擎与SIMD提高了CPU利用率,多核多节点并行化大查询

为了高效的使用CPU,数据不仅仅按列存储,同时还按向量(列的一部分)进行处理,这样可以更加高效地使用CPU

ClickHouse会使用服务器上一切可用的资源,从而以最自然的方式并行处理大型查询

支持SQL

ClickHouse支持基于SQL的声明式查询语言,该语言大部分情况下是与SQL标准兼容的。几乎覆盖了标准SQL的大部分语法,包括DDL和DML,以及配套的各种函数,用户管理及权限管理,数据的备份与恢复

支持的查询包括 GROUP BY,ORDER BY,IN,JOIN以及非相关子查询。

绝大部分查询基本和常用的mysql一样,可以省去大部分同学的学习成本。不仅如此提供了强大的函数支查询能力,更丰富的存储格式,例如array多维数组、json、tuple、set等。

支持近似计算

ClickHouse提供各种各样在允许牺牲数据精度的情况下对查询进行加速的方法:

用于近似计算的各类聚合函数,如:distinct values, medians, quantiles

基于数据的部分样本进行近似查询。这时,仅会从磁盘检索少部分比例的数据。

不使用全部的聚合条件,通过随机选择有限个数据聚合条件进行聚合。这在数据聚合条件满足某些分布条件下,在提供相当准确的聚合结果的同时降低了计算资源的使用。

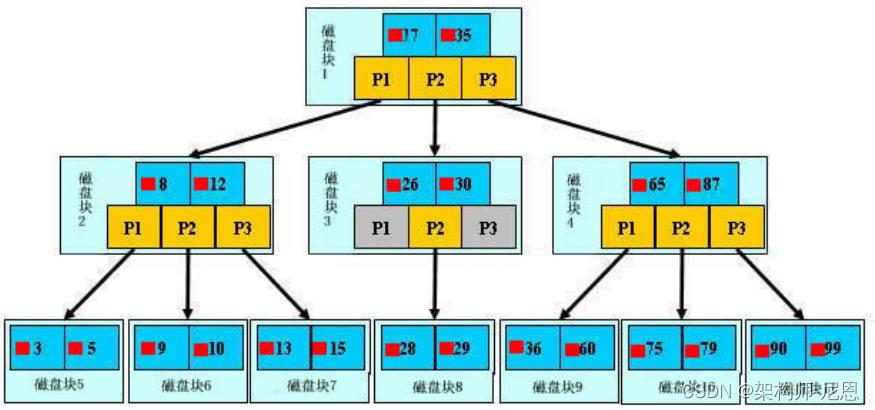

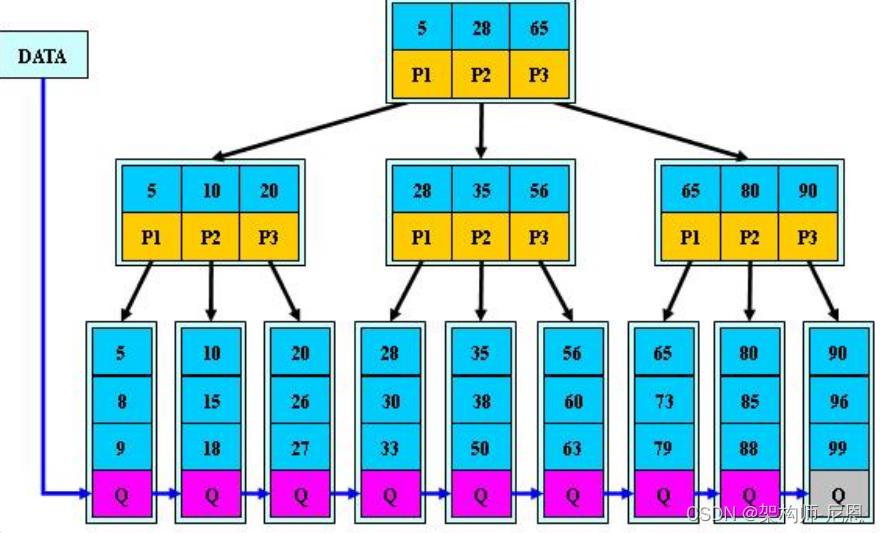

索引

- 主键索引

ClickHouse支持主键索引,它将每列数据按照index granularity(默认8192行)进行划分,会为每个数据片段创建一个索引文件,索引文件包含每个索引行(『标记』)的主键值。

索引行号定义为 n * index_granularity 。当数据被插入到表中时,会分成数据片段并按主键的字典序排序。例如,主键是 (CounterID, Date) 时,片段中数据按 CounterID 排序,具有相同 CounterID 的部分按 Date 排序。

但是值得注意的是:ClickHouse 不要求主键惟一。

所以,你可以插入多条具有相同主键的行。

要想实现去重效果,需要结合具体的表引擎ReplacingMergeTree、CollapsingMergeTree、VersionedCollapsingMergeTree实现。

ClickHouse支持对任意列创建任意数量的稀疏索引。其中被索引的value可以是任意的合法SQL Expression,并不仅仅局限于对column value本身进行索引。之所以叫稀疏索引,是因为它本质上是对一个完整index granularity(默认8192行)的统计信息,并不会具体记录每一行在文件中的位置。

支持近似计算

ClickHouse提供各种各样在允许牺牲数据精度的情况下对查询进行加速的方法:

- 用于近似计算的各类聚合函数,如:distinct values, medians, quantiles

- 基于数据的部分样本进行近似查询。这时,仅会从磁盘检索少部分比例的数据。

- 不使用全部的聚合条件,通过随机选择有限个数据聚合条件进行聚合。这在数据聚合条件满足某些分布条件下,在提供相当准确的聚合结果的同时降低了计算资源的使用。

丰富的表引擎

ClickHouse和MySQL类似,把表级的存储引擎插件化,根据表的不同需求可以设定不同的存储引擎。

目前包括合并树,日志,接口和其他四大类20多种引擎。

clickhouse 不仅拥有自己强大的MergeTree家族的多种本地引擎外,还提供了丰富的外部引擎供我们选择,包括但不限于:kafka、HDFS、Mysql。

但是使用外部引擎的时,性能自然会不如本地存储。

MergeTree引擎家族中很有很多优秀的引擎

比如:

适合人物画像的AggregatingMergeTree引擎

可自定义去重的SummingMergeTree引擎

折叠树CollapsingMergeTree

用于Graphite监控的GraphiteMergeTree引擎

。。。

这些都具有数据副本的能力 Replicated*

官方推荐的适合大多数场景的依然是MergeTree引擎,其家族中其他引擎大多也是在其基础上做的封装。

除此之外,还有分布式的表引擎Distributed。 Distributed是一种逻辑表引擎,并不存储数据。

创建该表引擎时,会指向已配置的分片集,要查询的时候,它会向每个分片发起查询并最终汇总集合然后返回。

这里配置分片集可超灵活的配置,不用的时候可以删除。以后会单独来介绍该引擎的使用。

基于shard+replica实现的线性扩展和高可靠

clickhouse高吞吐写入能力

ClickHouse 采用类 LSM Tree的结构,数据写入后定期在后台 Compaction。

通过类 LSM tree的结构,ClickHouse 在数据导入时全部是顺序 append 写,写入后数据段不可更改,

在后台compaction 时也是多个段 merge sort 后顺序写回磁盘。

顺序写的特性,充分利用了磁盘的吞吐能力,即便在 HDD 上也有着优异的写入性能。

官方公开 benchmark 测试显示能够达到 50MB-200MB/s 的写入吞吐能力,按照每行100Byte 估算,大约相当于 50W-200W 条/s 的写入速度。

LSM结构(Log Structured Merge Tree)解读

1996年,一篇名为 Thelog-structured merge-tree(LSM-tree)的论文创造性地提出了日志结构合并树( Log-Structured Merge-Tree)的概念,该方法既吸收了日志结构方法的优点,又通过将数据文件预排序克服了日志结构方法随机读性能较差的问题。

尽管当时 LSM-tree新颖且优势鲜明,但它真正声名鹊起却是在 10年之后的 2006年,

2006年,Google 发表了 BigTable 的论文。这篇论文提到 BigTable 单机上所使用的数据结构就是 LSM。

那年谷歌的一篇使用了 LSM-tree技术的论文 Bigtable: A Distributed Storage System for Structured Data横空出世,在分布式数据处理领域掀起了一阵旋风,

随后两个声名赫赫的大数据开源组件( 2007年的 HBase与 2008年的 Cassandra,目前两者同为 Apache顶级项目)直接在其思想基础上破茧而出,彻底改变了大数据基础组件的格局,同时也极大地推广了 LSM-tree技术。

目前,LSM 被很多存储产品作为存储结构,比如 Apache HBase, Apache Cassandra, MongoDB 的 Wired Tiger 存储引擎, LevelDB 存储引擎, RocksDB 存储引擎等。

简单地说,LSM 的设计目标是提供比传统的 B+ 树更好的写性能。

LSM 通过将磁盘的随机写转化为顺序写来提高写性能 ,而付出的代价就是牺牲部分读性能、写放大(B+树同样有写放大的问题)。

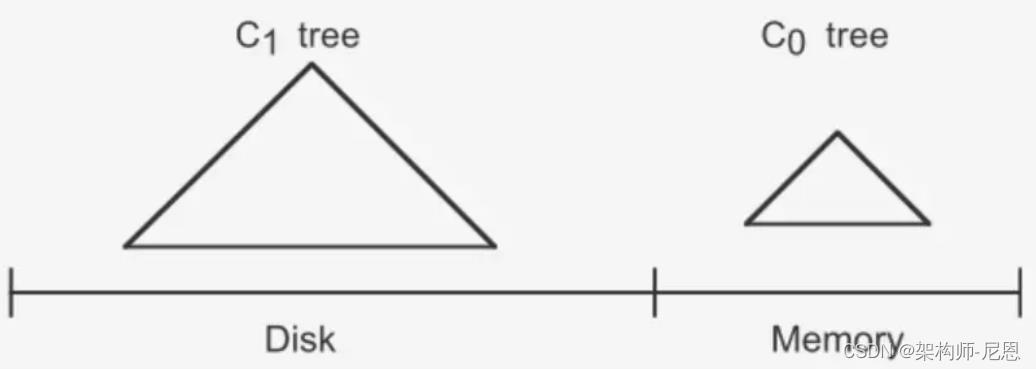

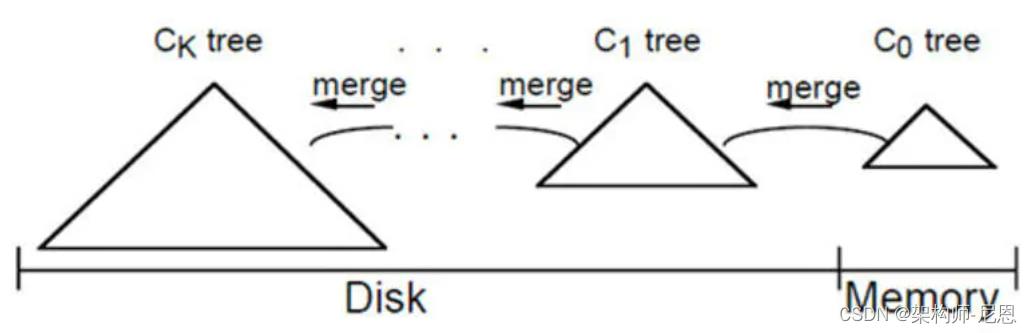

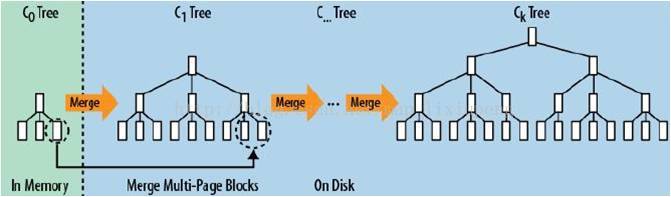

LSM-tree最大的特点是同时使用了两部分类树的数据结构来存储数据,并同时提供查询。

其中一部分数据结构( C0树)存在于内存缓存(通常叫作 memtable)中,负责接受新的数据插入更新以及读请求,并直接在内存中对数据进行排序;

另一部分数据结构( C1树)存在于硬盘上 (这部分通常叫作 sstable),它们是由存在于内存缓存中的 C0树冲写到磁盘而成的,主要负责提供读操作,特点是有序且不可被更改。

LSM 相比 B+ 树能提高写性能的本质原因是:

外存——无论磁盘还是 SSD,其随机读写都要慢于顺序读写。

hash表和B+树

在了解LSM树之前,我们需要对hash表和B+树有所了解。

hash表就不用说了,通过key值经过hash算法,直接定位到数据存储地址,然后取出value值。时间复杂度O(1),找数据和存数据就需要那么一下子,就给找到了

hash存储方式支持增、删、改以及随机读取操作,但不支持顺序扫描,对应的存储系统为key-value存储系统。对于key-value的插入以及查询,哈希表的复杂度都是O(1),明显比树的操作O(n)快,如果不需要有序的遍历数据,哈希表就是最佳选择

B+树我们常用的数据库Mysql的底层数据结构,例如我们的索引就是B+树结构。

B+树是一种专门针对磁盘存储而优化的N叉排序树,以树节点为单位存储在磁盘中,从根开始查找所需数据所在的节点编号和磁盘位置,将起加载到内存中然后继续查找,直到找到所需的数据。

B+树既有排序树的优点,能够很快沿着树枝找打目标节点,又能防止树的高度过高,大大减少磁盘IO次数。还能进行快速全表扫描遍历。

B+ 树的三个特点:

- 节点的子树数和关键字数相同

- 非叶子节点仅用作索引,它的关键字和子节点有重复元素

- 叶子节点形成有序链表,包含了全部数据,同时符合左小右大的顺序

B+树改进了B树, 让内结点只作索引使用, 去掉了其中指向data record的指针, 使得每个结点中能够存放更多的key, 因此能有更大的出度.

这有什么用? 这样就意味着存放同样多的key, 树的层高能进一步被压缩, 使得检索的时间更短。

B树和B+树的对比介绍

首先从二叉树说起,

因为 二叉树 会产生退化现象,提出了平衡二叉树,

在平衡二叉树基础上, 再提出怎样让每一层放的节点多一些,来减少遍历高度,引申出m叉树,

m叉搜索树同样会有退化现象,引出m叉平衡树,也就是B树,这时候每个节点既放了key也放了value,

怎样使每个节点放尽可能多的key值,以减少遍历高度呢(访问磁盘次数),

可以将每个节点只放key值,将value值放在叶子结点,在叶子结点的value值增加指向相邻节点指针,这就是优化后的B+树。所有叶子节点形成有序链表,便于范围查询,不用每次要检索树。

目前数据库多采用两级索引的B+树,树的层次最多三层,因此可能需要5次磁盘访问才能更新一条记录(三次磁盘访问获得数据索引以及行id,然后再进行一次数据文件读操作及一次数据文件写操作)

B~树(平衡多路二叉树)

B树,又叫平衡多路查找树。一棵m阶的B树 (m叉树)的特性如下:

-

树中每个结点至多有m个孩子;

-

除根结点和叶子结点外,其它每个结点至少有[m/2]个孩子;

-

若根结点不是叶子结点,则至少有2个孩子;

-

所有叶子结点都出现在同一层,叶子结点不包含任何关键字信息(可以看做是外部接点或查询失败的接点,实际上这些结点不存在,指向这些结点的指针都为null);

-

每个非终端结点中包含有n个关键字信息: (n,A0,K1,A1,K2,A2,…,Kn,An)。其中,

a) Ki (i=1…n)为关键字,且关键字按顺序排序Ki < K(i-1)。

b) Ai为指向子树根的接点,且指针A(i-1)指向子树种所有结点的关键字均小于Ki,但都大于K(i-1)。

c) 关键字的个数n必须满足: [m/2]-1 <= n <= m-1

B+树

B+树:是应文件系统所需而产生的一种B~树的变形树。

一棵m阶的B+树和m阶的B-树的差异在于:

-

有n棵子树的结点中含有n个关键字; (B~树是n棵子树有n+1个关键字)

-

所有的叶子结点中包含了全部关键字的信息,及指向含有这些关键字记录的指针,且叶子结点本身依关键字的大小自小而大的顺序链接。 (B~树的叶子节点并没有包括全部需要查找的信息)

-

所有的非终端结点可以看成是索引部分,结点中仅含有其子树根结点中最大(或最小)关键字。 (B~树的非终节点也包含需要查找的有效信息)

a、B+树的磁盘读写代价更低

我们都知道磁盘时可以块存储的,也就是同一个磁道上同一盘块中的所有数据都可以一次全部读取。

而B+树的内部结点并没有指向关键字具体信息的指针(比如文件内容的具体地址 , 比如说不包含B~树结点中的FileHardAddress[filenum]部分) 。

因此其内部结点相对B~树更小。如果把所有同一内部结点的关键字存放在同一盘块中,那么盘块所能容纳的关键字数量也越多。

这样,一次性读入内存中的需要查找的关键字也就越多。相对来说IO读写次数也就降低了。

举个例子,假设磁盘中的一个盘块容纳16bytes,而一个关键字2bytes,一个关键字具体信息指针2bytes。一棵9阶B树(一个结点最多8个关键字)的内部结点需要2个盘快。而B+树内部结点只需要1个盘快。当需要把内部结点读入内存中的时候,B树就比B+数多一次盘块查找时间(在磁盘中就是盘片旋转的时间)。

b、B+树的查询效率更加稳定。

由于非终结点并不是最终指向文件内容的结点,而只是叶子结点中关键字的索引。

所以任何关键字的查找必须走一条从根结点到叶子结点的路。

所有关键字查询的路径长度相同,导致每一个数据的查询效率相当。

什么是LSM树

LSM树,即日志结构合并树(Log-Structured Merge-Tree)。

其实它并不属于一个具体的数据结构,它更多是一种数据结构的设计思想。

大多NoSQL数据库核心思想都是基于LSM来做的,只是具体的实现不同。

LSM树诞生背景

传统关系型数据库使用btree或一些变体作为存储结构,能高效进行查找。

但保存在磁盘中时它也有一个明显的缺陷,那就是逻辑上相离很近但物理却可能相隔很远,这就可能造成大量的磁盘随机读写。

随机读写比顺序读写慢很多,为了提升IO性能,我们需要一种能将随机操作变为顺序操作的机制,于是便有了LSM树。

为啥 随机读写比顺序读写慢很多呢?

磁盘读写时涉及到磁盘上数据查找,地址一般由柱面号、盘面号和块号三者构成。

也就是说:

step1:移动臂先根据柱面号移动到指定柱面,

step2: 然后根据 盘面号 确定盘面

step3:最后 块号 确定磁道,最后将指定的磁道段移动到磁头下,便可开始读写。

整个过程主要有三部分时间消耗,查找时间(seek time) +等待时间(latency time)+传输时间(transmission time) 。分别表示定位柱面的耗时、将块号指定 磁道段 移到磁头的耗时、将数据传到内存的耗时。

整个磁盘IO最耗时的地方在查找时间,所以减少查找时间能大幅提升性能。

LSM树原理

LSM树能让我们进行顺序写磁盘,从而大幅提升写操作,作为代价的是牺牲了一些读性能。

LSM树由两个或以上的存储结构组成,

最简单的两个存储结构:

-

一个存储结构常驻内存中,称为C0 tree,具体可以是任何方便健值查找的数据结构,比如红黑树、map之类,甚至可以是跳表。

-

另外一个存储结构常驻在硬盘中,称为C1 tree,具体结构类似B树。

C1所有节点都是100%满的,节点的大小为磁盘块大小。

SSTable的定义

要解释这个术语的真正含义,最好的方法就是从它的出处找答案,所以重新翻开BigTable的论文。

在这篇论文中,最初对SSTable是这么描述的(第三页末和第四页初):

SSTable

The Google SSTable file format is used internally to store Bigtable data.

An SSTable provides a persistent, ordered immutable map from keys to values, where both keys and values are arbitrary byte strings. Operations are provided to look up the value associated with a specified key, and to iterate over all key/value pairs in a specified key range. Internally, each SSTable contains a sequence of blocks (typically each block is 64KB in size, but this is configurable). A block index (stored at the end of the SSTable) is used to locate blocks; the index is loaded into memory when the SSTable is opened. A lookup can be performed with a single disk seek: we first find the appropriate block by performing a binary search in the in-memory index, and then reading the appropriate block from disk. Optionally, an SSTable can be completely mapped into memory, which allows us to perform lookups and scans without touching disk.

简单的非直译:

SSTable是Bigtable内部用于数据的文件格式,它的格式为文件本身就是一个排序的、不可变的、持久的Key/Value对Map,其中Key和value都可以是任意的byte字符串。

使用Key来查找Value,或通过给定Key范围遍历所有的Key/Value对。

每个SSTable包含一系列的Block(一般Block大小为64KB,但是它是可配置的),在SSTable的末尾是Block索引,用于定位Block,这些索引在SSTable打开时被加载到内存中,在查找时首先从内存中的索引二分查找找到Block,然后一次磁盘寻道即可读取到相应的Block。还有一种方案是将这个SSTable加载到内存中,从而在查找和扫描中不需要读取磁盘。

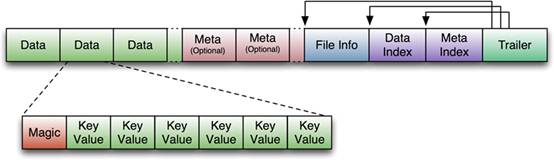

HBase中的SSTable

这个貌似就是HFile第一个版本的格式么,贴张图感受一下:

在HBase使用过程中,对这个版本的HFile遇到以下一些问题(参考这里):

- 解析时内存使用量比较高。

- Bloom Filter和Block索引会变的很大,而影响启动性能。具体的,Bloom Filter可以增长到100MB每个HFile,而Block索引可以增长到300MB,如果一个HRegionServer中有20个HRegion,则他们分别能增长到2GB和6GB的大小。HRegion需要在打开时,需要加载所有的Block索引到内存中,因而影响启动性能;而在第一次Request时,需要将整个Bloom Filter加载到内存中,再开始查找,因而Bloom Filter太大会影响第一次请求的延迟。

而HFile在版本2中对这些问题做了一些优化,具体会在HFile解析时详细说明。

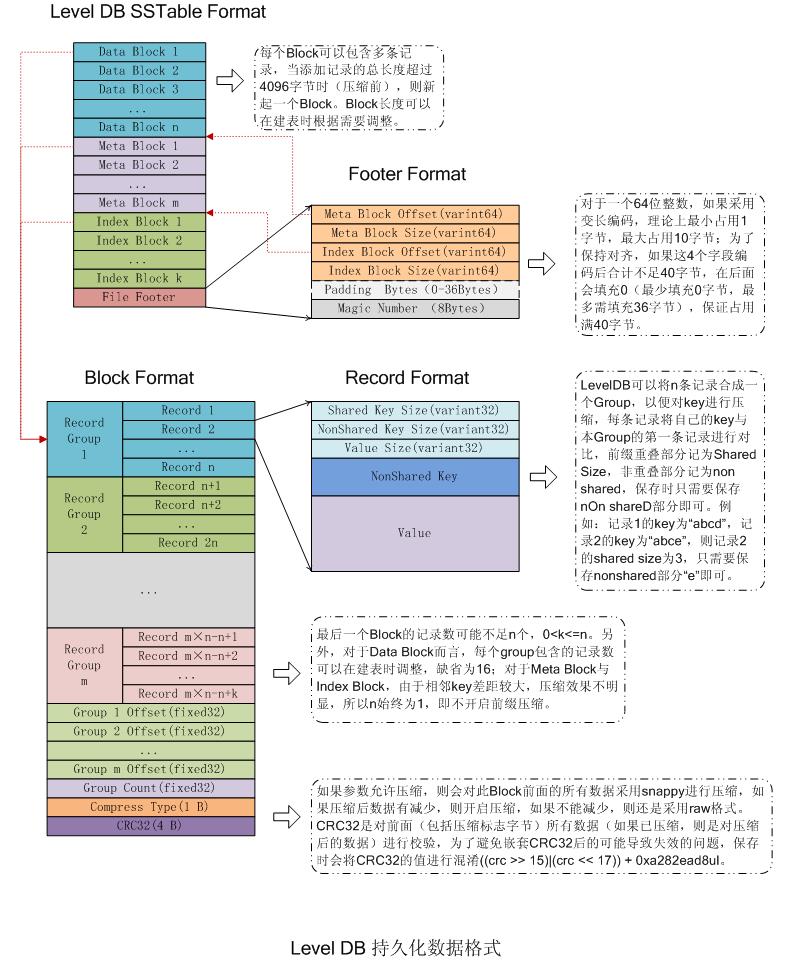

LevelDB 中的SSTable

先看看SSTable文件的结构

整体上看 SSTable文件分为数据区与索引区,

尾部的footer指出了meta index block与data index block的偏移与大小,

index block指出了各data block的偏移与大小,metaindex block指出了filter block的偏移与大小。

1)data block:存储key-value记录,分为Data、type、CRC三部分

2)filter block:默认没有使用,用于快速从data block 判断key-value是否存在

3)metaindex block :记录filter block的相关信息

4)Index block:描述一个data block,存储着对应data block的最大Key值,以及data block在文件中的偏移量和大小

5)footer:索引的索引,记录metaindex block和Index block在SSTable中的偏移量了和大小

下面再具体看看各个部分物理结构

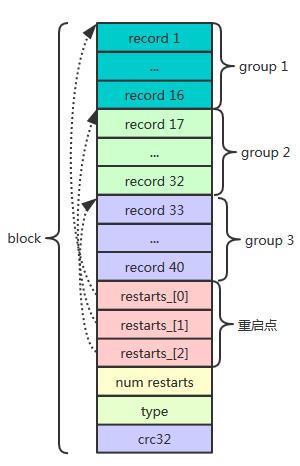

1、block

sstable中data block 、metaindex block、index block都用这种block这种结构。

对于data block,当block大小(record、restarts数组、以及num_restarts)超过4k时,就切换一个新的block继续往SSTable写数据,

而metaindex block、index block就只有一个block,所以上图看起来data block有多个。

block主要由数据区record和restarts组成。 为什么是这种结构?

data block主要是存储数据,block内给一定数量(默认16)key-value分组,

每组又用restarts数组记录起始位置,因此可以根据restarts读取每组起始位置key-value,

由于block内的数据是从小到大有序存储的,所以可以通过restarts数组,获取每组起始key-value,比较起始key key(n)与查找的key大小,如果key(n)>key,那么key一定在序号>=n组之后,否则在 < n组之前。

因此可以通过二分查找思想通过restarts获取起始key,来定位key的位置,避免线性查找低效。

因此,restarts的思想就是:提高block内key-value查找效率,直接定位key所在group。

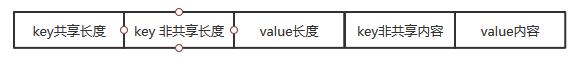

下面再来看看record结构。

record相对有意思,不是简单的用key-length | key-data | value-length|value-data存储。

data block中的key是有序存储的,相邻的key之间可能有重复,因此存储时采用前缀压缩,后一个key只存储与前一个key不同的部分。

重启点指出的位置即每组起始位置的key不按前缀压缩,而是完整存储该key。

type是表示数据是否压缩,以怎样的方式压缩,crc32是该block校验码。

2、index block

index block 的结构也是block 结构,是data block的索引,记录每个data block 最大key 和 起始位置以及大小。

具体的存储方式是以每个data block最大key 为key,以data block 起始位置和大小为value。因此可以根据每个

block的最大key与查询key比较,直接定位查询key所在的位置。

这是理论上key的存储方式,但是在sstable二次压缩的过程对key做了一个优化,它并不保存最大key,而是保存一个能分隔两个data block的最短Key,如:假定data block1的最大一个key为“abcdefg”,data block2最大key为“abzxcv”,则index可以记录data block1的索引key为“abd”;这样的分割串可以有很多,只要保证data block1中的所有Key都小于等于此索引,data block2中的所有Key都大于此索引即可。

这种优化缩减了索引长度,查询时可以有效减小比较次数。

因此,index block的思想是提高SSTable内key-value查找效率,直接定位key所在block。

3、metaindex_block

也是block结构。就只有一条记录,其key是filter. + filter_policy的name,value是filter大小和起始位置。

4、filter block

filter block就是一个bloom filter,关于bloom filter原理概念可以百度。

每个bloom filter是对data block 的key 经过hash num 次形成的字节数组,多少个data block对应多少个bloom filter。

bloom filter实质就是一个bit 数组,对block 内key hash,将相应的位置设为1,这种设计关键在于能提高不存在的key判断效率,通过filter 计算,如果不存在,就不用通过data block内的restarts方式读取文件查找key是否存在,但是如果filter判断存在,还需通过restarts方式确定。

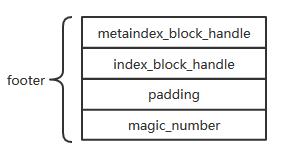

5、footer

footer位于SSTable文件尾部,占用空间固定为48个字节。其末尾8个字节是一个magic_number。metaindex_block_handle与index_block_handle物理上占用了40个字节,metaindex_block_handle和index_block_handle是BlockHandle数据类型, 这种结构用于记录metaindex block 和index block的起始位置和大小。

对于BlockHandle ,其实可以看作文件内容指针实现方式,BlockHandle记录数据位置及大小,与c/c++指针 思想类似,通过地址和大小可以读取数据。

BlockHandle格式

varint64 offset | varint64 size_

采用变长存储,所以实际上存储可能连32字节都不到,剩余填充0。

总结:

SSTable其实就是通过二次索引,先读取footer,

根据footer中index_block_handler记录的index_block起始位置和大小,读取index block,

通过index block 查询key所在data block,再在data block内部通过restarts 进一步确定key所在group。

下面是完整的SSTable结构图

LSM插入步骤

插入一条新纪录时,首先在日志文件中插入操作日志,以便后面恢复使用,日志是以append形式插入,所以速度非常快;

将新纪录的索引插入到C0中,这里在内存中完成,不涉及磁盘IO操作;

当C0大小达到某一阈值时或者每隔一段时间,将C0中记录滚动合并到磁盘C1中;

对于多个存储结构的情况,当C1体量越来越大就向C2合并,以此类推,一直往上合并Ck。

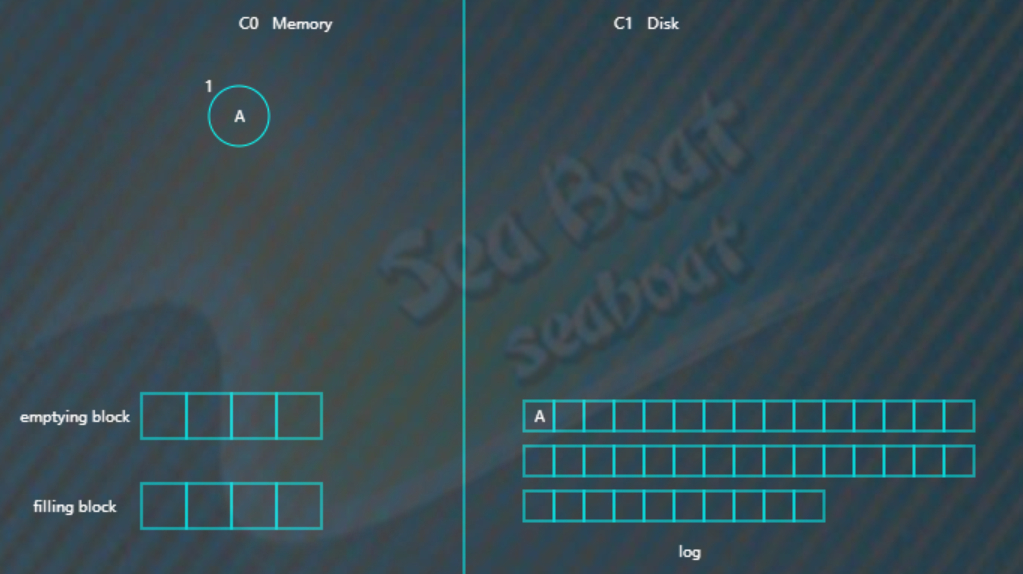

LSM合并步骤

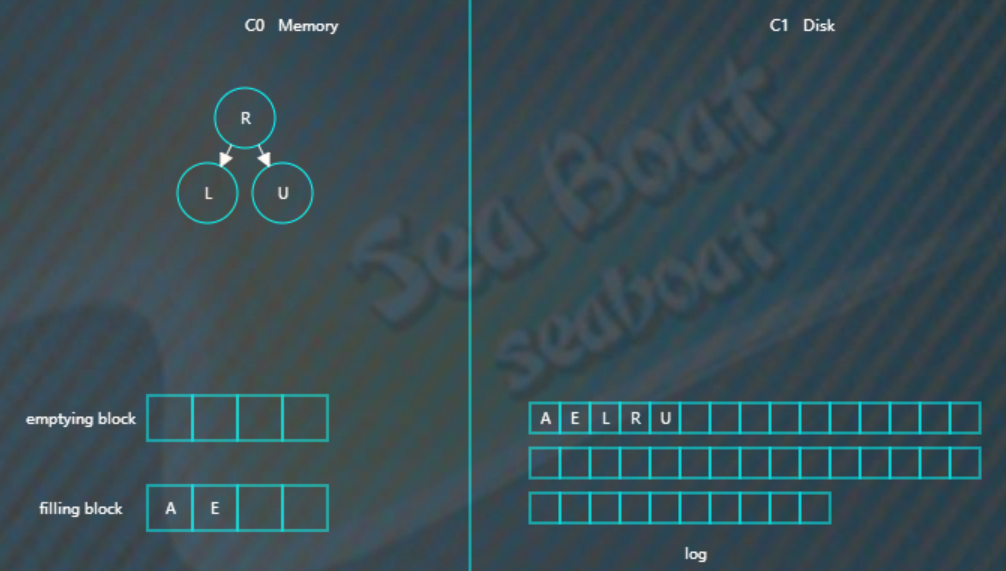

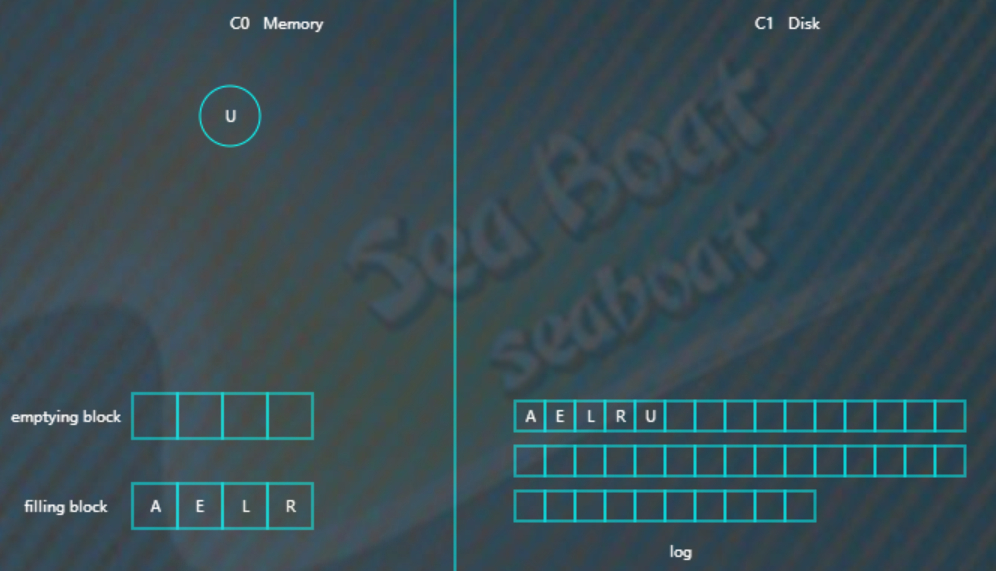

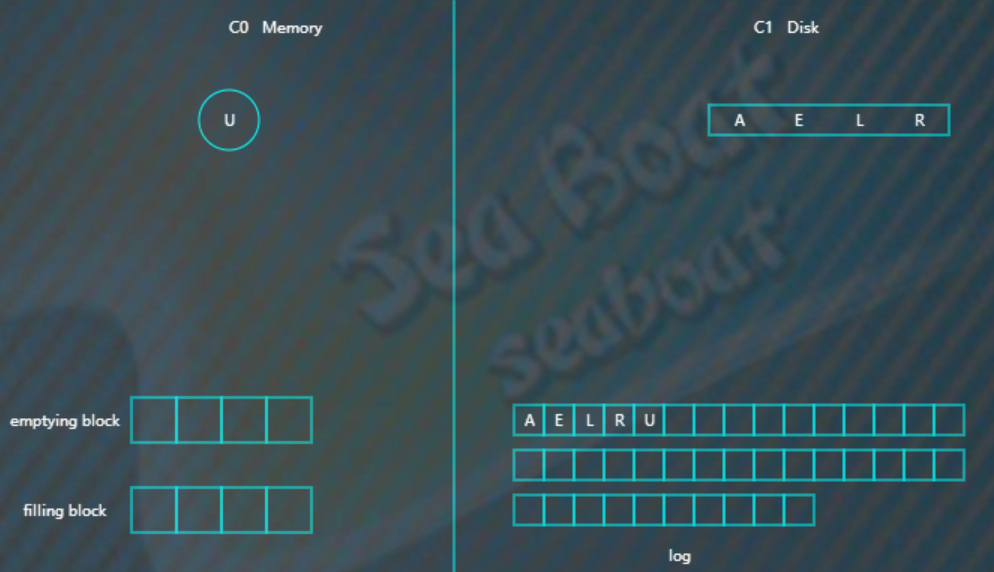

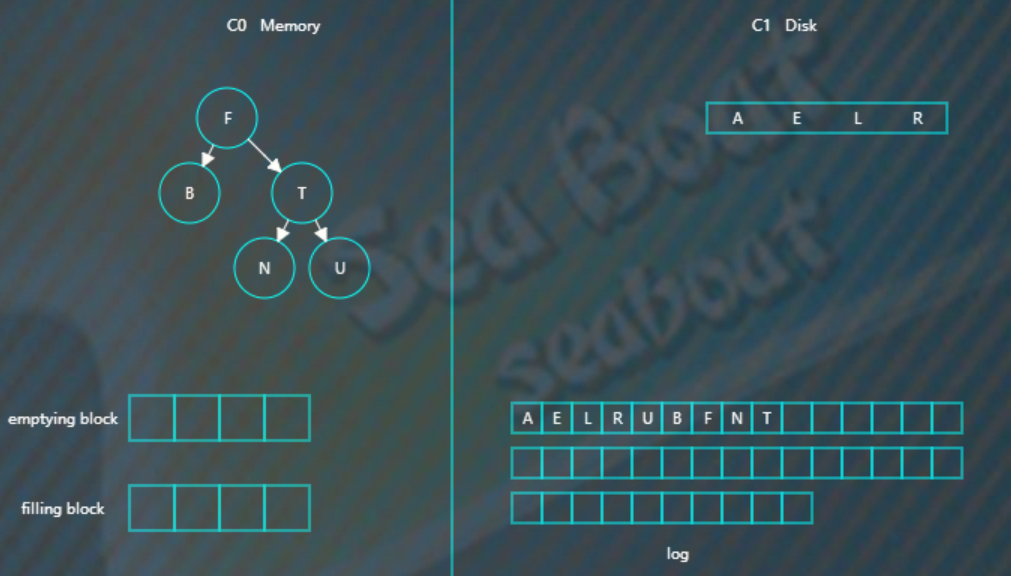

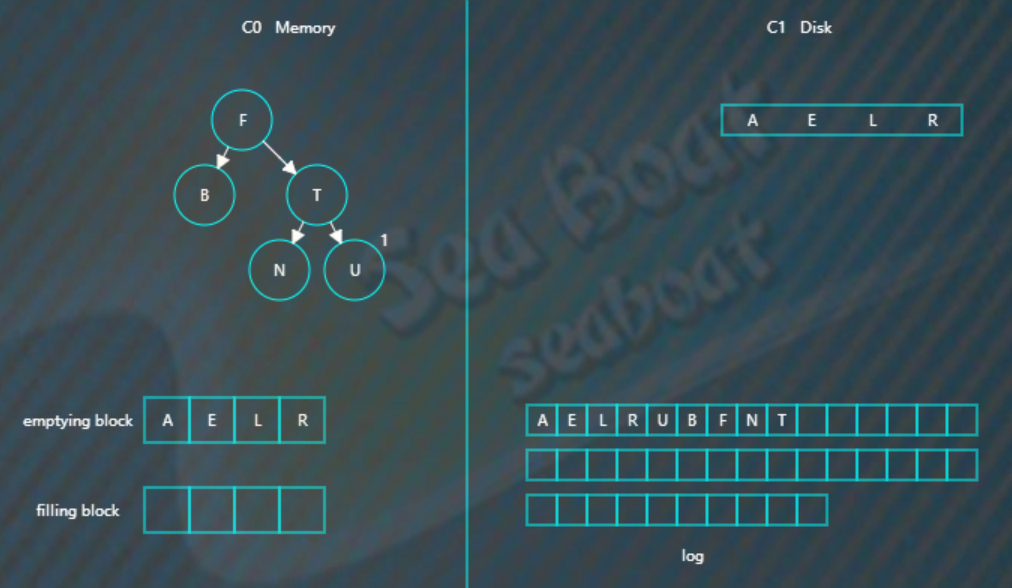

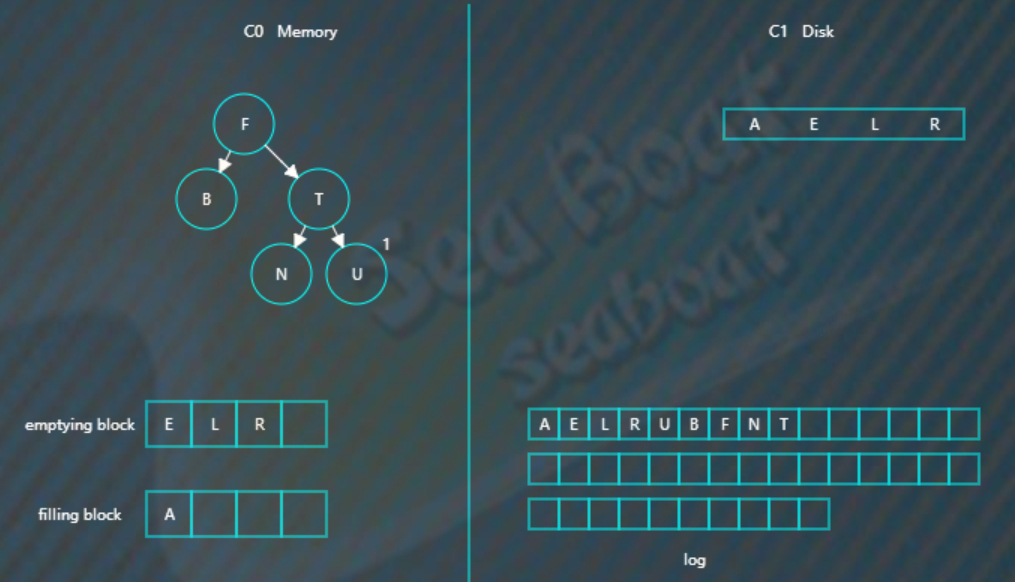

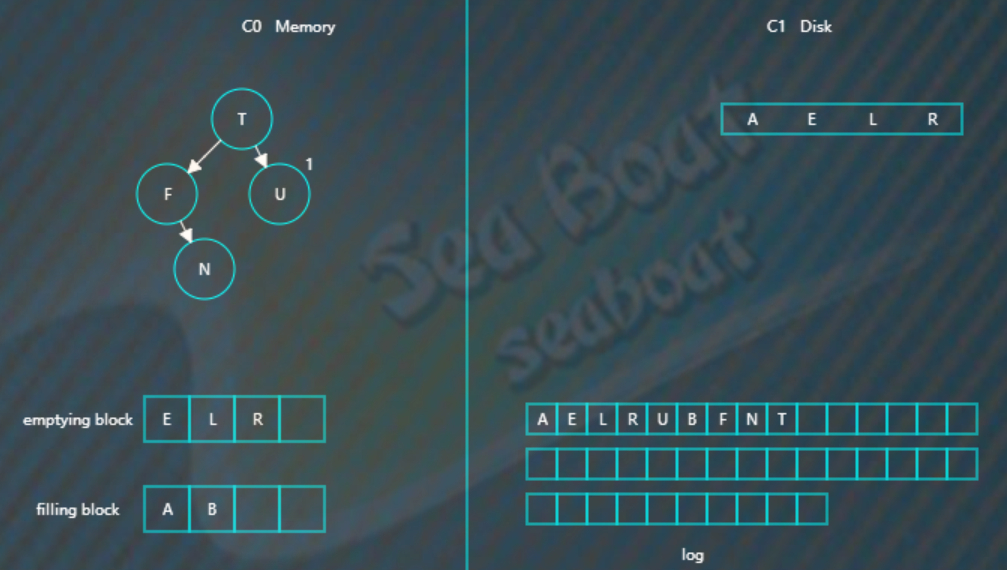

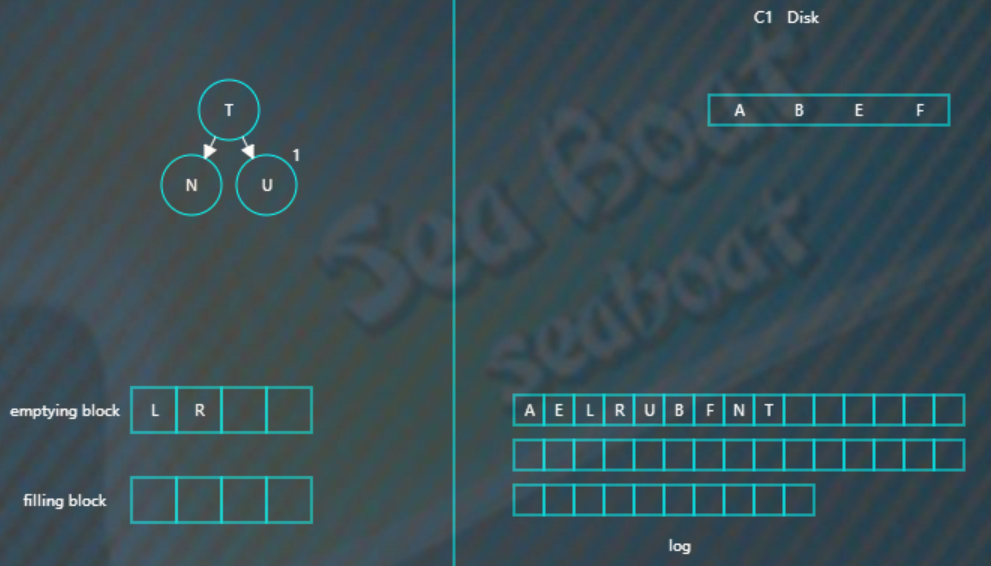

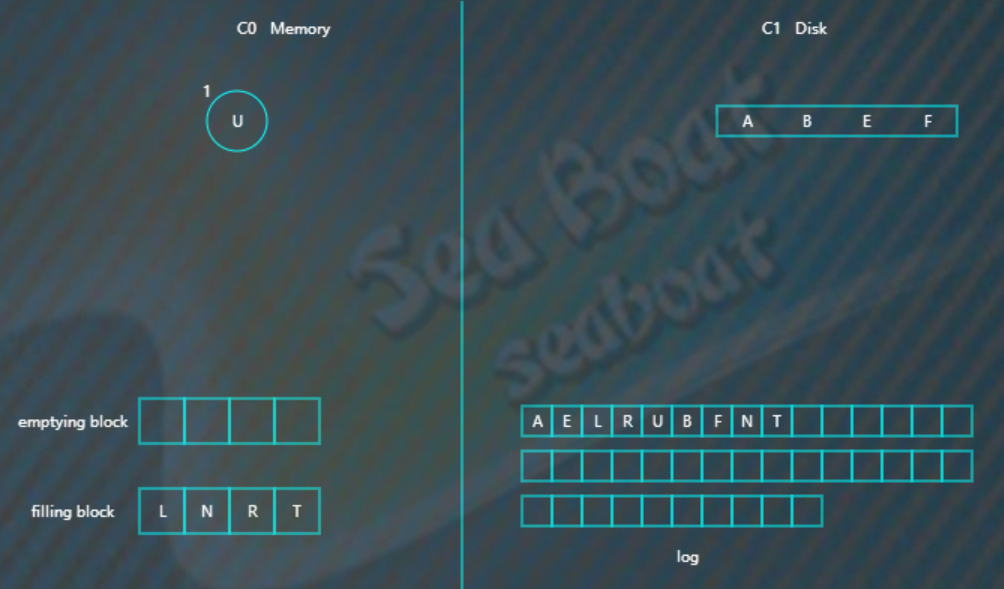

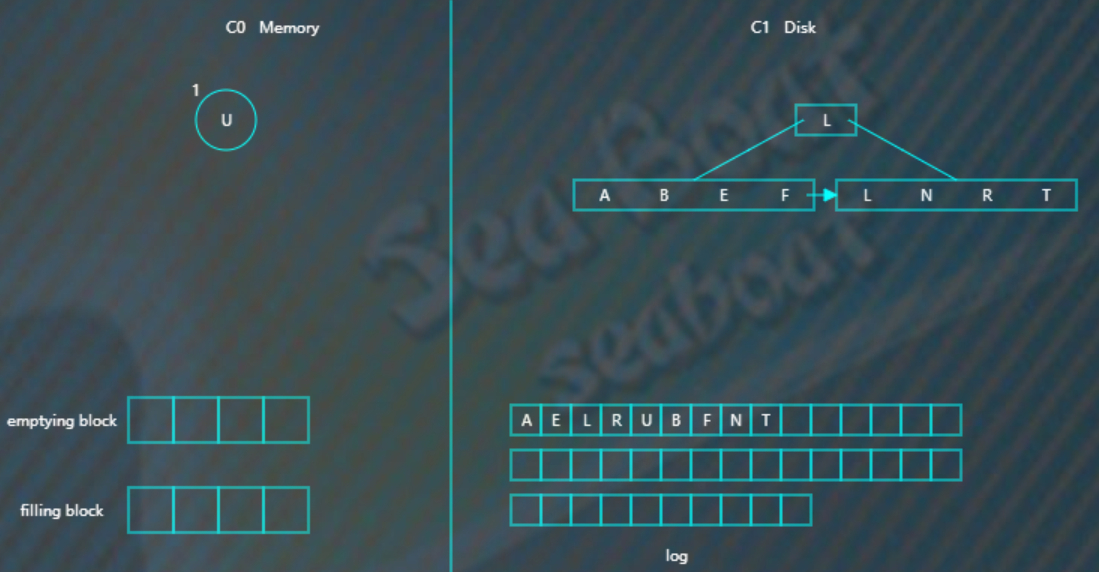

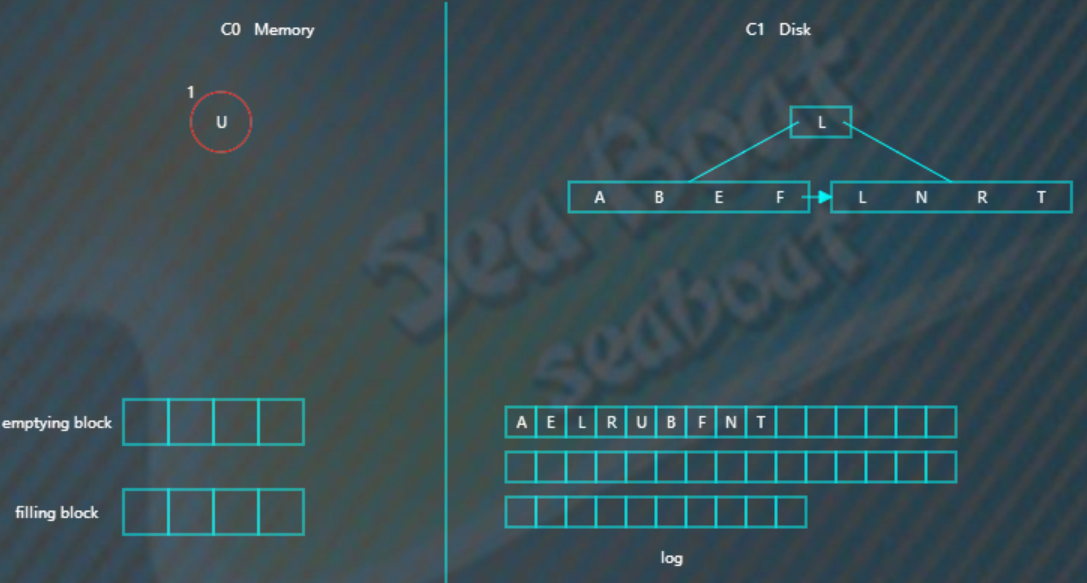

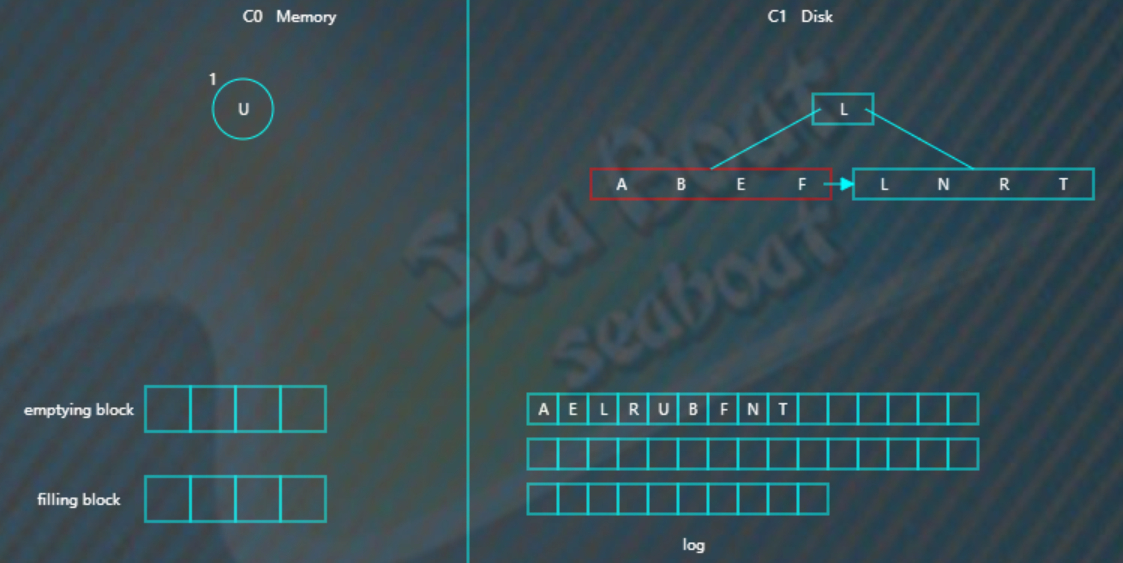

合并过程中会使用两个块:emptying block 和 filling block。

- 从C1中读取未合并叶子节点,放置内存中的emptying block中。

- 从小到大找C0中的节点,与emptying block进行合并排序,合并结果保存到filling block中,并将C0对应的节点删除。

- 不断执行第2步操作,合并排序结果不断填入filling block中,当其满了则将其追加到磁盘的新位置上,注意是追加而不是改变原来的节点。合并期间如故宫emptying block使用完了则再从C1中读取未合并的叶子节点。

- C0和C1所有叶子节点都按以上合并完成后,即完成一次合并。

LSM插入案例

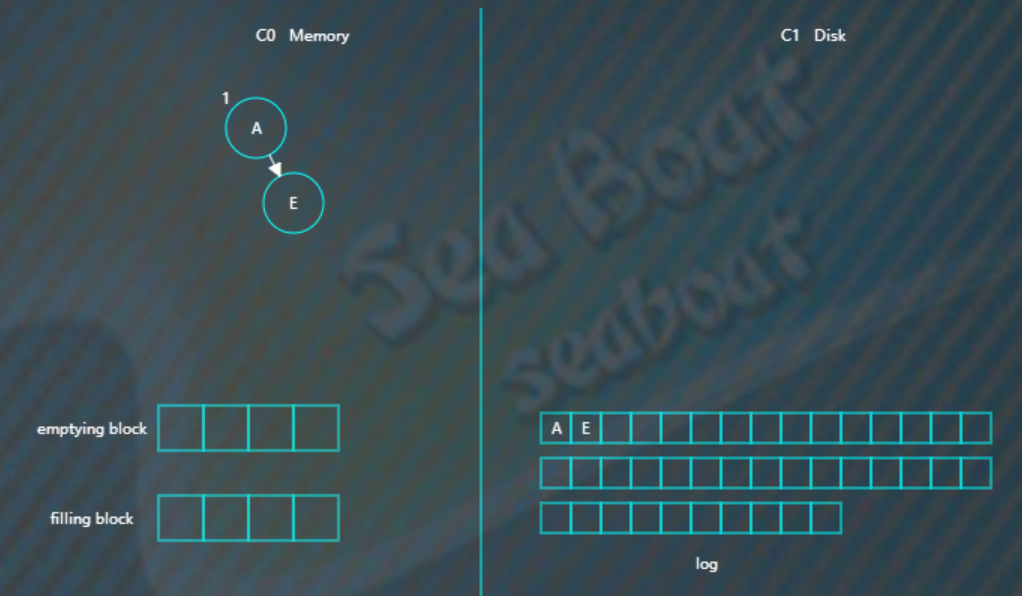

向LSM树中插入 A E L R U ,首先会插入到内存中的C0树上,

这里使用AVL树,插入“A”,

当然,得先WAL, 预先写入日志,向磁盘日志文件追加记录,然后再插入C0,

插入“E”,同样先追加日志再写内存,

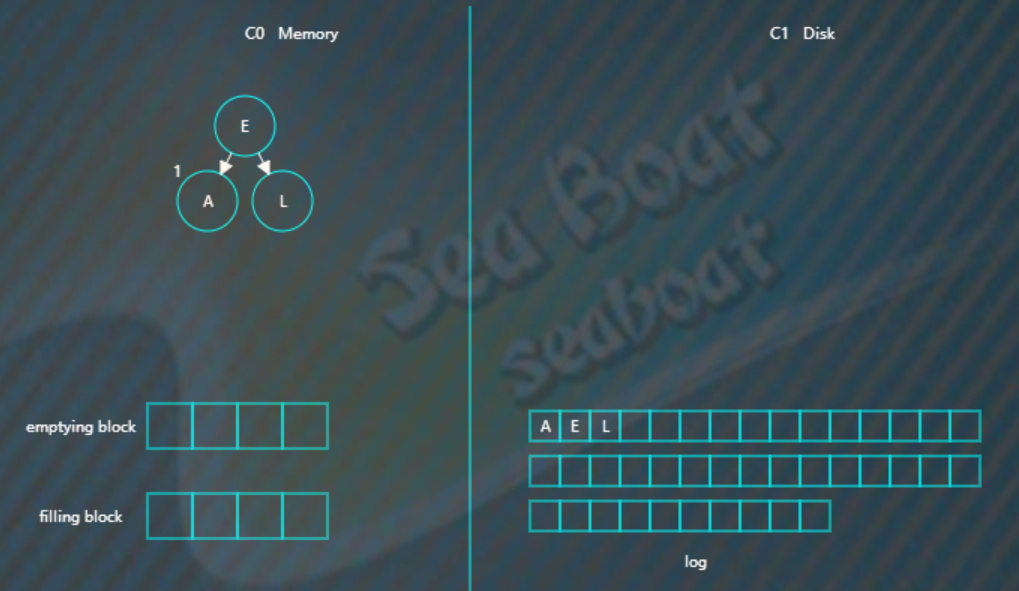

继续插入“L”,旋转后如下,

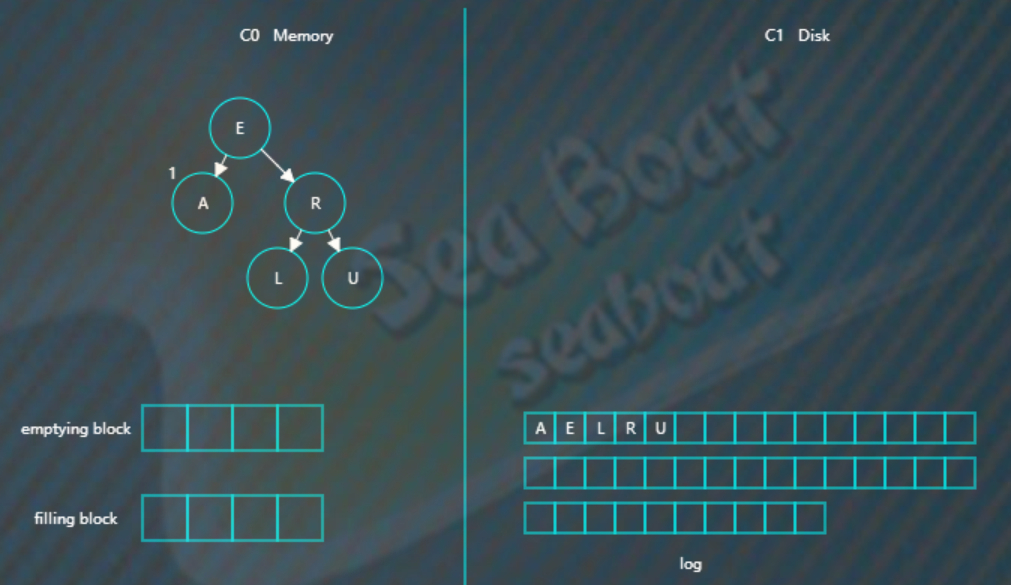

插入“R”“U”,旋转后最终如下。

假设此时触发合并,

则因为C1还没有树,所以emptying block为空,直接从C0树中依次找最小的节点。

filling block长度为4,这里假设磁盘块大小为4。

开始找最小的节点,并放到filling block中,

继续找第二个节点,

以此类推,填满filling block,

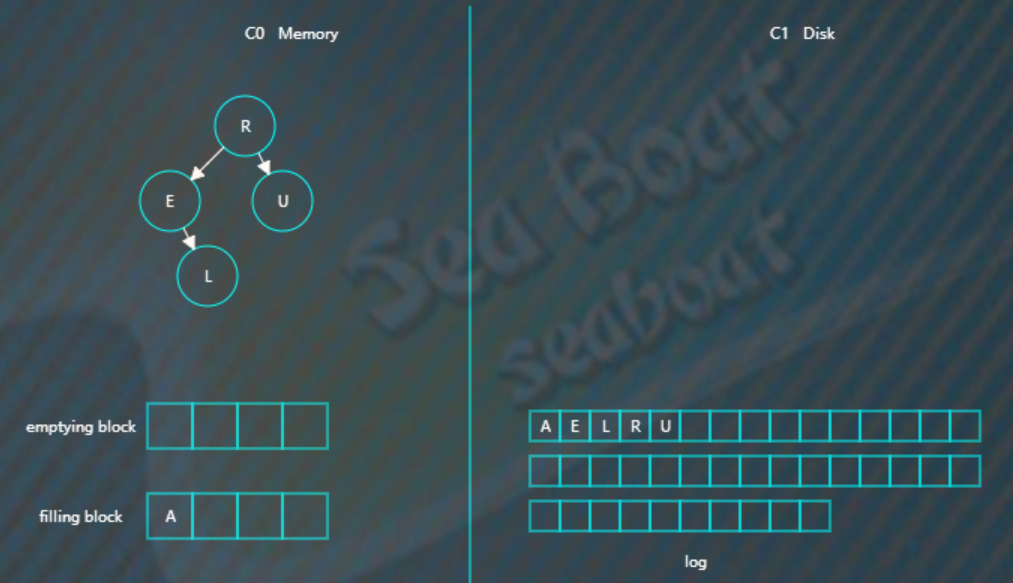

开始写入磁盘,C1树,

继续插入 B F N T ,先分别写日志,然后插入到内存的C0树中,

假如此时进行合并,先加载C1的最左边叶子节点到emptying block,

接着对C0树的节点和emptying block进行合并排序,首先是“A”进入filling block,

然后是“B”,

合并排序最终结果为,

将filling block追加到磁盘的新位置,将原来的节点删除掉,

继续合并排序,再次填满filling block,

将filling block追加到磁盘的新位置,上一层的节点也要以磁盘块(或多个磁盘块)大小写入,尽量避开随机写。另外由于合并过程可能会导致上层节点的更新,可以暂时保存在内存,后面在适当时机写入。

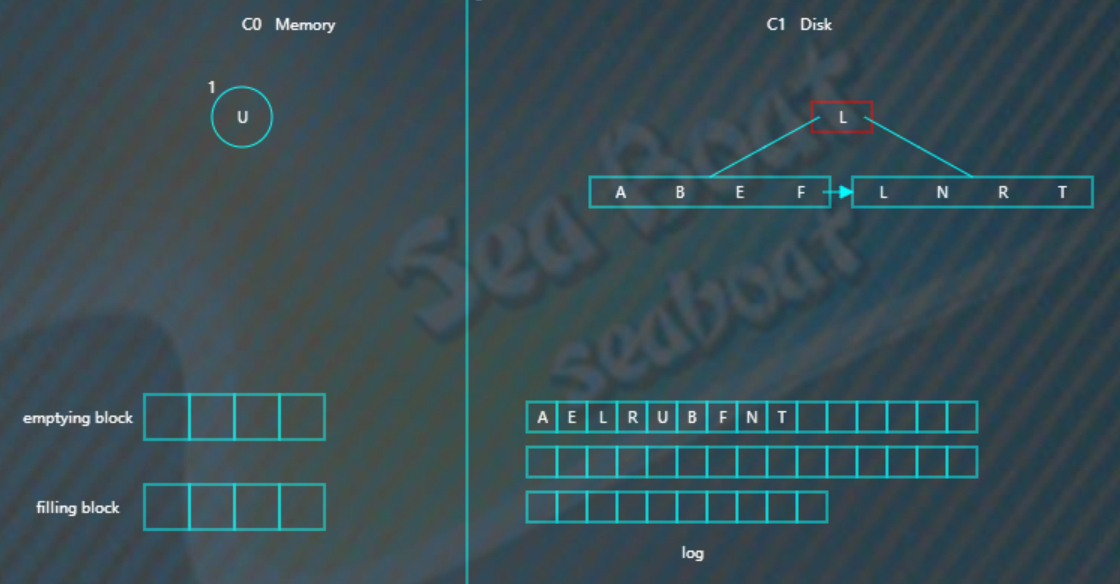

LSM查找操作

查找总体思想是先找内存的C0树,找不到则找磁盘的C1树,然后是C2树,以此类推。

假如要找“B”,先找C0树,没找到。

接着找C1树,从根节点开始,

找到“B”。

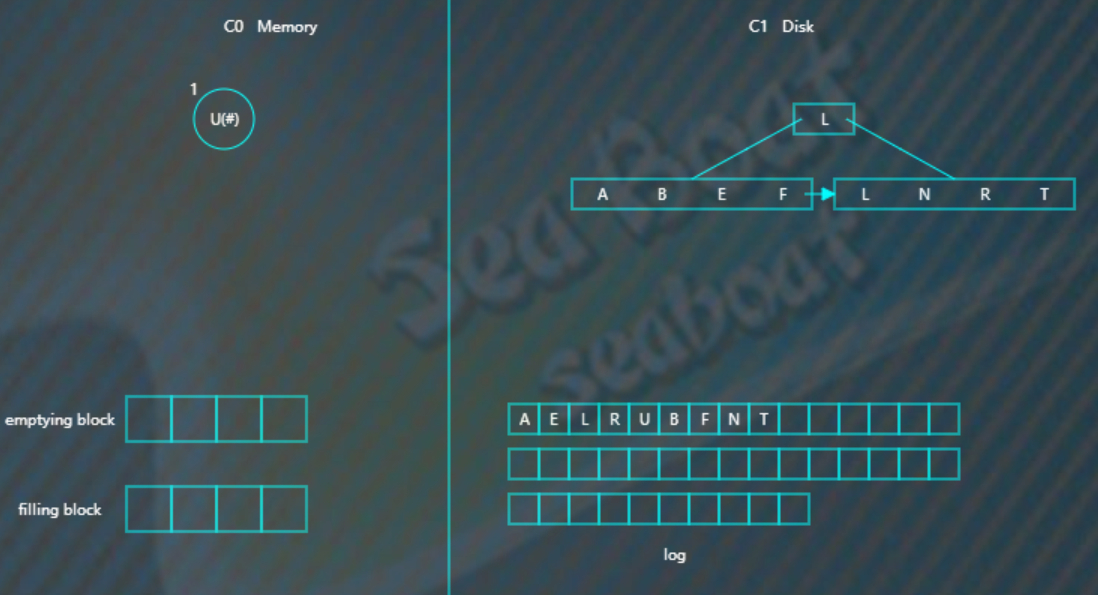

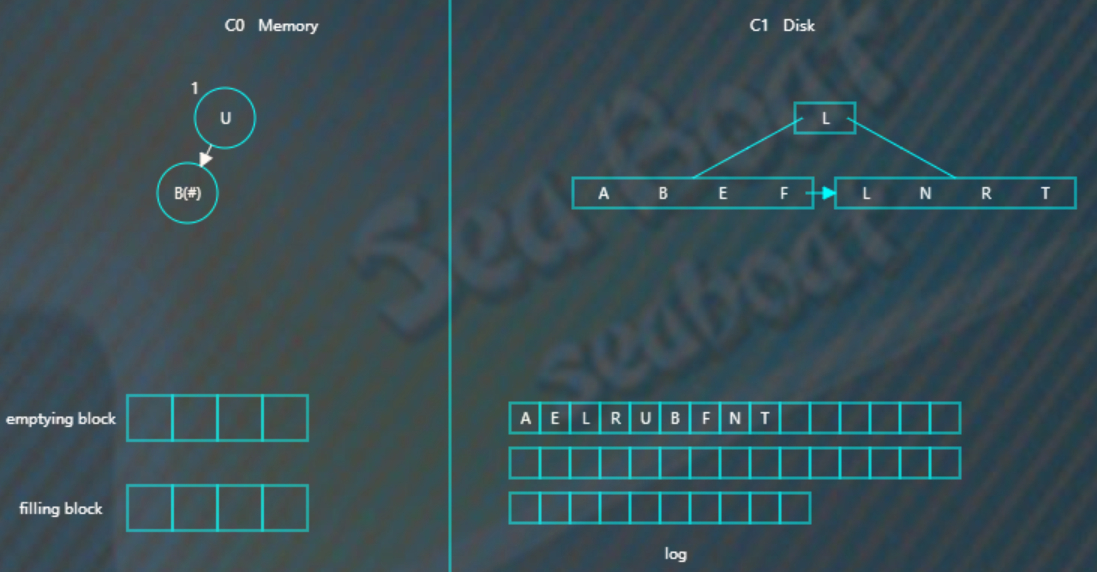

LSM删除操作

删除操作为了能快速执行,主要是通过标记来实现,在内存中将要删除的记录标记一下,后面异步执行合并时将相应记录删除。

比如要删除“U”,假设标为#的表示删除,则C0树的“U”节点变为,

而如果C0树不存在的记录,

则在C0树中生成一个节点,并标为#,查找时就能再内存中得知该记录已被删除,无需去磁盘找了。

比如要删除“B”,那么没有必要去磁盘执行删除操作,直接在C0树中插入一个“B”节点,并标为#。

LSM树的特点:用牺牲读性能,来换取写性能

优化写性能

如果我们对写性能特别敏感,我们最好怎么做?

—— Append Only:所有写操作都是将数据添加到文件末尾。这样做的写性能是最好的,大约等于磁盘的理论速度(200 ~ 300 MB/s)。

但是 Append Only 的方式带来的问题是:

- 读操作不方便。

- 很难支持范围操作。

- 需要垃圾回收(合并过期数据)。

所以, 纯粹的 Append Only 方式只能适用于一些简单的场景:

- 数据库的 WAL(预写日志)。

- 能知道明确的 offset,比如 Bitcask。

如果要优化读性能

如果我们对读性能特别敏感,一般我们有两种方式:

- 有序存储,比如 B+ 树,SkipList 等。

- Hash 存储 —— 不支持范围操作,适用范围有限。

读写性能的权衡

如何获得(接近) Append Only 的写性能,而又能拥有不错的读性能呢?

以 LevelDB 为代表的 LSM 存储引擎给出了一个参考答案。

注意,LevelDB 实现的是优化后的 LSM,原始的 LSM 可以参考论文。

以 LevelDB 例子, LevelDB 的写操作主要由两步组成:

- 写日志并持久化(Append Only)。

- Apply 到内存中的 memtable(SkipList)。

所以,LevelDB 的写速度非常快。

memtable 写“满”后,会转换为 immutable memtable,

然后被后台线程 compaction 成按 Key 有序存储的 sst 文件(顺序写)。

由于 sst 文件会有多个,所以 LevelDB 的读操作可能会有多次磁盘 IO(LevelDB 通过 table cache、block cache 和 bloom filter 等优化措施来减少读操作的磁盘 IO 次数)。

基于 LSM 数据结构的 NO SQL的适用场景:

- 写请求多。

- 写性能要求高:(高吞吐+低延迟)。

LSM-tree的另一大特点是除了使用两部分类树的数据结构外,还会使用日志文件(通常叫作 commit log)来为数据恢复做保障。

这三类数据结构的协作顺序一般是:所有的新插入与更新操作都首先被记录到 commit log中——该操作叫作 WAL(Write Ahead Log),然后再写到 memtable,最后当达到一定条件时数据会从 memtable冲写到 sstable,并抛弃相关的 log数据; memtable与 sstable可同时供查询;当 memtable出问题时,可从 commit log与 sstable中将 memtable的数据恢复。

理论上,可以是内存中树的一部分和磁盘中第一层树做合并,对于磁盘中的树直接做update操作有可能会破坏物理block的连续性,但是实际应用中,一般LSM树有多层,当磁盘中的小树合并成一个大树的时候,可以重新排好顺序,使得block连续,优化读性能。

LSM树的特点:用读性能来换取写性能,将对数据的修改增量保持在内存中,达到指定的大小限制后将这些修改操作批量写入磁盘

LSM树的核心思想:放弃部分读性能,提高写性能

代表数据库:nessDB、LevelDB、HBase等非关系型数据库

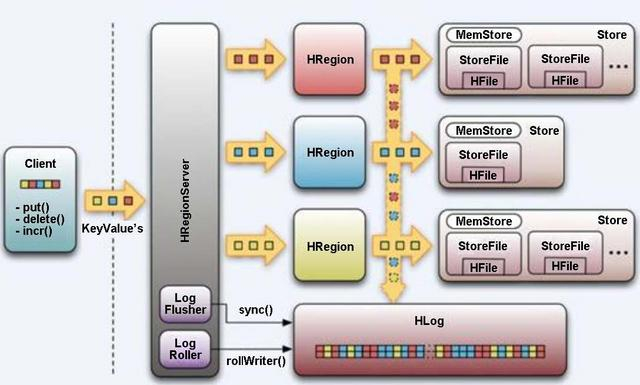

我们可以参考 HBase的架构来体会其架构中基于 LSM-tree的部分特点。

按照 WAL的原则,数据首先会写到 HBase的 HLog(相当于 commit log)里,然后再写到 MemStore(相当于 memtable)里,最后会冲写到磁盘 StoreFile(相当于 sstable)中。

这样 HBase的 HRegionServer就通过 LSM-tree实现了数据文件的生成。

HBase LSM-tree架构示意图如下图。

LSM-tree的这种结构非常有利于数据的快速写入(理论上可以接近磁盘顺序写速度),

但是,LSM-tree不利于读——因为理论上读的时候可能需要同时从 memtable和所有硬盘上的 sstable中查询数据,这样显然会对性能造成较大的影响。

为了解决这个问题, LSM-tree采取了以下主要的相关措施。

- 定期将硬盘上小的 sstable合并(通常叫作 Merge或 Compaction操作)成大的 sstable,以减少 sstable的数量。而且,平时的数据更新删除操作并不会更新原有的数据文件,只会将更新删除操作加到当前的数据文件末端,只有在 sstable合并的时候才会真正将重复的操作或更新去重、合并。

- 对每个 sstable使用布隆过滤器( Bloom Filter),以加速对数据在该 sstable的存在性进行判定,从而减少数据的总查询时间。

LSM树和B+树的差异主要在于读性能和写性能进行权衡,在牺牲的读性能的同时,寻找其余补救方案。

B+树存储引擎,不仅支持单条记录的增、删、读、改操作,还支持顺序扫描(B+树的叶子节点之间的指针),对应的存储系统就是关系数据库。但随着写入操作增多,为了维护B+树结构,节点分裂,读磁盘的随机读写概率会变大,读性能会逐渐减弱。

LSM树(Log-Structured MergeTree)存储引擎和B+树存储引擎一样,同样支持增、删、读、改、顺序扫描操作。而且通过批量存储技术规避磁盘随机写入问题。

当然凡事有利有弊,LSM树和B+树相比,LSM树牺牲了部分读性能,用来大幅提高写性能。

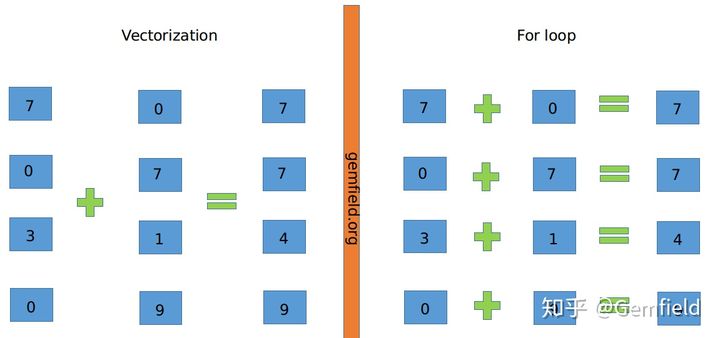

什么是vectorization?

向量化计算(vectorization),也叫vectorized operation,也叫array programming,

说的是一个事情:将多次for循环计算变成一次计算。

上图中,左侧为vectorization,右侧为寻常的For loop计算。

vectorization 将多次for循环计算变成一次计算,

vectorization 完全仰仗于CPU的SIMD指令集,

SIMD指令可以在一条cpu指令上处理2、4、8或者更多份的数据。

在Intel处理器上,这个称之为SSE, 以及后来的AVX,在Arm处理上,这个称之为NEON。

因此简单来说,

for循环计算是将一个loop——处理一个array(N个数据)的时候,每次处理1个数据,共处理N次,

向量化计算就 转化为vectorization——处理一个array的时候每次同时处理8个数据,共处理N/8次。

vectorization如何让速度更快?

介绍SSE 指令集 / AVX指令集之前,先要引入一个向量的概念。所谓向量,

就是多个标量的组合,通常意味着SIMD(单指令多数据),就是一个指令同时对多个数据进行处理,达到很大的吞吐量。

早在1996年,Intel就在X86架构上应用了MMX(多媒体扩展)指令集,那时候还仅仅是64位向量。

到了1999年,SSE(流式SIMD扩展)指令集出现了,这时候的向量提升到了128位。

SIMD

SIMD(Single Instruction Multiple Data,单指令多数据流),是一种实现空间上的并行性的技术。

这种技术使用一个控制器控制多个处理单元,同时对一组数据中的每一个数据执行相同的操作。

在 SIMD 指令执行期间,任意时刻都只有一个进程在运行,即 SIMD 没有并发性,仅仅只是同时进行计算。

在 Intel 的 x86 微架构处理器中,SIMD 指令集有 MMX、SSE、SSE2、SSE3、SSSE3、SSE4.1、SSE4.2、AVX、AVX2、AVX512。

我们以x86指令集为例,

1997年,x86扩展出了MMX指令集,伴随着80-bit的vector寄存器,首开向量化计算的先河。

之后,x86又扩展出了SSE指令集 (有好几个版本, 从SSE1到SEE4.2),伴随着128-bit寄存器。

而在2011年,Intel发布了Sandy Bridge架构——扩展出了AVX指令集(256-bit寄存器)。

在2016年,第一个带有AVX-512寄存器的CPU发布了(512-bit寄存器,可以同时处理16个32-bit的float数)。

SSE和AVX各有16个寄存器。

SSE的16个寄存器为XMM0-XMM15,AVX的16个寄存器为YMM0-YMM15。

XMM 寄存器 registers 每个为128 bits,

YMM寄存器 registers 每个为256bit

AVX-512 寄存器 registers 每个为512bit。

AVX

AVX 是 SSE 架构的延伸,将 SSE 的 XMM 128bit 寄存器升级成了 YMM 256bit 寄存器,同时浮点运算命令扩展至 256 位,运算效率提升了一倍。

另外,AVX 还添加了三操作数指令,以减少在编码时先复制再运算的动作。

AVX2 将大多数整数运算命令扩展至 256 位,同时支持 FMA(Fused Multiply-Accumulate,融合乘法累加)运算,可以在提高运算效率的同时减少运算时的精度损失。

AVX512 将 AVX 指令进一步扩展至 512 位。

AVX指令介绍, 参考该网站:Crunching Numbers with AVX and AVX2 - CodeProject

SSE有3个数据类型:__m128 , __m128d 和 m128i,分别代表Float、double (d) 和integer (i)。

AVX有3个数据类型: m256 , m256d 和 m256i,分别代表Float、double (d) 和 integer (i)。

SSE指令的数据类型

SSE指令有3种数据类型,分别为:

__m256、__m256i、__m256d。

每一种类型都以"__"+"m"+“vector的位长度”构成。

__m256

包含8个float类型数据的向量

__m256i

包含若干个整型数据的向量,如char、short、int、unsigned long long等。

例如256位的vector可以32个char、16个short、8个int,这些整型既可以是有符号的也可以是无符号的。

__m256d

包含4个double类型数据的向量。

指令

SSE指令命名约定

_mm256_<name>_<data_type>

<name>:描述了内联函数的算术操作。

<data_type>:标识函数主要参数的数据类型

从内存中加载数据

指令:_m256i _mm256_loadu_si256 (__m256i const * mem_addr)

从内存中读入一个256位的整型数据放到dst中(32字节地址无需对齐)。

dst[255:0] := MEM[mem_addr+255:mem_addr]

dst[MAX:256] := 0

指令:_m256i _mm256_load_si256 (__m256i const * mem_addr):

从内存中读入一个256位的整型数据放到dst中(32字节地址必需对齐)。

dst[255:0] := MEM[mem_addr+255:mem_addr]

dst[MAX:256] := 0

指令:_m256 _mm256_load_ps (float const * mem_addr):

从内存中读入8个float型数据放入dst(32字节地址必需对齐)。

dst[255:0] := MEM[mem_addr+255:mem_addr]

dst[MAX:256] := 0

指令:_m128 _mm_maskload_ps (float const * mem_addr, m128i mask) :

从内存中读入128位(4个float),根据mask的真假赋值。

FOR j := 0 to 3

i := j*32

IF mask[i+31]

dst[i+31:i] := MEM[mem_addr+i+31:mem_addr+i]

ELSE

dst[i+31:i] := 0

FI

ENDFOR

dst[MAX:128] := 0

指令:_m256 _mm256_maskload_ps (float const * mem_addr, m256i mask):

根据掩码载入8个float数据

FOR j := 0 to 7

i := j*32

IF mask[i+31]

dst[i+31:i] := MEM[mem_addr+i+31:mem_addr+i]

ELSE

dst[i+31:i] := 0

FI

ENDFOR

dst[MAX:256] := 0

指令:_m256 _mm256_add_ps (__m256 a, __m256 b):

将 a+b 操作按32位float进行处理,其中32位不能有溢出。

FOR j := 0 to 7

i := j*32

dst[i+31:i] := a[i+31:i] + b[i+31:i]

ENDFOR

dst[MAX:256] := 0

指令:_m256i _mm256_add_epi8 (__m256i a, __m256i b):

将 a+b 操作按8位整型进行处理,其中8位不能有溢出。

FOR j := 0 to 31

i := j*8

dst[i+7:i] := a[i+7:i] + b[i+7:i]

ENDFOR

dst[MAX:构建高可用的Redis服务(主从复制/哨兵/集群底层原理)