神经网络机器翻译Neural Machine Translation: Gradient-based Optimization Algorithms

Posted clear-

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了神经网络机器翻译Neural Machine Translation: Gradient-based Optimization Algorithms相关的知识,希望对你有一定的参考价值。

本文将介绍近两年应用到端到端的神经网络模型中的一些优化方法。

转载请注明出处:http://blog.csdn.net/u011414416/article/details/51567362

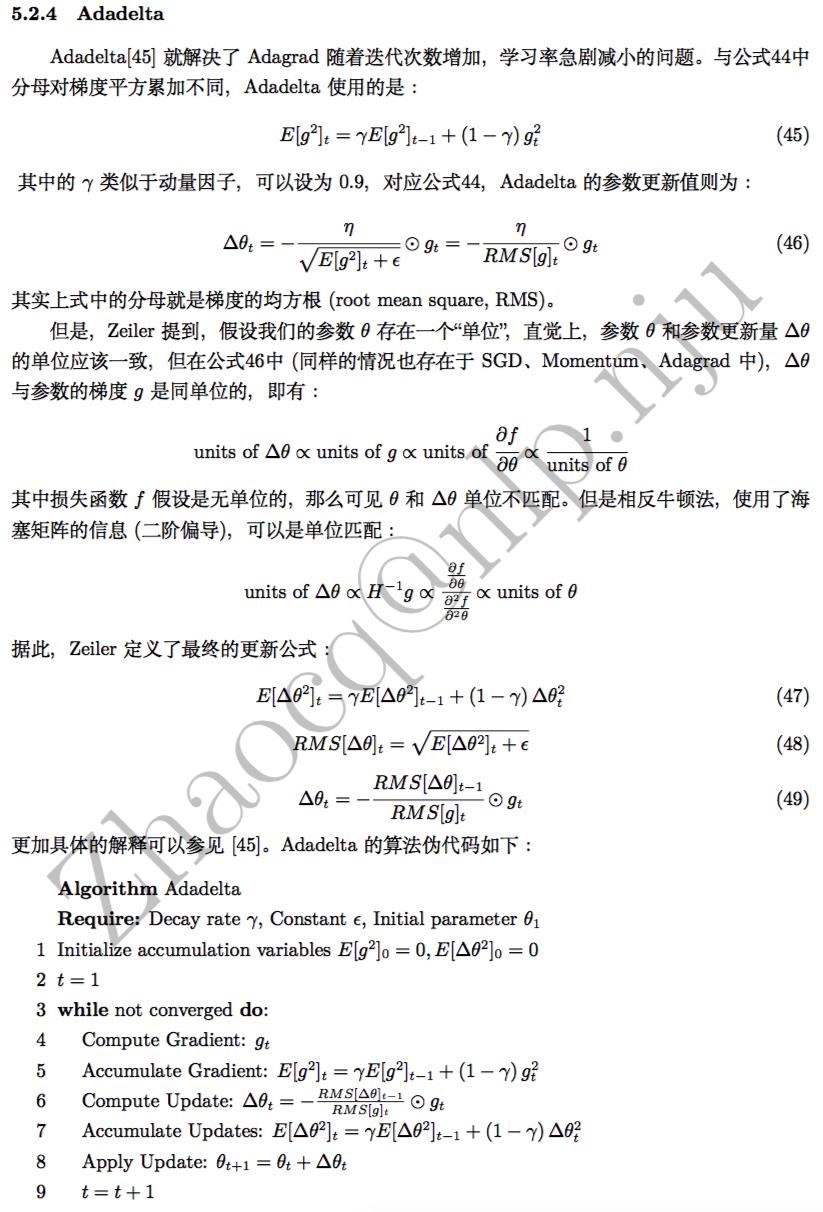

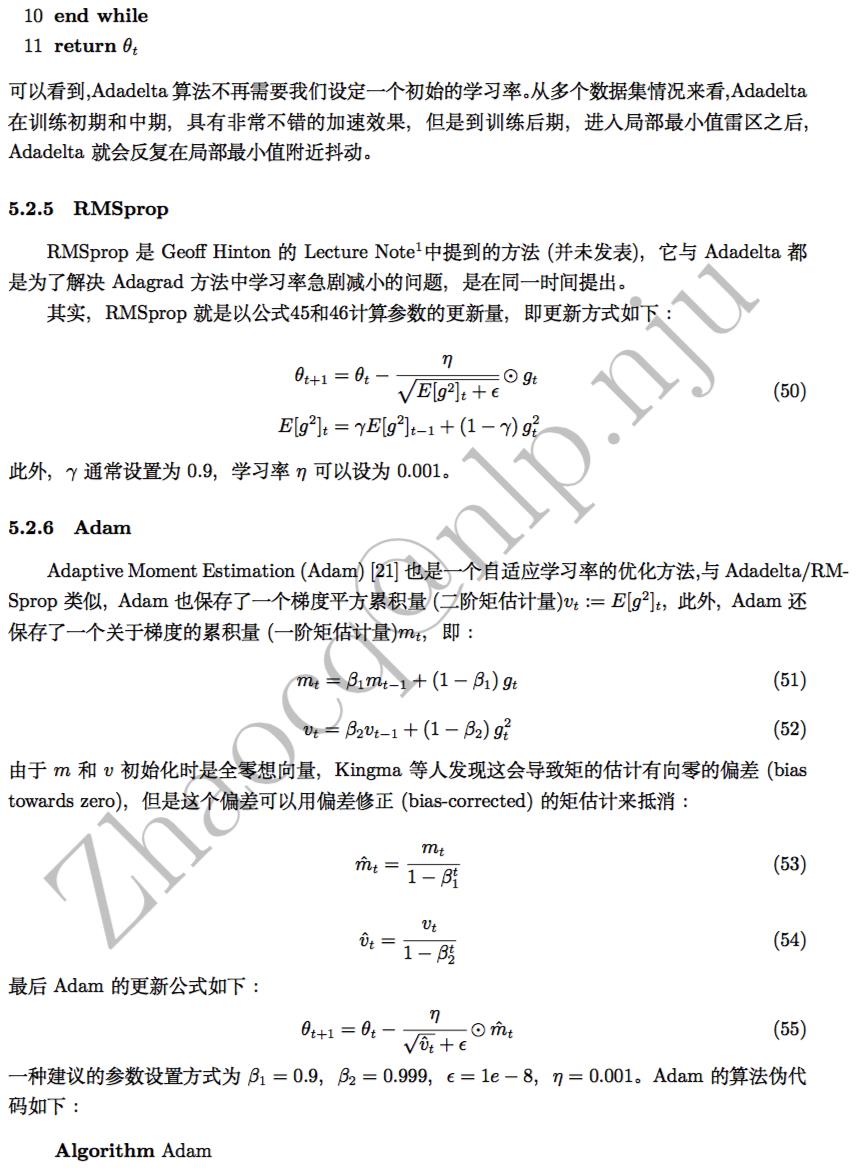

本文将介绍近两年应用到端到端的神经网络模型中的一些参数优化方法,包括SGD、Momentum、NAG、Adagrad、Adadelta、RMSprop、Adam等。

本文全文参考自博客:http://sebastianruder.com/optimizing-gradient-descent/index.html

Hinton’s Lecture: http://www.cs.toronto.edu/~tijmen/csc321/slides/lecture_slides_lec6.pdf

各个方法在MNIST数据集上的比较: http://cs.stanford.edu/people/karpathy/convnetjs/demo/trainers.html

以上是关于神经网络机器翻译Neural Machine Translation: Gradient-based Optimization Algorithms的主要内容,如果未能解决你的问题,请参考以下文章

神经网络机器翻译Neural Machine Translation: Encoder-Decoder Architecture

神经网络机器翻译Neural Machine Translation: Attention Mechanism

神经网络机器翻译Neural Machine Translation: Attention Mechanism

《Neural Machine Translation: Challenges, Progress and Future》译文分享

神经网络机器翻译Neural Machine Translation: Encoder-Decoder Architecture