Flink 实战系列Flink SQL 使用 filesystem connector 同步 Kafka 数据到 HDFS(parquet 格式 + snappy 压缩)

Posted JasonLee实时计算

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Flink 实战系列Flink SQL 使用 filesystem connector 同步 Kafka 数据到 HDFS(parquet 格式 + snappy 压缩)相关的知识,希望对你有一定的参考价值。

Flink SQL 同步 Kafka 数据到 HDFS(parquet + snappy)

在上一篇文章中,我们用 datastream API 实现了从 Kafka 读取数据写到 HDFS 并且用 snappy 压缩,今天这篇文章我们来实现一个 Flink SQL 版本的,为了方便我直接采用 sql-client 提交任务的方式来演示。

添加 jar 包

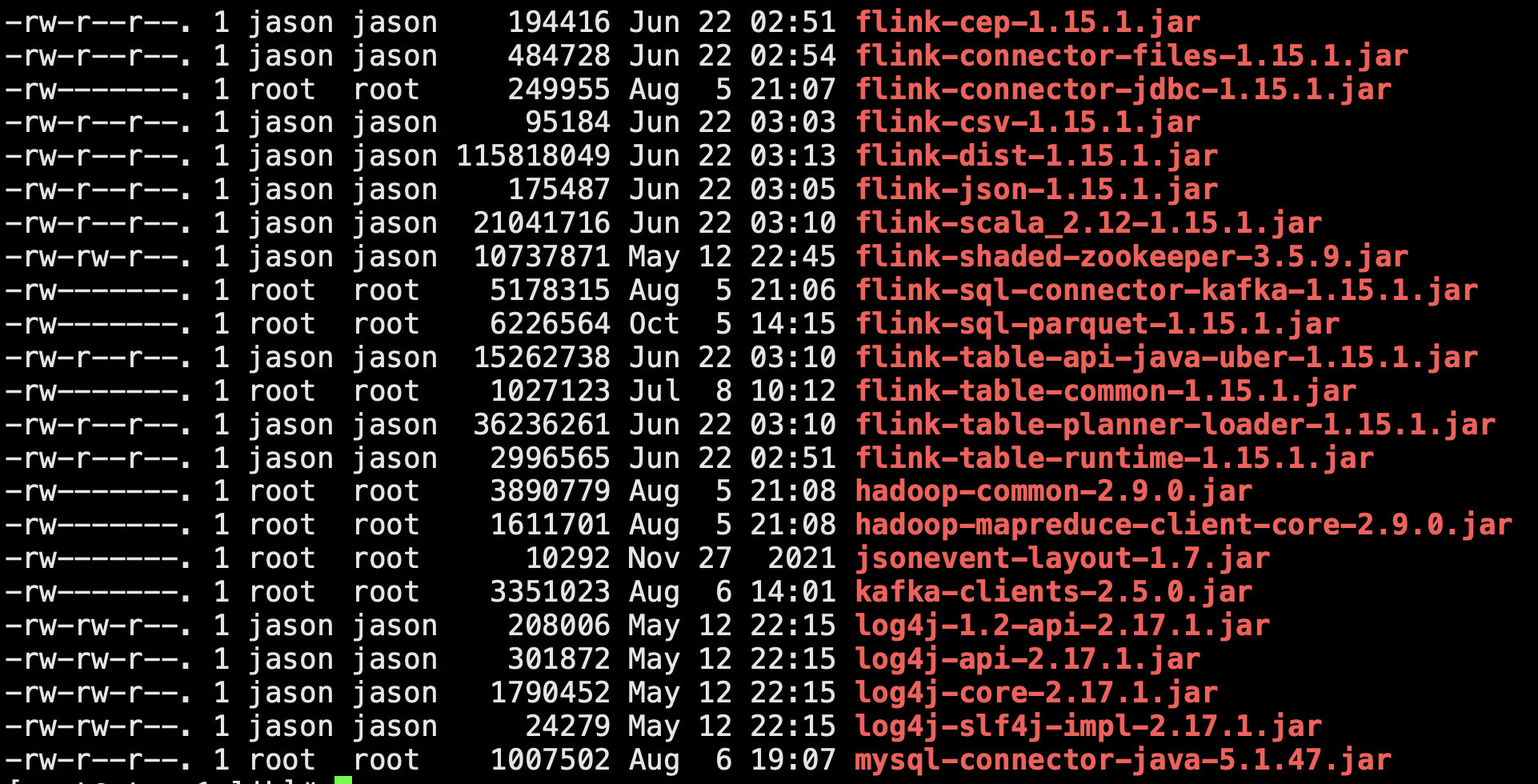

第一步肯定是添加我们需要的 jar 包了,一共需要下面这几个 jar 包:

flink-connector-files-1.15.1.jar

flink-sql-connector-kafka-1.15.1.jar

flink-sql-parquet-1.15.1.jar

hadoop-mapreduce-client-core-2.9.0.jar

因为我们用的是 Flink SQL,那 flink-parquet 有一个专门为 SQL 使用而打的包 flink-sql-parquet-1.15.1.jar。

以上是关于Flink 实战系列Flink SQL 使用 filesystem connector 同步 Kafka 数据到 HDFS(parquet 格式 + snappy 压缩)的主要内容,如果未能解决你的问题,请参考以下文章