BILIBILI 高并发实时弹幕系统那些事(项目开源架构演变)

Posted 由此及彼

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了BILIBILI 高并发实时弹幕系统那些事(项目开源架构演变)相关的知识,希望对你有一定的参考价值。

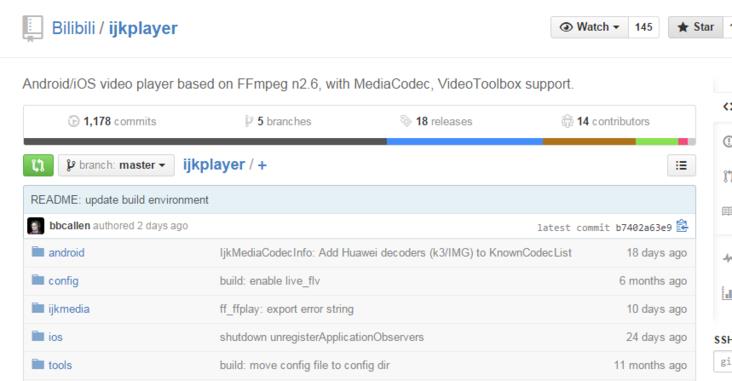

B 站建立开源工作组:ijkplayer 等多个项目开源

SegmentFault 兄弟 + 基友单位弹幕视频网 Bilibili(B 站)近日在 GitHub 网站上建立了开源工作组(BOSTF)(此处 1024 赞),用以分享与维护自己的开源项目,其中包括 DanmakuFlameMaster(燃烧吧!烈焰弹幕使)与 ijkplayer。前者是免费提供 android 平台下应用弹幕集成的解决方案,而后者则提供 Android 和 ios 双平台视频播放器的解决方案。

DanmakuFlameMaster

项目地址:https://github.com/Bilibili/DanmakuFlameMaster

DanmakuFlameMaster,android 上开源弹幕解析绘制引擎项目,实现的特性有:

- 使用多种方式 ( View / SurfaceView / TextureView ) 实现高效绘制

- B 站 xml 弹幕格式解析

- 基础弹幕精确还原绘制

- 支持 mode7 特殊弹幕

- 多核机型优化,高效的预缓存机制

- 支持多种显示效果选项实时切换

- 实时弹幕显示支持

- 换行弹幕支持/运动弹幕支持

- 支持自定义字体

- 支持多种弹幕参数设置

- 支持多种方式的弹幕屏蔽

ijkplayer

项目地址:https://github.com/Bilibili/ijkplayer

ijkplayer,基于 ffplay 的跨平台播放器,实现的特性有:

- 移除 FFmpeg 中不常用的特性以减小体积。

- 对一些在线视频播放的 BUG 修复

- 支持安卓 API 9-22 和 iOS 5.1.1-8.3.X

- 使用各种平台原生的渲染方式进行优化

作为国内首屈一指的弹幕视频网站,B 站的两个开源项目已经被多个 App 使用。其中美拍和斗鱼使用了 ijkplayer 项目,DanmakuFlameMaster 项目则被包括优酷土豆、开迅视频、MissEvan、echo 回声、斗鱼 TV、天天动听、被窝声次元、ACFUN 等 App 使用。

技术上,ijkplayer 实现了跨平台功能,支持 Android 和 iOS 双平台;API 易于集成;编译配置可裁剪,方便控制安装包大小;支持 硬件加速解码,更加省电。而DanmakuFlameMaster 架构清晰,简单易用,支持多种高效率绘制方式选择,支持多种自定义功能设置。

Bilibili,也被称为哔哩哔哩、B 站,是中国大陆一个动画、游戏相关的弹幕视频分享网站,因为其深厚的宅文化和实时评论功能,已经在 90 后中收到广泛的欢迎。据悉,B 站的程序员也多为 90 后。

哔哩哔哩~( ゜- ゜)つロ 乾杯~

大舒 2015年05月08日发布

https://segmentfault.com/a/1190000002739762

BILIBILI 高并发实时弹幕系统的实战之路 | 架构师实践日

编者按:随着直播的发展,直播弹幕也逐渐火爆起来。在架构设计上,高稳定、高可用、低延迟是一款直播弹幕系统必备的三要素。7 月31 日,在七牛云主办的架构师实践日上,来自 bilibili 的架构师刘丁,从这三个方面出发,为大家带来了 bilibili 在直播弹幕服务架构上的最佳实践。下面是对他演讲内容的整理。

刘丁,bilibili 架构师,2015 年加入 B 站,在 B 站负责直播弹幕、主站弹幕、推送平台等后端基础服务开发,同时兼职 DBA。2011 年毕业后,加入猎豹移动从事 C++ 客户端开发,曾开发项目「远程维修平台」,2013 年年初,转型后端开发(以 Go 为主)主要负责猎豹视频软件的后端 API 支持,以及弹泡系统,GoPush-Cluster,GOIM 开源项目的开发。高并发实时弹幕是一种互动的体验。对于互动来说,考虑最多的地方就是:高稳定性、高可用性以及低延迟这三个方面。

- 高稳定性,为了保证互动的实时性,所以要求连接状态稳定。

- 高可用性,相当于提供一种备用方案,比如,互动时如果一台机器挂了,此时必须保证可以和另外一台机器连接,这样就从侧面解决了用户连接不中断的问题。

- 对于低延迟,弹幕的延迟周期控制在 1 秒以内,响应是比较快的,所以可以满足互动的需求。

B 站直播弹幕服务架构(下面简称 GOIM )的出现就是为了解决这一系列的需求。下面将对此进行详细的介绍。

B 站直播弹幕服务架构 GOIM 的出现

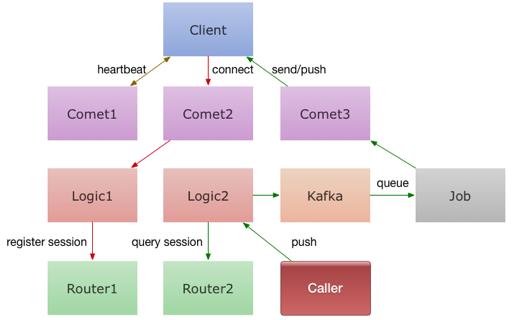

直播聊天系统本质上也是一种推送系统,所谓推送系统就是,当你发送一条消息时,它可以将这个消息推送给所有人。对于直播弹幕来说,用户在不断地发送消息,不断地进行广播,当一个房间里面有 10 万人时,一个消息就要发出 10 万次请求。在 GOIM 出现之前,也用过另一个名为 Gopush 的项目,这个项目推出的目的就是进行推送。在此之后,基于一些针对性的应用场景,GOIM 对 Gopush 进行了优化,从而出现在我们视野当中。GOIM 主要包含以下几个模块(图 1):

- Kafka(第三方服务)

消息队列系统。Kafka 是一个分布式的基于发布/订阅的消息系统,它是支持水平扩展的。每条发布到 Kafka 集群的消息都会打上一个名为 Topic(逻辑上可以被认为是一个 queue)的类别,起到消息分布式分发的作用。 - Router

存储消息。Comet 将信息传送给 Logic 之后,Logic 会对所收到的信息进行存储,采用 register session 的方式在 Router 上进行存储。Router 里面会收录用户的注册信息,这样就可以知道用户是与哪个机器建立的连接。 - Logic

对消息进行逻辑处理。用户建立连接之后会将消息转发给 Logic ,在 Logic 上可以进行账号验证。当然,类似于 IP 过滤以及黑名单设置此类的操作也可以经由 Logic 进行。 - Comet

维护客户端长链接。在上面可以规定一些业务需求,比如可以规定用户传送的信息的内容、输送用户信息等。Comet 提供并维持服务端与客户端之间的链接,这里保证链接可用性的方法主要是发送链接协议(如 Socket 等)。 - Client

客户端。与 Comet 建立链接。 - Jop

消息分发。可以起多个 Jop 模块放到不同的机器上进行覆盖,将消息收录之后,分发到所有的 Comet 上,之后再由 Comet 转发出去。

以上就是 GOIM 系统实现客户端建立链接,并进行消息转发的一个具体过程。一开始这个结构并不完善,在代码层面也存在一些问题。鉴于这些问题,B 站提供了一些相关的优化操作。在高稳定性方面,提供了内存优化、模块优化以及网络优化,下面是对这些优化操作的介绍。

GOIM 系统的优化之路

内存优化

内存优化主要分为以下三个方面:

1.一个消息一定只有一块内存

使用 Job 聚合消息,Comet 指针引用。

2.一个用户的内存尽量放到栈上

内存创建在对应的用户 Goroutine(Go 程)中。

3.内存由自己控制

主要是针对 Comet 模块所做的优化,可以查看模块中各个分配内存的地方,使用内存池。

模块优化

模块优化也分为以下三方面:

1.消息分发一定是并行的并且互不干扰

要保证到每一个 Comet 的通讯通道必须是相互独立的,保证消息分发必须是完全并列的,并且彼此之间互不干扰。

2.并发数一定是可以进行控制的

每个需要异步处理开启的 Goroutine(Go 协程)都必须预先创建好固定的个数,如果不提前进行控制,那么 Goroutine 就随时存在爆发的可能。

3.全局锁一定是被打散的

Socket 链接池管理、用户在线数据管理都是多把锁;打散的个数通常取决于 CPU,往往需要考虑 CPU 切换时造成的负担,并非是越多越好。

模块优化的三个方面,主要考虑的问题就是,分布式系统中会出现的单点问题,即当一个用户在建立链接后,如果出现故障,其余用户建立的链接不能被影响。

测试是实践过程中最不可缺少的一部分,同时,测试的数据也是用来进行参考比照的最好工具。

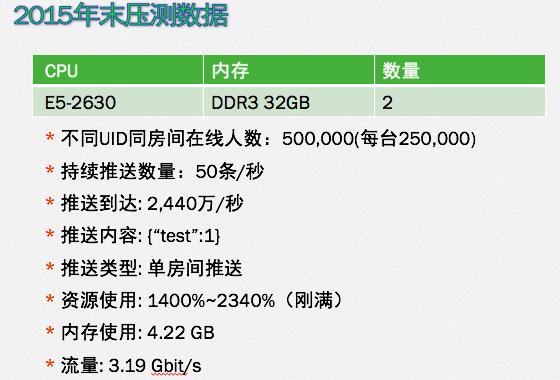

图 2 是 15 年末的压测数据。当时使用了两台物理机,平均每台的在线量是 25 万,每个直播每秒的推送数量控制在 20-50 条内。一般对于一个屏幕来说,40 条就可以满足直播的需求,当时用来进行模拟的推送量是 50 条/秒(峰值),推送到达数是 2440 万/秒。这次的数据显示,CPU 的负载是刚好满,内存使用量在 4G 左右,流量约为 3G。从这个数据得出的结论是,真正的瓶颈负载在 CPU 上。所以,目的很明确,就是将 CPU 负载打满(但是不能超负载)。

2015 年之后,再次进行优化,将所有内存(堆上的、不可控的)都迁移到栈上,当时只采用了一台物理机,上面承载了 100 万的在线数量。 优化效果体现在 2016 年 3 月的压测数据(图 3)中,这个数据也是最初直播时,想要测试的一个压缩状况。

从图 3 的数据可以看出,优化效果是成倍增加的。当时的目的也是将 CPU 打满,可是在实际直播环境中,需要考虑的最本质的问题其实是在流量上,包括弹幕字数,赠送礼物的数量。如果弹幕需要加上一些特殊的需求(字体、用户等级等),赠送礼物数量过多这样,都会产生很多流量。所以,直播弹幕优化的最终瓶颈只有流量。

2016 年之前,B 站的优化重点都放在了系统的优化上,包括优化内存,降低 CPU 的使用率,可是优化的效果并不显著,一台机器的瓶颈永远是流量。在 2016 年 3 月份后,B 站将优化重点转移到了网络优化上。下面就是 B 站网络优化的一些措施。

网络优化

最初 B 站的工作内容,主要是以开发为主,为了在结构上面得到扩展,所做的工作就是将代码尽量完善。但是在实际业务当中,也会遇见更多运维方面的问题,所以,在之后的关注重点上,B 站添加了对运维的重点关注。

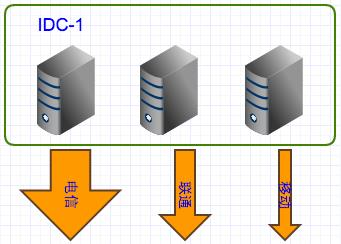

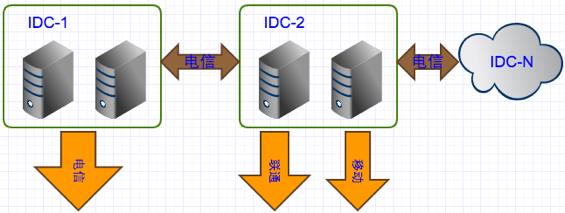

图 4 是 B 站早期的部署结构。最开始,整套服务是部署在一个 IDC 上面的(单点 IDC),时间一长,这样的部署结构也逐渐显现出它的缺陷:

- 单线 IDC 流量不足

- 单点问题

- 接入率低

这样的网络部署往往会造成延迟高、网速卡顿等问题。

针对以上三点问题,B 站也对部署结构进行了改善,图 5 是改善过的网络部署结构,下面将对这个部署结构进行详细说明。

图 5

针对单点 IDC 流量不足的问题,B 站采用了多点 IDC 接入的方案。一个机房的流量不够,那么就把它分散到不同的机房,看看效果如何。

对于多点 IDC 接入来说,专线的成本是非常高昂的,对于创业公司来说,是一块很大的负担,所以可以通过一些研发或者是架构的方式来解决多 IDC 的问题 。针对多 IDC 的问题,需要优化的方面还有很多,下面列举出一些 B 站现有的一些优化方案:

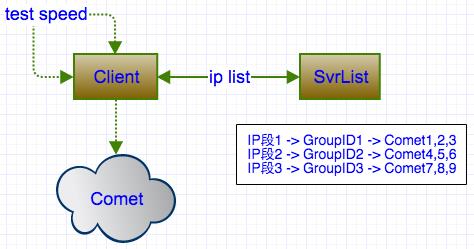

1.调节用户最优接入节点

使用 Svrlist 模块(图 6.1)支持,选取距离用户最近的最稳定的节点,调控 IP 段,然后进行接入。

2.IDC 的服务质量监控:掉线率

判断一个节点是否稳定,需要不断收集大量的用户链接信息,此时就可以使用监控来查询掉线率,然后不断调优,收集最终的结果去做一个拓扑图(全国范围),在拓扑图当中就可以判断出城市到机房之间的最优线路。

3.自动切走「失联」服务器

4.消息 100%的到达率(仍在实现中)

对于弹幕来说,低丢包率是非常重要的。比如,消息是价值上千块的礼物,此时一旦丢失某些消息,当用户发礼物时,起到的效果就是,实际在弹幕中显示出来的效果是,礼物数远远少于用户花费金钱买来的礼物数。这是一个很严重的问题。

5.流量控制

对于弹幕来说,当用户量到达一定级别时,需要考虑的问题还是流量控制,这也是对于花销成本的控制,当买的机房的带宽,是以千兆带宽为计费标准时,当有超标时,一定要将超标部分的流量切走,以此实现了流量控制的功能。

引入多点 IDC 接入之后,电信的用户依旧可以走电信的线路,但是可以将模块在其他机房进行部署,让移动的一些用户可以连接移动的机房。这样就保证了,不同地区不同运营商之间,最优网络选取的问题。

可是解决了最优网络的选取,却带来了跨域传输的问题。比如在数据收集时,Comet 模块将数据反馈到 Logic,Logic 进行消息分发时,数据便会跨机房传输。有些公司的机房是通过专线进行传输,这样成本将会非常高。所以,为了节约成本就只能走公网的流量,但是公网的稳定性是否高、是否高可用,都是需要考虑的。当流量从电信的机房出去之后,经过电信的交换机,转到联通的交换机,然后到达联通的机房,就会存在跨运营商传输的问题,比如丢包率高,因此,跨运营商传输带来的问题还是非常严重的。

为了解决这个可能存在的风险,可以尝试在联通机房接入一条电信的线路(带宽可以小一点),「看管」电信的模块,让来自不同运营商的流量,可以走自己的线路。做了这样的尝试之后,不仅降低了丢包率,还满足了对稳定性的基本要求,并且成本消耗也不高。可是,这样的方案也不能说是百分百的完美,因为就算是同运营商之间的通讯,也会存在城市和城市之间某个交换机出现故障的情况,对于这样的情况,B 站采取的方法是同时在 IDC-1 与 IDC-2(图 5)之间部署两条电信线路,做了这样的备份方案之后,通畅程度以及稳定性都有非常明显的提升。