异常检测怎么做,试试孤立随机森林算法(附代码)

Posted Python学习与数据挖掘

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了异常检测怎么做,试试孤立随机森林算法(附代码)相关的知识,希望对你有一定的参考价值。

从银行欺诈到预防性的机器维护,异常检测是机器学习中非常有效且普遍的应用。在该任务中,孤立森林算法是简单而有效的选择。喜欢本文记得收藏、关注、点赞。

本文内容包括:

-

介绍异常检测;

-

异常检测的用例;

-

孤立森林是什么;

-

用孤立森林进行异常检测;

-

用 Python 实现。

注:完整代码、数据、技术交流,文末获取

异常检测简介

离群值是在给定数据集中,与其他数据点显著不同的数据点。异常检测是找出数据中离群值(和大多数数据点显著不同的数据点)的过程。真实世界中的大型数据集的模式可能非常复杂,很难通过查看数据就发现其模式。这就是为什么异常检测的研究是机器学习中极其重要的应用。

本文要用孤立森林实现异常检测。我们有一个简单的工资数据集,其中一些工资是异常的。目标是要找到这些异常值。可以想象成,公司中的一些雇员挣了一大笔不同寻常的巨额收入,这可能意味着存在不道德的行为。

异常检测用例

异常检测在业界中应用广泛。下面介绍一场常见的用例:

银行: 发现不正常的高额存款。每个账户持有人通常都有固定的存款模式。如果这个模式出现了异常值,那么银行就要检测并分析这种异常(比如洗钱)。

金融: 发现欺诈性购买的模式。每个人通常都有固定的购买模式。如果这种模式出现了异常值,银行需要检测出这种异常,从而分析其潜在的欺诈行为。

网络: 检测网络入侵。任何对外开放的网络都面临这样的威胁。监控网络中的异常活动,可以及早防止入侵。

什么是孤立森林

孤立森林是用于异常检测的机器学习算法。这是一种无监督学习算法,通过隔离数据中的离群值识别异常。

孤立森林是基于决策树的算法。从给定的特征集合中随机选择特征,然后在特征的最大值和最小值间随机选择一个分割值,来隔离离群值。这种特征的随机划分会使异常数据点在树中生成的路径更短,从而将它们和其他数据分开。

孤立森林隔离数据点中的异常值,而不是分析正常的数据点。和其他正常的数据点相比,异常数据点的树路径更短,因此在孤立森林中的树不需要太大的深度,所以可以用更小的 max_depth 值,从而降低内存需求。

探索性数据分析

先导入所需的库。导入 numpy、pandas、seaborn 和 matplotlib。此外还要从 sklearn.ensemble 中导入孤立森林(IsolationForest)。

import numpy as np

import pandas as pd

import seaborn as sns

import matplotlib.pyplot as plt

from sklearn.ensemble import IsolationForest

导入库后,要将 csv 数据读取为 padas 数据框,检查前十行数据。

本文所用数据是不同职业的人的年薪(美元)。数据中有一些异常值(比如工资太高或太低),目标是检测这些异常值。

df = pd.read_csv('salary.csv')

df.head(10)

为了更好地了解数据,将工资数据绘制成小提琴图,如下图所示。小提琴图是一种绘制数值数据的方法。

通常,小提琴图包含箱图中所有数据——中位数的标记和四分位距的框或标记,如果样本数量不太大,图中可能还包括所有样本点。

为了更好地了解离群值,可能还会查看箱图。箱图一般也称为箱线图。箱图中的箱子显示了数据集的四分位数,线表示剩余的分布。线不表示确定为离群值的点。

我们通过 interquartile range, 的函数检测离群值。在统计数据中,interquartile range,(也称为 midspread 或 middle 50%)是度量统计学分散度的指标,等于第 75% 个数和第 25% 个数的差。

工资的箱图,指示了右侧的两个离群值。

完成数据的探索性分析后,就可以定义并拟合模型了。

定义及拟合模型

我们要创建一个模型变量,并实例化 IsolationForest(孤立森林)类。将这四个参数的值传递到孤立森林方法中,如下所示。

from sklearn.ensemble import IsolationForest

def Isolation_Forest_model(df):

#构建模型,n_estimators=50,构建50棵树

model=IsolationForest(n_estimators=50,

max_samples='auto',

contamination=float(0.1),

max_features=1.0)

#训练模型

model.fit(df[['salary']])

#预测decision_function得出异常评分

df['scores']=model.decision_function(df[['salary']])

#predict()函数 得到模型是否异常的判断,-1异常,1正常

df['anomaly']=model.predict(df[['salary']])

return df

-

评估器数量:n_estimators 表示集成的基评估器或树的数量,即孤立森林中树的数量。这是一个可调的整数参数,默认值是 100;

-

最大样本:max_samples 是训练每个基评估器的样本的数量。如果 max_samples 比样本量更大,那么会用所用样本训练所有树。max_samples 的默认值是『auto』。如果值为『auto』的话,那么 max_samples=min(256, n_samples);

-

数据污染问题:算法对这个参数非常敏感,它指的是数据集中离群值的期望比例,根据样本得分拟合定义阈值时使用。默认值是『auto』。如果取『auto』值,则根据孤立森林的原始论文定义阈值;

-

最大特征:所有基评估器都不是用数据集中所有特征训练的。这是从所有特征中提出的、用于训练每个基评估器或树的特征数量。该参数的默认值是 1。

model=IsolationForest(n_estimators=50, max_samples='auto', contamination=float(0.1),max_features=1.0)

model.fit(df[['salary']])

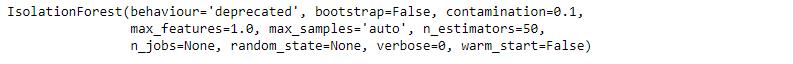

孤立森林模型训练输出。

模型定义完后,就要用给定的数据训练模型了,这是用 fit() 方法实现的。这个方法要传入一个参数——使用的数据(在本例中,是数据集中的工资列)。

正确训练模型后,将会输出孤立森林实例(如图所示)。现在可以添加分数和数据集的异常列了。

添加分数和异常列

在定义和拟合完模型后,找到分数和异常列。对训练后的模型调用 decision_function(),并传入工资作为参数,找出分数列的值。

类似的,可以对训练后的模型调用 predict() 函数,并传入工资作为参数,找到异常列的值。

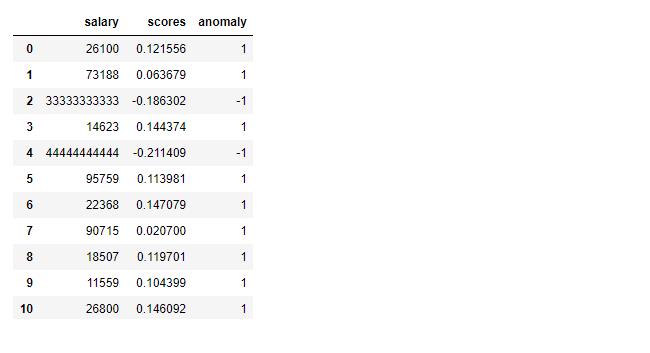

将这两列添加到数据框 df 中。添加完这两列后,查看数据框。如我们所料,数据框现在有三列:工资、分数和异常值。分数列中的负值和异常列中的 -1 表示出现异常。异常列中的 1 表示正常数据。

这个算法给训练集中的每个数据点都分配了异常分数。可以定义阈值,根据异常分数,如果分数高于预定义的阈值,就可以将这个数据点标记为异常。

df['scores']=model.decision_function(df[['salary']])

df['anomaly']=model.predict(df[['salary']])

df.head(20)

给数据的每一行中都添加了分数和异常值后,就可以打印预测的异常了。

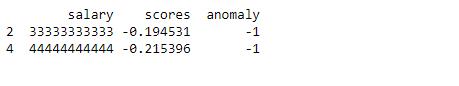

打印异常

为了打印数据中预测得到的异常,在添加分数列和异常列后要分析数据。如前文所述,预测的异常在预测列中的值为 -1,分数为负数。根据这一信息,将预测的异常(本例中是两个数据点)打印如下。

anomaly=df.loc[df['anomaly']==-1]

anomaly_index=list(anomaly.index)

print(anomaly)

异常输出。

注意,这样不仅能打印异常值,还能打印异常值在数据集中的索引,这对于进一步处理是很有用的。

异常可视化

#异常数据可视化函数

import plotly.graph_objects as go

def plot_anomaly(ts,anomaly_pred = None,fig = go.Figure()):

fig1 = go.Scatter(x = ts.index,y = ts,mode = 'lines', name = ts.name)

fig.add_trace(fig1)

if anomaly_pred is not None:

status = go.Scatter(

x = anomaly_pred.index,

y = ts.loc[anomaly_pred.index],

mode = 'markers', name = anomaly_pred.name,marker= 'color':'red','size':10,'symbol':'star','line_width':0)

fig.add_trace(status)

# fig.show()

return fig

df = Isolation_Forest_model(df)

fig = plot_anomaly(df['salary'], anomaly_pred=df[df['anomaly'] == -1]['anomaly'])

评估模型

为了评估模型,将阈值设置为工资>99999 的为离群值。用以下代码找出数据中存在的离群值:

outliers_counter = len(df[df['salary'] > 99999])

outliers_counter

计算模型找到的离群值数量除以数据中的离群值数量,得到模型的准确率。

print("Accuracy percentage:", 100*list(df['anomaly']).count(-1)/(outliers_counter))

准确率:100%

推荐文章

技术交流

欢迎转载、收藏、有所收获点赞支持一下!数据、代码可以找我获取

目前开通了技术交流群,群友已超过2000人,添加时最好的备注方式为:来源+兴趣方向,方便找到志同道合的朋友

- 方式①、发送如下图片至微信,长按识别,后台回复:加群;

- 方式②、添加微信号:dkl88191,备注:来自CSDN

- 方式③、微信搜索公众号:Python学习与数据挖掘,后台回复:加群

以上是关于异常检测怎么做,试试孤立随机森林算法(附代码)的主要内容,如果未能解决你的问题,请参考以下文章

异常检测 | 使用孤立森林 sklearn.ensemble.IsolationForest 分析异常流量