人工智能作业一

Posted liuzhexuan1

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了人工智能作业一相关的知识,希望对你有一定的参考价值。

文章目录

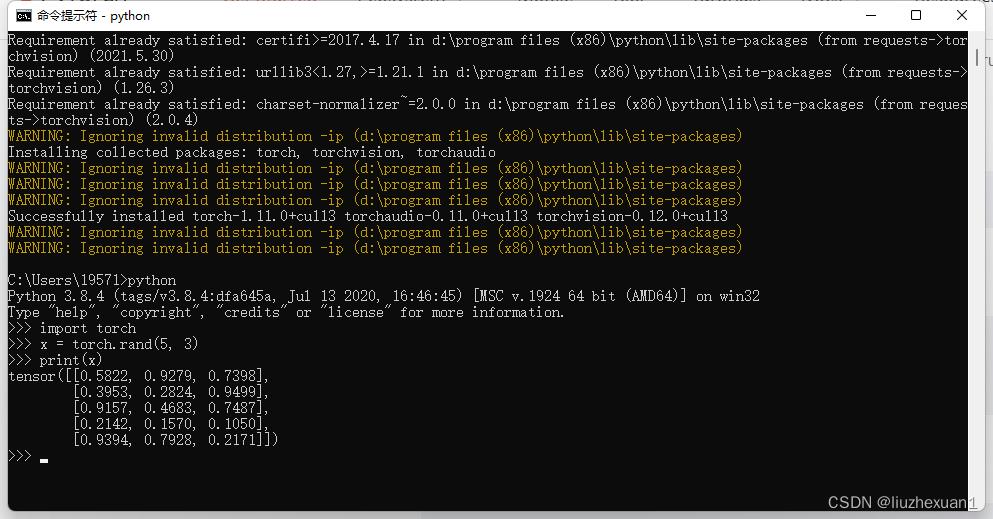

PyTorch 安装

PyTorch可以在 https://pytorch.org/get-started/locally/ 网站进行安装。

由最新的pytorch的windows版本不支持CUDA-10.2,所以我选择CUDA 11.3.下面是用pip进行安装

复制Run this Command里的命令,打开cmd输入.

复制Run this Command里的命令,打开cmd输入.

安装完毕后进行测试,发现已经安装成功!

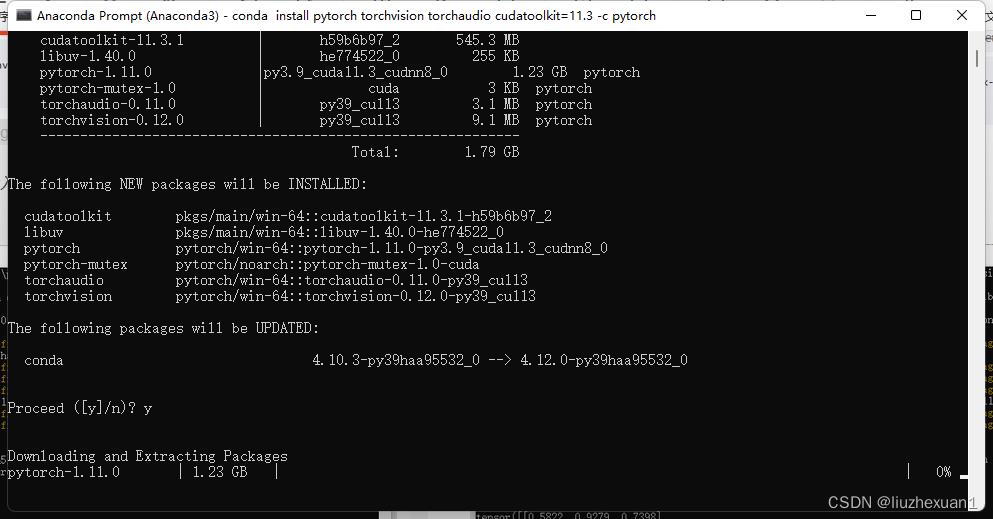

Conda安装首先你要有安装Anaconda3, 然后打开Anaconda Prompt,在里面输入Run this Command里的即可,出现下面提示时选择y即可

如果安装太慢,可以先在Anaconda Prompt输入下面的命令更换镜像源

如果安装太慢,可以先在Anaconda Prompt输入下面的命令更换镜像源

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/free/

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/main/

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud/conda-forge/

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud/pytorch/

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/pro/

更换了之后,需要把官网给出的命令后面-c pytorch删除,因为-c命令是指定下载源

PS:安装的时候要把梯子关掉,不然会报ProxyError

pytorch实现反向传播

首先,反向传播算法的目的是找到一组能最大限度地减小误差的权重,在反向传播中使用的方法是梯度下降法。 在这个算法中,误差会从输出结点反向传播到输入结点。

1.链式法则

在学习反向传播之前,首先要知道链式法则是什么东西。

Case 1

对于单变量的结论如下:

y

=

g

(

x

)

w

=

h

(

y

)

d

z

d

x

=

d

z

d

y

d

y

d

x

\\beginaligned &y = g(x) \\space \\space w = h(y) \\\\ &\\fracdzdx = \\fracdzdy \\fracdydx \\endaligned

y=g(x) w=h(y)dxdz=dydzdxdy

Case 2

对于多变量的结论如下:

x

=

g

(

s

)

y

=

h

(

s

)

z

=

f

(

x

,

y

)

∂

z

∂

s

=

∂

z

∂

x

∂

x

∂

s

+

∂

z

∂

y

∂

y

∂

s

\\beginaligned &x = g(s) \\space \\space y = h(s) \\space \\space z = f(x,y) \\\\ &\\frac\\partialz\\partials = \\frac\\partialz\\partialx \\frac\\partialx\\partials + \\frac\\partialz\\partialy \\frac\\partialy\\partials \\endaligned

x=g(s) y=h(s) z=f(x,y)∂s∂z=∂x∂z∂s∂x+∂y∂z∂s∂y

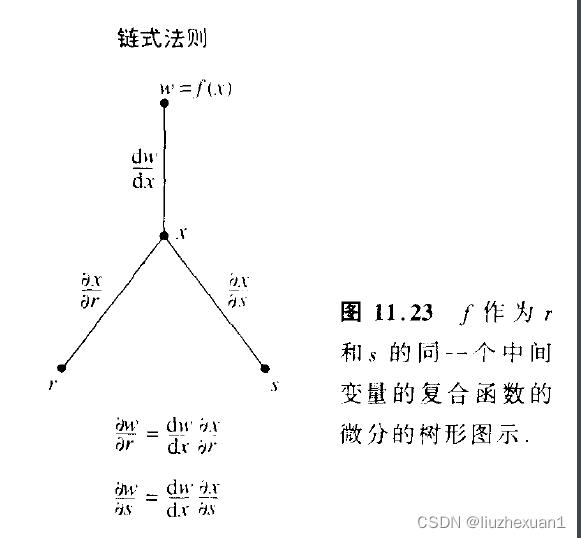

这就是基本的链式法则,他会形成如下的计算图(三个单变量的情况):

计算误差函数对权重的导数

设误差函数为

C

C

C,权重为

w

i

w_i

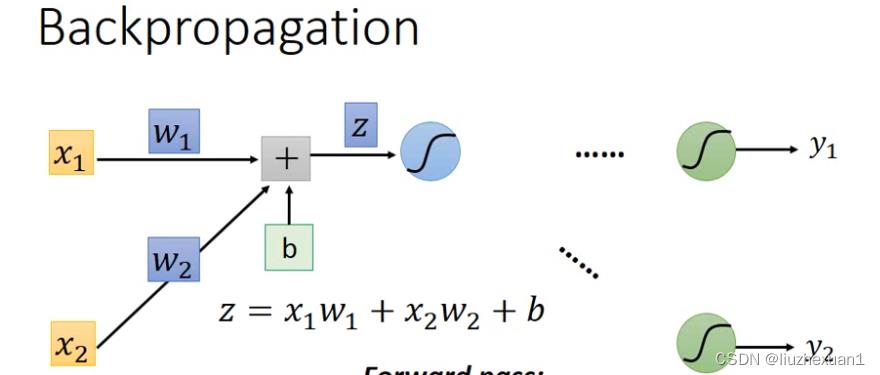

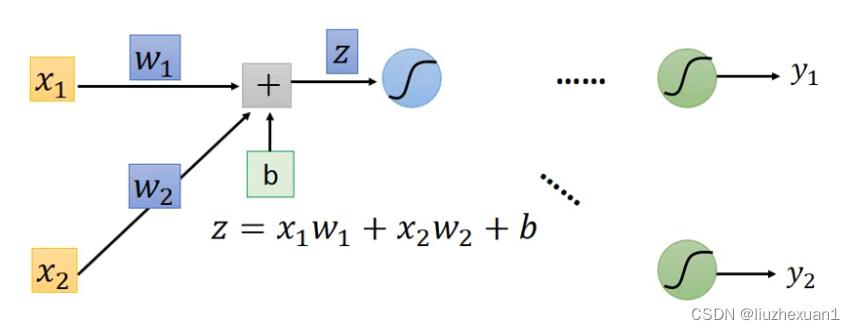

wi,如下图(下面所有的图均来自ML Lecture 7):

那么有

∂

C

∂

w

=

∂

z

∂

w

∂

C

∂

z

\\frac\\partialC\\partialw = \\frac\\partialz\\partialw \\frac\\partialC\\partialz

∂w∂C=∂w∂z∂z∂C

其中,计算

∂

z

∂

w

\\frac\\partialz\\partialw

∂w∂z的过程是前向传播,计算

∂

C

∂

z

\\frac\\partialC\\partialz

∂z∂C是反向传播

前向传播

前向传播计算

∂

z

∂

w

\\frac\\partialz\\partialw

∂w∂z,而很容易发现,这个值就是输入的值,因此可以从输入端一路推下去。

如上图, 有

∂

z

∂

w

1

=

x

1

∂

z

∂

w

2

=

x

2

\\frac\\partialz\\partialw_1 =x_1 \\\\ \\frac\\partialz\\partialw_2 =x_2

∂w1∂z=x1∂w2∂z=x2

如上图, 有

∂

z

∂

w

1

=

x

1

∂

z

∂

w

2

=

x

2

\\frac\\partialz\\partialw_1 =x_1 \\\\ \\frac\\partialz\\partialw_2 =x_2

∂w1∂z=x1∂w2∂z=x2

反向传播

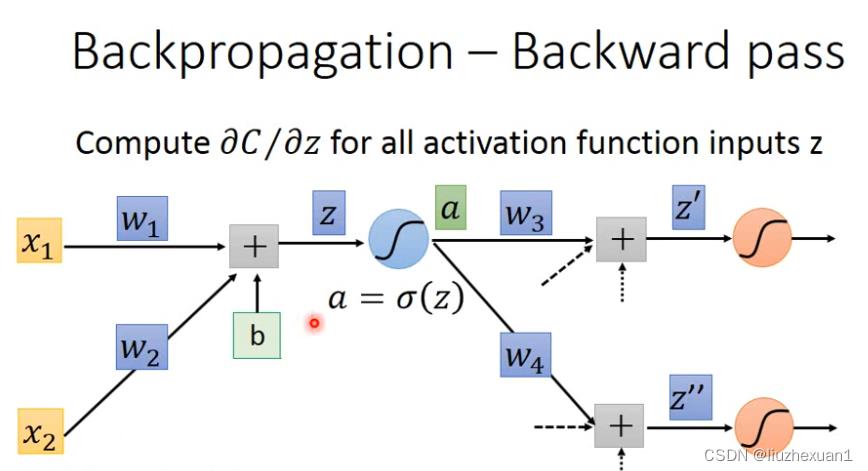

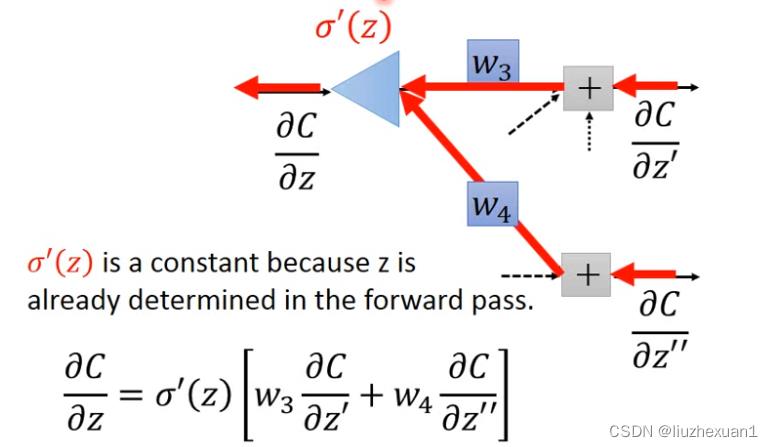

反向传播计算 ∂ C ∂ z \\frac\\partialC\\partialz ∂z∂C,如果从输入端推下去的话,会发现计算变得非常困难。例如下图:

根据链式法则

∂

C

∂

z

=

∂

a

∂

z

∂

C

∂

a

∂

C

∂

a

=

∂

z

′

∂

a

∂

C

∂

z

′

+

∂

z

′

′

∂

a

∂

C

∂

z

′

′

\\beginaligned &\\frac\\partialC\\partialz =\\frac\\partiala\\partialz\\frac\\partialC\\partiala \\\\ &\\frac\\partialC\\partiala=\\frac\\partialz'\\partiala\\frac\\partialC\\partialz'+\\frac\\partialz''\\partiala\\frac\\partialC\\partialz'' \\endaligned

∂z∂C=∂z∂a∂a∂C∂a∂C=∂a∂z′∂z′∂C+∂a∂z′′∂z′′∂C

会发现仅仅是两层,式子就变得非常复杂,如果要计算当前层的答案,必须要把下一层的东西计算出来。

但是如果从输出端往前推,会发现计算变得与前向传播一样,很好计算。

pytorch实现

下面是代码实现(代码来自:Pytorch深度学习(三):反向传播)

import torch

import matplotlib.pyplot as plt

x_data = [1.0,2.0,3.0]

y_data = [2.0,4.0,6.0]

w = torch.Tensor([3.0]) #初始化权重

w.requires_grad = True #说明w需要计算梯度

# 注意其中w是tensor,在实际运算中开始进行数乘。

def forward(x):

return w*x

# 损失函数的求解,构建计算图,并不是乘法或者乘方运算

def loss(x,y):

y_pred = forward(x)

return (y_pred - y) ** 2

print("Predict before training",4,forward(4).item()) ## 打印学习之前的值,.item表示输出张量的值

learning_rate = 0.01

epoch_list = []

loss_list =[]

#训练

for epoch in range(100):

for x,y in zip(x_data,y_data):

l=loss(x,y)

l.backward() #向后传播

print('\\tgrad',x,y,w.grad.item()) # 将梯度存到w之中,随后释放计算图,w.grad.item():取出数值

w.data = w.data - learning_rate*w.grad.data # 张量中的grad也以上是关于人工智能作业一的主要内容,如果未能解决你的问题,请参考以下文章