基于Pytorch的强化学习(DQN)之 Multistep TD target

Posted ZDDWLIG

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了基于Pytorch的强化学习(DQN)之 Multistep TD target相关的知识,希望对你有一定的参考价值。

目录

1. 引言

我们之前已经学习了Sarsa算法和Q-learning算法,我们知道这两者都是基于TD算法的,我们又知道TD算法效果改变受TD target影响,我们思考一下,如果我们选用包含真实信息更多的TD target,效果会不会更好呢?下面我们来进行数学推导。

2. 数学推导

一切都源于这个公式: ,我们再使用这个公式将

,我们再使用这个公式将  展开得到

展开得到

这个公式相较于前一个公式更加精确,因为它含有 两个真实信息,而前面的公式只有一个

两个真实信息,而前面的公式只有一个  ,于是我们可以进一步递推这个公式,将其展开

,于是我们可以进一步递推这个公式,将其展开 次得到

次得到

这样我们便可以将Sarsa算法中的TD target 修正为

特别地当 时我们得到之前推导TD target

时我们得到之前推导TD target

将Q-learning算法中的TD target 修正为

特别地当 时我们得到之前推导TD target

时我们得到之前推导TD target

由于我们获得了更准确的TD target,所以我们需要付出一些代价,这些代价就是 ,我们需要计算更多的return,于是原来的transition

,我们需要计算更多的return,于是原来的transition  变成了

变成了

3. 文献

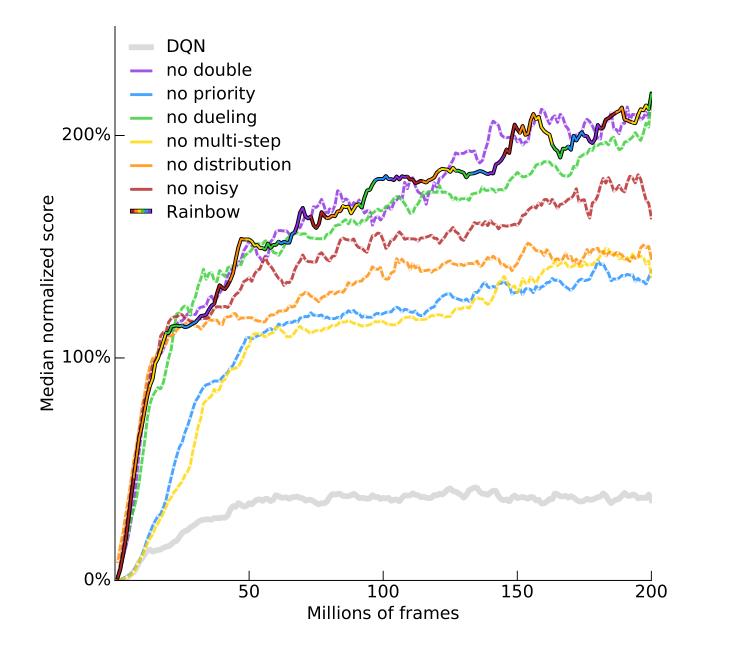

有文献表明[1],m-step TD target往往比1-step TD target效果更好

我们可以看到代表使用multi-step的Rainbow(彩虹线)比没有使用的no multi-step 的黄线得分更高,说明其效果更好

[1][1] Hessel, M. , Modayil, J. , Hasselt, H. V. , Schaul, T. , Ostrovski, G. , & Dabney, W. , et al. (2017). Rainbow: combining improvements in deep reinforcement learning.

以上是关于基于Pytorch的强化学习(DQN)之 Multistep TD target的主要内容,如果未能解决你的问题,请参考以下文章